大数据之路week07--day07 (Sqoop 从mysql增量导入到HDFS)

我们之前导入的都是全量导入,一次性全部导入,但是实际开发并不是这样,例如web端进行用户注册,mysql就增加了一条数据,但是HDFS中的数据并没有进行更新,但是又再全部导入一次又完全没有必要。

所以,sqoop提供了增量导入的方法。

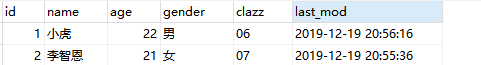

1、数据准备:

2、将其先用全量导入到HDFS中去

3、先在mysql中添加一条数据,在使用命令进行追加

#指定字段的取值范围,增量到数据(指的是Mysql增加了一条或多条数据,追加到HDFS中去,

如果想追加到hive本来的数据中去就把路径换成hive的路径)

# 适用于表不断的有新数据插入 sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--table student_zeng \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--split-by id \

-m \

--fields-terminated-by '\t' \

--incremental append \

--check-column id \

--last-value

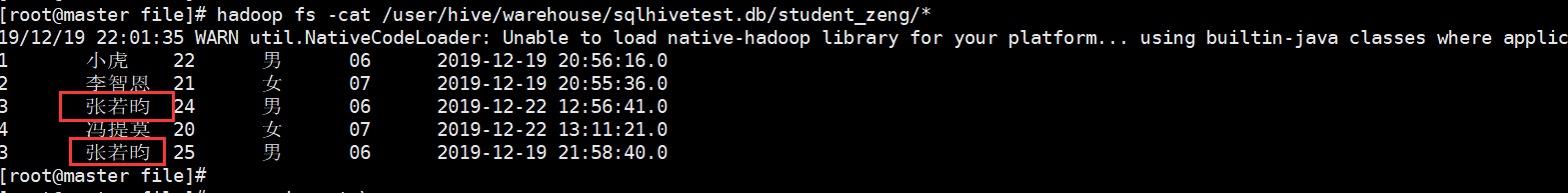

4、根据时间进行大量追加(不去重)

追加

sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--table student_zeng \

--fields-terminated-by '\t' \

--check-column last_mod \

--incremental lastmodified \

--last-value "2019-12-19 20:57:16" \

-m \

--append

结果:但是我们发现有两个重复的字段

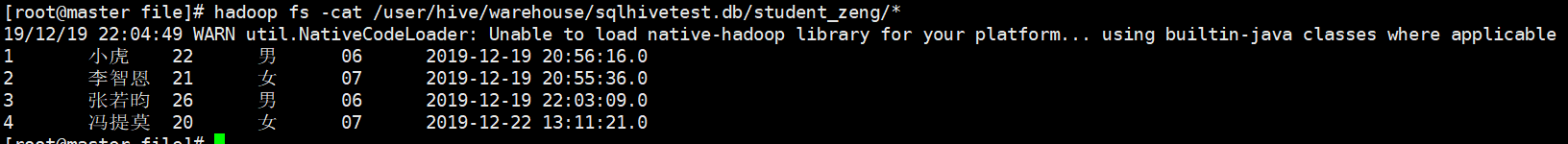

5、往往开发中需要进行去重操作:sqoop提供了一个方法进行去重,内部是先开一个map任务将数据导入进来,然后再开一个map任务根据指定的字段进行合并去重

#根据业务可能需要去重 -merge-key 就是做这个事 sqoop import \

--connect jdbc:mysql://master:3306/student \

--username root \

--password \

--target-dir /user/hive/warehouse/sqlhivetest.db/student_zeng/ \

--table student_zeng \

--fields-terminated-by '\t' \

--check-column last_mod \

--incremental lastmodified \

--last-value "2019-12-19 22:00:09" \

-m \

-merge-key id

结果:

之前有重复的也进行合并去重操作,最后生成一个结果。

大数据之路week07--day07 (Sqoop 从mysql增量导入到HDFS)的更多相关文章

- 大数据之路week07--day06 (Sqoop 的使用)

Sqoop的使用一(将数据库中的表数据上传到HDFS) 首先我们先准备数据 1.没有主键的数据(下面介绍有主键和没有主键的使用区别) -- MySQL dump 10.13 Distrib 5.1.7 ...

- 大数据之路week07--day06 (Sqoop 将关系数据库(oracle、mysql、postgresql等)数据与hadoop数据进行转换的工具)

为了方便后面的学习,在学习Hive的过程中先学习一个工具,那就是Sqoop,你会往后机会发现sqoop是我们在学习大数据框架的最简单的框架了. Sqoop是一个用来将Hadoop和关系型数据库中的数据 ...

- 大数据之路week07--day06 (Sqoop 在从HDFS中导出到关系型数据库时的一些问题)

问题一: 在上传过程中遇到这种问题: ERROR tool.ExportTool: Encountered IOException running export job: java.io.IOExce ...

- 大数据之路week07--day06 (Sqoop 的安装及配置)

Sqoop 的安装配置比较简单. 提供安装需要的安装包和连接mysql的驱动的百度云链接: 链接:https://pan.baidu.com/s/1pdFj0u2lZVFasgoSyhz-yQ 提取码 ...

- sqoop操作之Oracle导入到HDFS

导入表的所有字段 sqoop import --connect jdbc:oracle:thin:@192.168.1.100:1521:ORCL \ --username SCOTT --passw ...

- 大数据之路week06--day07(Hadoop生态圈的介绍)

Hadoop 基本概念 一.Hadoop出现的前提环境 随着数据量的增大带来了以下的问题 (1)如何存储大量的数据? (2)怎么处理这些数据? (3)怎样的高效的分析这些数据? (4)在数据增长的情况 ...

- 大数据之路week04--day06(I/O流阶段一 之异常)

从这节开始,进入对I/O流的系统学习,I/O流在往后大数据的学习道路上尤为重要!!!极为重要,必须要提起重视,它与集合,多线程,网络编程,可以说在往后学习或者是工作上,起到一个基石的作用,没了地基,房 ...

- 大数据框架开发基础之Sqoop(1) 入门

Sqoop是一款开源的工具,主要用于在Hadoop(Hive)与传统的数据库(mysql.postgresql...)间进行数据的传递,可以将一个关系型数据库(例如 : MySQL ,Oracle , ...

- C#码农的大数据之路 - 使用C#编写MR作业

系列目录 写在前面 从Hadoop出现至今,大数据几乎就是Java平台专属一般.虽然Hadoop或Spark也提供了接口可以与其他语言一起使用,但作为基于JVM运行的框架,Java系语言有着天生优势. ...

随机推荐

- 问题三:Appium 的 UIAutomator2 模式下使用 sendKeys 出现错误

在Appium默认的模式下,可以对TextFiled控件进行sendKeys操作: 设置capabilities.setCapability("automationName",&q ...

- LVS的基础使用

LVS的基础使用 LVS的介绍 A:什么是LVS B:cluster(集群的概念) C:LVS的介绍 LVS的使用 A:ipvsadm命令的使用 ♣一:LVS的介绍 A:什么是lvs LVS的英文全称 ...

- Qt qml调试,qml性能分析和优化工具

QML语言为qt推出的用于界面编程的语言. 1)如何在qt creator中进行调试qml: 以Qt Creator 4.6.2为例: 在qt creator的debug模式下,可以直接在qml中打断 ...

- PHP设计模式 - 模板方法模式

模板模式准备一个抽象类,将部分逻辑以具体方法以及具体构造形式实现,然后声明一些抽象方法来迫使子类实现剩余的逻辑.不同的子类可以以不同的方式实现这些抽象方法,从而对剩余的逻辑有不同的实现.先制定一个顶级 ...

- C++Primer 5th Chap4 Expressions

左值和右值:左值:用的是对象的身份(内存中的位置),右值:用的是对象的值(内容) 解引用与递增(递减)运算符连用: *ivec++:取ivec当前值并向后移动一个元素,等价于*(ivec++),本来+ ...

- windows 开始→运行→命令集锦

windows 开始→运行→命令集锦 来源于网络,侵权请通知我删除 命令 说明 vwinver 检查Windows版本 wmimgmt.msc 打开windows管理体系结构(WMI) wupdmgr ...

- xorm -sum 系列方法实例

求和数据可以使用Sum, SumInt, Sums 和 SumsInt 四个方法,Sums系列方法的参数为struct的指针并且成为查询条件. package main import ( " ...

- gorm 实现 mysql for update 排他锁

关于 MySQL 的排他锁网上已经有很多资料进行了介绍,这里主要是记录一下 gorm 如果使用排他锁. 排他锁是需要对索引进行锁操作,同时需要在事务中才能生效.具体操作如下: 假设有如下数据库表结构: ...

- Python爬虫b站视频弹幕并生成词云图分析

爬虫:requests,beautifulsoup 词云:wordcloud,jieba 代码加注释: # -*- coding: utf-8 -*- import xlrd#读取excel impo ...

- [CF436D]Pudding Monsters

题目大意:有一个长度为$2\times 10^5$的板,有$n(n\leqslant 10^5)$个格子$a_1,\dots,a_n$有布丁怪兽,一开始连续的怪兽算一个怪兽,有$m(m\leqslan ...