Ajax爬取豆瓣电影目录(Python)

下面的分析相当于一个框架,搞懂之后,对于类似的文字爬取,我们也可以实现。就算不能使用Ajax方法,我们也能够使用相同思想去爬取我们想要的数据。

豆瓣电影排行榜分析

首先我们打开网页的审查元素,选中Network==》XHR==》电影相关信息网页文件

筛选并比较以下数据(三个文件数据)

请求地址

Request URL:https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&sort=recommend&page_limit=20&page_start=0 Request URL:https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&sort=recommend&page_limit=20&page_start=20 Request URL:https://movie.douban.com/j/search_subjects?type=movie&tag=%E7%83%AD%E9%97%A8&sort=recommend&page_limit=20&page_start=40

查询参数

type:movie

tag:热门

sort:recommend

page_limit:

page_start: type:movie

tag:热门

sort:recommend

page_limit:

page_start: type:movie

tag:热门

sort:recommend

page_limit:

page_start:

请求报头

Host:movie.douban.com

Referer:https://movie.douban.com/explore

User-Agent:Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36

X-Requested-With:XMLHttpRequest

通过比较请求地址和查询参数,得出

请求地址 = baseurl+type+tag+sort+page_limit+page_start baseurl:https://movie.douban.com/j/search_subjects?

type:固定为movie

tag:关键字,需要将utf-8转换为urlencode

sort:固定为recommend

page_limit:表示一页显示的电影数量,固定20

page_start:表示电影页数,从0开始,20为公差的递增函数

由此我们获取到了我们需要的数据,可以将爬虫分为三步

- 获取网页json格式代码

- 从代码中获取电影名和电影海报图片链接

- 将获得的图片命名为电影名

流程

准备工作

在函数外部定义伪装的请求报头

headers={

'Host': 'movie.douban.com',

'Referer': 'https://movie.douban.com/explore',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'X-Requested-With': 'XMLHttpRequest'

}

获取json格式代码

def get_page(page):

#请求参数

params={

'type': 'movie',

'tag': '奥特曼',

'sort': 'recommend',

'page_limit': '',

'page_start': page,

}

#基本网页链接

base_url = 'https://movie.douban.com/j/search_subjects?'

#将基本网页链接与请求参数结合在一起

url = base_url + urlencode(params)

try:

#获取网页代码

resp = requests.get(url, headers=headers)

print(url)

#返回json数据格式代码

if 200 == resp.status_code:

print(resp.json())

return resp.json()

except requests.ConnectionError:

return None

筛选数据

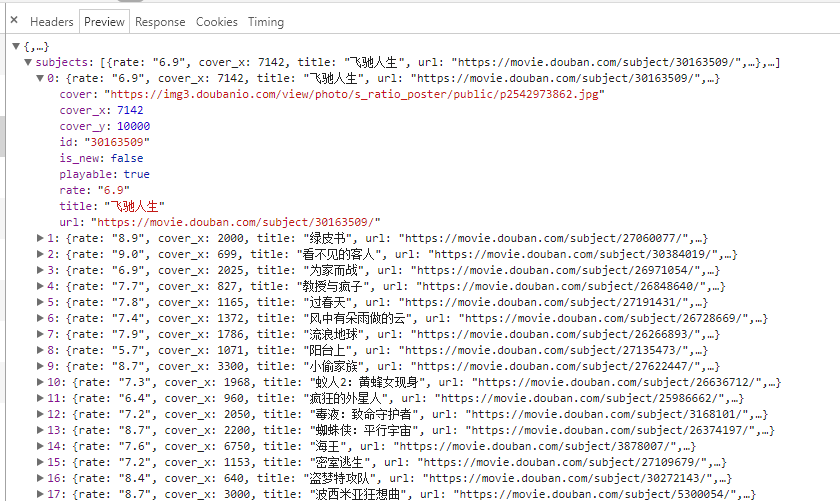

通过观察电影列表代码文件的preview,进行数据筛选

def get_image(json):

if(json.get('subjects')):

data=json.get('subjects')

for item in data:

title=item.get('title')

imageurl=item.get('cover')

#返回"信息"字典

yield {

'title':title,

'images':imageurl,

}

存储图片文件

def save_page(item):

#文件夹名称

file_name = '奥特曼电影大全'

if not os.path.exists(file_name):

os.makedirs(file_name) #获取图片链接

response=requests.get(item.get('images'))

#储存图片文件

if response.status_code==200:

file_path = file_name + os.path.sep + item.get('title') + '.jpg'

with open(file_path, 'wb') as f:

f.write(response.content)

多线程处理

def main(page):

json = get_page(page)

for item in get_image(json):

print(item)

save_page(item) if __name__ == '__main__':

pool = Pool()

pool.map(main, [i for i in range(0, 200, 20)])

pool.close()

pool.join()

总代码

import requests

from urllib.parse import urlencode

import os

from multiprocessing.pool import Pool headers={

'Host': 'movie.douban.com',

'Referer': 'https://movie.douban.com/explore',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

'X-Requested-With': 'XMLHttpRequest'

} def get_page(page):

#请求参数

params={

'type': 'movie',

'tag': '奥特曼',

'sort': 'recommend',

'page_limit': '',

'page_start': page,

}

#基本网页链接

base_url = 'https://movie.douban.com/j/search_subjects?'

#将基本网页链接与请求参数结合在一起

url = base_url + urlencode(params)

try:

#获取网页代码

resp = requests.get(url, headers=headers)

print(url)

#返回json数据格式代码

if 200 == resp.status_code:

print(resp.json())

return resp.json()

except requests.ConnectionError:

return None def get_image(json):

if(json.get('subjects')):

data=json.get('subjects')

for item in data:

title=item.get('title')

imageurl=item.get('cover')

#返回"信息"字典

yield {

'title':title,

'images':imageurl,

} def save_page(item):

#文件夹名称

file_name = '奥特曼电影大全'

if not os.path.exists(file_name):

os.makedirs(file_name) #获取图片链接

response=requests.get(item.get('images'))

#储存图片文件

if response.status_code==200:

file_path = file_name + os.path.sep + item.get('title') + '.jpg'

with open(file_path, 'wb') as f:

f.write(response.content) def main(page):

json = get_page(page)

for item in get_image(json):

print(item)

save_page(item) if __name__ == '__main__':

pool = Pool()

pool.map(main, [i for i in range(0, 200, 20)])

pool.close()

pool.join()

本来是准备使用https://movie.douban.com/tag/#/ 不过在后面,刷新网页时,总是出现服务器问题。不过下面的代码还是可以用。

import requests

from urllib.parse import urlencode

import os

from hashlib import md5

from multiprocessing.pool import Pool headers={

'Host': 'movie.douban.com',

'Referer': 'https://movie.douban.com/tag/',

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36',

} def get_page(page):

params={

'sort':'U',

'range':'0,10',

'tags':'奥特曼',

'start': page,

}

base_url = 'https://movie.douban.com/j/new_search_subjects?'

url = base_url + urlencode(params)

try:

resp = requests.get(url, headers=headers)

print(url)

if 200 == resp.status_code:

print(resp.json())

return resp.json()

except requests.ConnectionError:

return None def get_image(json):

if(json.get('data')):

data=json.get('data')

for item in data:

title=item.get('title')

imageurl=item.get('cover')

yield {

'title':title,

'images':imageurl,

} def save_page(item):

file_name='奥特曼大全'+os.path.sep+item.get('title')

if not os.path.exists(file_name):

os.makedirs(file_name)

try:

response=requests.get(item.get('images'))

if response.status_code==200:

file_path = '{0}/{1}.{2}'.format(file_name, md5(response.content).hexdigest(), 'jpg')

if not os.path.exists(file_path):

with open(file_path, 'wb') as f:

f.write(response.content)

else:

print('Already Downloaded', file_path)

except requests.ConnectionError:

print('Failed to Save Image') def main(page):

json = get_page(page)

for item in get_image(json):

print(item)

save_page(item) if __name__ == '__main__':

pool = Pool()

pool.map(main, [i for i in range(0, 200, 20)])

pool.close()

pool.join()

Ajax爬取豆瓣电影目录(Python)的更多相关文章

- 爬虫系列1:Requests+Xpath 爬取豆瓣电影TOP

爬虫1:Requests+Xpath 爬取豆瓣电影TOP [抓取]:参考前文 爬虫系列1:https://www.cnblogs.com/yizhiamumu/p/9451093.html [分页]: ...

- 利用Python爬取豆瓣电影

目标:使用Python爬取豆瓣电影并保存MongoDB数据库中 我们先来看一下通过浏览器的方式来筛选某些特定的电影: 我们把URL来复制出来分析分析: https://movie.douban.com ...

- Python开发爬虫之静态网页抓取篇:爬取“豆瓣电影 Top 250”电影数据

所谓静态页面是指纯粹的HTML格式的页面,这样的页面在浏览器中展示的内容都在HTML源码中. 目标:爬取豆瓣电影TOP250的所有电影名称,网址为:https://movie.douban.com/t ...

- Python爬虫爬取豆瓣电影之数据提取值xpath和lxml模块

工具:Python 3.6.5.PyCharm开发工具.Windows 10 操作系统.谷歌浏览器 目的:爬取豆瓣电影排行榜中电影的title.链接地址.图片.评价人数.评分等 网址:https:// ...

- python 爬取豆瓣电影评论,并进行词云展示及出现的问题解决办法

本文旨在提供爬取豆瓣电影<我不是药神>评论和词云展示的代码样例 1.分析URL 2.爬取前10页评论 3.进行词云展示 1.分析URL 我不是药神 短评 第一页url https://mo ...

- Python爬取豆瓣电影top

Python爬取豆瓣电影top250 下面以四种方法去解析数据,前面三种以插件库来解析,第四种以正则表达式去解析. xpath pyquery beaufifulsoup re 爬取信息:名称 评分 ...

- python爬取豆瓣电影信息数据

题外话+ 大家好啊,最近自己在做一个属于自己的博客网站(准备辞职回家养老了,明年再战)在家里 琐事也很多, 加上自己 一回到家就懒了(主要是家里冷啊! 广东十几度,老家几度,躲在被窝瑟瑟发抖,) 由于 ...

- python 爬取豆瓣电影短评并wordcloud生成词云图

最近学到数据可视化到了词云图,正好学到爬虫,各种爬网站 [实验名称] 爬取豆瓣电影<千与千寻>的评论并生成词云 1. 利用爬虫获得电影评论的文本数据 2. 处理文本数据生成词云图 第一步, ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

随机推荐

- python基础--3 列表

#list类#li是list类的一个对象li=[11,22,33,22,44] #参数#在原来值最后进行整个作为元素追加 # li.append((11,22,33))#对列表本身进行操作,appen ...

- paste 合并文件

1.命令功能 paste 用于合并文件的列,把每个文件以列对列的方式,一列列地加以合并. 2.语法格式 paste option file 参数选项 参数 参数说明 -d 指定间隔符合并文件(默 ...

- 【串线篇】spring boot日志使用

一.默认配置 1.SpringBoot默认帮我们配置好了日志: //记录器 Logger logger = LoggerFactory.getLogger(getClass()); @Test pub ...

- django classonlymethod 和 python classmethod的区别

--classmethod可以被一个实例调用,classonlyethod只能被类调用 class Kls(object): no_inst = 0 def __init__(self): Kls.n ...

- 【leetcode】1046. Last Stone Weight

题目如下: We have a collection of rocks, each rock has a positive integer weight. Each turn, we choose t ...

- mycat操作mysql示例之分库

准备工作: 服务器192.168.96.12,centos7, jdk,mysql5.7,mycat1.6.x,navicat 搭建步骤: 1.在服务器192.168.96.12服务器上安装mysql ...

- [CSP-S模拟测试]:trade(反悔贪心)

题目传送门(内部题62) 输入格式 第一行有一个整数$n$.第二行有$N$个整数:$a_1\ a_2\ a_3\cdot\cdot\cdot a_n$. 输出格式 一行一个整数表示最大收益. 样例 样 ...

- [CSP-S模拟测试96]题解

以后不能再借没改完题的理由不写题解了…… A.求和 求$\sum \sum i+j-1$ 柿子就不化了吧……这年头pj都不考这么弱智的公式化简了…… 坑点1:模数不定,可能没有2的逆元,那么只要先把乘 ...

- drawArc

1) 画笔设置 Paint.Style.STROKE 中空模式 paint = new Paint(); //新建一个画笔对象 paint.setAntiAlias(true);//抗锯齿功能 pai ...

- (转)Python3 zip() 函数

转:http://www.runoob.com/python3/python3-func-zip.html 描述 zip() 函数用于将可迭代的对象作为参数,将对象中对应的元素打包成一个个元组,然后返 ...