python之Beautiful Soup库

1、简介

简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据。官方解释如下:

Beautiful Soup提供一些简单的、python式的函数用来处理导航、搜索、修改分析树等功能。它是一个工具箱,通过解析文档为用户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出一个完整的应用程序。

Beautiful Soup自动将输入文档转换为Unicode编码,输出文档转换为utf-8编码。你不需要考虑编码方式,除非文档没有指定一个编码方式,这时,Beautiful Soup就不能自动识别编码方式了。然后,你仅仅需要说明一下原始编码方式就可以了。

Beautiful Soup已成为和lxml、html6lib一样出色的python解释器,为用户灵活地提供不同的解析策略或强劲的速度。

2、环境安装

Beautiful Soup 3 目前已经停止开发,推荐在现在的项目中使用Beautiful Soup 4,不过它已经被移植到BS4了,也就是说导入时我们需要 from bs4 import BeautifulSoup 。所以这里我们用的版本是 Beautiful Soup 4.3.2 (简称BS4)。

1、快速安装

|

1

|

pip install beautifulsoup4 |

2、如果想安装最新的版本,请直接下载安装包来手动安装,也是十分方便的方法

1、Beautiful Soup3.2.1

https://pypi.python.org/pypi/BeautifulSoup/3.2.1

2、Beautiful Soup4.3.2

https://pypi.python.org/pypi/beautifulsoup4/

下载完成之后解压

运行下面的命令即可完成安装

python setup.py install

3、然后需要安装 lxml

pip install lxml

另一个可供选择的解析器是纯Python实现的 html5lib , html5lib的解析方式与浏览器相同,可以选择下列方法来安装html5lib:

pip install html5lib

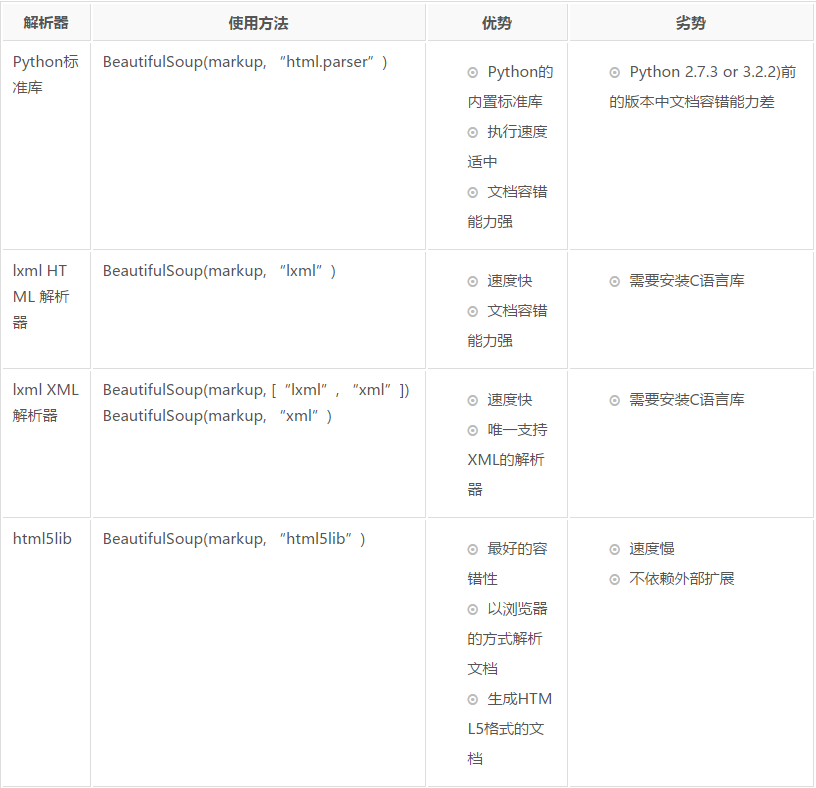

Beautiful Soup支持Python标准库中的HTML解析器,还支持一些第三方的解析器,如果我们不安装它,则 Python 会使用 Python默认的解析器,lxml 解析器更加强大,速度更快,推荐安装。

3. 使用方法

最佳方法参考官方文档:https://www.crummy.com/software/BeautifulSoup/bs4/doc.zh/

以下内容测试css和xpath分别提取文本和属性的区别,方便后续查看

from scrapy.selector import Selector

from scrapy.http import HtmlResponse

from bs4 import BeautifulSoup as bs body = '''<html>

<head>

<base href='http://example.com/' />

<title id="txt">Example website</title>

</head>

<body>

<div id='images'>

<a href='image1.html'>Name: My image <br /><img src='image1_thumb.jpg' /></a>

<a href='image2.html'>Name: My image <br /><img src='image2_thumb.jpg' /></a>

<a href='image3.html'>Name: My image <br /><img src='image3_thumb.jpg' /></a>

<a href='image4.html'>Name: My image <br /><img src='image4_thumb.jpg' /></a>

<a href='image5.html'>Name: My image <br /><img src='image5_thumb.jpg' /></a>"div text"</div>

<div>helloworld test</div>

</body>

</html>'''

soup = bs(body, "lxml")

print("css获取属性:",soup.select("div")[].attrs["id"])

print("xpath获取属性:",Selector(text=body).xpath("//div/@id").extract()[]) print("css获取文本:", soup.select("title[id='txt']")[].string)

print("xpath获取文本:",Selector(text=body).xpath("//title[@id='txt']/text()").extract()[])

python之Beautiful Soup库的更多相关文章

- Python Beautiful Soup库

Beautiful Soup库 Beautiful Soup库:https://www.crummy.com/software/BeautifulSoup/ 安装Beautiful Soup: 使用B ...

- Beautiful Soup库基础用法(爬虫)

初识Beautiful Soup 官方文档:https://www.crummy.com/software/BeautifulSoup/bs4/doc/# 中文文档:https://www.crumm ...

- 【转载】Beautiful Soup库(bs4)入门

转载自:Beautiful Soup库(bs4)入门 该库能够解析HTML和XML 使用Beautiful Soup库: from bs4 import BeautifulSoup impo ...

- Beautiful Soup库入门

1.安装:pip install beautifulsoup4 Beautiful Soup库是解析.遍历.维护“标签树”的功能库 2.引用:(1)from bs4 import BeautifulS ...

- python beautiful soup库的超详细用法

原文地址https://blog.csdn.net/love666666shen/article/details/77512353 参考文章https://cuiqingcai.com/1319.ht ...

- 【Python爬虫学习笔记(3)】Beautiful Soup库相关知识点总结

1. Beautiful Soup简介 Beautiful Soup是将数据从HTML和XML文件中解析出来的一个python库,它能够提供一种符合习惯的方法去遍历搜索和修改解析树,这将大大减 ...

- crawler碎碎念4 关于python requests、Beautiful Soup库、SQLlite的基本操作

Requests import requests from PIL import Image from io improt BytesTO import jason url = "..... ...

- Python之Beautiful Soup的用法

1. Beautiful Soup的简介 简单来说,Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据.官方解释如下: Beautiful Soup提供一些简单的.pyt ...

- Python的Beautiful Soup简单使用

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据 Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能 它是一个工具箱, ...

随机推荐

- LVS原理详解以及部署

linux virtual server简称LVS,Internet的快速增长使多媒体网络服务器面对的访问数量快速增加,服务器需要具备提供大量并发访问服务的能力,因此对于大负载的服务器来讲, CPU. ...

- SQL中的几个判断是否存在

库是否存在if exists(select * from master..sysdatabases wherename=N'库名')print 'exists'elseprint 'not exist ...

- [HEOI2016/TJOI2016]求和(第二类斯特林数)

题目 [HEOI2016/TJOI2016]求和 关于斯特林数与反演的更多姿势\(\Longrightarrow\)点这里 做法 \[\begin{aligned}\\ Ans&=\sum\l ...

- 解析Linux系统的平均负载概念

一.什么是系统平均负载(Load average)? 在Linux系统中,uptime.w.top等命令都会有系统平均负载load average的输出,那么什么是系统平均负载呢?系统平均负载被定义为 ...

- [POI2012] BEZ-Minimalist Security

一张n个点m条边的无向图,有点权有边权都是非负,且每条边的权值小于等于两个顶点的权值和,现在要将每个点减一个非负整数使得每条边权等于两个顶点的点权和,问最大修改代价和最小修改代价 思路神的一匹,完全想 ...

- JAVA文件下载,页面显示另存为效果

经过测试 firefox.QQ.IE 浏览器是可以的 chrome浏览器不行(直接下载了) 1. 系统框架springmvc+jsp 2. 后台servlet代码 @RequestMapping( ...

- Contest-hunter 暑假送温暖 SRM08

01-07都没写...然后突然来写貌似有点突兀啊...不管了,难得前排记录一下... 吐槽一下赛制...不得不说很强... cf 套oi...很创新...不过还是兹磁ACM或者CF A-1 数据才2& ...

- Ubuntu 通过APT安装Tomcat

Ubuntu 通过APT安装Tomcat 安装 sudo apt-get install tomcat8 tomcat8-docs tomcat8-examples tomcat8-admin # s ...

- Nginx配置端口访问的网站

server { listen 80; #listen [::]:80 default_server ipv6only=on; server_name www.website.com; index i ...

- 腾讯开源的Android UI框架——QMUI Android

各位同学,早上好,我是你们的老朋友D_clock爱吃葱花,前些天忙着发版本,最近也在看各种各样的新知识,有好多东西想写啊啊啊啊啊.嗯,先冷静捋一下,卖个关子.扯回正题,今天继续为大家推荐一个Githu ...