使用TorchLens可视化一个简单的神经网络

TorchLens:可用于可视化任何PyTorch模型,一个包用于在一行代码中提取和映射PyTorch模型中每个张量运算的结果。TorchLens功能非常强大,如果能够熟练掌握,算是可视化PyTorch模型的一把利剑。本文通过TorchLens可视化一个简单神经网络,算是抛砖引玉吧。

一.定义一个简单神经网络

import torch

import torch.nn as nn

import torch.optim as optim

import torchlens as tl

import os

os.environ["PATH"] += os.pathsep + 'D:/Program Files/Graphviz/bin/'

# 定义神经网络类

class NeuralNetwork(nn.Module): # 继承nn.Module类

def __init__(self, input_size, hidden_size, output_size):

super(NeuralNetwork, self).__init__() # 调用父类的构造函数

# 定义输入层到隐藏层的线性变换

self.input_to_hidden = nn.Linear(input_size, hidden_size)

# 定义隐藏层到输出层的线性变换

self.hidden_to_output = nn.Linear(hidden_size, output_size)

# 定义激活函数

self.sigmoid = nn.Sigmoid()

def forward(self, x):

# 前向传播

hidden = self.sigmoid(self.input_to_hidden(x))

output = self.sigmoid(self.hidden_to_output(hidden))

return output

def NeuralNetwork_train(model):

# 训练神经网络

for epoch in range(10000):

optimizer.zero_grad() # 清零梯度

outputs = model(input_data) # 前向传播

loss = criterion(outputs, labels) # 计算损失

loss.backward() # 反向传播和优化

optimizer.step() # 更新参数

# 每100个epoch打印一次损失

if (epoch + 1) % 1000 == 0:

print(f'Epoch [{epoch + 1}/10000], Loss: {loss.item():.4f}')

return model

def NeuralNetwork_test(model):

# 在训练后,可以使用模型进行预测

with torch.no_grad():

test_input = torch.tensor([[0, 0], [0, 1], [1, 0], [1, 1]], dtype=torch.float32)

predictions = model(test_input)

predicted_labels = (predictions > 0.5).float()

print("Predictions:", predicted_labels)

if __name__ == '__main__':

# 定义神经网络的参数

input_size = 2 # 输入特征数量

hidden_size = 4 # 隐藏层神经元数量

output_size = 1 # 输出层神经元数量

# 创建神经网络实例

model = NeuralNetwork(input_size, hidden_size, output_size)

# 定义损失函数和优化器

criterion = nn.BCELoss() # 二分类交叉熵损失

optimizer = optim.SGD(model.parameters(), lr=0.1) # 随机梯度下降优化器

# 准备示例输入数据和标签

input_data = torch.tensor([[0, 0], [0, 1], [1, 0], [1, 1]], dtype=torch.float32)

labels = torch.tensor([[0], [1], [1], [0]], dtype=torch.float32)

# model:神经网络模型

# input_data:输入数据

# layers_to_save:需要保存的层

# vis_opt:rolled/unrolled,是否展开循环

model_history = tl.log_forward_pass(model, input_data, layers_to_save='all', vis_opt='unrolled') # 可视化神经网络

print(model_history)

# print(model_history['input_1'].tensor_contents)

# print(model_history['input_1'])

tl.show_model_graph(model, input_data)

# model = NeuralNetwork_train(model) # 训练神经网络

# NeuralNetwork_test(model) # 测试神经网络

1.神经网络结构

输入层包括2个神经元,隐藏层包括4个神经元,输出层包括1个神经元。

2.log_forward_pass

给定输入x,通过模型运行前向传播,并返回一个包含前向传播日志(层激活和相应的层元数据)的ModelHistory对象。如果vis_opt设置为rolled或unrolled并可视化模型图。

3.show_model_graph

可视化模型图,而不保存任何激活。

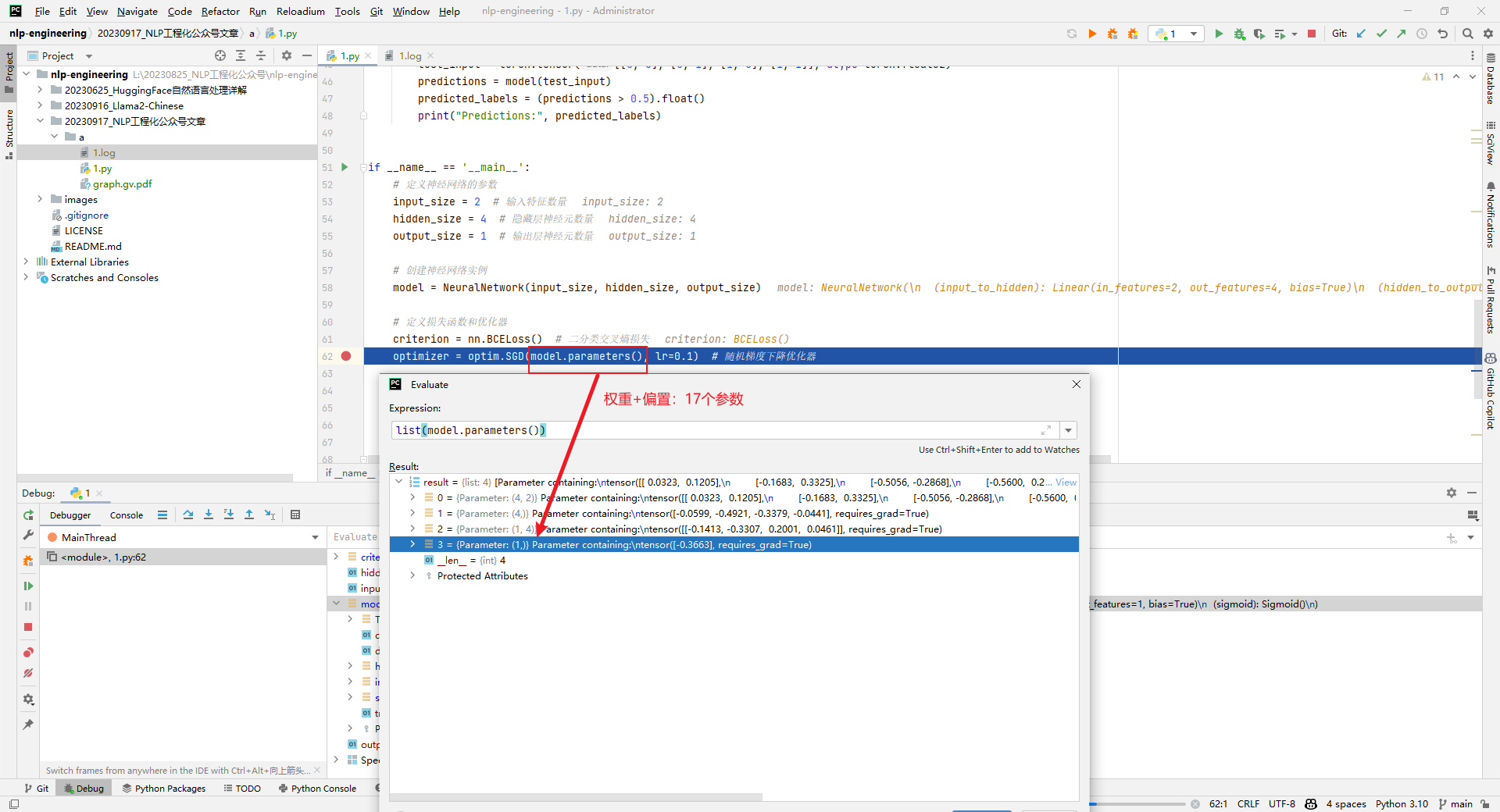

4.查看神经网络模型参数

权重(12)+偏置(5)共计17个参数,如下所示:

二.输出结果分析

1.model_history输出结果

Log of NeuralNetwork forward pass: // 神经网络前向传播日志

Random seed: 1626722175 // 随机种子

Time elapsed: 1.742s (1.74s spent logging) // 耗时

Structure: // 结构

- purely feedforward, no recurrence // 纯前馈,无循环

- no branching // 无分支

- no conditional (if-then) branching // 无条件(if-then)分支

- 3 total modules // 3个模块

Tensor info: // 张量信息

- 6 total tensors (976 B) computed in forward pass. // 前向传播中计算的6个张量(976 B)

- 6 tensors (976 B) with saved activations. // 6个张量(976 B)保存了激活

Parameters: 2 parameter operations (17 params total; 548 B) // 参数:2个参数操作(总共17个参数;548 B)

Module Hierarchy: // 模块层次

input_to_hidden // 输入到隐藏

sigmoid:1 // sigmoid:1

hidden_to_output // 隐藏到输出

sigmoid:2 // sigmoid:2

Layers (all have saved activations): // 层(所有层都有保存的激活)

(0) input_1 // 输入

(1) linear_1_1 // 线性

(2) sigmoid_1_2 // sigmoid

(3) linear_2_3 // 线性

(4) sigmoid_2_4 // sigmoid

(5) output_1 // 输出

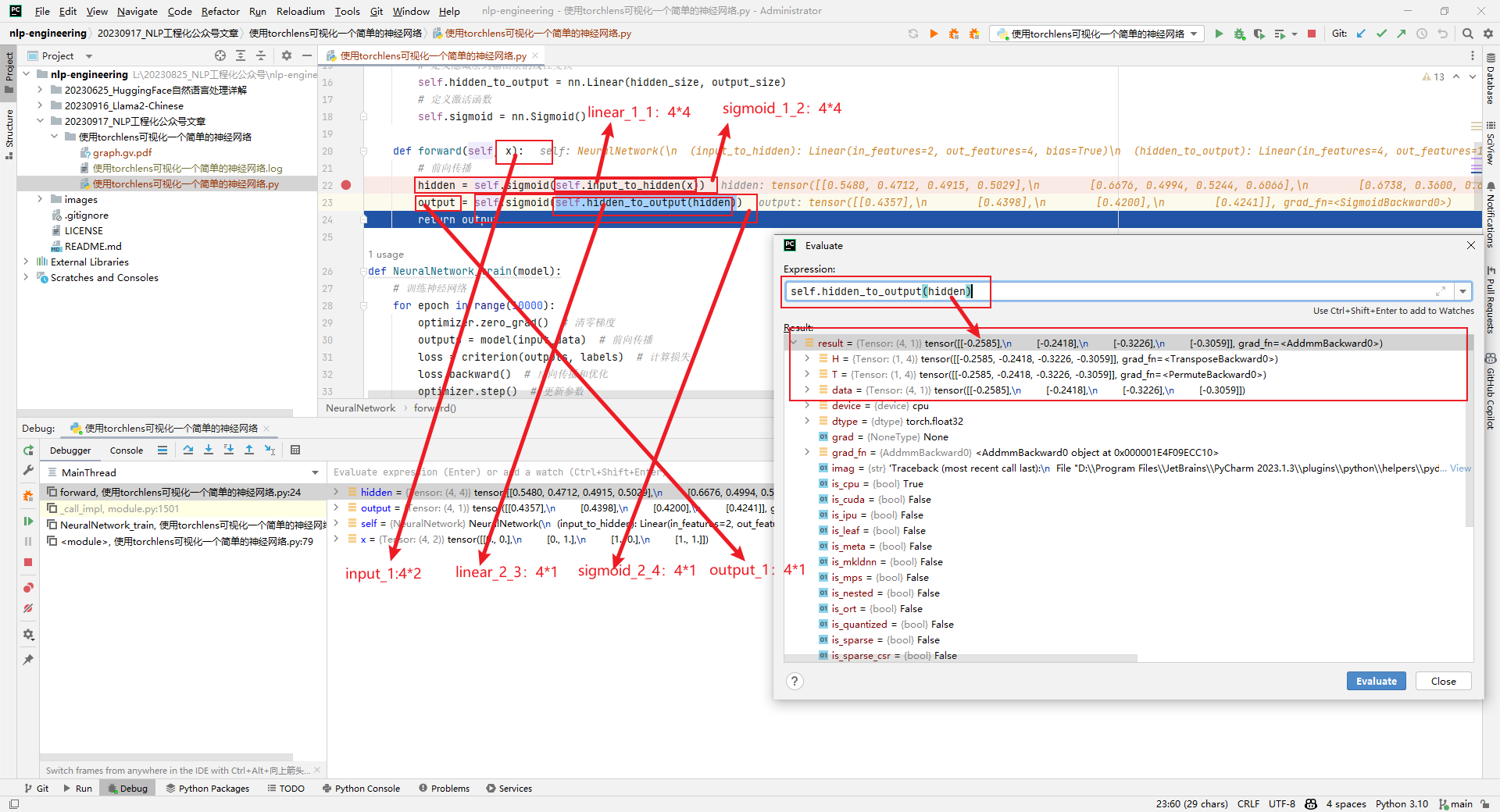

2.show_model_graph输出结果

(1)总共包含6层

分别为input_1、linear_1_1、sigmoid_1_2、linear_2_3、sigmoid_2_4和output_1。

(2)总共6个张量

指的是input_1(160B)、linear_1_1(192B)、sigmoid_1_2(192B)、linear_2_3(144B)、sigmoid_2_4(144B)和output_1(144B)。共计976B。

(3)input_1 4*2(160B)

4*2表示input_1的shape,而160B指的是该张量在内存中占用空间大小,以字节(B)为单位。知道张量的形状和内存占用情况,对于模型内存管理和优化来说是很有用的信息。其它张量信息如下所示:

(4)共计17参数

linear_1_1参数信息为42和4,linear_1_1参数信息为14和1,共计17参数,内存占用548B。

三.遇到的问题

1.需要安装和设置graphviz

subprocess.CalledProcessError: Command '[WindowsPath('dot'), '-Kdot', '-Tpdf', '-O', 'graph.gv']' returned non-zero exit status 1.

解决方案是将D:\Program Files\Graphviz\bin添加到系统环境变量PATH中。

2.AlexNet神经网络

因为BP神经网络过于简单,接下来可视化一个稍微复杂点儿的AlexNet神经网络,如下所示:

参考文献:

[1]torchlens_tutorial.ipynb:https://colab.research.google.com/drive/1ORJLGZPifvdsVPFqq1LYT3t5hV560SoW?usp=sharing#scrollTo=W_94PeNdQsUN

[2]Extracting and visualizing hidden activations and computational graphs of PyTorch models with TorchLens:https://www.nature.com/articles/s41598-023-40807-0

[3]torchlens:https://github.com/johnmarktaylor91/torchlens

[4]Torchlens Model Menagerie:https://drive.google.com/drive/folders/1BsM6WPf3eB79-CRNgZejMxjg38rN6VCb

[5]使用TorchLens可视化一个简单的神经网络:github.com/ai408/nlp-engineering/tree/main/20230917_NLP工程化公众号文章/使用torchlens可视化一个简单的神经网络

使用TorchLens可视化一个简单的神经网络的更多相关文章

- tensorflow笔记(二)之构造一个简单的神经网络

tensorflow笔记(二)之构造一个简单的神经网络 版权声明:本文为博主原创文章,转载请指明转载地址 http://www.cnblogs.com/fydeblog/p/7425200.html ...

- Python实现一个简单三层神经网络的搭建并测试

python实现一个简单三层神经网络的搭建(有代码) 废话不多说了,直接步入正题,一个完整的神经网络一般由三层构成:输入层,隐藏层(可以有多层)和输出层.本文所构建的神经网络隐藏层只有一层.一个神经网 ...

- python日记:用pytorch搭建一个简单的神经网络

最近在学习pytorch框架,给大家分享一个最最最最基本的用pytorch搭建神经网络并且训练的方法.本人是第一次写这种分享文章,希望对初学pytorch的朋友有所帮助! 一.任务 首先说下我们要搭建 ...

- pytorch定义一个简单的神经网络

刚学习pytorch,简单记录一下 """ test Funcition """ import torch from torch.autog ...

- 使用RStudio学习一个简单神经网络

数据准备 1.收集数据 UC Irvine Machine Learning Repository-Concrete Compressive Strength Data Set 把下载到的Concre ...

- 从程序员的角度设计一个Java的神经网络

欢迎大家前往云+社区,获取更多腾讯海量技术实践干货哦~ 来自维基百科: 人工神经网络(ANN)或连接系统是受生物神经网络启发构成生物大脑的计算系统.这样的系统通过考虑例子来学习(逐步提高性能)来完成任 ...

- pytorch学习笔记(8)--搭建简单的神经网络以及Sequential的使用

1.神经网络图 输入图像是3通道的32×32的,先后经过卷积层(5×5的卷积核).最大池化层(2×2的池化核).卷积层(5×5的卷积核).最大池化层(2×2的池化核).卷积层(5×5的卷积核).最大池 ...

- C++从零实现简单深度神经网络(基于OpenCV)

代码地址如下:http://www.demodashi.com/demo/11138.html 一.准备工作 需要准备什么环境 需要安装有Visual Studio并且配置了OpenCV.能够使用Op ...

- 使用Python来编写一个简单的感知机

来表示.第二个元素是表示期望输出的值. 这个数组定义例如以下: training_data = [ (array([0,0,1]), 0), (array([0,1,1]), 1), (arra ...

- tensorflow学习笔记四:mnist实例--用简单的神经网络来训练和测试

刚开始学习tf时,我们从简单的地方开始.卷积神经网络(CNN)是由简单的神经网络(NN)发展而来的,因此,我们的第一个例子,就从神经网络开始. 神经网络没有卷积功能,只有简单的三层:输入层,隐藏层和输 ...

随机推荐

- Galaxy Release_20.09 发布,新增多个数据上传组件

Galaxy Project(https://galaxyproject.org/)是在云计算背景下诞生的一个生物信息学可视化分析开源项目. 该项目由美国国家科学基金会(NSF).美国国家人类基因组研 ...

- OSPF 多区域配置实验

实验拓扑 实验需求 按照图示配置 IP 地址和loopback 接口 按照图示分区域配置 OSPF ,实现全网互通 为了路由结构稳定,要求路由器使用环回口作为 Router-id 在AR3上配置静默接 ...

- 【Python入门教程】Python常用表格函数&操作(xlrd、xlwt、openpyxl、xlwings)

在我们使用Python时,避免不了与Excel打交道.同样Python的三方库和代码的简洁性也为我们处理大数据提供了便利.今天给大家介绍一下常用的处理表格的函数,同时还有一些常用的 ...

- .Net7矢量化的性能优化

前言 矢量化是性能优化的重要技术,也是寄托硬件层面的优化技术.本篇来看下. 概括 一:矢量化支持的问题: 矢量化的System.Runtime.Intrinsics.X86.Sse2.MoveMask ...

- [ARM汇编]计算机原理与数制基础—1.1.2 二进制与十进制数制转换

在计算机中,我们通常使用二进制数制来表示数据,因为计算机的基本电平只有两种状态:高电平(通常表示为 1)和低电平(通常表示为 0).而在我们的日常生活中,我们习惯使用十进制数制.为了方便理解,我们需要 ...

- 前端学习C语言 - 函数和关键字

函数和关键字 本篇主要介绍:自定义函数.宏函数.字符串处理函数和关键字. 自定义函数 基本用法 实现一个 add() 函数.请看示例: #include <stdio.h> // 自定义函 ...

- 【保姆级教程】Vue项目调试技巧

前言 在Vue项目开发过程中,当遇到应用逻辑出现错误,但又无法准确定位的时候,知晓Vue项目调试技巧至关重要,debug是必备技能. 同后台项目开发一样,可以在JS实现的应用逻辑中设置断点,并进行单步 ...

- 前端Vue图片上传组件支持单个文件多个文件上传 自定义上传数量 预览删除图片 图片压缩

前端Vue图片上传组件支持单个文件多个文件上传 自定义上传数量 预览删除图片 图片压缩, 下载完整代码请访问uni-app插件市场址:https://ext.dcloud.net.cn/plugin? ...

- IOS开发--UILabel的基本使用

UILabel是iOS中用于显示静态文本的控件. 它的主要功能是:1. 显示一行或多行文本 UILabel可以用来显示单行或多行文本内容.通过设置numberOfLines属性可以控制文本显示的行数. ...

- 端口探测神器——Nmap

Nmap 简介: 全称网络映射器,能快速扫描大型网络或单个网络上有哪些主机,这些主机提供什么服务,可以发现服务器运行在什么操作系统上,从而发现可攻击的脆弱点,扩大攻击范围 Nmap有图形化版本名叫Ze ...