Confluent介绍(二)--confluent platform quickstart

下载

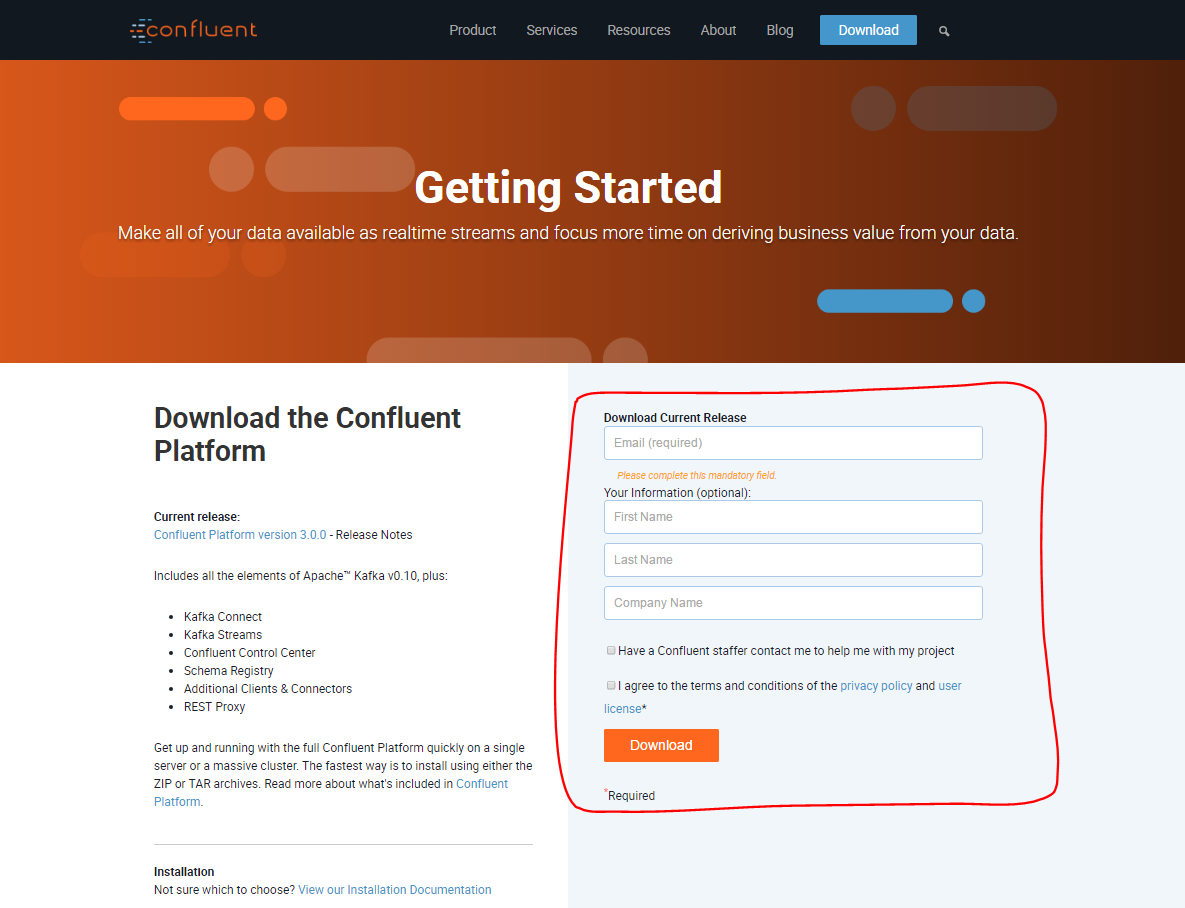

http://www.confluent.io/download,打开后,显示最新版本3.0.0,然后在右边填写信息后,点击Download下载。

之后跳转到下载页面,选择zip 或者 tar都行, 下载完成后上传linux系统,解压即完成安装。

- zip and tar archives– 推荐OS X 和 Quickstart

- deb packages via apt – 推荐安装服务在 Debian/Ubuntu系统

- rpm packages via yum – 推荐安装服务在 RHEL/CentOS/Fedora系统

- deb/rpm packages with installer script

Confluent 目前还不支持Windows系统。Windows用户可以下载和使用zip 和 tar包,但最好直接运行jar文件 ,而不是使用包装脚本。

Requirements

唯一需要的条件是java 版本>=1.7。

Confluent Platform Quickstart

你可以快速的运行Confluent platform在单台服务器上。在这篇quickstart,我们将介绍如何运行ZooKeeper,Kafka,和Schema Registry,然后如何读和写一些Avro数据从/到Kafka。

(如果你想跑一个数据管道用Kafka Connect和Control Center,参考The Control Center QuickStart Guide.)我们随后也会介绍。

1.下载和安装Confluent platform。在这篇quickstart 我们使用zip包,也有很多其他安装方式,见上。

$ wget http://packages.confluent.io/archive/3.0/confluent-3.0.0-2.11.zip

$ unzip confluent-3.0.-2.11.zip

$ cd confluent-3.0.

下边展示的是安装目录里上层层级结构:

confluent-3.0./bin/ # Driver scripts for starting/stopping services

confluent-3.0./etc/ # Configuration files

confluent-3.0./share/java/ # Jars

如果你通过deb或者rpm安装,目录结构如下:

/usr/bin/ # Driver scripts for starting/stopping services, prefixed with <package> names

/etc/<package>/ # Configuration files

/usr/share/java/<package>/ # Jars

2.启动Zookeeper。因为这是长期运行的服务,你应该运行它在一个独立的终端(或者在后边运行它,重定向输出到一个文件中)。你需要有写权限到/var/lib在这一步以及之后的步骤里:

# The following commands assume you exactly followed the instructions above.

# This means, for example, that at this point your current working directory

# must be confluent-3.0./.

$ ./bin/zookeeper-server-start ./etc/kafka/zookeeper.properties

3.启动Kafka,同样在一个独立的终端。

$ ./bin/kafka-server-start ./etc/kafka/server.properties

4.启动Schema Registry,同样在一个独立的终端。

$ ./bin/schema-registry-start ./etc/schema-registry/schema-registry.properties

5.现在所有需要的服务都已启动,我们发送一些Avro数据到Kafka的topic中。虽然这一步一般会得到一些数据从一些应用里,这里我们使用Kafka提供的例子,不用写代码。我们在本地的Kafka集群里,写数据到topic “test”里,读取每一行Avro信息,校验Schema Registry .

$ ./bin/kafka-avro-console-producer \

--broker-list localhost: --topic test \

--property value.schema='{"type":"record","name":"myrecord","fields":[{"name":"f1","type":"string"}]}'

一旦启动,进程等待你输入一些信息,一条一行,会发送到topic中一旦按下enter键。试着输入一些信息:

{"f1": "value1"}

{"f1": "value2"}

{"f1": "value3"}

输入完成后,可以使用Ctrl+C来终止进程。

Note:如果一个空行你按下Enter键,会被解释为一个null值,引起错误。然后仅仅需要做的是启动producer进程,接着输入信息。

6.现在我们可以检查,通过Kafka consumer控制台读取数据从topic。在topic ‘test'中,Zookeeper实例,会告诉consumer解析数据使用相同的schema。最后从开始读取数据(默认consumer只读取它启动之后写入到topic中的数据)

$ ./bin/kafka-avro-console-consumer --topic test \

--zookeeper localhost: \

--from-beginning

你会看到你之前在producer中输入的数据,以同样的格式。

consumer不会退出,它可以监听写入到topic中的新数据。保持consumer运行,然后重复第5步,输入一些信息,然后按下enter键,你会看到consumer会立即读取到写入到topic中的数据。

当你完成了测试,可以用Ctrl+C终止进程。

7.现在让我们尝试写一些不兼容的schema的数据到topic ’test‘中,我们重新运行producer命令,但是改变schema。

$ ./bin/kafka-avro-console-producer \

--broker-list localhost:9092 --topic test \

--property value.schema='{"type":"int"}'

现在输入一个整数按下enter键,你会看到以下的异常:

org.apache.kafka.common.errors.SerializationException: Error registering Avro schema: "int"

Caused by: io.confluent.kafka.schemaregistry.client.rest.exceptions.RestClientException: Schema being registered is incompatible with the latest schema; error code:

at io.confluent.kafka.schemaregistry.client.rest.utils.RestUtils.httpRequest(RestUtils.java:)

at io.confluent.kafka.schemaregistry.client.rest.utils.RestUtils.registerSchema(RestUtils.java:)

at io.confluent.kafka.schemaregistry.client.CachedSchemaRegistryClient.registerAndGetId(CachedSchemaRegistryClient.java:)

at io.confluent.kafka.schemaregistry.client.CachedSchemaRegistryClient.register(CachedSchemaRegistryClient.java:)

at io.confluent.kafka.serializers.AbstractKafkaAvroSerializer.serializeImpl(AbstractKafkaAvroSerializer.java:)

at io.confluent.kafka.formatter.AvroMessageReader.readMessage(AvroMessageReader.java:)

at kafka.tools.ConsoleProducer$.main(ConsoleProducer.scala:)

at kafka.tools.ConsoleProducer.main(ConsoleProducer.scala)

当producer试图发送一些信息,它会检查schema用Schema Registry。当返回错误时说明现在的schema无效,因为它不能兼容之前设置的schema。控制台打印出错误信息并退出,但是你自己的应用可以更加人性化处理这类问题。但最重要的是,我们保证不让不兼容的数据写入到Kafka中。

8.当你完成这一系列测试,你可以使用ctrl+c来关闭服务,以启动时相反的顺序。

这一简单的教程包含了Kafka和Schema Registry这一些核心的服务。你也可以参考以下document:

- Confluent Control Center documentation

- Kafka Streams documentation

- Kafka Connect documentation

- Schema Registry documentation

- Kafka REST Proxy documentation

- Camus documentation

本片博文为作者原创,转载请注明出处,部分译自confluent官网

Confluent介绍(二)--confluent platform quickstart的更多相关文章

- Confluent介绍(一)

最开始接触confluent是通过这篇博客,How to Build a Scalable ETL Pipeline with Kafka Connect,对于做大数据的,数据的ETL(抽取,转换,装 ...

- Confluent介绍

Building a Scalable ETL Pipeline in 30 Minutes confluent介绍: LinkedIn有个三人小组出来创业了—正是当时开发出Apache Kafka实 ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(六)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(六) Lucene.Net的上一个版本是2.1,而在2.3.1版本中才引入了Next(Token)方法重载,而ReusableStrin ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(五)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(五) 2.1.3 二元分词 上一节通过变换查询表达式满足了需求,但是在实际应用中,如果那样查询,会出现另外一个问题,因为,那样搜索,是只 ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(三)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(三) 1.3 分词器结构 1.3.1 分词器整体结构 从1.2节的分析,终于做到了管中窥豹,现在在Lucene.Net项目中添加一个类关 ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(四)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(四) 2.1.2 可以使用的内置分词 简单的分词方式并不能满足需求.前文说过Lucene.Net内置分词中StandardAnalyze ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(二)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(二) 1.2.分词的过程 1.2.1.分词器工作的过程 内置的分词器效果都不好,那怎么办?只能自己写了!在写之前当然是要先看看内置的分词 ...

- Lucene.Net 2.3.1开发介绍 —— 二、分词(一)

原文:Lucene.Net 2.3.1开发介绍 -- 二.分词(一) Lucene.Net中,分词是核心库之一,当然,也可以将它独立出来.目前Lucene.Net的分词库很不完善,实际应用价值不高.唯 ...

- {Django基础十之Form和ModelForm组件}一 Form介绍 二 Form常用字段和插件 三 From所有内置字段 四 字段校验 五 Hook钩子方法 六 进阶补充 七 ModelForm

Django基础十之Form和ModelForm组件 本节目录 一 Form介绍 二 Form常用字段和插件 三 From所有内置字段 四 字段校验 五 Hook钩子方法 六 进阶补充 七 Model ...

随机推荐

- java servlet手机app访问接口(二)短信验证

今天找了几个短信平台,其实最想使用的一个是sharesdk,使用它上面http api短信功能,不仅价格低,而且最少可以充值100RMB,但是审核过于严格,对应APP还必须集成他们的短信功能,而且要上 ...

- 《Head First Java》——对象的行为

类所描述的是 对象知道什么与执行什么! 调用两个参数的方法,并传入两个参数 void go(){ TestStuff t = new TestStuff(); t.takeTwo(12,34); } ...

- RDBMS架构的开源DW/DSS引擎列表

因为笔者早期以oracle为主要RDBMS进行设计和优化,所以几乎即使单表超过5000w,多张超过300万以上的表做任意复杂的统计和风控计算都没出过性能问题.如今全面mysql为主线或者说open s ...

- Hibernate(七)__多对一 、一对多、 一对一、多对多

1.many-to-one 以学生和部门之间的关系为例: Department.hbm.xml <?xml version="1.0" encoding="utf- ...

- javascript 异步模块加载 简易实现

在javascript是没有类似java或其他语言的模块概念的,因此也不可能通过import或using等关键字来引用模块,这样造成了复杂项目中前端代码混乱,变量互相影响等. 因此在复杂项目中引入AM ...

- 20款免费响应式的 HTML5 网站模板下载

今天这篇文章给大家带来的是20款免费响应式的 HTML5 网站模板,大家可以借助这些优秀的网站模板创建自己的优秀网站.响应式(Responsive Design)设计的目标是要让产品界面能够响应用户的 ...

- about reg

var getR=function(str,reg){ return str.match(reg).join(""); } var a=getR("138888" ...

- 最近喜欢听的英文歌——Because Of You - Kelly Clarkson

没了解过歌曲背景,总觉得像是一首女儿唱给母亲的歌= =也许是我的错觉 I will not make the same mistakes that you did 我不会重复你犯过的错误 I will ...

- VS 2015打开项目闪退,新建项目提示未将对象引用到实例

因为开发需要,要把开发工具换成visual studio2015,装完之后会有警告“js”安装的问题,打开VS也没有问题, 但是一打开项目就闪退,新建项目也不行,查看应用程序日志,报错提示如下: .N ...

- sharepoint 权限继承相关

重新继承父级权限: SPList.ResetRoleInheritance(); 断开继承: SPList.BreakRoleInheritance(true); 用powershell断开继承: $ ...