七月在线爬虫班学习笔记(五)——scrapy spider的几种爬取方式

第五课主要内容有:

- Scrapy框架结构,组件及工作方式

- 单页爬取-julyedu.com

- 拼URL爬取-博客园

- 循环下页方式爬取-toscrape.com

- Scrapy项目相关命令-QQ新闻

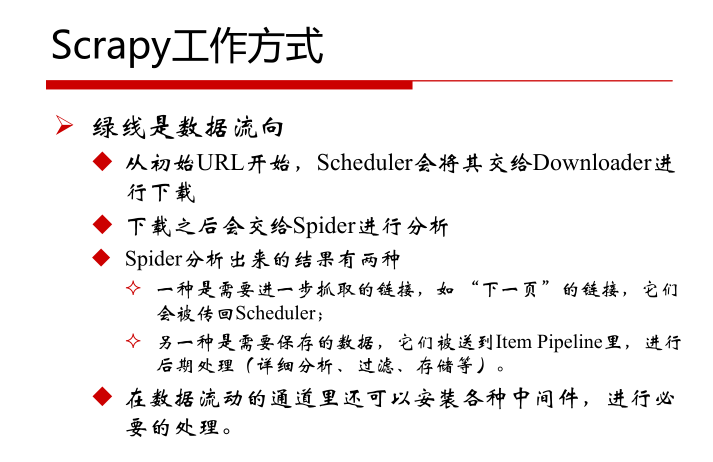

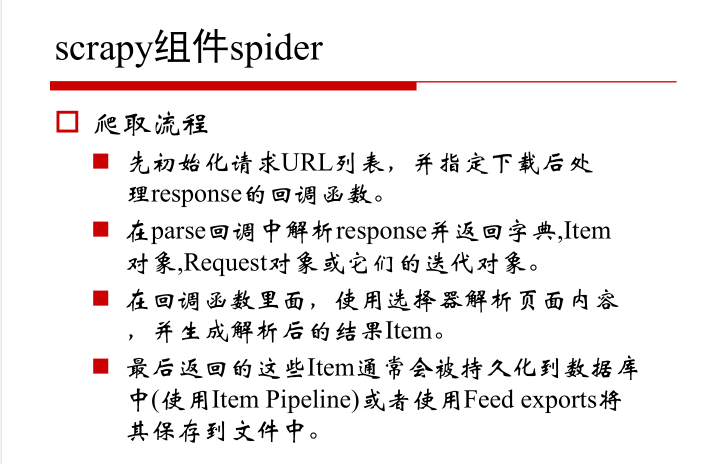

1.Scrapy框架结构,组件及工作方式

2.单页爬取-julyedu.com

#by 寒小阳(hanxiaoyang.ml@gmail.com)---七月在线讲师

#Python2 import scrapy class JulyeduSpider(scrapy.Spider):

name = "julyedu"

start_urls = [

'https://www.julyedu.com/category/index',

] def parse(self, response):

for julyedu_class in response.xpath('//div[@class="course_info_box"]'):

print julyedu_class.xpath('a/h4/text()').extract_first()

print julyedu_class.xpath('a/p[@class="course-info-tip"][1]/text()').extract_first()

print julyedu_class.xpath('a/p[@class="course-info-tip"][2]/text()').extract_first()

print response.urljoin(julyedu_class.xpath('a/img[1]/@src').extract_first())

print "\n" yield {

'title':julyedu_class.xpath('a/h4/text()').extract_first(),

'desc': julyedu_class.xpath('a/p[@class="course-info-tip"][1]/text()').extract_first(),

'time': julyedu_class.xpath('a/p[@class="course-info-tip"][2]/text()').extract_first(),

'img_url': response.urljoin(julyedu_class.xpath('a/img[1]/@src').extract_first())

}

3.拼URL爬取-博客园

#by 寒小阳(hanxiaoyang.ml@gmail.com) import scrapy class CnBlogSpider(scrapy.Spider):

name = "cnblogs"

allowed_domains = ["cnblogs.com"]

start_urls = [

'http://www.cnblogs.com/pick/#p%s' % p for p in xrange(1, 11)

] def parse(self, response):

for article in response.xpath('//div[@class="post_item"]'):

print article.xpath('div[@class="post_item_body"]/h3/a/text()').extract_first().strip()

print response.urljoin(article.xpath('div[@class="post_item_body"]/h3/a/@href').extract_first()).strip()

print article.xpath('div[@class="post_item_body"]/p/text()').extract_first().strip()

print article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/a/text()').extract_first().strip()

print response.urljoin(article.xpath('div[@class="post_item_body"]/div/a/@href').extract_first()).strip()

print article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/span[@class="article_comment"]/a/text()').extract_first().strip()

print article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/span[@class="article_view"]/a/text()').extract_first().strip()

print "" yield {

'title': article.xpath('div[@class="post_item_body"]/h3/a/text()').extract_first().strip(),

'link': response.urljoin(article.xpath('div[@class="post_item_body"]/h3/a/@href').extract_first()).strip(),

'summary': article.xpath('div[@class="post_item_body"]/p/text()').extract_first().strip(),

'author': article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/a/text()').extract_first().strip(),

'author_link': response.urljoin(article.xpath('div[@class="post_item_body"]/div/a/@href').extract_first()).strip(),

'comment': article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/span[@class="article_comment"]/a/text()').extract_first().strip(),

'view': article.xpath('div[@class="post_item_body"]/div[@class="post_item_foot"]/span[@class="article_view"]/a/text()').extract_first().strip(),

}

4.找到‘下一页’标签进行爬取

import scrapy class QuotesSpider(scrapy.Spider):

name = "quotes"

start_urls = [

'http://quotes.toscrape.com/tag/humor/',

] def parse(self, response):

for quote in response.xpath('//div[@class="quote"]'):

yield {

'text': quote.xpath('span[@class="text"]/text()').extract_first(),

'author': quote.xpath('span/small[@class="author"]/text()').extract_first(),

} next_page = response.xpath('//li[@class="next"]/@herf').extract_first()

if next_page is not None:

next_page = response.urljoin(next_page)

yield scrapy.Request(next_page, callback=self.parse)

5.进入链接,按照链接进行爬取

#by 寒小阳(hanxiaoyang.ml@gmail.com) import scrapy class QQNewsSpider(scrapy.Spider):

name = 'qqnews'

start_urls = ['http://news.qq.com/society_index.shtml'] def parse(self, response):

for href in response.xpath('//*[@id="news"]/div/div/div/div/em/a/@href'):

full_url = response.urljoin(href.extract())

yield scrapy.Request(full_url, callback=self.parse_question) def parse_question(self, response):

print response.xpath('//div[@class="qq_article"]/div/h1/text()').extract_first()

print response.xpath('//span[@class="a_time"]/text()').extract_first()

print response.xpath('//span[@class="a_catalog"]/a/text()').extract_first()

print "\n".join(response.xpath('//div[@id="Cnt-Main-Article-QQ"]/p[@class="text"]/text()').extract())

print ""

yield {

'title': response.xpath('//div[@class="qq_article"]/div/h1/text()').extract_first(),

'content': "\n".join(response.xpath('//div[@id="Cnt-Main-Article-QQ"]/p[@class="text"]/text()').extract()),

'time': response.xpath('//span[@class="a_time"]/text()').extract_first(),

'cate': response.xpath('//span[@class="a_catalog"]/a/text()').extract_first(),

}

七月在线爬虫班学习笔记(五)——scrapy spider的几种爬取方式的更多相关文章

- 七月在线爬虫班学习笔记(六)——scrapy爬虫整体示例

第六课主要内容: 爬豆瓣文本例程 douban 图片例程 douban_imgs 1.爬豆瓣文本例程 douban 目录结构 douban --douban --spiders --__init__. ...

- 七月在线爬虫班学习笔记(二)——Python基本语法及面向对象

第二课主要内容如下: 代码格式 基本语法 关键字 循环判断 函数 容器 面向对象 文件读写 多线程 错误处理 代码格式 syntax基本语法 a = 1234 print(a) a = 'abcd' ...

- 【学习笔记】Python 3.6模拟输入并爬取百度前10页密切相关链接

[学习笔记]Python 3.6模拟输入并爬取百度前10页密切相关链接 问题描述 通过模拟网页,实现百度搜索关键词,然后获得网页中链接的文本,与准备的文本进行比较,如果有相似之处则代表相关链接. me ...

- Dynamic CRM 2013学习笔记(十)客户端几种查询数据方式比较

我们经常要在客户端进行数据查询,下面分别比较常用的几种查询方式:XMLHttpRequest, SDK.JQuery, SDK.Rest. XMLHttpRequest是最基本的调用方式,JQuery ...

- (3)分布式下的爬虫Scrapy应该如何做-递归爬取方式,数据输出方式以及数据库链接

放假这段时间好好的思考了一下关于Scrapy的一些常用操作,主要解决了三个问题: 1.如何连续爬取 2.数据输出方式 3.数据库链接 一,如何连续爬取: 思考:要达到连续爬取,逻辑上无非从以下的方向着 ...

- scrapy爬虫框架学习笔记(一)

scrapy爬虫框架学习笔记(一) 1.安装scrapy pip install scrapy 2.新建工程: (1)打开命令行模式 (2)进入要新建工程的目录 (3)运行命令: scrapy sta ...

- Scrapy:学习笔记(2)——Scrapy项目

Scrapy:学习笔记(2)——Scrapy项目 1.创建项目 创建一个Scrapy项目,并将其命名为“demo” scrapy startproject demo cd demo 稍等片刻后,Scr ...

- go微服务框架kratos学习笔记五(kratos 配置中心 paladin config sdk [断剑重铸之日,骑士归来之时])

目录 go微服务框架kratos学习笔记五(kratos 配置中心 paladin config sdk [断剑重铸之日,骑士归来之时]) 静态配置 flag注入 在线热加载配置 远程配置中心 go微 ...

- C#可扩展编程之MEF学习笔记(五):MEF高级进阶

好久没有写博客了,今天抽空继续写MEF系列的文章.有园友提出这种系列的文章要做个目录,看起来方便,所以就抽空做了一个,放到每篇文章的最后. 前面四篇讲了MEF的基础知识,学完了前四篇,MEF中比较常用 ...

随机推荐

- mysql用户管理和pymysql模块

一:mysql用户管理 mysql是一个tcp的服务器,用于操作服务器上的文件数据,接收用户端发送的指令,而接收指令时就 需要考虑安全问题. 在mysql自带的数据库中有4个表是用于用户管理的,分别是 ...

- @staticmethod和@classmethod

一般来说,要使用某个类的方法,需要先实例化一个对象再调用方法. 而使用@staticmethod或@classmethod,就可以不需要实例化,直接类名.方法名()来调用. 这有利于组织代码,把某些应 ...

- DAY 17常用模块

一.时间模块:time 1.时间戳:time.time() # 可以作为数据的唯一标识 print(time.time) # 1554878849.8452318 2.延迟线程的运行:time.sle ...

- psycopg2+postgis+pgAdmin4

基于docker的postgres 部署见这篇 https://www.cnblogs.com/xuanmanstein/p/7742647.html 连接数据库 import psycopg2cla ...

- P2685 [TJOI2012]桥

P2685 [TJOI2012]桥 思路: 先求出最短路: d1[u] : u 到 1 的最短路, d2[u] : u 到 n 的最短路 再求出一条从 1 到 n 的最短路链,然后从链上的每一个点出发 ...

- HBase Block Cache(块缓存)

Block Cache HBase提供了两种不同的BlockCache实现,用于缓存从HDFS读出的数据.这两种分别为: 默认的,存在于堆内存的(on-heap)LruBlockCache 存在堆外内 ...

- NopCommerce源码架构详解

NopCommerce源码架构详解--初识高性能的开源商城系统cms 很多人都说通过阅读.学习大神们高质量的代码是提高自己技术能力最快的方式之一.我觉得通过阅读NopCommerce的源码,可以从 ...

- SWPU新闻后台登录页面

最终效果图: <!DOCTYPE html> <html> <head> <meta charset="UTF-8"> <ti ...

- php(三)使用thinkphp操作数据库

1.数据库设置 在项目D:\workspaces\phpDemo01\helloworldProject\Common\Conf\config.php配置: <?php return array ...

- CodeIgniter框架解析

转载于:https://www.cnblogs.com/xiaoxiaoqingyi/p/6901654.html 转载仅为以后自己学习. 业余花了点时间看看CodeIgniter框架(简称CI),C ...