k8s系列---service

来源 : http://blog.itpub.net/28916011/viewspace-2214745/

service是要通过coreDNS来管理pod的。

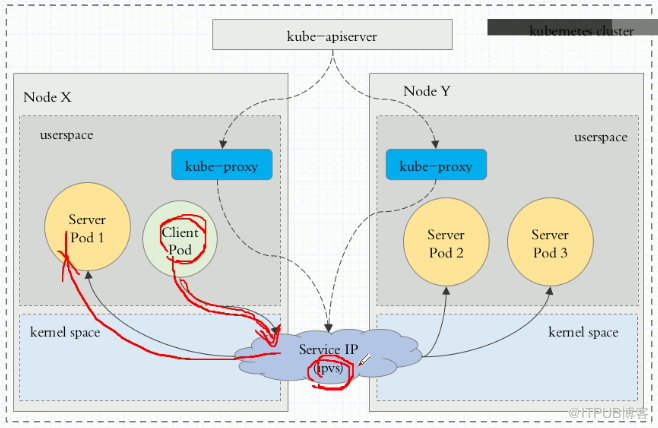

kube-proxy始终监视着apiserver,获取与service资源的变动状态。一旦发现有service资源发生变动,kube-proxy都要把它转变为当前节点之上的,能够实现service资源调度,包括将客户端资源调度到pod的规则(iptables或者ipvs)。

service工作模式有三种:userspace(k8s 1.1版本之前),iptables(k8s 1.10版本之前)和ipvs(k8s 1.11版本之后)

userspace模型:用户空间模型。k8s 1.11版本用ipvs了,这个比iptables效率高。

[root@master ~]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 16d

redis ClusterIP 10.106.138.181 <none> 6379/TCP 23h

[root@master ~]# kubectl delete svc redis

service "redis" deleted

注意kubernetes这个service千万别删,因为K8s都是通过10.96.0.1这个地址联系的。

[root@master ~]# kubectl explain svc

service类型:

a)、ExternalName:表示把集群外部的服务引入到集群内部中来,即实现了集群内部pod和集群外部的服务进行通信;

b)、ClusterIP:只能在集群内部通讯;

c)、NodePort:可以和集群外部通讯;

d)、LoadBalancer:这个表示我们把k8s部署在虚拟机上,自动在外部创建负载均衡器。比如在阿里云上,底层是LBAAS。

ClusterIP

以前我们使用kubectl expose创建service,下面我们使用清单来创建service。

[root@master manifests]# cat redis-svc.yaml

apiVersion: v1

kind: Service

metadata:

name: redis

namespace: default

spec:

selector:

app: redis

role: logstor

clusterIP: 10.97.97.97 #这个ip可以不指定,让它自动分配

type: ClusterIP

ports:

- port: 6379 #service ip中的端口

targetPort: 6379 #容器ip中的端口

[root@master manifests]# kubectl apply -f redis-svc.yaml

service/redis created

[root@master manifests]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 16d

redis ClusterIP 10.97.97.97 <none> 6379/TCP 1m

[root@master manifests]# kubectl describe svc redis

Name: redis

Namespace: default

Labels: <none>

Annotations: kubectl.kubernetes.io/last-applied-configuration={"apiVersion":"v1","kind":"Service","metadata":{"annotations":{},"name":"redis","namespace":"default"},"spec":{"clusterIP":"10.97.97.97","ports":[{"por...

Selector: app=redis,role=logstor

Type: ClusterIP

IP: 10.97.97.97

Port: <unset> 6379/TCP

TargetPort: 6379/TCP

Endpoints: 10.244.2.65:6379 ##这是pod的ip

Session Affinity: None

Events: <none>

资源记录:SVC_NAME.NAMESPACE_NAME.DOMAIN.LTD

集群默认后缀是svc.cluster.local

比如我们创建的redis默认名称就是redis.defalut.svc.cluster.local

NodePort

访问路径:client---->NodeIP:NodePoint----->ClusterIP:ServerPort---->PodIP:containerPort

[root@master manifests]# cat myapp-svc.yaml

apiVersion: v1

kind: Service

metadata:

name: myapp

namespace: default

spec:

selector:

app: myapp

release: canary

clusterIP: 10.99.99.99 #这个ip可以不指定,让他自动分配

type: NodePort

ports:

- port: 80 #service ip的端口

targetPort: 80 #容器ip的端口

nodePort: 30080 #node节点上端口,这个端口也可以不指定,会自动分配端口

[root@master manifests]# kubectl apply -f myapp-svc.yaml

service/myapp created

[root@master manifests]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 16d

myapp NodePort 10.99.99.99 <none> 80:30080/TCP 44s

redis ClusterIP 10.97.97.97 <none> 6379/TCP 15m

[root@master manifests]# curl http://172.16.1.101:30080/hostname.html

myapp-deploy-69b47bc96d-79fqh

[root@master manifests]# curl http://172.16.1.101:30080/hostname.html

myapp-deploy-69b47bc96d-tc54k

注意:172.16.1.101是Node节点的Ip,并且可以看到访问是做了负载均衡的

下面我们再把来自同一个客户端会话请求用sessionAffinity粘滞到一个固定的pod上,这样就不会出现负载均衡现象了,相当于nginx的 ip_hash功能,如下:

[root@master manifests]# kubectl patch svc myapp -p '{"spec":{"sessionAffinity":"ClientIP"}}'

service/myapp patched

上面打的补丁也可以直接用edit方法编辑。

[root@master manifests]# kubectl describe svc myapp

Session Affinity: ClientIP

再改回负载均衡模式:

[root@master manifests]# kubectl patch svc myapp -p '{"spec":{"sessionAffinity":"None"}}'

service/myapp patched

无头service

我们前面介绍的service是service name解析为cluster ip,然后cluster ip对应到后面的pod ip。

而无头service是指service name 直接解析为后面的pod ip。

无头就是没有cluster ip牵头了。

[root@master manifests]# cat myapp-svc-headless.yaml

apiVersion: v1

kind: Service

metadata:

name: myapp-svc

namespace: default

spec:

selector:

app: myapp #挑选的pod还是myapp。一个pod可以有多个service

release: canary

clusterIP: None #None表示是无头service

ports:

- port: 80 #service ip中的端口

targetPort: 80 #容器ip中的端口

[root@master manifests]# kubectl apply -f myapp-svc-headless.yaml

service/myapp-svc created

[root@master manifests]# kubectl get svc

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kubernetes ClusterIP 10.96.0.1 <none> 443/TCP 16d

myapp NodePort 10.99.99.99 <none> 80:30080/TCP 1h

myapp-svc ClusterIP None <none> 80/TCP 28s

redis ClusterIP 10.97.97.97 <none> 6379/TCP 1h

看到上面myapp-svc的cluster-ip是空,这就是无头service。

[root@master manifests]# kubectl get svc -n kube-system

NAME TYPE CLUSTER-IP EXTERNAL-IP PORT(S) AGE

kube-dns ClusterIP 10.96.0.10 <none> 53/UDP,53/TCP 16d

可以看到coreDNS的地址是10.96.0.10

[root@master manifests]# dig -t A myapp-svc.default.svc.cluster.local. @10.96.0.10

; <<>> DiG 9.9.4-RedHat-9.9.4-61.el7_5.1 <<>> -t A myapp-svc.default.svc.cluster.local. @10.96.0.10

;; global options: +cmd

;; Got answer:

;; ->>HEADER<<- opcode: QUERY, status: NOERROR, id: 10702

;; flags: qr aa rd ra; QUERY: 1, ANSWER: 2, AUTHORITY: 0, ADDITIONAL: 1

;; OPT PSEUDOSECTION:

; EDNS: version: 0, flags:; udp: 4096

;; QUESTION SECTION:

;myapp-svc.default.svc.cluster.local. INA

;; ANSWER SECTION:

myapp-svc.default.svc.cluster.local. 5 IN A10.244.1.63

myapp-svc.default.svc.cluster.local. 5 IN A10.244.2.51

;; Query time: 0 msec

;; SERVER: 10.96.0.10#53(10.96.0.10)

;; WHEN: Mon Sep 24 00:22:07 EDT 2018

;; MSG SIZE rcvd: 166

[root@master manifests]# kubectl get pods -o wide -l app=myapp

NAME READY STATUS RESTARTS AGE IP NODE

myapp-deploy-69b47bc96d-79fqh 1/1 Running 0 1d 10.244.1.63 node1

myapp-deploy-69b47bc96d-tc54k 1/1 Running 0 1d 10.244.2.51 node2

上面看到无头service name直接被解析到另个pod上的ip了。

ExternalName

我们可以用ExternalName对Service名称和集群外部服务地址做一个映射,使之访问Service名称就是访问外部服务。例如下面的例子是将 svc1 和 xxx.xxx.xxx.xxx 做了对等关系。

kind: Service

apiVersion: v1

metadata:

name: svc1

namespace: default

spec:

type: ExternalName

externalName: somedomain.org

不过,ExternalName 类型的服务适用于外部服务使用域名的方式,缺点是不能指定端口。

另外,要实现集群内访问集群外服务的这个需求,也是非常简单的。因为集群内的Pod会继承Node上的DNS解析规则。因此只要Node可以访问的服务,Pod中也可以访问到

=========================================阿里云上某个服务的svc文件例子和解释===========================

apiVersion: v1

kind: Service

metadata:

annotations:

service.beta.kubernetes.io/alicloud-loadbalancer-address-type: intranet

service.beta.kubernetes.io/alicloud-loadbalancer-force-override-listeners: 'false'

service.beta.kubernetes.io/alicloud-loadbalancer-id: xxxxxxx

labels:

app: xxxx

name: xxxx-inner

namespace: xxxx-dev

spec:

clusterIP: 10.129.16.253

externalTrafficPolicy: Local

healthCheckNodePort:

ports:

- name: azvs-https

nodePort:

port:

protocol: TCP

targetPort:

- name: xxxx

nodePort:

port:

protocol: TCP

targetPort:

selector:

app: xxxx

sessionAffinity: None

type: LoadBalancer

status:

loadBalancer:

ingress:

- ip: 10.250.7.77

externalTrafficPolicy: Local 表示此服务是否希望将外部流量路由到节点本地或集群范围的端点。

有两个可用选项:”Cluster”(默认)和 “Local”。

”Cluster” 隐藏了客户端源 IP,可能导致第二跳到另一个节点,但具有良好的整体负载分布。

“Local” 保留客户端源 IP 并避免 LoadBalancer 和 NodePort 类型服务的第二跳,但存在潜在的不均衡流量传播风险

大白话就是:“Local 会在某个节点上把流量引过来,SLB上只能看到该端口通的那个节点,而Cluster把流量分到后面的所有work节点,阿里的SLB上能看到所有的work节点”

service.beta.kubernetes.io/alicloud-loadbalancer-address-type: intranet 表示内部,把intranet 改成internet就是外部

service.beta.kubernetes.io/alicloud-loadbalancer-force-override-listeners: 'false' 是否强制覆盖的意思

service.beta.kubernetes.io/alicloud-loadbalancer-id: xxxxxxx 这个就是你的SLB的id

k8s系列---service的更多相关文章

- k8s系列---Service之ExternalName用法

需求:需要两个不同的namespace之间的不同pod可以通过name的形式访问 实现方式: A:在其他pod内ping [svcname].[namespace] ping出来到结果就是svc的ip ...

- Docker & k8s 系列二:本机k8s环境搭建

本篇将会讲解k8s是什么?本机k8s环境搭建,部署一个pod并演示几个kubectl命令,k8s dashboard安装. k8s是什么 k8s是kubernetes的简写,它是一个全新的基于容器技术 ...

- Docker & k8s 系列三:在k8s中部署单个服务实例

本章将会讲解: pod的概念,以及如何向k8s中部署一个单体应用实例. 在上面的篇幅中,我们了解了docker,并制作.运行了docker镜像,然后将镜像发布至中央仓库了.然后又搭建了本机的k8s环境 ...

- Docker & k8s 系列一:快速上手docker

Docker & k8s 系列一:快速上手docker 本篇文章将会讲解:docker是什么?docker的安装,创建一个docker镜像,运行我们创建的docker镜像,发布自己的docke ...

- Kubernetes K8S之Service服务详解与示例

K8S之Service概述与代理说明,并详解所有的service服务类型与示例 主机配置规划 服务器名称(hostname) 系统版本 配置 内网IP 外网IP(模拟) k8s-master Cent ...

- 容器编排系统k8s之Service资源

前文我们了解了k8s上的DemonSet.Job和CronJob控制器的相关话题,回顾请参考:https://www.cnblogs.com/qiuhom-1874/p/14157306.html:今 ...

- k8s 无头service 方式向内发布

k8s 无头service 是指 clusterIP 为 None 的service 案例,假定有一个 deployment,containerPort 端口80,同时还被打上 python=mywe ...

- K8S系列第八篇(Service、EndPoints以及高可用kubeadm部署)

更多精彩内容请关注微信公众号:新猿技术生态圈 更多精彩内容请关注微信公众号:新猿技术生态圈 更多精彩内容请关注微信公众号:新猿技术生态圈 Endpoints 命名空间级资源,如果endpoints和s ...

- k8s系列文章第五篇(docker-compose)

更多精彩内容,猛搓这里 目录 一.Docker Compose 1.前言 2.官方介绍 1.Compose 中有两个重要的概念 2.三步骤 3.Compose是Docker官方的开源项目,需要安装! ...

随机推荐

- arima.predict()参数选择以及相关的一些问题

在使用a ri ma进行模型建立时,需要注意以下几点 1.参数选择上predict必须起始时间在原始的数据及当中的,在下例中就是说2017必须在数据集里面,而2019不受限制,只哟在2017后面就好了 ...

- C# 调用word进程操作文档关闭进程

C# 调用word进程操作文档关闭进程 作者:Jesai 时间:2018-02-12 20:36:23 前言: office办公软件作为现在主流的一款办公软件,在我们的日常生活和日常工作里面几乎每天都 ...

- 2.Scanner的进阶使用

package com.duan.scanner; import java.util.Scanner; public class Demo04 { public static void main(St ...

- 前端开发利器 Web Replay

前端开发人员收到测试发来的 bug 后,通常比较头疼复现的问题. 即使测试人员录了视频,照着一步步操作也不一定能复现,例如bug是与当时的数据相关的. 为了解决这个问题,Firefox 推出了一个重磅 ...

- 4、python基础语法

前言:本文主要介绍python的一些基础语法,包括标识符的定义.行和缩进.引号和注释.输入输出.变量的定义. 一.标识符 1.凡是我们自己取的名字,都是标识符. 2.在Python里,标识符由字母.下 ...

- copy and swap技巧与移动赋值操作符

最近在实现一个Delegate类的时候碰到了一个问题,就是copy and swap技巧和移动赋值操作符有冲突. 比如有以下一个类: class Fun { public: Fun(const Fun ...

- python,for循环的使用案例集

1.循环执行某一系列操作.将该操作定义为一个def,然后使用for去循环执行该操作 思路,先把操作定义为一个函数,在for循环执行这个函数 比如下面案例,把微信好友列表内的好友,循环的方式依次调整到第 ...

- 使用dlib基于CNN(卷积神经网络)的人脸检测器来检测人脸

基于机器学习CNN方法来检测人脸比之前介绍的效率要慢很多 需要先下载一个训练好的模型数据: 地址点击下载 // dlib_cnn_facedetect.cpp: 定义控制台应用程序的入口点. // # ...

- ThinkPHP 5.0.7 + MySQL 构建RESTful API的小程序---02-ThinkPHP5中的orm的模型关联

ThinkPHP5.0中的操作ORM的一对一,一对多,多对多的操作: 由以下表举例: banner表的设计 id name description delete_time update_time 1 ...

- Django自定义认证系统

官网教程:https://docs.djangoproject.com/en/2.2/topics/auth/customizing/ app下的model.py from django.db imp ...