Layer Normalization和Batch Normalization

Layer Normalization

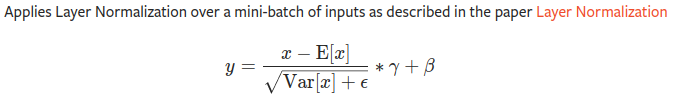

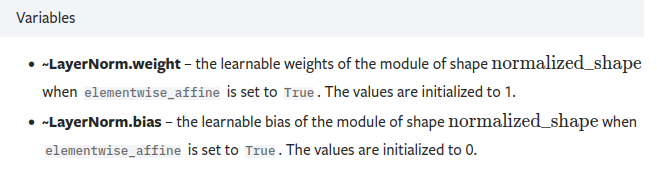

总览

- 针对同一通道数的图片的H*W进行层正则化,后面的γ和β是可以学习的参数,其中这两个的维度和最后一个的维度相同

- 例如特征图矩阵维度为[3, 577, 768], 那么γ和β的维度均为Tensor(768,)

step1:代码示例1

import torch

import torch.nn as nn

input = torch.tensor(

[

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

layer_norm = nn.LayerNorm([2, 2, 2, 2], elementwise_affine=True)

output = layer_norm(input)

print(output)

"""

tensor([[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeLayerNormBackward>)

"""

# 总结

"""

根据公式

E(x) = ((2+2+3+3)*4)/16 = 2.5

Var(x) = {(2-2.5)**2 * 8 + (3-2.5)**2 * 8} / 16 = 0.5**2

带入公式可以得到:

y = (x - E(x)) / (var(x)**0.5)

可以得到output

"""

step2更改输入观察输出

import torch

import torch.nn as nn

input = torch.tensor(

[

[

[

[3., 2.], # 这里将2 变成 3进行观察输出

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

layer_norm = nn.LayerNorm([2, 2, 2, 2], elementwise_affine=True)

output = layer_norm(input)

print(output)

"""

tensor([[[[ 0.8819, -1.1339],

[ 0.8819, 0.8819]],

[[ 0.8819, 0.8819],

[-1.1339, -1.1339]]],

[[[-1.1339, -1.1339],

[ 0.8819, 0.8819]],

[[ 0.8819, 0.8819],

[-1.1339, -1.1339]]]], grad_fn=<NativeLayerNormBackward>)

"""

# 总结

"""

由上述的公式可得,输入变化,整个输出都进行了改变

"""

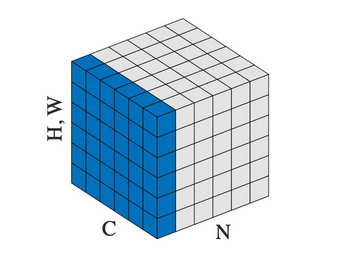

Batch Normalization

- 计算公式同上, 这里他的可学习参数与in_channel同

step1:代码示例1:

import torch

import torch.nn as nn

# With Learnable Parameters

m = nn.BatchNorm2d(2)

input = torch.tensor(

[

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

output = m(input)

print(output)

"""

tensor([[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.0000, -1.0000],

[ 1.0000, 1.0000]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeBatchNormBackward>)

"""

# 总结:

"""

计算的是某个批次的正则

根据公式 以第一个批次为例:

E(x) = {2+2+3+3+2+2+3+3}/8 = 2.5

Var(x) = {(2-2.5)**2 * 4 + (3-2.5)**2 * 4}/8 = 0.5**2

带入公式可以得到:

y = (x - E(x)) / (var(x)**0.5)

可以得到output

"""

进行微小更改观察变化

import torch

import torch.nn as nn

# With Learnable Parameters

m = nn.BatchNorm2d(2)

input = torch.tensor(

[

[

[

[3., 2.], # 这里2变成3来观察变化

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

],

[

[

[2., 2.],

[3., 3.]

],

[

[3., 3.],

[2., 2.]

]

]

]

)

print(input)

print(input.shape) # torch.Size([2, 2, 2, 2])

output = m(input)

print(output)

"""

tensor([[[[ 0.7746, -1.2910],

[ 0.7746, 0.7746]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]],

[[[-1.2910, -1.2910],

[ 0.7746, 0.7746]],

[[ 1.0000, 1.0000],

[-1.0000, -1.0000]]]], grad_fn=<NativeBatchNormBackward>)

"""

# 总结:

"""

进行微小更改观察到,发生变化的是他同一批次里面的

"""

参考

Layer Normalization和Batch Normalization的更多相关文章

- 深度学习之Batch Normalization

在机器学习领域中,有一个重要的假设:独立同分布假设,也就是假设训练数据和测试数据是满足相同分布的,否则在训练集上学习到的模型在测试集上的表现会比较差.而在深层神经网络的训练中,当中间神经层的前一层参数 ...

- tensorflow中使用Batch Normalization

在深度学习中为了提高训练速度,经常会使用一些正正则化方法,如L2.dropout,后来Sergey Ioffe 等人提出Batch Normalization方法,可以防止数据分布的变化,影响神经网络 ...

- 深度学习基础系列(七)| Batch Normalization

Batch Normalization(批量标准化,简称BN)是近些年来深度学习优化中一个重要的手段.BN能带来如下优点: 加速训练过程: 可以使用较大的学习率: 允许在深层网络中使用sigmoid这 ...

- Deep Learning 27:Batch normalization理解——读论文“Batch normalization: Accelerating deep network training by reducing internal covariate shift ”——ICML 2015

这篇经典论文,甚至可以说是2015年最牛的一篇论文,早就有很多人解读,不需要自己着摸,但是看了论文原文Batch normalization: Accelerating deep network tr ...

- 解开Batch Normalization的神秘面纱

停更博客好长一段时间了,其实并不是没写了,而是转而做笔记了,但是发现做笔记其实印象无法更深刻,因此决定继续以写博客来记录或者复习巩固所学的知识,与此同时跟大家分享下自己对深度学习或者机器学习相关的知识 ...

- 激活函数,Batch Normalization和Dropout

神经网络中还有一些激活函数,池化函数,正则化和归一化函数等.需要详细看看,啃一啃吧.. 1. 激活函数 1.1 激活函数作用 在生物的神经传导中,神经元接受多个神经的输入电位,当电位超过一定值时,该神 ...

- Batch Normalization、Layer Normalization、Instance Normalization、Group Normalization、Switchable Normalization比较

深度神经网络难训练一个重要的原因就是深度神经网络涉及很多层的叠加,每一层的参数变化都会导致下一层输入数据分布的变化,随着层数的增加,高层输入数据分布变化会非常剧烈,这就使得高层需要不断适应低层的参数更 ...

- Batch Normalization和Layer Normalization

Batch Normalization:对一个mini batch的样本,经过一个nueron(或filter)后生成的feature map中的所有point进行归一化.(纵向归一化) Layer ...

- 从Bayesian角度浅析Batch Normalization

前置阅读:http://blog.csdn.net/happynear/article/details/44238541——Batch Norm阅读笔记与实现 前置阅读:http://www.zhih ...

随机推荐

- 定制卡牌式 banner

HTML <template> <view > <swiper class='swiperClass' autoplay interval="2000" ...

- 【每日日报】第三十四天---Scanner类的应用

1 今天继续看书 Scanner类的应用 1 package File; 2 import java.util.Scanner; 3 4 public class ScannerDemo { 5 pu ...

- CCF201512-2消除类游戏

问题描述 消除类游戏是深受大众欢迎的一种游戏,游戏在一个包含有n行m列的游戏棋盘上进行,棋盘的每一行每一列的方格上放着一个有颜色的棋子,当一行或一列上有连续三个或更多的相同颜色的棋子时,这些棋子都被消 ...

- Mybatis实现简单增删改查

Mybatis的简单应用 学习内容: 需求 环境准备 代码 总结: 学习内容: 需求 使用Mybatis实现简单增删改查(以下是在IDEA中实现的,其他开发工具中,代码一样) jar 包下载:http ...

- 进入React的世界

一. React 是什么 1. 声明式写法 2. 组件化 3. 一次学习, 随处编写 二. 为什么要学习React 1. 大厂加持 - Facebook 2. 最流行, 使用人数最多, 最被开发者喜爱 ...

- 什么是机器学习的分类算法?【K-近邻算法(KNN)、交叉验证、朴素贝叶斯算法、决策树、随机森林】

1.K-近邻算法(KNN) 1.1 定义 (KNN,K-NearestNeighbor) 如果一个样本在特征空间中的k个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类 ...

- Linux---必备命令(2)

进程相关命令 # 查看系统所有的进程 ps -ef ps -ef | grep vim # 过滤出vim有关的进程 ps -ef | grep vim # 过滤出22端口的信息 ps -tunlp | ...

- Abp 实现通过手机号注册用户

前言 Abp 的 Identity 模块,实现了用户的管理,但是对于国内来讲,很多场景不能很好适配.比如:通过手机号进行注册的场景. Abp vnext Identity 以及 asp.net cor ...

- 2021.08.05 P7095 不离【扶咕咕出题】(贪心)

2021.08.05 P7095 不离[扶咕咕出题](贪心) [P7095 yLOI2020] 不离 - 洛谷 | 计算机科学教育新生态 (luogu.com.cn) 题意: 游戏中人物有两个属性,我 ...

- RecyclerView + SQLite 简易备忘录-----中(1)

在上一节讲完了登录界面的内容,现在随着Activity的跳转,来到MainActivity. 1.主界面activity_main.xml 由上图,activity_main.xml的内容很简单. 首 ...