GPUStack v0.5:模型Catalog、图生图功能上线,多维优化全面提升产品能力与使用体验

GPUStack 是一个专为运行 AI 模型设计的开源 GPU 集群管理器,致力于支持基于任何品牌的异构 GPU 构建统一管理的算力集群。无论这些 GPU 运行在 Apple Mac、Windows PC 还是 Linux 服务器上,GPUStack 都能将它们纳入统一的算力集群中。管理员可以轻松地从 Hugging Face 等流行的模型仓库中部署 AI 模型,开发人员则能够通过 OpenAI 兼容的 API 访问这些私有模型服务,就像使用 OpenAI 或 Microsoft Azure 提供的公共模型服务 API 一样便捷。

GPUStack 一直致力于以最简单易用的方式,帮助用户快速纳管异构 GPU 资源并运行所需的 AI 模型,从而支撑 RAG、AI Agents 以及其他生成式 AI 落地场景。为用户打造绝佳的使用体验是我们始终坚持的目标。在最新发布的 v0.5 版本以及接下来的版本中,我们将全方位强化和改善整体的用户体验。

GPUStack v0.5 版本的核心更新包括:

- 新增模型 Catalog:提供经过验证的模型集合,简化模型部署流程,大幅降低用户的认知负担,提升部署效率。

- 增强 Windows 和 macOS 模型支持:将 VLM 多模态模型支持和 Tool Calling 能力扩展到 Windows 和 macOS 平台,不再局限于 Linux 环境。

- 支持图生图功能:为 Image 模型新增图生图(图像编辑)功能,同时提供对应的 API 和 Playground UI,支持更丰富的应用场景。

- 模型管理优化:新增模型启动检查功能、支持模型的停止和启动操作,还有支持对无法自动识别的模型进行手动分类,便于分类和使用。

- 调度优化:优化自动调度优先级,将分布式推理的优先级调整至高于 CPU 推理。还增强了手动调度选卡功能,支持选择多卡,包括单机多卡(vLLM)和多机多卡(llama-box),资源分配更加自由。

- 扩展集成能力:增加了 AMD GPU 支持,为 Dify 的 GPUStack Provider 添加了 STT 和 TTS 语音模型支持。还提供了 RAGFlow 的 GPUStack Provider,修复了与 FastGPT 集成的问题。

这一版本包含 60 多项增强、修复、稳定性改进和用户体验优化,全面提升了 GPUStack 的易用性与功能,为用户提供更强大的应用场景支持。

有关 GPUStack 的详细信息,可以访问:

GitHub 仓库地址: https://github.com/gpustack/gpustack

GPUStack 用户文档: https://docs.gpustack.ai

重点特性介绍

新增模型 Catalog

GPUStack 支持直接从 Hugging Face 和 ModelScope 的公共模型仓库中搜索模型并进行部署。结合自定义推理引擎版本的功能,用户无需升级 GPUStack 就能随时部署体验新发布的前沿模型。

这种模式可能会给一些新上手的用户带来额外的负担。Hugging Face 和 ModelScope 上有多种多样的模型,用户往往难以确定该选择哪个模型进行部署。为改善用户的部署体验,GPUStack 在 v0.5 版本中新增了模型 Catalog。在 Catalog 中,我们提供了一组经过验证的模型,并对部署流程进行了简化,从而大幅降低用户在部署模型时的认知负担:

- 聚合同类模型为一个模型族,用户可以根据自身需求选择模型族进行部署,权重大小、量化精度等配置作为可选项,进一步简化模型部署流程。

- 无需用户手动选择下载源,GPUStack 会根据 Hugging Face 和 ModelScope 的下载速度自动选择最优下载源。

- 提供预置参数配置,对于运行模型所需的各种配置参数,GPUStack 会针对每个模型按需预设运行参数。例如,针对支持 Tool Calling 的模型,自动配置启用 Tool Calling 的相关参数。

在接下来的 v0.6 及后续版本中,GPUStack 将持续增强和优化 Catalog,提升模型部署的效率和成功率。通过减少用户的试错环节,帮助用户更加省时、省力、省心地完成所需模型的部署。

增强 Windows 和 macOS 模型支持

在此前的版本中,VLM 多模态模型和模型 Tool Calling 能力的支持依赖于 vLLM 后端,因此仅限于 Linux 环境。为了覆盖更多场景和环境,满足 Windows 和 macOS 用户的需求,我们对 llama-box 后端进行了增强。

无论用户使用的是 Linux、Windows 还是 macOS,现在都可以无缝体验跨平台的 VLM 多模态模型支持,在这些平台轻松部署如 Qwen2-VL、MiniCPM-V、MiniCPM-o 等多模态模型。同时,llama-box 还会自动为支持 Tool Calling 的模型启用该能力,让用户在多平台环境中享受一致的模型体验。

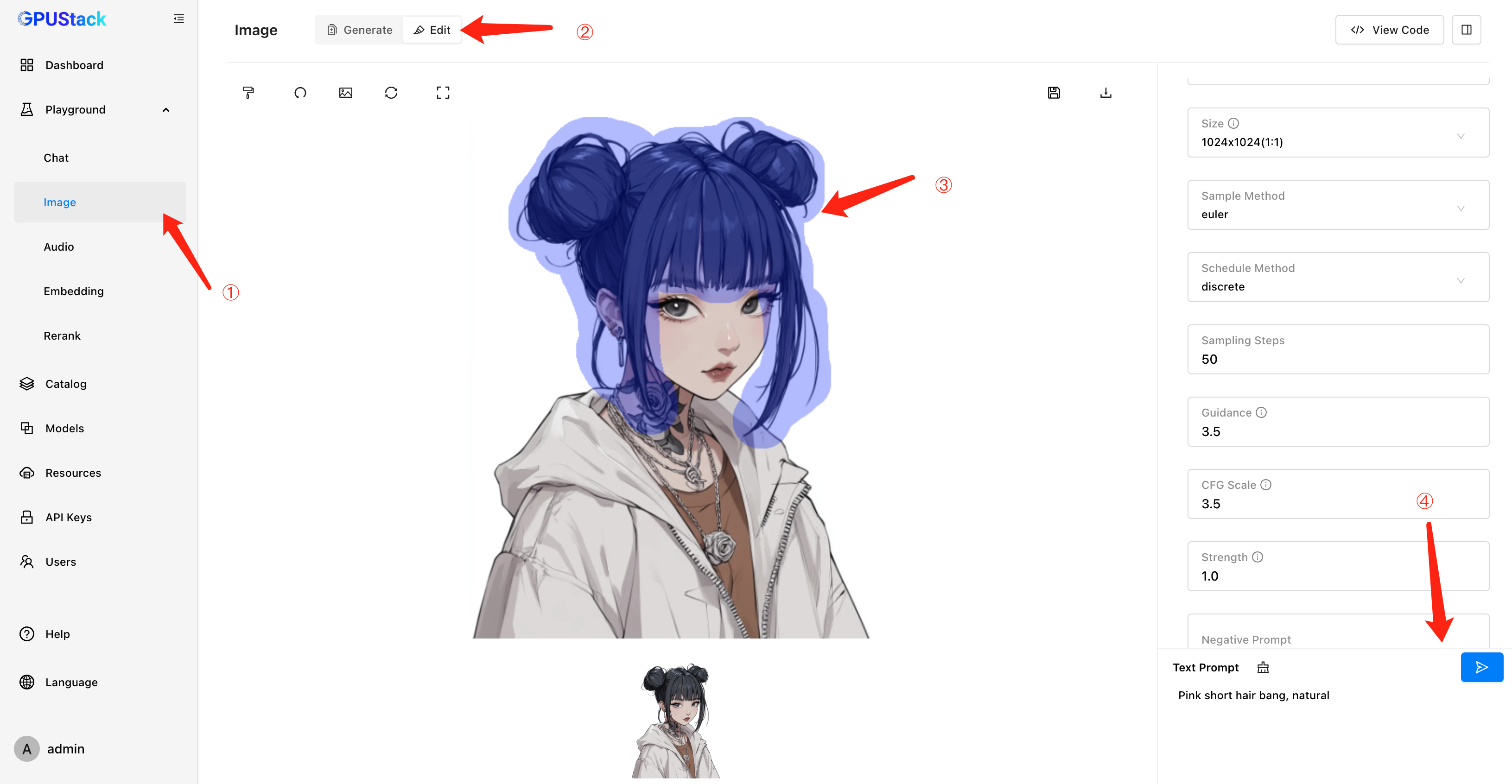

支持图生图

GPUStack 在 v0.4 版本中引入了文生图模型支持,为用户提供图像生成能力。在 v0.5 版本中,我们进一步升级了这一功能,新增了图生图(图像编辑)支持。用户不仅可以通过 Image Edit API 调用这一功能,还可以使用直观的 Playground UI 进行图像编辑的调试。这项增强拓展了图像模型的应用场景,满足了用户更多样化的需求,为创意生成和图像应用提供了相应的技术支持。

模型管理优化

在 GPUStack 中,模型的部署和管理是核心功能之一。为了进一步提升用户体验,v0.5 版本新增了模型启动检查功能。现在,GPUStack 会在模型完全启动并确认能够正常推理后,才会允许用户在 Playground 中使用该模型,避免了用户因模型未启动完成而出现的使用问题。

对于用户反馈通过将副本数调整为零来停止模型实例的操作不够清晰的问题,v0.5 版本也做出了优化。现在,GPUStack 直接支持更加直观的模型停止和启动操作,用户可以通过简单的按钮操作来管理模型实例,操作更加简单易懂。

此外,在 v0.5 中,我们还解决了部分模型无法自动识别分类的问题,完善了自动识别逻辑,而对于那些依然无法自动识别的模型,GPUStack 也支持用户手动为模型分类:

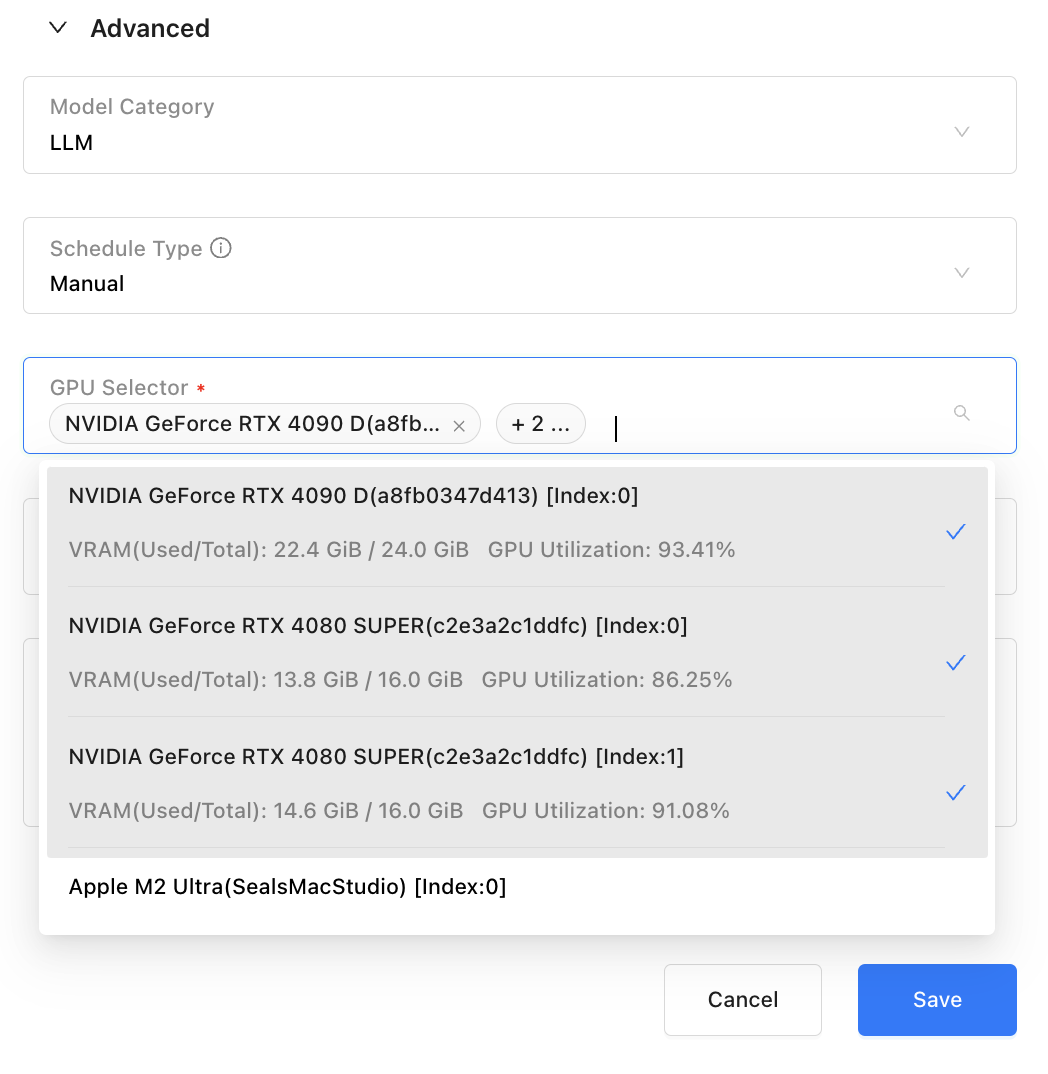

调度优化

针对用户在模型部署和调度中的实际场景需求,同时经过详细的测试验证了分布式推理的性能和稳定性,GPUStack v0.5 对自动调度的优先级进行了优化,将分布式推理的优先级调整至高于 CPU 推理。现在自动调度的优先级为:

单机单卡推理 > 单机多卡推理 > 多机多卡分布式推理 > CPU & GPU 混合推理 > 纯 CPU 推理

这项优化确保了优先使用高性能资源运行模型,更好地保证推理性能与效率。

为了更加灵活地控制 GPU 资源分配,GPUStack v0.5 对手动调度选卡功能进行了增强,支持了选择多卡,包括单机多卡(vLLM)和多机多卡(llama-box)。现在用户可以根据实际需求精细化分配 GPU 资源,为用户提供更高的调度自由度和场景适配能力,满足多样化的场景需求。

扩展集成能力

GPUStack 始终致力于实现与各种第三方应用和框架的无缝集成,为生成式 AI 应用落地提供强大的模型能力支持。与各类生成式 AI 应用框架例如 Dify、RAGFlow 和 FastGPT 等上层项目的集成一直是我们在重点推进的工作之一。

在 GPUStack 新增对语音模型(STT 和 TTS)的支持后,我们进一步增强了 Dify 的 GPUStack Provider 功能。用户现在可以通过 Dify 的 GPUStack Provider 无缝对接 GPUStack 部署的语音模型。GPUStack 与 Dify 的结合可以在生成式 AI 场景中提供多样化的应用能力。

我们也在 RAGFlow 的最新版本中添加了 GPUStack Provider,支持接入 GPUStack 部署的多种模型,包括 LLM、Embedding、Reranker,以及 STT 和 TTS 模型,为构建高效的 RAG 流程提供了更多可能性。

当前 RAGFlow 已发布的 v0.15.1 版本还未支持,可以安装 RAGFlow 的

nightly版本或等待新版本发布

同时,在 v0.5 版本中我们还修复了与 FastGPT 的集成问题,FastGPT 用户可以通过 OneAPI 集成 GPUStack 部署的模型服务。

对于其他大模型应用框架(如 LangChain、LlamaIndex 等),GPUStack 提供了标准的 OpenAI 兼容 API,便于这些框架的接入。如果用户在集成 GPUStack 时遇到任何问题,也欢迎随时与我们反馈。

扩展支持范围

GPUStack v0.5 版本新增了对 AMD GPU 的支持!请参考教程进行配置:https://docs.gpustack.ai/latest/tutorials/running-inference-with-amd-gpus/

GPUStack 提供了多种加速框架的离线容器镜像,包括 NVIDIA CUDA、AMD ROCm、昇腾 CANN、摩尔线程 MUSA,以及适用于 CPU 推理的容器镜像(x86 架构需支持 AVX2,ARM64 架构需支持 NEON)。这些镜像允许用户在不同类型的设备上按需运行对应的推理环境,从而灵活组建异构 GPU 资源池,满足多样化模型运行需求。

我们正在持续扩展 GPUStack 的支持范围,目前正在推进对海光 DCU 和寒武纪 MLU 等硬件的支持工作。

GPUStack 当前依赖 Pyhon >= 3.10,若主机的 Python 版本低于 3.10,建议使用 Conda 创建符合版本要求的 Python 环境。

其他特性和修复

GPUStack v0.5.0 版本还针对用户使用 GPUStack 的阻碍点和反馈的问题点进行了大量改进和修复,例如:

- 提供对 NVIDIA、AMD、昇腾、摩尔线程 GPU/NPU 的容器安装指引

- 自动根据下载速度选择下载源下载运行所需的 tools,不再需要用户手动指定

- 固定内置的 vLLM 与 vox-box 版本,在多节点安装、再次安装等场景提供版本一致性

- 修复 vLLM 后端自动调度计算分配的卡并行数量不正确问题

- 修复 vLLM 后端部署 GPTQ 和AWQ 量化模型时对显存资源的预估不准确问题

- 解决 llama-box 后端在 GPU 环境进行纯 CPU 推理仍然需要分配一小部分显存问题

等等。这些改进增强了 GPUStack 的易用性和稳定性,进一步改善了用户的使用体验。

其他增强和修复请查看完整变更日志:

https://github.com/gpustack/gpustack/releases/tag/v0.5.0

参与开源

想要了解更多关于 GPUStack 的信息,可以访问我们的仓库地址:https://github.com/gpustack/gpustack。如果你对 GPUStack 有任何建议,欢迎提交 GitHub issue。在体验 GPUStack 或提交 issue 之前,请在我们的 GitHub 仓库上点亮 Star ️关注我们,也非常欢迎大家一起参与到这个开源项目中!

如果觉得对你有帮助,欢迎点赞、转发、关注。

GPUStack v0.5:模型Catalog、图生图功能上线,多维优化全面提升产品能力与使用体验的更多相关文章

- 最新版本 Stable Diffusion 开源 AI 绘画工具之图生图进阶篇

目录 图生图基本参数 图生图(img2img) 涂鸦绘制(Sketch) 局部绘制(Inpaint) 涂鸦蒙版(Inpaint sketch) 上传蒙版(Inpaint upload) 图生图基本参数 ...

- 在3D Max中查看模型引用的贴图

需求 假如在Max中有一个模型,想查看贴图 操作步骤 1.右上角点击 2.在弹出材质编辑器中 点击吸管 3.把吸管点击在角色模型上,然后点击M 4.点击查看图像 5.就能查看到模型使用的贴图

- 讨论UML概念和模型UML九种图。

文件夹: UML的视图 UML的九种图 UML中类间的关系 上文我们介绍了,UML的视图.在每一种视图中都包括一个或多种图. 本文我们重点解说UML每种图的细节问题: 1.用例图(use case d ...

- 关于图计算&图学习的基础知识概览:前置知识点学习(Paddle Graph Learning (PGL))

关于图计算&图学习的基础知识概览:前置知识点学习(Paddle Graph Learning (PGL)) 欢迎fork本项目原始链接:关于图计算&图学习的基础知识概览:前置知识点学习 ...

- UML九种图-包图、类图

UML九种图-包图.类图 一.包 (一)相关概念: 1.包: 一个包=一层=一个命名空间=一个文件夹 2.包的命名: 简单名:王老二 路径名:中国.河北省.廊坊市.廊坊师范学院.信息技术提高班.九期班 ...

- 【UML 建模】UML建模语言入门 -- 静态图详解 类图 对象图 包图 静态图建模实战

发现个好东西思维导图, 最近开始用MindManager整理博客 . 作者 :万境绝尘 转载请注明出处 : http://blog.csdn.net/shulianghan/article/deta ...

- UML建模语言入门 -- 静态图详解 类图 对象图 包图 静态图建模实战

发现个好东西思维导图, 最近开始用MindManager整理博客 . 作者 :万境绝尘 转载请注明出处 : http://blog.csdn.net/shulianghan/article/deta ...

- JanusGraph : 图和图数据库的简介

JanusGraph:图数据库系统简介 图(graph)是<数据结构>课中第一次接触到的一个概念,它是一种用来描述现实世界中个体和个体之间网络关系的数据结构. 为了在计算机中存储图,< ...

- seaborn(2)---画分类图/分布图/回归图/矩阵图

二.分类图 1. 分类散点图 (1)散点图striplot(kind='strip') 方法1: seaborn.stripplot(x=None, y=None, hue=None, data=No ...

- .NET生成小程序码,并合自定义背景图生成推广小程序二维码

前言: 对于小程序大家可能都非常熟悉了,随着小程序的不断普及越来越多的公司都开始推广使用起来了.今天接到一个需求就是生成小程序码,并且于运营给的推广图片合并在一起做成一张漂亮美观的推广二维码,扫码这种 ...

随机推荐

- redis 执行性能检测指令报错:-bash: redis-benchmark: command not found

最近在看redis相关的内容,redis有自带检测性能的命令: -bash: redis-benchmark: command not found 碰到的所有资料中均提示不能在redis客户端中执行, ...

- 本地部署DeepSeek后,没有好看的交互界面怎么行!

大家好,我是晓凡. 写在前面 在前面的文章中手摸手的带小伙伴们在本地部署了DeepSeek.但是,部署完之后,我们要与之交互,只能在命令行中进行. 忘记怎么部署的小伙伴,来这儿复习一下~ 命令行交互如 ...

- 分享一个 Windows 下的透明锁屏工具【开源】

透明锁屏 担心展示内容时被误操作打断? 害怕离开后忘记锁屏导致隐私泄露? 厌倦了千篇一律的系统锁屏界面? 透明锁屏 了解一下. 功能特点 告别误操作:锁屏状态下,屏幕内容依然可见,视频播放.PPT 演 ...

- MybatisPlus - [05] 逻辑删除

题记部分 一.物理删除&逻辑删除 物理删除:delete from table_name where xxx = ?; 逻辑删除:update table_name set deleted = ...

- Linux - lvm逻辑卷的操作

执行 lsblk如下所示: [root@idc-poc-60 ~]# lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sr0 11:0 1 3.7G 0 r ...

- 一种基于虚拟摄像头、NDI、OBS以及yolo的多机视觉目标检测方案

一种基于虚拟摄像头.NDI.OBS以及yolo的多机视觉目标检测方案 绪论 近来为了实现某种实时展示效果,笔者希望通过一套方案实现在两台主机上分别运行仿真平台以及视觉深度学习算法.透过对当下较为流行的 ...

- Caddy web服务器

caddy 中文文档:https://caddy2.dengxiaolong.com/docs/ 常用命令 命令 描述 caddy run 启动Caddy服务器 caddy reload 重载Cadd ...

- containerd 配置使用私有镜像仓库 harbor

前言 当要从非安全的镜像仓库中进行 Pull.Push 时,会遇到 x509: certificate signed by unknown authority 错误提示: 这是由于镜像仓库是可能是 ...

- HoloLens 2 开发推荐书籍

博客地址:https://www.cnblogs.com/zylyehuo/ 书名 HoloLens 2开发入门精要--基于Unity和MRTK http://www.tup.tsinghua.edu ...

- 关于oracle pfile和spfile文件说明

•Pfile(Parameter File,参数文件):是基于文本格式的参数文件,含有数据库的配置参数. 默认的名称为"init+例程名.ora",这是一个文本文件,可以用任何文本 ...