异步日志监控:FastAPI与MongoDB的高效整合之道

title: 异步日志监控:FastAPI与MongoDB的高效整合之道

date: 2025/05/27 17:49:39

updated: 2025/05/27 17:49:39

author: cmdragon

excerpt:

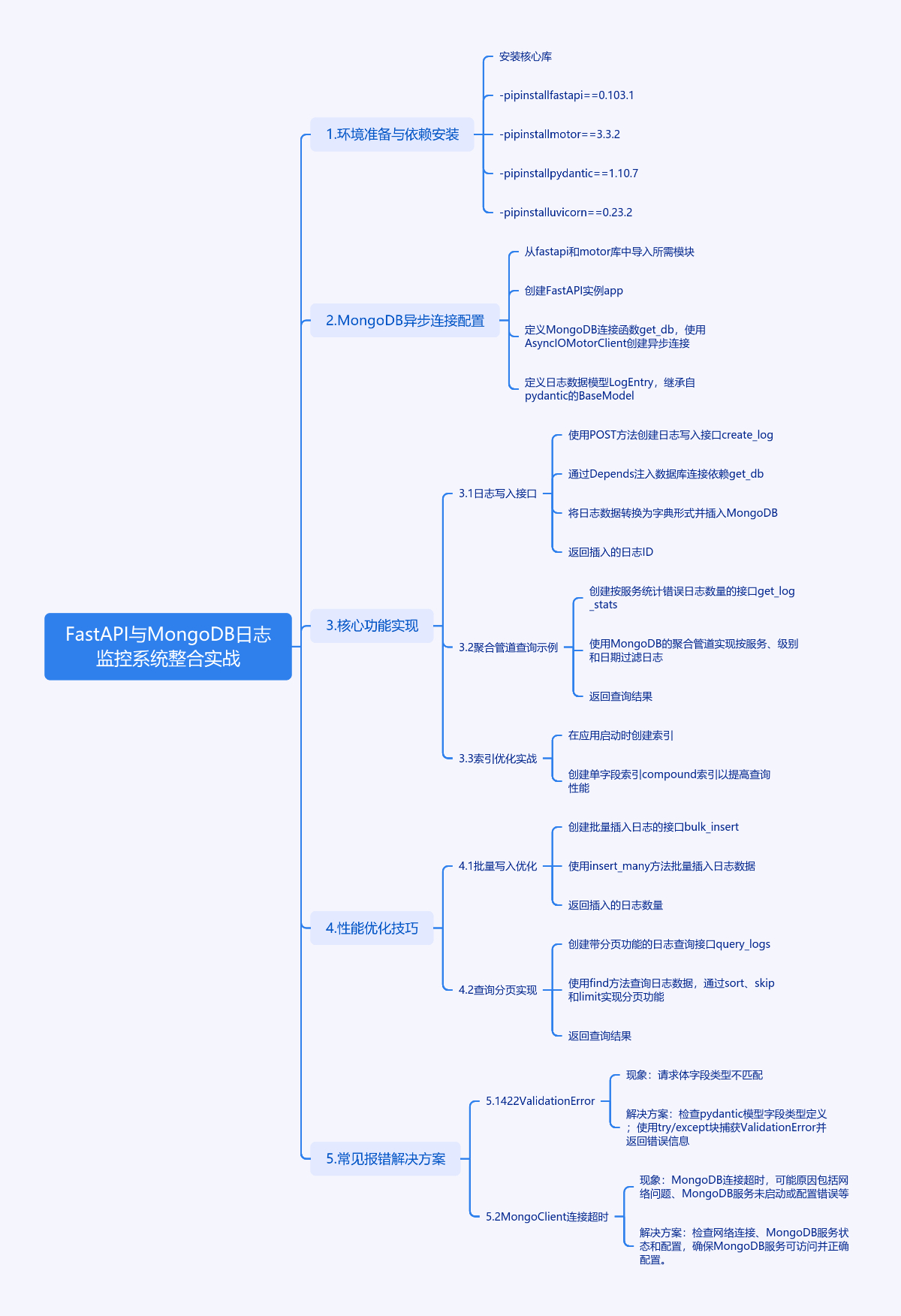

FastAPI与MongoDB整合实现日志监控系统的实战指南。首先配置MongoDB异步连接,定义日志数据模型。核心功能包括日志写入接口、聚合管道查询和索引优化。性能优化技巧涵盖批量写入和查询分页。常见报错解决方案涉及422 Validation Error和MongoClient连接超时。生产环境建议包括连接池配置、读写分离、慢查询监控和TTL索引。通过该方案,可构建日均千万级日志处理系统,建议配合Prometheus和Grafana进行监控和可视化。

categories:

- 后端开发

- FastAPI

tags:

- FastAPI

- MongoDB

- 日志监控系统

- 异步编程

- 性能优化

- 数据库索引

- 生产环境部署

扫描二维码

关注或者微信搜一搜:编程智域 前端至全栈交流与成长

探索数千个预构建的 AI 应用,开启你的下一个伟大创意:https://tools.cmdragon.cn/

FastAPI与MongoDB日志监控系统整合实战

1. 环境准备与依赖安装

# 安装核心库

pip install fastapi==0.103.1

pip install motor==3.3.2

pip install pydantic==1.10.7

pip install uvicorn==0.23.2

2. MongoDB异步连接配置

from fastapi import FastAPI, Depends

from motor.motor_asyncio import AsyncIOMotorClient

from pydantic import BaseModel

from datetime import datetime

app = FastAPI()

# MongoDB连接配置

async def get_db():

client = AsyncIOMotorClient(

"mongodb://admin:password@localhost:27017",

maxPoolSize=10,

minPoolSize=5

)

return client.log_db

# 日志数据模型

class LogEntry(BaseModel):

timestamp: datetime

level: str # DEBUG/INFO/WARNING/ERROR

service: str

message: str

metadata: dict = None

3. 核心功能实现

3.1 日志写入接口

@app.post("/logs")

async def create_log(log: LogEntry, db=Depends(get_db)):

"""异步写入日志到MongoDB"""

log_dict = log.dict()

result = await db.logs.insert_one(log_dict)

return {"inserted_id": str(result.inserted_id)}

3.2 聚合管道查询示例

@app.get("/logs/stats")

async def get_log_stats(service: str, db=Depends(get_db)):

"""按服务统计错误日志数量"""

pipeline = [

{"$match": {

"service": service,

"level": "ERROR",

"timestamp": {"$gte": datetime(2023, 1, 1)}

}},

{"$group": {

"_id": "$service",

"error_count": {"$sum": 1},

"latest_error": {"$last": "$timestamp"}

}}

]

cursor = db.logs.aggregate(pipeline)

results = await cursor.to_list(length=100)

return results

3.3 索引优化实战

# 启动时创建索引

@app.on_event("startup")

async def create_indexes():

db = await get_db()

await db.logs.create_index([("timestamp", 1)], name="timestamp_asc")

await db.logs.create_index(

[("service", 1), ("level", 1)],

name="service_level_compound"

)

4. 性能优化技巧

4.1 批量写入优化

@app.post("/logs/bulk")

async def bulk_insert(logs: list[LogEntry], db=Depends(get_db)):

"""批量插入日志提升写入性能"""

documents = [log.dict() for log in logs]

result = await db.logs.insert_many(documents)

return {"inserted_count": len(result.inserted_ids)}

4.2 查询分页实现

@app.get("/logs")

async def query_logs(

page: int = 1,

page_size: int = 50,

db=Depends(get_db)

):

"""带分页的日志查询接口"""

skip = (page - 1) * page_size

cursor = db.logs.find().sort("timestamp", -1).skip(skip).limit(page_size)

return await cursor.to_list(length=page_size)

5. 常见报错解决方案

5.1 422 Validation Error

现象:请求体字段类型不匹配

解决方案:

- 检查pydantic模型字段类型定义

- 使用try/except块捕获ValidationError

from fastapi.exceptions import RequestValidationError

@app.exception_handler(RequestValidationError)

async def validation_exception_handler(request, exc):

return JSONResponse(

status_code=400,

content={"detail": "请求数据格式错误"}

)

5.2 MongoClient连接超时

现象:ServerSelectionTimeoutError

排查步骤:

- 检查MongoDB服务状态

systemctl status mongod - 验证连接字符串格式是否正确

- 检查防火墙设置是否开放27017端口

6. 课后Quiz

问题1:当使用$match进行时间范围查询时,如何确保查询性能?

A) 使用内存缓存

B) 在timestamp字段创建索引

C) 增加数据库连接池

正确答案:B

解析:创建索引可以显著提升字段的查询效率,特别是对时间戳这种常用于范围查询的字段

问题2:在批量插入日志时,如何保证数据完整性?

A) 使用事务操作

B) 启用写入确认机制

C) 增加重试逻辑

正确答案:B

解析:MongoDB的写入确认(write concern)机制可以确保数据成功写入磁盘

7. 生产环境建议

- 连接池配置:根据业务负载调整maxPoolSize(建议10-100之间)

- 读写分离:为分析类查询配置secondary节点读取

- 慢查询监控:定期检查

db.currentOp()的输出 - TTL索引:自动清理过期日志

# 创建7天过期的TTL索引

await db.logs.create_index(

[("timestamp", 1)],

name="logs_ttl",

expireAfterSeconds=604800 # 7天

)

通过本文的完整实现方案,开发者可以快速构建日均千万级日志处理系统。实际部署时建议配合Prometheus进行性能监控,并使用Grafana实现可视化看板。

余下文章内容请点击跳转至 个人博客页面 或者 扫码关注或者微信搜一搜:编程智域 前端至全栈交流与成长,阅读完整的文章:异步日志监控:FastAPI与MongoDB的高效整合之道 | cmdragon's Blog

往期文章归档:

- FastAPI与MongoDB分片集群:异步数据路由与聚合优化 | cmdragon's Blog

- FastAPI与MongoDB Change Stream的实时数据交响曲 | cmdragon's Blog

- 地理空间索引:解锁日志分析中的位置智慧 | cmdragon's Blog

- 异步之舞:FastAPI与MongoDB的极致性能优化之旅 | cmdragon's Blog

- 异步日志分析:MongoDB与FastAPI的高效存储揭秘 | cmdragon's Blog

- MongoDB索引优化的艺术:从基础原理到性能调优实战 | cmdragon's Blog

- 解锁FastAPI与MongoDB聚合管道的性能奥秘 | cmdragon's Blog

- 异步之舞:Motor驱动与MongoDB的CRUD交响曲 | cmdragon's Blog

- 异步之舞:FastAPI与MongoDB的深度协奏 | cmdragon's Blog

- 数据库迁移的艺术:FastAPI生产环境中的灰度发布与回滚策略 | cmdragon's Blog

- 数据库迁移的艺术:团队协作中的冲突预防与解决之道 | cmdragon's Blog

- 驾驭FastAPI多数据库:从读写分离到跨库事务的艺术 | cmdragon's Blog

- 数据库事务隔离与Alembic数据恢复的实战艺术 | cmdragon's Blog

- FastAPI与Alembic:数据库迁移的隐秘艺术 | cmdragon's Blog

- 飞行中的引擎更换:生产环境数据库迁移的艺术与科学 | cmdragon's Blog

- Alembic迁移脚本冲突的智能检测与优雅合并之道 | cmdragon's Blog

- 多数据库迁移的艺术:Alembic在复杂环境中的精妙应用 | cmdragon's Blog

- 数据库事务回滚:FastAPI中的存档与读档大法 | cmdragon's Blog

- Alembic迁移脚本:让数据库变身时间旅行者 | cmdragon's Blog

- 数据库连接池:从银行柜台到代码世界的奇妙旅程 | cmdragon's Blog

- 点赞背后的技术大冒险:分布式事务与SAGA模式 | cmdragon's Blog

- N+1查询:数据库性能的隐形杀手与终极拯救指南 | cmdragon's Blog

- FastAPI与Tortoise-ORM开发的神奇之旅 | cmdragon's Blog

- DDD分层设计与异步职责划分:让你的代码不再“异步”混乱 | cmdragon's Blog

- 异步数据库事务锁:电商库存扣减的防超卖秘籍 | cmdragon's Blog

- FastAPI中的复杂查询与原子更新指南 | cmdragon's Blog

- 深入解析Tortoise-ORM关系型字段与异步查询 | cmdragon's Blog

- FastAPI与Tortoise-ORM模型配置及aerich迁移工具 | cmdragon's Blog

- 异步IO与Tortoise-ORM的数据库 | cmdragon's Blog

- FastAPI数据库连接池配置与监控 | cmdragon's Blog

- 分布式事务在点赞功能中的实现 | cmdragon's Blog

- Tortoise-ORM级联查询与预加载性能优化 | cmdragon's Blog

- 使用Tortoise-ORM和FastAPI构建评论系统 | cmdragon's Blog

- 分层架构在博客评论功能中的应用与实现 | cmdragon's Blog

- XML Sitemap

异步日志监控:FastAPI与MongoDB的高效整合之道的更多相关文章

- 一个轻巧高效的多线程c++stream风格异步日志(一)

一个轻巧高效的多线程c++stream风格异步日志 一个轻巧高效的多线程c++stream风格异步日志 前言 功能需求 性能需求 Logger实现 LogStream类 Logger类 LogStre ...

- 一个轻巧高效的多线程c++stream风格异步日志(二)

目录 一个轻巧高效的多线程c++stream风格异步日志(二) 前言 LogFile类 AsyncLogging类 AsyncLogging实现 增加备用缓存 结语 一个轻巧高效的多线程c++stre ...

- 如何监控 Log4j2 异步日志遇到写入瓶颈

如何监控 Log4j2 异步日志遇到写入瓶颈 在之前的一篇文章中(一次鞭辟入里的 Log4j2 异步日志输出阻塞问题的定位),我们详细分析了一个经典的 Log4j2 异步日志阻塞问题的定位,主要原因还 ...

- 前端异常日志监控 - 使用Sentry

背景 现在的前端项目越来越复杂,在不同的客户端会产生各种在开发人员机器上不会出现的问题.当用户报告一个问题给开发人员的时候,开发人员无法直接定位问题.在此前,听过一次鹅厂的前端人员,他们对QQ里面的网 ...

- spring boot:配置druid数据库连接池(开启sql防火墙/使用log4j2做异步日志/spring boot 2.3.2)

一,druid数据库连接池的功能? 1,Druid是阿里巴巴开发的号称为监控而生的数据库连接池 它的优点包括: 可以监控数据库访问性能 SQL执行日志 SQL防火墙 2,druid的官方站: http ...

- 一次鞭辟入里的 Log4j2 异步日志输出阻塞问题的定位

一次鞭辟入里的 Log4j2 日志输出阻塞问题的定位 问题现象 线上某个应用的某个实例突然出现某些次请求服务响应极慢的情况,有几次请求超过 60s 才返回,并且通过日志发现,服务线程并没有做什么很重的 ...

- 近期业务大量突增微服务性能优化总结-3.针对 x86 云环境改进异步日志等待策略

最近,业务增长的很迅猛,对于我们后台这块也是一个不小的挑战,这次遇到的核心业务接口的性能瓶颈,并不是单独的一个问题导致的,而是几个问题揉在一起:我们解决一个之后,发上线,之后发现还有另一个的性能瓶颈问 ...

- [Asp.net]SignalR实现实时日志监控

摘要 昨天吃饭的时候,突然想起来一个好玩的事,如果能有个页面可以实时的监控网站或者其他类型的程序的日志,其实也不错.当然,网上也有很多成熟的类似的监控系统.就想着如果通过.net该如何实现?所以就在想 ...

- MySQL慢日志监控脚本实例剖析

公司线上的 MySQL 慢日志,之前一直没有做好监控.趁着上周空闲,我就把监控脚本写了下,今天特地把代码发出来与51博友分享一下. 针对脚本的注解和整体构思,我会放到脚本之后为大家详解. 1 2 3 ...

- ElasticSearch实战-日志监控平台

1.概述 在项目业务倍增的情况下,查询效率受到影响,这里我们经过讨论,引进了分布式搜索套件——ElasticSearch,通过分布式搜索来解决当下业务上存在的问题.下面给大家列出今天分析的目录: El ...

随机推荐

- 大数据之路Week10_day01 (练习:通过设计rowkey来实现查询需求)

1.准备数据 链接:https://pan.baidu.com/s/1fRECXp0oWM1xgxc0uoniAA 提取码:4k43 2.需求如下 (1)查询出10条某个人的最近出现的位置信息 (2) ...

- 重生之数据结构与算法----数组&链表

简介 数据结构的本质,只有两种结构,数组与链表.其它的都是它的衍生与组合 算法的本质就是穷举. 数组 数组可以分为两大类,静态数组与动态数组. 静态数组的本质是一段连续的内存,因为是连续的,所以我们可 ...

- 别再用vector<bool>了!Google高级工程师:这可能是STL最大的设计失误

大家好,我是小康.今天我们来聊一个藏在C++标准库中的"定时炸弹",它看起来人畜无害,但却坑了无数C++程序员. 前言:当你以为自己用的是vector,结果却不是 嘿,各位码农兄弟 ...

- excel 文件提示已受损 解决方案

1.打开office excel 2.python 语言save 方法导致,将后缀改为.xls 3.用WPS打开

- java web 传输视频流代码锦集

方案一 //path为本地文件路劲 public void play(String path, HttpServletRequest request, HttpServletResponse resp ...

- NumPy学习3

继续学习NumPy,今天学习以下3个章节: 7,NumPy高级索引 8,NumPy广播机制 9,NumPy遍历数组 numpy_test3.py : import numpy as np ''' 7, ...

- 查看CentOS7的版本信息

1,查看CentOS的版本号: cat /etc/centos-release 显示结果: ...

- 关于Linux的core dump

core dump简介 core dump就是在进程crash时把包括内存在内的现场保留下来,以备故障分析. 但有时候,进程crash了却没有输出core,因为有一些因素会影响输出还是不输出cor ...

- 使用SPA单页面跟MPA多页面的优缺点?

SPA vs MPA 深度解析 1. 概述 什么是 SPA? SPA(Single Page Application,单页面应用)是一种仅加载一个 HTML 页面,并通过 JavaScript 动态更 ...

- MySQL查询当前连接数的语句

1. 查看当前总连接数 SHOW STATUS LIKE 'Threads_connected'; 返回当前建立的连接总数 2. 查看最大连接数配置 SHOW VARIABLES LIKE 'max_ ...