Kafka中数据的流向

1: 多个消费者消费同一个Topic数据相同的数据

(1)使用一个全新的"group.id"(就是之前没有被任何消费者使用过); (2)使用assign来订阅;

# 例如 groupId

@KafkaListener(topics = "test-syn",groupId = "test-2")

public void send(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】" + messge);

}

}

注意:如果把 "enable.auto.commit" 设为 "false",使用 consumer.commitAsync(currentOffsets, null) 手动提交 offset ,是不能从头开始消费的

auto.offset.reset值含义解释:

- earliest

- 当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,从头开始消费

- latest

- 当各分区下有已提交的offset时,从提交的offset开始消费;无提交的offset时,消费新产生的该分区下的数据

- none

- topic各分区都存在已提交的offset时,从offset后开始消费;只要有一个分区不存在已提交的offset,则抛出异常

也就是说无论哪种设置,只要 kafka 中相同 group、partition 中已经有提交的 offset,则都无法从开始消费。

参考论坛:服务器重启了,那么该group是否会重新消费服务器里面所有的消息

KafkaConsumer.subscribe() : 为consumer自动分配partition,

有内部算法保证topic-partition以最优的方式均匀分配给同group下的不同consumer。如果有多个partition且只有一个消费者,则按顺序消费所有分区。不会重复消费。

KafkaConsumer.assign() : 为consumer手动、显示的指定需要消费的topic-partitions,

不受group.id限制,不提交offset,相当与指定的group无效(this method does not use the consumer's group management)。可以重复消费。

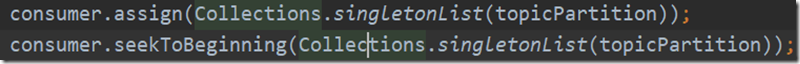

或者,这样做:

目前就 high level API 而言,offset 是存于 Zookeeper 中的,无法存于 HDFS,而 low level API 的 offset 是由自己去维护的,可以将之存于 HDFS 中。

2: 多个消费者消费同一个Topic数据不同数据

# groupId 将多个消费者分配到同一个组下面

@KafkaListener(topics = "test-syn",groupId = "test-1")

public void send(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】" + messge);

}

}

@KafkaListener(topics = "test-syn",groupId = "test-1")

public void send(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】" + messge);

}

}

3: 各个消费者按组协调消费

@KafkaListener(topics = "test-syn",groupId = "test-1")

public void send(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】1" + messge);

}

} @KafkaListener(topics = "test-syn",groupId = "test-2")

public void send2(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】2" + messge);

}

}

@KafkaListener(topics = "test-syn",groupId = "test-3")

public void send(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】1" + messge);

}

} @KafkaListener(topics = "test-syn",groupId = "test-2")

public void send2(ConsumerRecord<?, ?> record) {

Optional<?> kafkaMessage = Optional.ofNullable(record.value());

if (kafkaMessage.isPresent()) {

Object messge = kafkaMessage.get();

log.info("【KafkaListener监听到消息】2" + messge);

}

}

# 上面

1 2 3 收到相同的消费message

2 2 收到不同的message

Kafka中数据的流向的更多相关文章

- flink---实时项目--day02-----1. 解析参数工具类 2. Flink工具类封装 3. 日志采集架构图 4. 测流输出 5. 将kafka中数据写入HDFS 6 KafkaProducer的使用 7 练习

1. 解析参数工具类(ParameterTool) 该类提供了从不同数据源读取和解析程序参数的简单实用方法,其解析args时,只能支持单只参数. 用来解析main方法传入参数的工具类 public c ...

- SparkStreaming消费kafka中数据的方式

有两种:Direct直连方式.Receiver方式 1.Receiver方式: 使用kafka高层次的consumer API来实现,receiver从kafka中获取的数据都保存在spark exc ...

- flume实时采集mysql数据到kafka中并输出

环境说明 centos7(运行于vbox虚拟机) flume1.9.0(flume-ng-sql-source插件版本1.5.3) jdk1.8 kafka(版本忘了后续更新) zookeeper(版 ...

- Kafka消费者 从Kafka中读取数据并写入文件

Kafka消费者 从Kafka中读取数据 最近有需求要从kafak上消费读取实时数据,并将数据中的key输出到文件中,用于发布端的原始点进行比对,以此来确定是否传输过程中有遗漏数据. 不废话,直接上代 ...

- Flink 使用(一)——从kafka中读取数据写入到HBASE中

1.前言 本文是在<如何计算实时热门商品>[1]一文上做的扩展,仅在功能上验证了利用Flink消费Kafka数据,把处理后的数据写入到HBase的流程,其具体性能未做调优.此外,文中并未就 ...

- canal从mysql拉取数据,并以protobuf的格式往kafka中写数据

大致思路: canal去mysql拉取数据,放在canal所在的节点上,并且自身对外提供一个tcp服务,我们只要写一个连接该服务的客户端,去拉取数据并且指定往kafka写数据的格式就能达到以proto ...

- flink---实时项目--day01--1. openrestry的安装 2. 使用nginx+lua将日志数据写入指定文件中 3. 使用flume将本地磁盘中的日志数据采集到的kafka中去

1. openrestry的安装 OpenResty = Nginx + Lua,是⼀一个增强的Nginx,可以编写lua脚本实现⾮非常灵活的逻辑 (1)安装开发库依赖 yum install -y ...

- flink04 -----1 kafkaSource 2. kafkaSource的偏移量的存储位置 3 将kafka中的数据写入redis中去 4 将kafka中的数据写入mysql中去

1. kafkaSource 见官方文档 2. kafkaSource的偏移量的存储位置 默认存在kafka的特殊topic中,但也可以设置参数让其不存在kafka的特殊topic中 3 将k ...

- 大数据学习day32-----spark12-----1. sparkstreaming(1.1简介,1.2 sparkstreaming入门程序(统计单词个数,updateStageByKey的用法,1.3 SparkStreaming整合Kafka,1.4 SparkStreaming获取KafkaRDD的偏移量,并将偏移量写入kafka中)

1. Spark Streaming 1.1 简介(来源:spark官网介绍) Spark Streaming是Spark Core API的扩展,其是支持可伸缩.高吞吐量.容错的实时数据流处理.Sp ...

随机推荐

- C#实现文件Move操作和文件的Copy操作

文件移动(Move)操作和文件的复制(Copy)是C#程式开发经常遇到的方法,根据传入的源文件地址和目标文件地址参数,实现对文件的操作.实现代码如下: Move操作代码: public static ...

- Prometheus+Alertmanager+Grafana监控组件容器部署

直接上部署配置文件 docker-compose.yml version: '3' networks: monitor: driver: bridge services: prometheus: im ...

- 【JavaScript 基础知识】一篇关于 JavaScript 一些知识点的总结

JavaScript 中基础数据类型 数据类型名称 数据类型说明 Undefined 只有一个值,即 undefined ,声明变量的初始值. Null 只有一个值,即 null ,表示空指针, ...

- 全网最详细!Centos7.X 搭建Grafana+Jmeter+Influxdb 性能实时监控平台

背景 日常工作中,经常会用到Jmeter去压测,毕竟LR还要钱(@¥&*...),而最常用的接口压力测试,我们都是通过聚合报告去查看压测结果的,然鹅聚合报告的真的是丑到家了,作为程序猿这当然不 ...

- javascript 内置对象和方法

一.自定义对象 方法1 /* 自定义对象 */ var sex= "gender" var person={"name": "tom", & ...

- Jenkins配置邮件发送测试报告

前言 在之前的文章(Jenkins自动执行python脚本输出测试报告)中,我们已成功实现利用Jenkins自动执行python脚本,输出并可直接在界面上查看测试报告,这里我们还差最后一步,我们需要将 ...

- python类型-集合

集合对象是一组无序排列的可哈希的值,集合成员可以做字典的键.集合有两种类型:可变集合,可以添加和删除元素,可变集合不是可哈希的,不能用作字典的键也不能作为其它集合中的元素:不可变集合相反,有哈希值,可 ...

- 双指针,BFS与图论(一)

(一)双指针 1.日志统计 小明维护着一个程序员论坛.现在他收集了一份”点赞”日志,日志共有 N 行. 其中每一行的格式是: ts id 表示在 ts 时刻编号 id 的帖子收到一个”赞”. 现在小明 ...

- NOI2.4 2011

描述 已知长度最大为200位的正整数n,请求出2011^n的后四位. 输入 第一行为一个正整数k,代表有k组数据,k<=200接下来的k行, 每行都有一个正整数n,n的位数<=200 输出 ...

- requests快速构造请求头的方法

上图请求头内容,内容多不说,也不确认哪些数据是必须的,网上找到一个懒办法 快速一键生成 Python 爬虫请求头 实战演练 抓取网站:https://developer.mozilla.org... ...