MongoDB Input

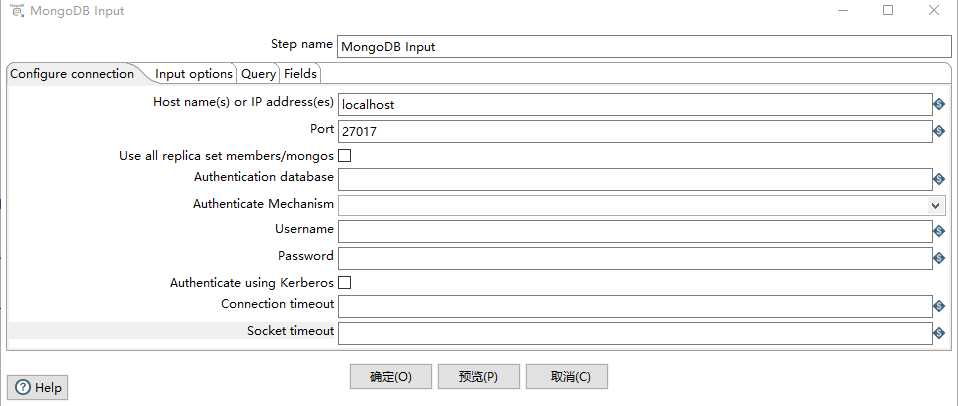

Configure Connection Tab

Host name(s) or IP address(es):网络名称或者地址。可以输入多个主机名或IP地址,用逗号分隔。还可以通过将主机名和端口号与冒号分隔开,为每个主机名指定不同的端口号,并将主机名和端口号的组合与逗号分隔开。例如,要为两个不同的MongoDB实例包含主机名和端口号,您将输入localhost 1:27017,localhost 2:27018,并使端口字段为空

Use all replica set members/mongos:

Port:端口号

Username:用户名

Password:密码

Authenticate using Kerberos:指示是否使用Kerberos服务来管理身份验证过程。

Connection timeout:连接超时时间(毫秒)

Socket timeout:等待写操作(以毫秒为单位)的时间

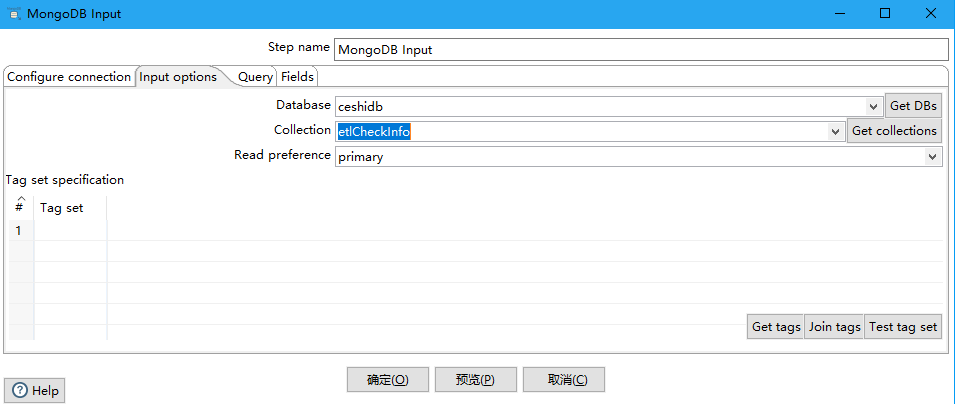

Input Options Tab

Database:检索数据的数据库的名称。单击Get DBs以在服务器上的数据库列表填充下拉菜单。

Collection:集合名称。点击 Get collections以在数据库中包含一个集合列表来填充下拉菜单

Read preference:表示要先读取哪个节点

Tag set specification/#/Tag Set:标签允许您自定义写关注和读取副本的首选项

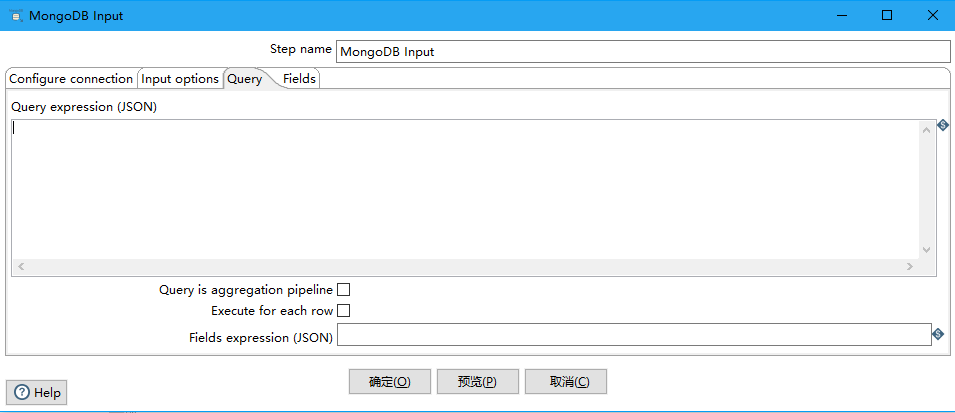

Query Tab

查询选项卡使您能够改进读请求。这个选项卡以两种不同的模式运行。您可以使用JSON查询表达式或使用聚合框架来创建查询。默认情况下,查询选项卡是JSON查询表达式模式。您可以输入一个JSON查询表达式。当选Query is aggregation pipeline 的时候,使用聚合表达式查询,是一种类似与json的查询语言。

Query expression (JSON):查询表达式(JSON)(Query is aggregation pipeline没被选择的情况下)

{ name : "MongoDB" } 或者{ name : { '$regex' : "m.*", '$options' : "i" } }

Query is aggregation pipeline:将多个JSON表达式连接在一起,立即执行。聚合管道将几个JSON表达式串在一起,前面的表达式的输出将成为下一个表达式的输入。

Aggregation pipeline specification (JSON):聚合管道规范(JSON)(Query is aggregation pipeline被选择)

{ $match : {state : "FL", city : "ORLANDO" } }, {$sort : {pop : -1 } }或者{ $group : { _id: "$state"} }, { $sort : { _id : 1 } }

Execute for each row:对每一行数据执行查询

Fields expression (JSON):Query is aggregation pipeline没被选中时候有效,控制字段返回

MongoDB Input的更多相关文章

- kettle之mongodb数据同步

需求: 1.源数据库新增一条记录,目标库同时新增一条记录: 2.源数据库修改一条记录,目标库同时修改该条记录: 示例用到三个Kettle组件 下面详细说下每个组件的配置 Source: 本示例连接的是 ...

- Scala spark mongodb

最好的参考是Mongo官网的地址 https://docs.mongodb.com/spark-connector/getting-started/ 需要截图所示的包 代码地址 https://git ...

- Spark连接MongoDB之Scala

MongoDB Connector for Spark Spark Connector Scala Guide spark-shell --jars "mongo-spark-connect ...

- MongoDB With Spark遇到的2个错误,不能初始化和sample重复的key

1.$sample stage could not find a non-duplicate document while using a random cursor 这个问题比较难解决,因为我用mo ...

- Scala2.11.8 spark2.3.1 mongodb connector 2.3.0

import java.sql.DriverManager import com.mongodb.spark._ import org.apache.spark.SparkConf import or ...

- spark读取mongodb数据写入hive表中

一 环境: spark-: hive-; scala-; hadoop--cdh-; jdk-1.8; mongodb-2.4.10; 二.数据情况: MongoDB数据格式{ "_i ...

- MongoDB + Spark: 完整的大数据解决方案

Spark介绍 按照官方的定义,Spark 是一个通用,快速,适用于大规模数据的处理引擎. 通用性:我们可以使用Spark SQL来执行常规分析, Spark Streaming 来流数据处理, 以及 ...

- pyspark mongodb yarn

from pyspark.sql import SparkSession my_spark = SparkSession \ .builder \ .appName("myApp" ...

- Mongodb——文档数据库

mongodb是一个文档数据库. mongo操作 多个修改操作,但每个修改携带的数据包较小,可操作考虑批量操作.bulkWrite()改善性能. MongoCollection是线程安全的. db.c ...

随机推荐

- 5.caffe图片分类流程

一次创建下列文件: 1,create_txt.sh (create_filelist.sh) 2,create_lmdb.sh 3,make_mean.sh 4,train.prototxt+val. ...

- Tarjan-CV/BCC/SCC算法学习笔记

DFS性质的应用--利用Tarjan算法求割顶.BCC.SCC 整理自<算法竞赛入门经典--训练指南>以及网络 DFS (depth first search)深度优先搜索算法 dfs森林 ...

- fonts/font-awesome-woff2 404问题

报错环境: vue 开发的项目 npm 引入的font-awesome, 页面正常显示,就是控制台会报这个错误 产生原因:因为服务器IIS不认SVG,WOFF/WOFF2 这几个文件类型,只要在IIS ...

- linux基础_用户组的管理

1.创建组 语法:groupadd 组名 2.删除组 语法:groupdel 组名 3.创建用户时,直接指定组 语法:useradd -g 用户组 用户名 4.修改用户的组 语法:usermod -g ...

- 解决安卓app在真机上的无法登录问题

和小伙伴用安卓做的app在模拟器上可以正常使用,但是变成apk发到手机上下载使用时,出现无法的登录问题,而且登录提示的错误出现一秒就消失了,无法看清. 于是找了一下老师帮忙,老师是通过在电脑主机上插入 ...

- shell编程expr表达式----传智播客的书linux编程基础中出现的问题

首先声明:本人是传智播客的粉丝,拥有他出的多本编程书籍,此文绝无诋毁抹黑之意. 但在linux系统编程第88页给出的while循环范例中,代码运行无法得到预期结果 原代码如下 #!/bin/sh su ...

- smarty模板使用

安装配置 下载smarty模板核心类库,把libs文件夹复制到项目文件夹下,修改为smarty在php文件中调用 require '../smarty/Smarty.class.php';$tpl = ...

- bzoj3993: [SDOI2015]星际战争(二分+最大流)

题目描述 3333年,在银河系的某星球上,X军团和Y军团正在激烈地作战. 在战斗的某一阶段,Y军团一共派遣了N个巨型机器人进攻X军团的阵地,其中第i个巨型机器人的装甲值为Ai.当一个巨型机器人的装甲值 ...

- Codeforces Round #589 (Div. 2) C - Primes and Multiplication(数学, 质数)

链接: https://codeforces.com/contest/1228/problem/C 题意: Let's introduce some definitions that will be ...

- 【csp模拟赛2】 爆搜 方格加数

[题目描述] xyz1048576正在玩一个关于矩阵的游戏. 一个n*m的矩阵,矩阵中每个数都是[1,12]内的整数.你可以执行下列两个操作任意多次: (1)指定一行,将该行所有数字+1. (2)指定 ...