系数矩阵为Hessian矩阵时使用“Pearlmutter trick”或“有限差分法”近似的共轭梯度解法 —— Hession-free的共轭梯度法

共轭梯度法已经在前文中给出介绍:

共轭梯度法用来求解方程A*x=b,且A为正定矩阵。

在机器学习领域很多优化模型的求解最终可以写为A*x=b的形式,且A为正定矩阵或A为近似矩阵。在凸优化问题中A为正定矩阵是比较好满足的,在神经网络这类非线性问题中一般常用近似的技术方法来获得近似正定矩阵的A,相关见:https://www.zhihu.com/question/268719846/answer/351360155

而很多时候A*x=b中的A为Hession矩阵,即函数 f 对向量 w 的二次求导,如果w的size比较大,比如为1000000,那么这个Hession矩阵A的维度为1000000*1000000,然而这个大小的A矩阵是难以存储在内存中的。但是通过对共轭梯度法具体步骤的了解可以知道,在共轭梯度法的具体求解过程中我们其实并不是直接需要这个矩阵A进行参与计算的,我们需要直接参与计算的是A*p,由于A为Hession矩阵,因此我们有两种近似的方法来计算A*p,一种叫做“Pearlmutter trick”,一种叫做“有限差分法”。

利用“Pearlmutter trick”或“有限差分法” 近似的共轭梯度法又被称作Hession-free的共轭梯度法。

=======================================

使用共轭梯度法时,如果系数矩阵为Hessian矩阵,那么我们可以使用Pearlmutter trick技术或“有限差分法”来减少计算过程中的内存消耗,加速计算。

使用Pearlmutter trick和“有限差分法”的共轭梯度解法可以参考论文:

Fast Exact Multiplication by the Hessian

论文地址:

https://www.bcl.hamilton.ie/~barak/papers/nc-hessian.pdf

由于原论文中内容较多,所以我们介绍Pearlmutter trick技术和“有限差分法”的共轭梯度解法建议看的资料为其他网文blog:

https://justindomke.wordpress.com/2009/01/17/hessian-vector-products/

=======================================

1. 利用Pearlmutter trick的共轭梯度法

H(x)*p = ∂(g(x)*p)/∂x

=======================================

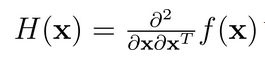

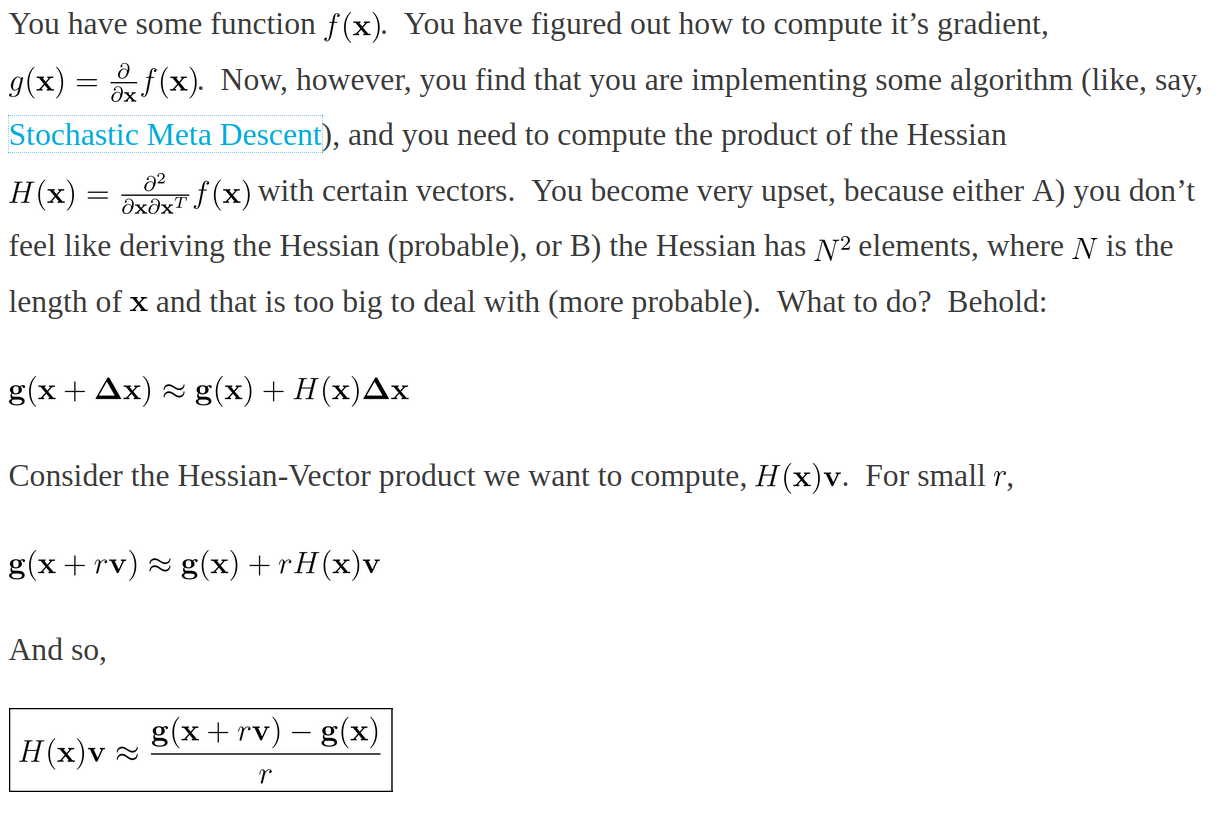

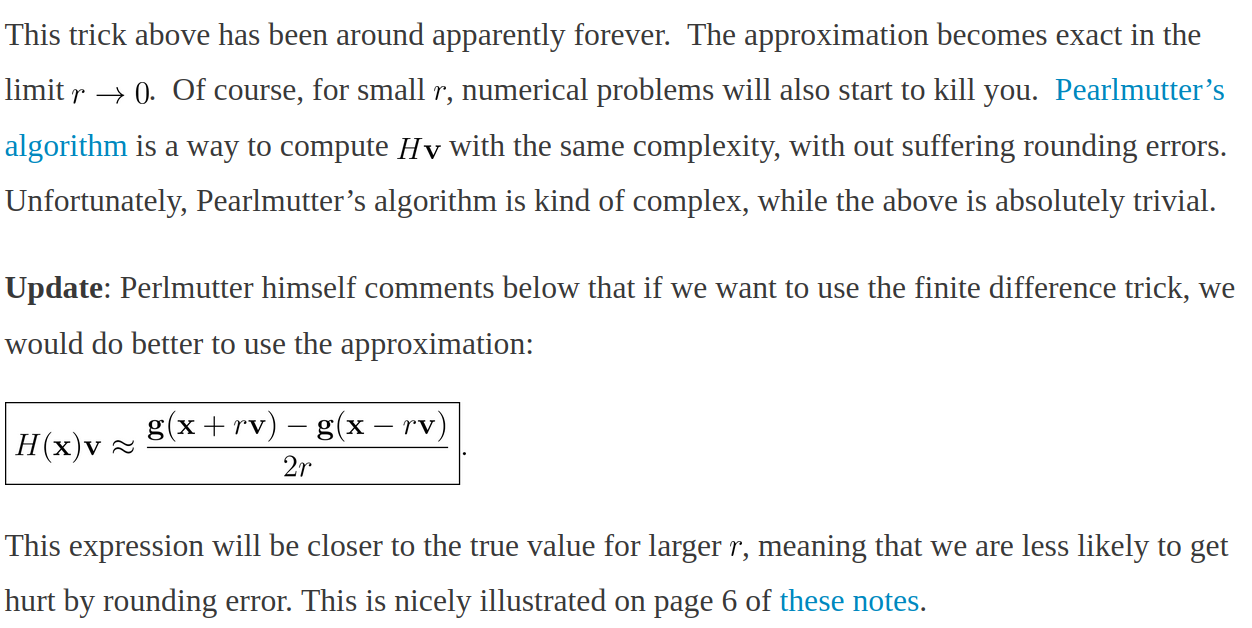

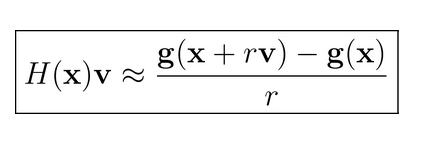

2. 利用有限差分法的共轭梯度法

依照上面内容解释一下:

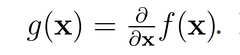

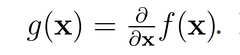

Hession 矩阵 H(x) 为 f(x) 的二阶导数矩阵,因此有:

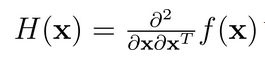

我们可以将 g(x) 按照泰勒公式展开为一阶导形式:

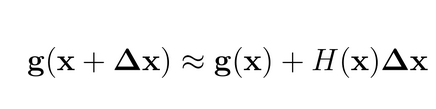

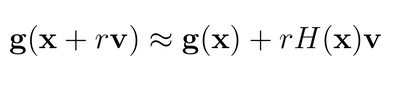

v 为一个向量vector,根据上面的公式我们可以得到:

其中 γ 为标量系数,该系数极小,因此γv可以看做为Δx

因此我们可以得到下面形式的公式:

=======================================

3. Pearlmutter trick技术和“有限差分法”的共轭梯度解法的 H(x)*p部分代码:

因为 H(x) 必然为正定对称矩阵,因此我们对 H(x) * y = b 形式的求解式可以使用共轭梯度法,而共轭梯度法在计算过程中需要重复的计算 H(x)*p, 其中 p 为计算过程中的迭代向量,p是在迭代过程中不断变化的,而H(x) 是系数矩阵在迭代过程中是不变的。

Pearlmutter trick 这个技术给出的是近似解,这里知道这个技术即可,实际感觉好像用处也不多,有可能是自己理解的不深。关于H(x)*b与共轭梯度的结合代码这里就省略掉了。

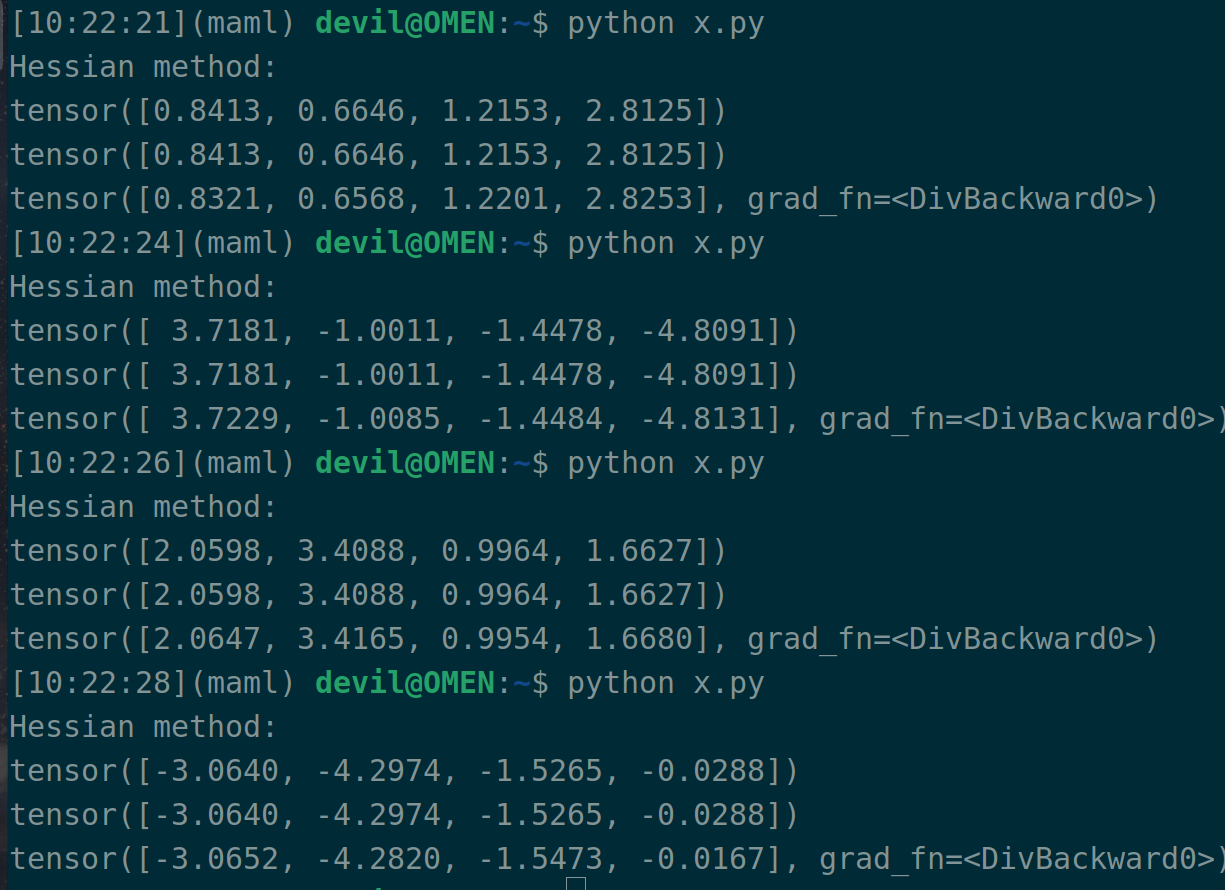

import torch # 计算目标为: H*b, H为函数s关于变量w的hessian矩阵

# 变量w

w = torch.randn(4, requires_grad=True) # 关于变量w的函数s

data = torch.randn(1000*4).reshape((-1, 4))

label = torch.randn(1000)

s = torch.mean( torch.square(label - torch.matmul(data, w)) ) # 计算目标中的b

b = torch.randn(4) # s对w的一阶导

first_grad = torch.autograd.grad(s, w, create_graph=True)[0] # 使用标准公式计算 H*b

second_grad = []

for grad in first_grad:

second_grad.append(torch.autograd.grad(grad, w, retain_graph=True)[0][None, :])

H = torch.concatenate(second_grad, axis=0)

print("Hessian method:")

print(torch.matmul(H, b)) # 在目标函数s进行一阶导后点乘向量b, 然后再对w进行一次求导, 也就是 dot(first_grad, b)后再次求导

# 这样计算可以减少内存占用,因为该种计算方式不会在内存中对整个hessian矩阵进行展开

# 如果要重复计算 H*b,而b又每次迭代都变化的情况,此种方式的缺点是每次都需要再次求导,但是总计算量应该变化不大

tmp = torch.dot(first_grad, b)

print(torch.autograd.grad(tmp, w)[0]) # paper, Pearlmutter trick, 没太感觉出优势, 或许理解的不对

r = 0.0001

new_w = w+r*b

new_s = torch.mean( torch.square(label - torch.matmul(data, new_w)) ) new_first_grad = torch.autograd.grad(new_s, w)[0]

print( (new_first_grad - first_grad)/r )

注意:

这个代码一共输出三行,第一行是真实的 H(x)*b ,第二行是 Pearlmutter trick 技术计算的 H(x)*b,第三行是有限差分法计算的 H(x)*b 。

系数矩阵为Hessian矩阵时使用“Pearlmutter trick”或“有限差分法”近似的共轭梯度解法 —— Hession-free的共轭梯度法的更多相关文章

- Hessian矩阵【转】

http://blog.sina.com.cn/s/blog_7e1ecaf30100wgfw.html 在数学中,海塞矩阵是一个自变量为向量的实值函数的二阶偏导数组成的方块矩阵,一元函数就是二阶导, ...

- Hessian矩阵与多元函数极值

Hessian矩阵与多元函数极值 海塞矩阵(Hessian Matrix),又译作海森矩阵,是一个多元函数的二阶偏导数构成的方阵.虽然它是一个具有悠久历史的数学成果.可是在机器学习和图像处理(比如SI ...

- 三维重建面试4:Jacobian矩阵和Hessian矩阵

在使用BA平差之前,对每一个观测方程,得到一个代价函数.对多个路标,会产生一个多个代价函数的和的形式,对这个和进行最小二乘法进行求解,使用优化方法.相当于同时对相机位姿和路标进行调整,这就是所谓的BA ...

- 【机器学习】梯度、Hessian矩阵、平面方程的法线以及函数导数的含义

想必单独论及" 梯度.Hessian矩阵.平面方程的法线以及函数导数"等四个基本概念的时候,绝大部分人都能够很容易地谈个一二三,基本没有问题. 其实在应用的时候,这几个概念经常被混 ...

- 梯度、Hessian矩阵、平面方程的法线以及函数导数的含义

本文转载自: Xianling Mao的专栏 =========================================================================== 想 ...

- 梯度vs Jacobian矩阵vs Hessian矩阵

梯度向量 定义: 目标函数f为单变量,是关于自变量向量x=(x1,x2,-,xn)T的函数, 单变量函数f对向量x求梯度,结果为一个与向量x同维度的向量,称之为梯度向量: 1. Jacobian 在向 ...

- C#处理医学图像(二):基于Hessian矩阵的医学图像增强与窗宽窗位

根据本系列教程文章上一篇说到,在完成C++和Opencv对Hessian矩阵滤波算法的实现和封装后, 再由C#调用C++ 的DLL,(参考:C#处理医学图像(一):基于Hessian矩阵的血管肺纹理骨 ...

- Jacobian矩阵和Hessian矩阵

1.Jacobian矩阵 在矩阵论中,Jacobian矩阵是一阶偏导矩阵,其行列式称为Jacobian行列式.假设 函数 $f:R^n \to R^m$, 输入是向量 $x \in R^n$ ,输出为 ...

- Hessian矩阵

http://baike.baidu.com/link?url=o1ts6Eirjn5mHQCZUHGykiI8tDIdtHHOe6IDXagtcvF9ncOfdDOzT8tmFj41_DEsiUCr ...

- Jacobian矩阵、Hessian矩阵和Newton's method

在寻找极大极小值的过程中,有一个经典的算法叫做Newton's method,在学习Newton's method的过程中,会引入两个矩阵,使得理解的难度增大,下面就对这个问题进行描述. 1, Jac ...

随机推荐

- 算法金 | 一文彻底理解机器学习 ROC-AUC 指标

大侠幸会,在下全网同名「算法金」 0 基础转 AI 上岸,多个算法赛 Top 「日更万日,让更多人享受智能乐趣」 在机器学习和数据科学的江湖中,评估模型的好坏是非常关键的一环.而 ROC(Rece ...

- java.sql.SQLException: Connection is read-only. Queries leading to data modification are not

java.sql.SQLException: Connection is read-only. Queries leading to data modification are not 产生的原因:事 ...

- ObjectMapper Json字符串的转换处理

package com.example.demo; import com.example.pojo.User; import com.fasterxml.jackson.annotation.Json ...

- Task - lmdeploy

基础作业: 使用 LMDeploy 以本地对话.网页Gradio.API服务中的一种方式部署 InternLM-Chat-7B 模型,生成 300 字的小故事(需截图

- 我写CSS的常用套路(附demo的效果实现与源码)

大赞: https://mp.weixin.qq.com/s/dYCWYeM629DwiSqmaaAs1w

- Shell脚本实现Linux回收站

前言 到目前为止,非图形化的Linux还没有回收站的命令. 那么,我们如果不小心将某一个文件删掉了,那就只能数据恢复了.如果这也不行,那就等着哭吧. 最新代码在我的github:https://git ...

- 基于 SQLite 3 的 C 学习:2-高级操作

基于 SQLite 3 的 C/C++ 学习:2-高级操作与有关函数 背景 基于 SQLite 3 的 C/C++ 学习:开发流程 与 基本函数 中,我们简单介绍了有关 SQLite3 函数的使用. ...

- 【workerman】uniapp+thinkPHP5使用GatewayWorker实现实时通讯

前言 之前公司需要一个内部的通讯软件,就叫我做一个.通讯软件嘛,就离不开通讯了,然后我就想到了长连接.这里本人用的是GatewayWorker框架. 什么是GatewayWorker框架? Gatew ...

- 苹果手机使用charles抓包无法下载charles证书

苹果手机使用charles抓包无法下载charles证书的问题记录: 使用:chls.pro/ssl --------无效 使用:http://chls.pro/ssl ---- ...

- 开源!开源一个flutter实现的古诗拼图游戏

去年(2023年)年底我初学flutter,看了一些文档和教程,想找个东西*练练手. 小时候看过一个关于历史名人儿时事迹的短片,有一集是讲*总理的,有一个细节我记得很清楚:幼年***经常要做一个游戏- ...