Flume+Kafka整合

脚本生产数据---->flume采集数据----->kafka消费数据------->storm集群处理数据

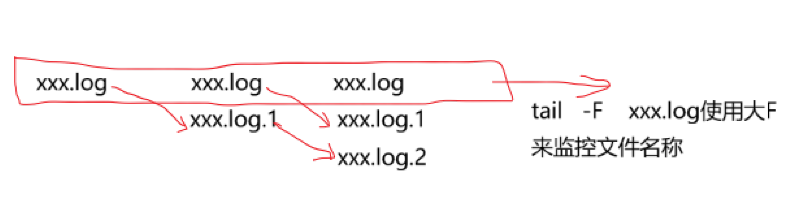

日志文件使用log4j生成,滚动生成!

当前正在写入的文件在满足一定的数量阈值之后,需要重命名!!!

flume+Kafka整合步骤及相关配置:(先安装好zookeeper集群和Kafka集群)

配置flume:

1、下载flume

2、解压flume安装包

cd /export/servers/

tar -zxvf apache-flume-1.6.0-bin.tar.gz

ln -s apache-flume-1.6.0-bin flume

3、创建flume配置文件

cd /export/servers/flume/conf/

mkdir myconf

vi exec.conf

输入一下内容:

a1.sources=r1

a1.channels=c1

a1.sinks=k1

a1.sources.r1.type=exec

a1.sources.r1.command=tail -F /export/data/flume_sources/click_log/1.log

a1.sources.r1.channels=c1

a1.channels.c1.type=memory

a1.channels.c1.capacity=10000

a1.channels.c1.transactionCapacity=100

a1.sinks.k1.type=org.apache.flume.sink.kafka.KafkaSink

a1.sinks.k1.topic=test

a1.sinks.k1.brokerList=kafka01:9092

a1.sinks.k1.requiredAcks=1

a1.sinks.k1.batchSize=20

a1.sinks.k1.channel=c1

4、准备目标数据的目录

mkdir -p /export/data/flume_sources/click_log

5、通过脚本创建目标文件并生产数据

for((i=0;i<=50000;i++));

do echo "message-" + $i >> /export/data/flume_sources/click_log/1.log;

done

注:脚本名称为click_log_out.sh,需要使用root用户赋权,chmod +x click_log_out.sh

6、开始打通所有流程

一:启动Kafka集群

kafka-server-start.sh /export/servers/kafka/config/server.properties

二:创建一个topic并开启consumer

kafka-console-consumer.sh --topic=test --zookeeper zk01:2181

三:执行数据生产的脚本

sh click_log_out.sh

四:启动flume客户端

./bin/flume_ng agent -n a1 -c conf -f conf/myconf/exec.conf -Dflume.root.logger=INFO,console

五:在第三步启动的kafka consumer窗口查看效果

Flume+Kafka整合的更多相关文章

- hadoop 之 kafka 安装与 flume -> kafka 整合

62-kafka 安装 : flume 整合 kafka 一.kafka 安装 1.下载 http://kafka.apache.org/downloads.html 2. 解压 tar -zxvf ...

- 大数据系列之Flume+kafka 整合

相关文章: 大数据系列之Kafka安装 大数据系列之Flume--几种不同的Sources 大数据系列之Flume+HDFS 关于Flume 的 一些核心概念: 组件名称 功能介绍 Agent ...

- Flume+Kafka+Storm+Redis 大数据在线实时分析

1.实时处理框架 即从上面的架构中我们可以看出,其由下面的几部分构成: Flume集群 Kafka集群 Storm集群 从构建实时处理系统的角度出发,我们需要做的是,如何让数据在各个不同的集群系统之间 ...

- flume与kafka整合

flume与kafka整合 前提: flume安装和测试通过,可参考:http://www.cnblogs.com/rwxwsblog/p/5800300.html kafka安装和测试通过,可参考: ...

- Flume+Kafka+Storm+Hbase+HDSF+Poi整合

Flume+Kafka+Storm+Hbase+HDSF+Poi整合 需求: 针对一个网站,我们需要根据用户的行为记录日志信息,分析对我们有用的数据. 举例:这个网站www.hongten.com(当 ...

- Flume+Kafka+Storm整合

Flume+Kafka+Storm整合 1. 需求: 有一个客户端Client可以产生日志信息,我们需要通过Flume获取日志信息,再把该日志信息放入到Kafka的一个Topic:flume-to-k ...

- ambari下的flume和kafka整合

1.配置flume #扫描指定文件配置 agent.sources = s1 agent.channels = c1 agent.sinks = k1 agent.sources.s1.type=ex ...

- Flume和Kafka整合安装

版本号: RedHat6.5 JDK1.8 flume-1.6.0 kafka_2.11-0.8.2.1 1.flume安装 RedHat6.5安装单机flume1.6:http://b ...

- flume和kafka整合(转)

原文链接:Kafka flume 整合 前提 前提是要先把flume和kafka独立的部分先搭建好. 下载插件包 下载flume-kafka-plus:https://github.com/beyon ...

随机推荐

- UEditor百度编辑器,工具栏自定义添加一个普通按钮

根据网上前辈提供的,还真的不错,下面也整理一下 添加一个名叫“macros”的普通按钮在工具栏上: 第一步:找到ueditor.config.js文件中的toolbars数组,增加一个“macros” ...

- C#窗口防止闪烁两种方法

public class PaintIncrease { public static void SetDoubleBuffered(object obj) { Type type = obj.GetT ...

- linux4.10.8 内核移植(三)---裁剪内核

一.裁剪内核 1.1 第一次修改 现在的内核大小为2.8M左右,要裁剪到2.0M以下,毕竟给内核分区就只有2.0M. 这两个设备我们没有,裁剪掉. 进入make menuconfig中,搜索mouse ...

- CSS进阶之SASS入门指南

CSS进阶之SASS入门指南 随着跟着公司学习项目的前端的推进,越来越对好奇了许久的SASS垂涎欲滴,哈哈,可能这个词使用不当,没有关系,就是对SASS有一股神秘的爱!好了,闲话不多说 ...

- luogu P1052 过河

传送门 容易想到设\(f_i\)表示走到坐标\(i\)的最少走过的石子数 但是这题数据范围很大,,, 不过一次可以走的步数范围是1-10,石子个数最多100个,所以中间会有很多多出来的没石子的路,可以 ...

- luogu P3522 [POI2011]TEM-Temperature

这道题暴力做法就是枚举每个起点,然后向后拓展到不能拓展 就像这样(红框是每个位置的取值范围,绿线是你取的值构成的折线) 应该可以发现,左端点往右移的过程中,右端点也只能不动或往右移,所以我们可以每次移 ...

- 2018-2019-2 网络对抗技术 20165320 Exp5 MSF基础应用

2018-2019-2 网络对抗技术 20165320 Exp5 MSF基础应用 一.实践内容 本实践目标是掌握metasploit的基本应用方式,重点常用的三种攻击方式的思路.具体需要完成: 一个主 ...

- JSP验证码。

package com; import java.awt.Color; import java.awt.Font; import java.awt.Graphics2D; import java.aw ...

- py-faster-rcnn + opencv3.0.0 + ubuntu16.04配置(CPU模式)

最近开始做行人检测,因此开始接触faster-rcnn,这里贴上配置教程(亲测可行),不过是基于cpu的,蓝瘦... 参考博客:http://www.tuicool.com/articles/nYJr ...

- [USACO12DEC]逃跑的BarnRunning Away From…

题意 给出以1号点为根的一棵有根树,问每个点的子树中与它距离小于等于l的点有多少个 题解 似乎有好多种做法啊……然而蒟蒻只会打打主席树的板子…… 调了一个上午一直WA……狠下心来重打一遍居然直接一遍过 ...