scrapy原理

scarpy据说是目前最强大的爬虫框架,没有之一。就是这么自信。

官网都是这么说的。

An open source and collaborative framework for extracting the data you need from websites. In a fast, simple, yet extensible way.

一个开源的,协作的框架从网络收集你需要的数据,是简单,快速以及可扩展的。

那么学习之前,首先要学习一个原理。

Scarpy有几个模块

1.engine 引擎,框架已经实现,不需要我们写,它是scrapy能够进行的重要部件。好比车的发动机。

2.spiders 爬虫文件

3.schedule 调度器 对于发起的请求入队列

4.downloader下载器 从互联网中下载网页源代码

5,Itempipline 管道文件 ,用于可持续化存储数据,可以存储在MySQL,MongoDB,Redis,也可以保存于文件。

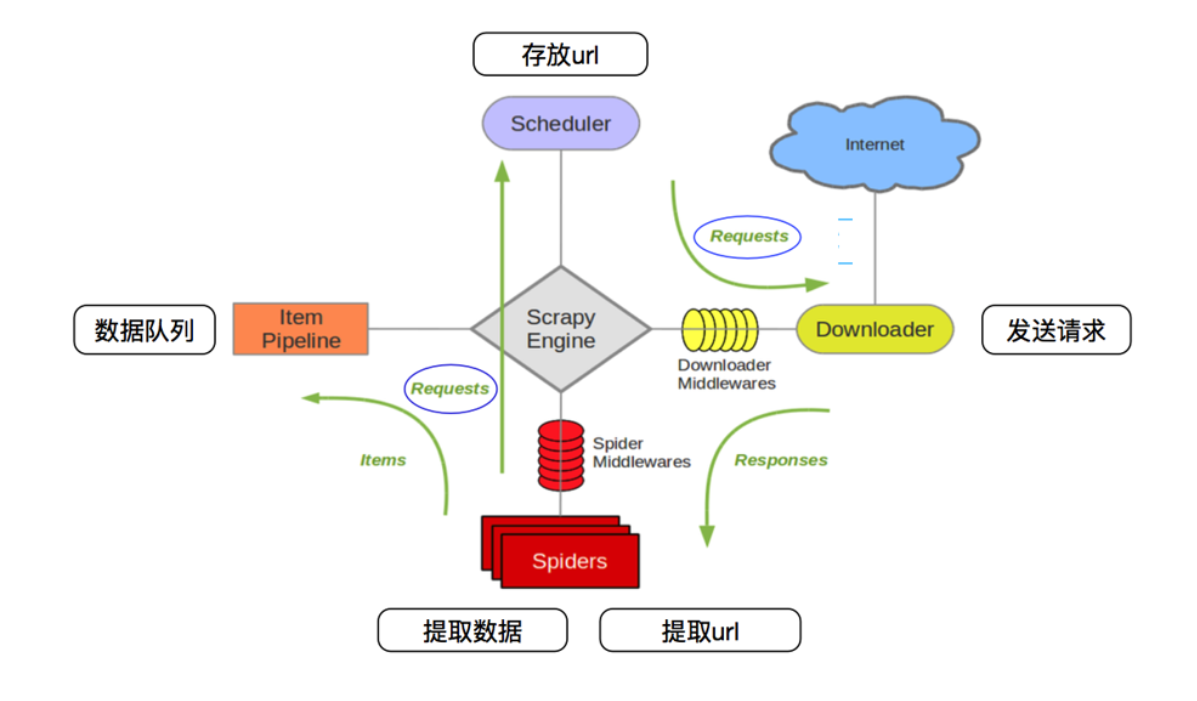

通过这个图可以看出scrapy工作的原理。

1,spiders 将发送的请求request(url)发送给 scrapy engine 引擎。然后引擎发送给调度器(scheduler),调度器对发送来的请求进行排序,入队列

2. scheduler调度器将请求request(url) ,发给scrapy engine引擎,然后引擎(Engine)将请求request 通过Downloader Middleware(下载器中间建)发送给Downloader下载器。

3,下载器Downloader 向互联网发送请求(request),下载网页源代码。得到response 响应,响应response通过 SpiderMiddleWares,发送给Spiders爬虫文件。

4.爬虫spiders对数据进行提取,然后发送数据交给Itempipeline 管道,管道将数据进行持久化操作或者保存。

spiders对下载器下载的网页源码进行数据机器,scrapy提供了css选择器。可以方便提取相关的数据。

通过这些步骤可以看出来,scrapy engine是占据很重要的位置。它负责联系各种组件之间的信号signals传递。

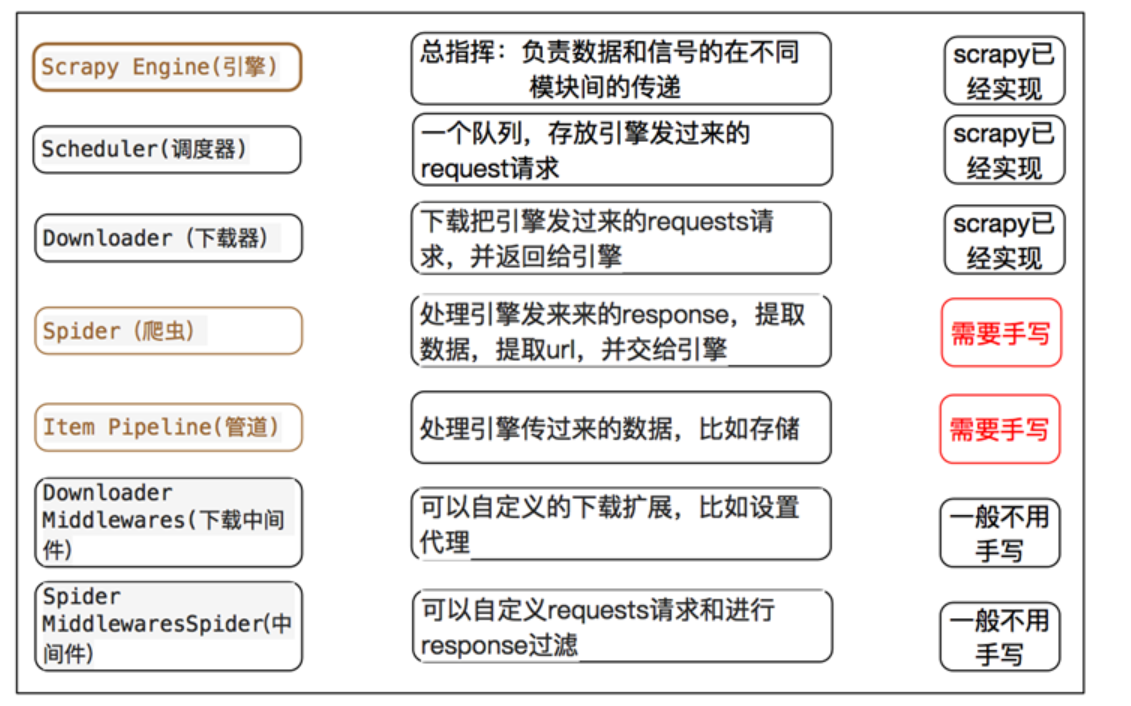

通过以下图,可以看出来,Scrapy需要我们书写的靳靳是spider,ItemPipeline,提取数据和持久化数据操作。其余的都已经替我们实现了。

scrapy原理的更多相关文章

- Scrapy 原理

Scrapy 原理 一.原理 scrapy 是一个为了爬取网站数据,提取结构性数据而编写的应用框架.可以应用在包括数据挖掘,信息处理或存储历史数据等一系列程序中. 二.工作流程 Scrapy Engi ...

- scrapy 原理,结构,基本命令,item,spider,selector简述

原理,结构,基本命令,item,spider,selector简述 原理 (1)结构 (2)运行流程 实操 (1) scrapy命令: 注意先把python安装目录的scripts文件夹添加到环境变量 ...

- 基于scrapy源码实现的自定义微型异步爬虫框架

一.scrapy原理 Scrapy 使用了 Twisted异步网络库来处理网络通讯.整体架构大致如下 Scrapy主要包括了以下组件: 引擎(Scrapy)用来处理整个系统的数据流处理, 触发事务(框 ...

- 学习scrapy框架爬小说

一.背景:近期学习python爬虫技术,感觉挺有趣.由于手动自制爬虫感觉效率低,了解到爬虫界有先进的工具可用,尝试学学scrapy爬虫框架的使用. 二.环境:centos7,python3.7,scr ...

- 01.scrapy入门

Scrapy快速入门 Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,它使用Twisted这个异步网络库来处理网络通讯,架构清晰,并且包含了各种中间件接口,可以灵活的完成各种需求. ...

- java网络爬虫----------简单抓取慕课网首页数据

© 版权声明:本文为博主原创文章,转载请注明出处 一.分析 1.目标:抓取慕课网首页推荐课程的名称和描述信息 2.分析:浏览器F12分析得到,推荐课程的名称都放在class="course- ...

- python网络爬虫之scrapy 工程创建以及原理介绍

执行scrapy startproject XXXX的命令,就会在对应的目录下生成工程 在pycharm中打开此工程目录:并在Run中选择Edit Configuration 点击+创建一个Pytho ...

- scrapy暂停和重启,及url去重原理,telenet简单使用

一.scrapy暂停与重启 1.要暂停,就要保留一些中间信息,以便重启读取中间信息并从当前位置继续爬取,则需要一个目录存放中间信息: scrapy crawl spider_name -s JOBDI ...

- 第三百三十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—深度优先与广度优先原理

第三百三十八节,Python分布式爬虫打造搜索引擎Scrapy精讲—深度优先与广度优先原理 网站树形结构 深度优先 是从左到右深度进行爬取的,以深度为准则从左到右的执行(递归方式实现)Scrapy默认 ...

随机推荐

- 控制透明度(兼容IE FF)

filter:alpha(opacity=70);opacity:0.7;

- 2018-2019 2 20165203 《网络对抗技术》Exp7 网络欺诈防范

2018-2019 2 20165203 <网络对抗技术>Exp7 网络欺诈防范 实验目的 本实践的目标理解常用网络欺诈背后的原理,以提高防范意识,并提出具体防范方法. 实验内容 (1)简 ...

- Locust 源码理解与分析

前言 相信很多小伙伴会选择Locust作为压测工具辅助测试,本文从Locust源码开始分析它的优劣,结论在最后,最终我还是选择了Jmeter 主要分析了Locust源码的两个文件:main.py 和 ...

- 建站手册-浏览器信息:Google Chrome 浏览器

ylbtech-建站手册-浏览器信息:Google Chrome 浏览器 1.返回顶部 1. http://www.w3school.com.cn/browsers/browsers_chrome.a ...

- 115、TensorFlow变量的使用

# To use the value of a tf.Variable in a Tesnorflow graph , simply treat it like a normal tf.Tensor ...

- VS2015 编写C++的DLL,并防止DLL导出的函数名出现乱码(以串口通信为例,实现串口通信)

参考链接:https://blog.csdn.net/songyi160/article/details/50754705 1.新建项目 建立好的项目界面如下: 接着在解决方案中找到[头文件]然后右击 ...

- 指针的value

全局变量的默认初始化值为0,char为空字符——'\0',string为"\0 " char c; string s; ; int main() { cout << p ...

- NTFS文件系统的UsnJrnl对于FileReference的处理

1. 背景 http://stackoverflow.com/q/20418694/941650 这里面临的一个核心问题是,如果MFT Reference相等,能够表明这些记录代表的是同一个文件吗? ...

- python 装饰器 第九步:使用类来作为装饰器

#第九步:使用类来作为装饰器 class kuozhan: #接收装饰器的参数(函数outer) def __init__(self,arg): print(self,arg)#arg就是la sel ...

- python 装饰器 第五步(2):带有返回值得装饰器

#第五步:带有返回值的装饰器 把第四步复制过来 #用于扩展基本函数的函数 def kuozhan(func): #内部函数(扩展之后的eat函数) def neweat(): #以下三步就是扩展之后的 ...