python爬虫学习之使用XPath解析开奖网站

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件。

实例环境:python3.7

BeautifulSoup库、XPath(需手动安装)

urllib库(内置的python库,无需手动安装)

实例网站:

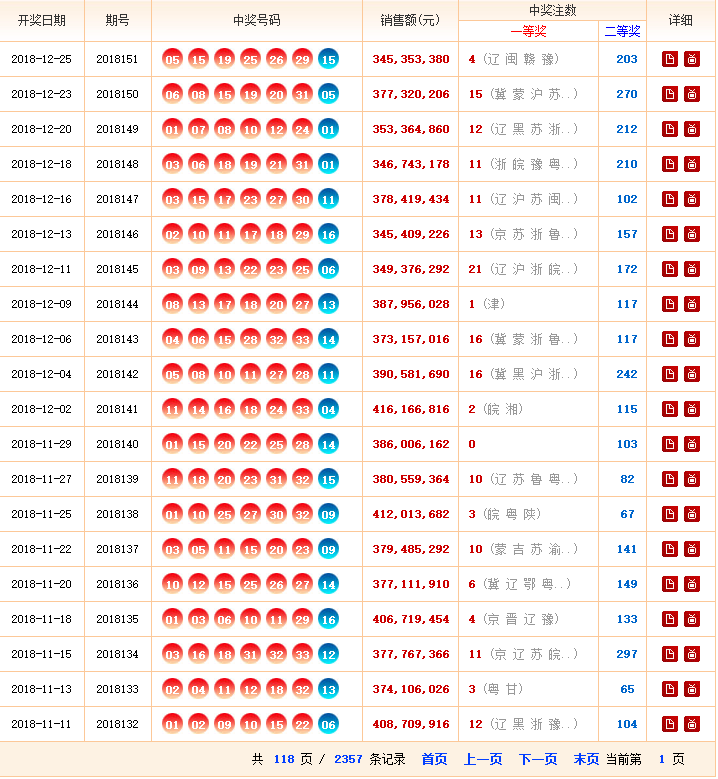

第一步,点击链接http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html进入网站,查看网站基本信息,注意一共要爬取118页数据。

第二步,查看网页源代码,熟悉网页结构,标签等信息。

实例代码:

#encoding=utf-8

#pip install lxml

from bs4 import BeautifulSoup

import urllib.request

from lxml import etree class GetDoubleColorBallNumber(object):

def __init__(self):

self.urls = []

self.getUrls()

self.items = self.spider(self.urls)

self.pipelines(self.items) def getUrls(self):

URL = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list.html'

htmlContent = self.getResponseContent(URL)

soup = BeautifulSoup(htmlContent, 'html.parser')

tag = soup.find_all('p')[-1]

pages = tag.strong.get_text()

pages = '3'

for i in range(2, int(pages)+1):

url = r'http://kaijiang.zhcw.com/zhcw/html/ssq/list_' + str(i) + '.html'

self.urls.append(url) #3、 网络模块(NETWORK)

def getResponseContent(self, url):

try:

response = urllib.request.urlopen(url)

except urllib.request.URLError as e:

raise e

else:

return response.read().decode("utf-8") #3、爬虫模块(Spider)

def spider(self,urls):

items = []

for url in urls:

try:

html = self.getResponseContent(url)

xpath_tree = etree.HTML(html)

trTags = xpath_tree.xpath('//tr[not(@*)]') # 匹配所有tr下没有任何属性的节点

for tag in trTags: # if tag.xpath('../html'):

# print("找到了html标签")

# if tag.xpath('/td/em'):

# print("****************") #如果存在em子孙节点

if tag.xpath('./td/em'):

item = {}

item['date'] = tag.xpath('./td[1]/text()')[0]

item['order'] = tag.xpath('./td[2]/text()')[0]

item['red1'] = tag.xpath('./td[3]/em[1]/text()')[0]

item['red2'] = tag.xpath('./td[3]/em[2]/text()')[0]

item['red3'] = tag.xpath('./td[3]/em[3]/text()')[0]

item['red4'] = tag.xpath('./td[3]/em[4]/text()')[0]

item['red5'] = tag.xpath('./td[3]/em[5]/text()')[0]

item['red6'] = tag.xpath('./td[3]/em[6]/text()')[0]

item['blue'] = tag.xpath('./td[3]/em[7]/text()')[0]

item['money'] = tag.xpath('./td[4]/strong/text()')[0]

item['first'] = tag.xpath('./td[5]/strong/text()')[0]

item['second'] = tag.xpath('./td[6]/strong/text()')[0]

items.append(item)

except Exception as e:

print(str(e))

raise e

return items def pipelines(self,items):

fileName = u'双色球.txt'

with open(fileName, 'w') as fp:

for item in items:

fp.write('%s %s \t %s %s %s %s %s %s %s \t %s \t %s %s \n'

%(item['date'],item['order'],item['red1'],item['red2'],item['red3'],item['red4'],item['red5'],item['red6'],item['blue'],item['money'],item['first'],item['second'])) if __name__ == '__main__':

GDCBN = GetDoubleColorBallNumber()

实例结果:

python爬虫学习之使用XPath解析开奖网站的更多相关文章

- Python爬虫学习之使用beautifulsoup爬取招聘网站信息

菜鸟一只,也是在尝试并学习和摸索爬虫相关知识. 1.首先分析要爬取页面结构.可以看到一列搜索的结果,现在需要得到每一个链接,然后才能爬取对应页面. 关键代码思路如下: html = getHtml(& ...

- python爬虫学习之使用BeautifulSoup库爬取开奖网站信息-模块化

实例需求:运用python语言爬取http://kaijiang.zhcw.com/zhcw/html/ssq/list_1.html这个开奖网站所有的信息,并且保存为txt文件和excel文件. 实 ...

- python爬虫学习笔记(一)——环境配置(windows系统)

在进行python爬虫学习前,需要进行如下准备工作: python3+pip官方配置 1.Anaconda(推荐,包括python和相关库) [推荐地址:清华镜像] https://mirrors ...

- Python爬虫学习:三、爬虫的基本操作流程

本文是博主原创随笔,转载时请注明出处Maple2cat|Python爬虫学习:三.爬虫的基本操作与流程 一般我们使用Python爬虫都是希望实现一套完整的功能,如下: 1.爬虫目标数据.信息: 2.将 ...

- Python爬虫教程-22-lxml-etree和xpath配合使用

Python爬虫教程-22-lxml-etree和xpath配合使用 lxml:python 的HTML/XML的解析器 官网文档:https://lxml.de/ 使用前,需要安装安 lxml 包 ...

- 小白学 Python 爬虫(21):解析库 Beautiful Soup(上)

小白学 Python 爬虫(21):解析库 Beautiful Soup(上) 人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前 ...

- 小白学 Python 爬虫(22):解析库 Beautiful Soup(下)

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- 小白学 Python 爬虫(23):解析库 pyquery 入门

人生苦短,我用 Python 前文传送门: 小白学 Python 爬虫(1):开篇 小白学 Python 爬虫(2):前置准备(一)基本类库的安装 小白学 Python 爬虫(3):前置准备(二)Li ...

- python爬虫学习01--电子书爬取

python爬虫学习01--电子书爬取 1.获取网页信息 import requests #导入requests库 ''' 获取网页信息 ''' if __name__ == '__main__': ...

随机推荐

- 双硬盘,win10安装到固态盘

1.PE下格式化固态盘的系统盘 2.打开DG分区工具,查看固态盘的系统盘是否为激活状态,红色为激活,如果不是,激活一下 3.用windows安装器,或者hdd安装win10到固态盘 4.bios中启动 ...

- Windows网络发现无法启动

解决方法: 运行services.msc命令,打开服务界面.分别将Function Discovery Resource Publication.SSDP Discovery.UPnP Device ...

- django admin的实用配置

https://www.cnblogs.com/wumingxiaoyao/p/6928297.html

- Oracle 12导出、导入数据

Precondition: complete the work described in Oracle 12 创建新的数据库实例.用户 1. export data under user " ...

- mr微博内容推荐

第一次迭代 1 package com.laoxiao.mr.weibo; import java.io.StringReader; import org.apache.commons.lan ...

- 初识spark的MLP模型

初识Spark的MLP模型 1. MLP介绍 Multi-layer Perceptron(MLP),即多层感知器,是一个前馈式的.具有监督的人工神经网络结构.通过多层感知器可包含多个隐藏层,实现对非 ...

- AJAX随笔1

[1] AJAX简介 > 全称: Asynchronous JavaScript And XML > 异步的JavaScript和XML > AJAX就是通过JavaSc ...

- SQL: Cannot create JDBC driver of class '' for connect URL

使用数据库数据源的web 项目,发布后,访问数据库500报错: 浏览器端: 控制台: 数据库连接池在不启动Tomcat的情况下,测试类通过,没有问题. 一旦在服务器发布,就会出现问题,考虑是Tomca ...

- 记录一下maven使用过程中的问题

Failed to execute goal on project bos_fore: Could not resolve dependencies for project 上面问题,我把<de ...

- pandas库的学习笔记

Environment pandas 0.21.0 python 3.6 jupyter notebook 开始 习惯上,我们导入如下: import pandas as pd import nump ...