spark (五) RDD的创建 & 分区

1. RDD的创建方式

1.1 从内存创建RDD

主要依赖如下两个方法

- parallelize

- makeRDD

- 底层调用的还是

parallelize

- 底层调用的还是

def main(args: Array[String]): Unit = {

val sparkConfig: SparkConf = new SparkConf()

.setMaster("local[*]")

.setAppName("WordCount")

val sparkContext: SparkContext = new SparkContext(sparkConfig)

val rdd1: RDD[Int] = sparkContext.parallelize(

List(1, 2, 3, 4)

)

// makeRDD 底层调用的还是parallelize

val rdd2: RDD[Int] = sparkContext.makeRDD(

List(1, 2, 3, 4)

)

}

1.2 从外部存储(文件)创建RDD

由外部存储系统的数据集创建RDD包括

- 本地文件系统

- 所有Hadoop支持的数据集,比如HDFS、HBase等

def main(args: Array[String]): Unit = {

val sparkConfig: SparkConf = new SparkConf()

.setMaster("local[*]")

.setAppName("WordCount")

val sparkContext: SparkContext = new SparkContext(sparkConfig)

val rdd1: RDD[String] = sparkContext.textFile("data") // 或者 hdfs://master:7077/input

rdd1.collect().foreach(println)

sparkContext.stop()

}

1.3 从其他的RDD创建

下述的flatMap map reduceByKey 每个操作都是以上一个RDD为基础创建另一个RDD

def main(args: Array[String]): Unit = {

val sparkConfig: SparkConf = new SparkConf()

.setMaster("local[*]")

.setAppName("WordCount")

val sparkContext: SparkContext = new SparkContext(sparkConfig)

val rdd1: RDD[String] = sparkContext.textFile("data") // 或者 hdfs://master:7077/input

rdd1

.flatMap(word => word.split(" "))

.map(word => (word, 1))

.reduceByKey(_ + _)

.collect()

.foreach(println)

sparkContext.stop()

}

1.4 直接 new RDD

spark框架中会这么操作

2. 分区(partition)

2.1 makeRDD的分区

可以通过以下优先级方式指定分区

- 优先使用

makeRDD的第二个参数指定的分区数量 - 使用默认的配置的分区数量

- SparkConf 若指定了

spark.default.parallelism, 则用这个 - 否则使用CPU的核数(这里的CPU的核数在本地模式下,如

local[3]则为3,local[*]等于物理机真实的CPU核数)

- SparkConf 若指定了

// 第二个参数指定numSlices, 即分区的数量

val rdd: RDD[Int] = sparkContext.makeRDD(List(1, 2, 3, 4), 2)

完整的表现分区的例子

package com.lzw.bigdata.spark.core.rdd_basic_usage_1

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object Rdd_4_Partition_From_Mem {

def main(args: Array[String]): Unit = {

val sparkConfig: SparkConf = new SparkConf()

.setMaster("local[*]")

.setAppName("WordCount")

// .set("spark.default.parallelism", "5")

val sparkContext: SparkContext = new SparkContext(sparkConfig)

val rdd: RDD[Int] = sparkContext.makeRDD(List(1, 2, 3, 4), 2)

// 保存成分区文件,每个分区会生成一个文件,可以借此查看真实生成了几个分区

rdd.saveAsTextFile("output")

sparkContext.stop()

}

}

2.2 读取文件的分区例子

spark读取文件借助的是hadoop的方法, 所以以下的读取规则是hadoop的规则

// 可以指定 minPartitions, 不指定默认是 math.min(defaultParallelism, 2)

sparkContext.textFile("data/word.txt", 2)

以以下一个文件word.txt为例, 该文件算上换行符\n一共13个字节

1234

567

8900

2.2.1 读取文件分区规则

所以分区数计算方式为

分区数: 13 bytes / 2(这里2是minPartitions) = 6

13 bytes / 6 bytes = 2分区 + 剩余的1byte => 1/6 > 0.1 => 3分区

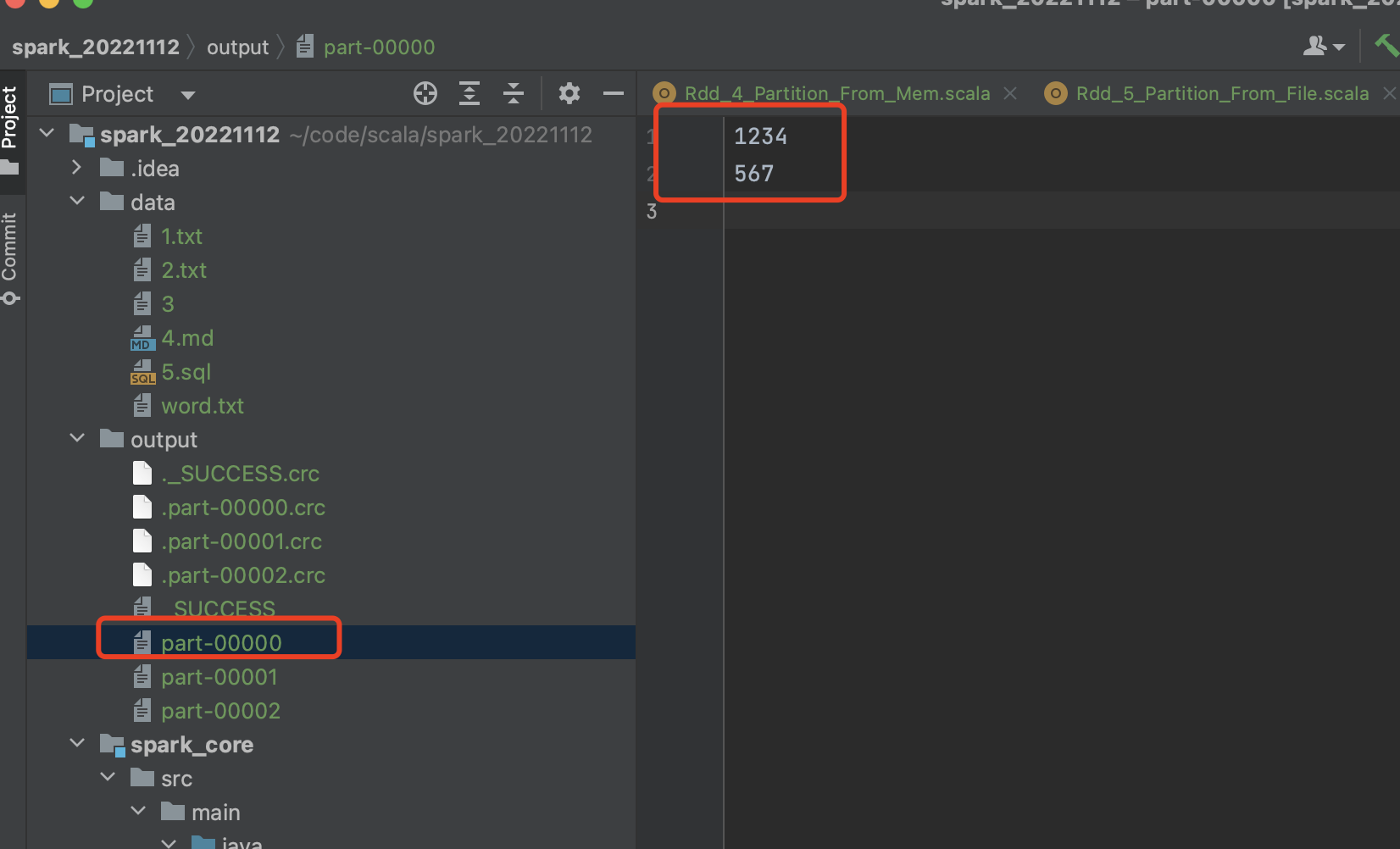

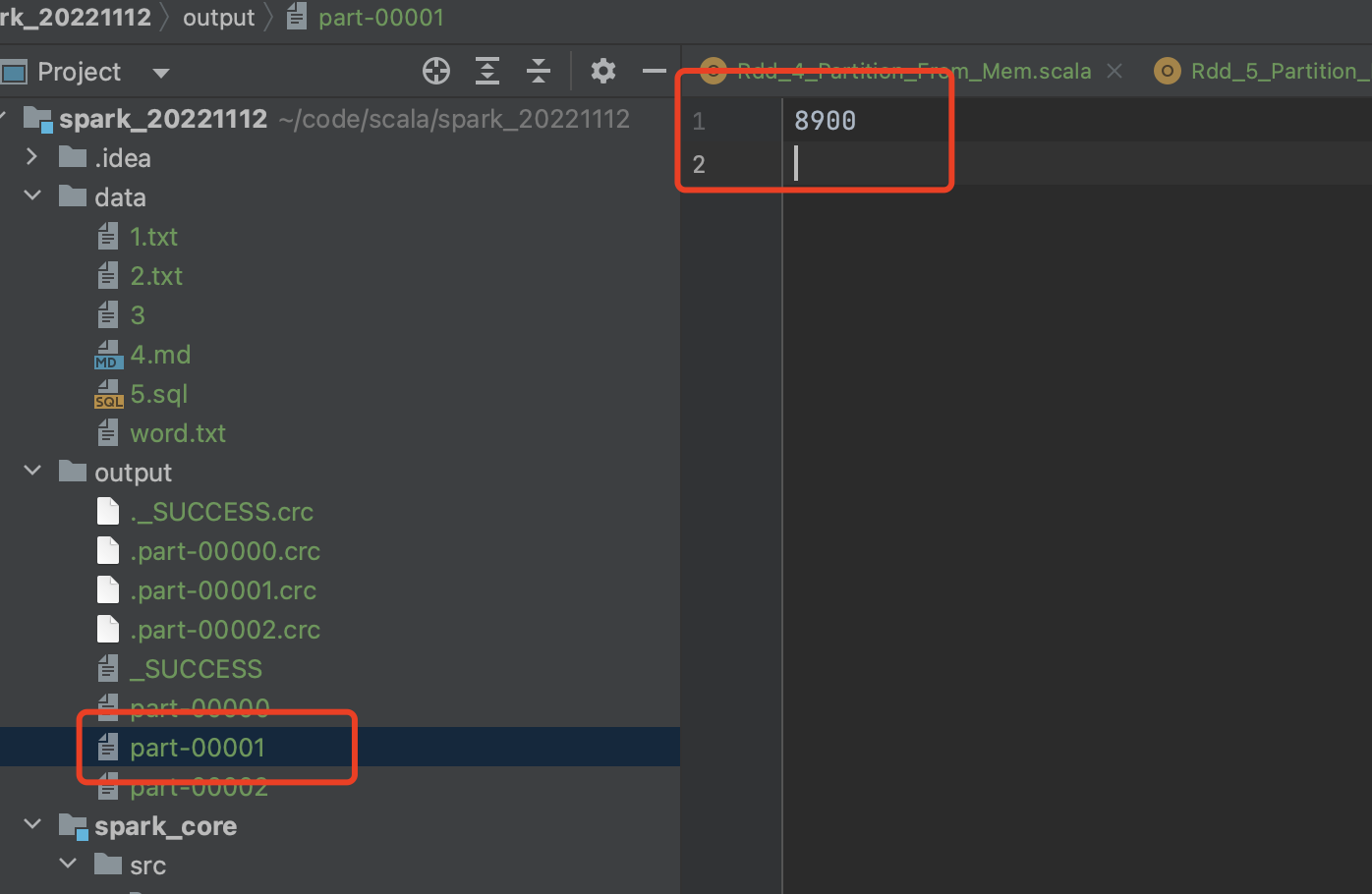

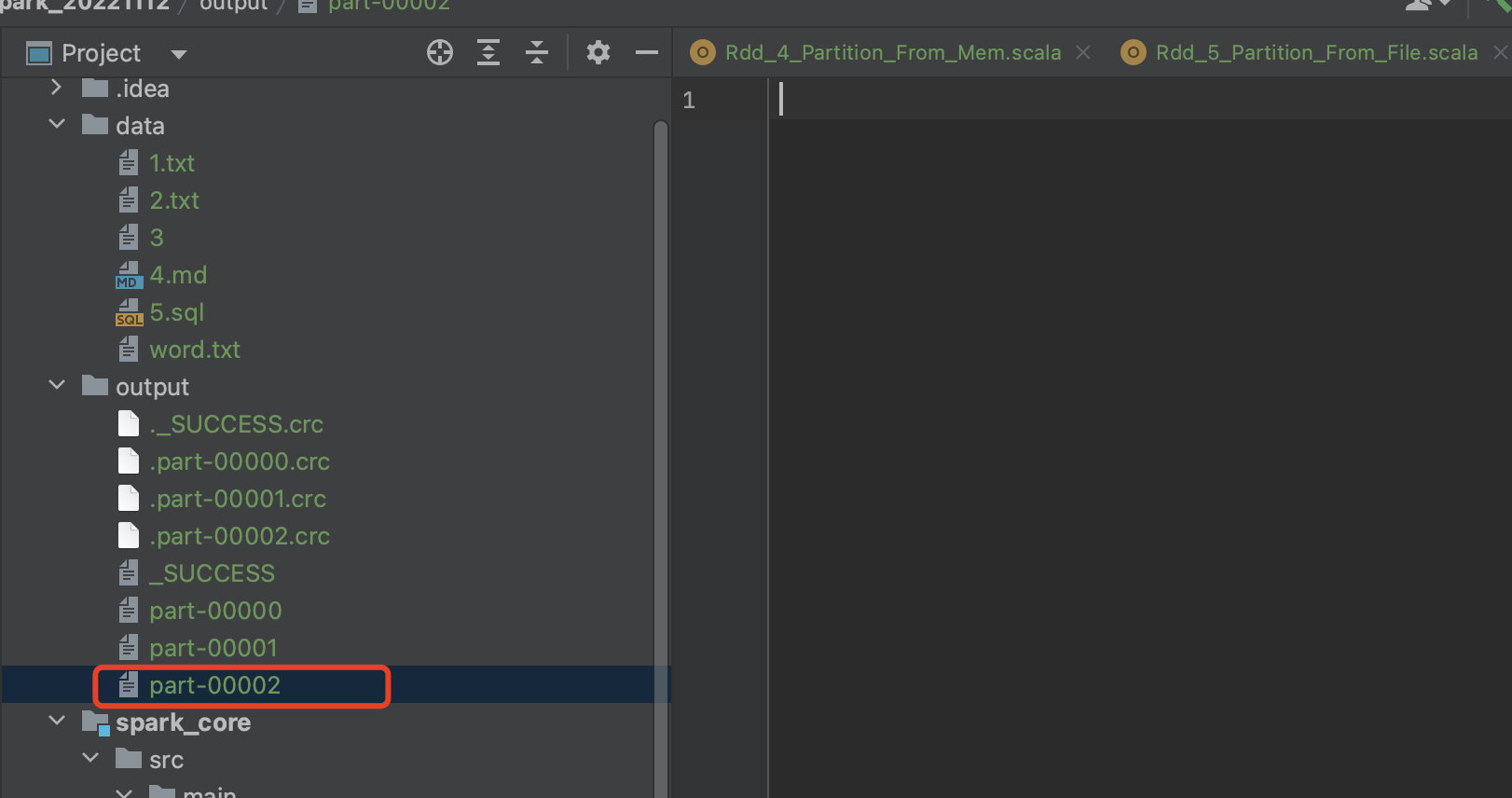

2.2.2 每个分区的数据

每个分区里面的数据, (hadoop按偏移量之后按行读取):

分区1预期 [0, 6] => 1234\n

567\n

分区2预期[6, 12] => 但是上一个分区因为是偏移量到了某一行,某行就都被读走了,所以真实的

=> 8900

分区3预计[12, 13] => 已无数据可读

2.2.3 完整示例

package com.lzw.bigdata.spark.core.rdd_basic_usage_1

import org.apache.spark.rdd.RDD

import org.apache.spark.{SparkConf, SparkContext}

object Rdd_5_Partition_From_File {

def main(args: Array[String]): Unit = {

val sparkConfig: SparkConf = new SparkConf()

.setMaster("local[*]")

.setAppName("WordCount")

// .set("spark.default.parallelism", "5")

val sparkContext: SparkContext = new SparkContext(sparkConfig)

/*

1234\n

567\n

8900

分区数: 13 bytes / 2(这里2是minPartitions) = 6

13 bytes / 6 bytes = 2分区 + 剩余的1byte => 1/6 > 0.1 => 3分区

每个分区里面的数据, (hadoop按偏移量之后按行读取):

分区1预期 [0, 6] => 1234\n

567\n

分区2预期[6, 12] => 但是上一个分区因为是偏移量到了某一行,某行就都被读走了,所以真实的

=> 8900

分区3预计[12, 13] => 已无数据可读

*/

val rdd: RDD[String] = sparkContext.textFile("data/word.txt", 2)

rdd.saveAsTextFile("output")

sparkContext.stop()

}

}

spark (五) RDD的创建 & 分区的更多相关文章

- spark 中如何查看单个RDD分区的内容(创建分区,查看分区数)

spark 创建分区 val scores = Array(("Fred", 88), ("Fred", 95), ("Fred", 91) ...

- Spark核心RDD、什么是RDD、RDD的属性、创建RDD、RDD的依赖以及缓存、

1:什么是Spark的RDD??? RDD(Resilient Distributed Dataset)叫做弹性分布式数据集,是Spark中最基本的数据抽象,它代表一个不可变.可分区.里面的元素可并行 ...

- 【Spark】快来学习RDD的创建以及操作方式吧!

目录 RDD的创建 三种方式 从一个集合中创建 从文件中创建 从其他的RDD转化而来 RDD编程常用API 算子分类 Transformation 概述 帮助文档 常用Transformation表 ...

- Spark RDD概念学习系列之RDD的创建(六)

RDD的创建 两种方式来创建RDD: 1)由一个已经存在的Scala集合创建 2)由外部存储系统的数据集创建,包括本地文件系统,还有所有Hadoop支持的数据集,比如HDFS.Cassandra.H ...

- Spark核心——RDD

Spark中最核心的概念为RDD(Resilient Distributed DataSets)中文为:弹性分布式数据集,RDD为对分布式内存对象的 抽象它表示一个被分区不可变且能并行操作的数据集:R ...

- [Spark] Spark的RDD编程

本篇博客中的操作都在 ./bin/pyspark 中执行. RDD,即弹性分布式数据集(Resilient Distributed Dataset),是Spark对数据的核心抽象.RDD是分布式元素的 ...

- 关于Spark中RDD的设计的一些分析

RDD, Resilient Distributed Dataset,弹性分布式数据集, 是Spark的核心概念. 对于RDD的原理性的知识,可以参阅Resilient Distributed Dat ...

- 理解Spark的RDD

RDD是个抽象类,定义了诸如map().reduce()等方法,但实际上继承RDD的派生类一般只要实现两个方法: def getPartitions: Array[Partition] def com ...

- Spark源码分析之分区器的作用

最近因为手抖,在Spark中给自己挖了一个数据倾斜的坑.为了解决这个问题,顺便研究了下Spark分区器的原理,趁着周末加班总结一下~ 先说说数据倾斜 数据倾斜是指Spark中的RDD在计算的时候,每个 ...

- [转]Spark学习之路 (三)Spark之RDD

Spark学习之路 (三)Spark之RDD https://www.cnblogs.com/qingyunzong/p/8899715.html 目录 一.RDD的概述 1.1 什么是RDD? ...

随机推荐

- css超出部分...显示

首先需要设置宽 white-space: nowrap;// 文字不换行 overflow: hidden;// 超出隐藏 text-overflow: ellipsis; 实现移入后正常显示的可 ...

- Web渗透10_CSRF SSRF

1 CSRF漏洞 CSRF 跨站请求伪造(英语:Cross-site request forgery),也被称为 one-click attack 或者 session riding,通常缩写为 CS ...

- 怎样在Windows 环境下安装Git附详细步骤图

Git下载路径:https://git-scm.com/ [步骤] 在非C盘创建一个git_install作为git的安装目录,双击安装包,按下一步默认安装即可 (后面有时间来补充各个参数意思,目前按 ...

- Flink 状态编程

概念 在Flink架构体系中,有状态计算可以说是Flink非常重要的特性之一 Flink优势: 支持高吞吐.低延迟.高性能 支持事件时间Event_time概念 支持有状态计算 有状态计算是指: 在程 ...

- 国内985大学计算机方向硕博高性价比灌水的SCI期刊pr、kbs、eswa、ieee tii、ieee tiv具体都是啥?

国内985大学计算机方向硕博高性价比灌水的SCI期刊pr.kbs.eswa.ieee tii.ieee tiv,下面给出具体名称: Pattern Recognition(PR) Knowledge- ...

- C++ 函数模板与类模板

目录 16.1.1 函数模板 16.1.2 类模板 定义类模板 实例化模板 在类外定义成员函数 类模板成员函数的实例化 类模板和友元 模板类型别名 类模板参数的static成员 16.1.3 模板参数 ...

- IBM 开源的文档转化利器「GitHub 热点速览」

上周的热门开源项目,Star 数增长犹如坐上了火箭,一飞冲天.短短一周就飙升了 6k Star 的多格式文档解析和导出神器 Docling,支持库和命令行的使用方式.全新的可视化爬虫平台 Maxun, ...

- Xdebug+Phpstorm远程调试

开发环境: 本地 Windows10 日常开发使用的环境 装有PHPStorm 远程主机 Linux 服务器 装php-fpm/nginx等所有开发依赖环境 本地可以访问远程主机 但远程主机无法访问本 ...

- Golang网络模型netpoll源码解析

0.引言 在学习完了Socket编程的基础知识.Linux系统提供的I/O多路复用的实现以及Golang的GMP调度模型之后,我们进而学习Golang的网络模型--netpoll.本文将从为什么需要使 ...

- 网站动静加速架构 dcdn+ga 全站加速和全球加速api

背景: 1,公司服务全部在香港 2,所有的服务也都在香港 3,但是我们的客户都在国内 4,那么国内用户访问香港的服务 那么就会存在慢的问题 至于为什么不放到国内,因为我们公司是做nft的.所以你懂得. ...