Python的scrapy之爬取豆瓣影评和排名

基于scrapy框架的爬影评

爬虫主程序:

import scrapy

from ..items import DoubanmovieItem class MoviespiderSpider(scrapy.Spider):

name = 'moviespider'

allowed_domains = ['douban.com']

start_urls = ['http://movie.douban.com/top250'] def parse(self, response):

movie_items=response.xpath('//div[@class="item"]')

for item in movie_items:

#print(type(item)) movie =DoubanmovieItem()

movie['rank']=item.xpath('div[@class="pic"]/em/text()').extract()

movie['title']=item.xpath('div[@class="info"]/div[@class="hd"]/a/span[@class="title"][1]/text()').extract()

movie['quote'] = item.xpath(

'div[@class="info"]/div[@class="bd"]/p[@class="quote"]/span[@class="inq"][1]/text()').extract()

movie['star'] = item.xpath(

'div[@class="info"]/div[@class="bd"]/div[@class="star"]/span/text()').extract() movie['src']=item.xpath(

'div[@class="pic"]/a/img/@src').extract() yield movie

pass #取下一页的地址

nextPageURL = response.xpath('//span[@class="next"]/a/@href').extract()

#print(nextPageURL)

if nextPageURL:

url = response.urljoin(nextPageURL[-1])

#print('url', url)

# 发送下一页请求并调用parse()函数继续解析

yield scrapy.Request(url, self.parse, dont_filter=False)

pass

else:

print("退出")

pass

items 对象

import scrapy class DoubanmovieItem(scrapy.Item):

# define the fields for your item here like:

# name = scrapy.Field()

rank=scrapy.Field()

title=scrapy.Field()

quote=scrapy.Field()

star=scrapy.Field()

src=scrapy.Field()

pass

pipelines 输出管道

class DoubanmoviePipeline(object):

def process_item(self, item, spider):

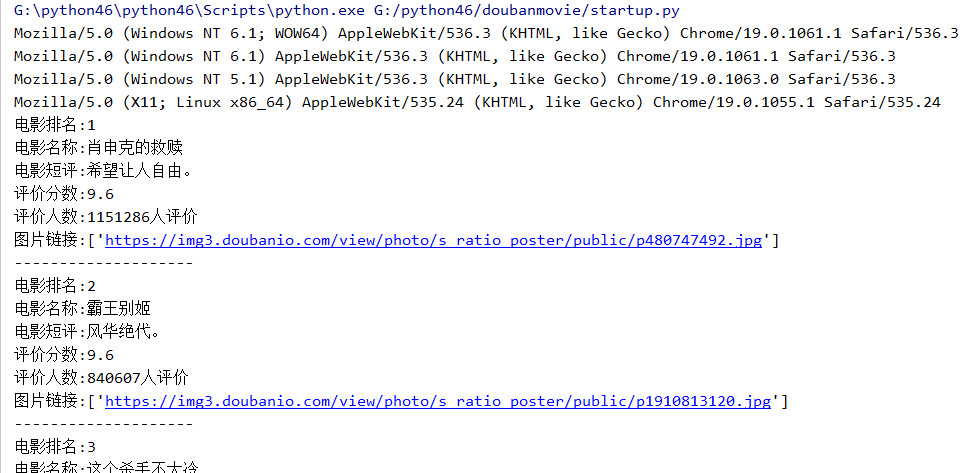

print('电影排名:{0}'.format(item['rank'][0]))

print('电影名称:{0}'.format(item['title'][0]))

print('电影短评:{0}'.format(item['quote'][0]))

print('评价分数:{0}'.format(item['star'][0]))

print('评价人数:{0}'.format(item['star'][1]))

print('图片链接:{0}'.format(item['src']))

print('-' * 20)

return item

在控制台输出的结果

可以通过爬出的图片链接,下载电影的剧照,这就另说了,也可以设置一个插入数据库的管道,将这些数据插入到数据库中

Python的scrapy之爬取豆瓣影评和排名的更多相关文章

- 基于python的scrapy框架爬取豆瓣电影及其可视化

1.Scrapy框架介绍 主要介绍,spiders,engine,scheduler,downloader,Item pipeline scrapy常见命令如下: 对应在scrapy文件中有,自己增加 ...

- Scrapy 通过登录的方式爬取豆瓣影评数据

Scrapy 通过登录的方式爬取豆瓣影评数据 爬虫 Scrapy 豆瓣 Fly 由于需要爬取影评数据在来做分析,就选择了豆瓣影评来抓取数据,工具使用的是Scrapy工具来实现.scrapy工具使用起来 ...

- 【python数据挖掘】爬取豆瓣影评数据

概述: 爬取豆瓣影评数据步骤: 1.获取网页请求 2.解析获取的网页 3.提速数据 4.保存文件 源代码: # 1.导入需要的库 import urllib.request from bs4 impo ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- [超详细] Python3爬取豆瓣影评、去停用词、词云图、评论关键词绘图处理

爬取豆瓣电影<大侦探皮卡丘>的影评,并做词云图和关键词绘图第一步:找到评论的网页url.https://movie.douban.com/subject/26835471/comments ...

- Python爬虫入门:爬取豆瓣电影TOP250

一个很简单的爬虫. 从这里学习的,解释的挺好的:https://xlzd.me/2015/12/16/python-crawler-03 分享写这个代码用到了的学习的链接: BeautifulSoup ...

- Python使用Scrapy框架爬取数据存入CSV文件(Python爬虫实战4)

1. Scrapy框架 Scrapy是python下实现爬虫功能的框架,能够将数据解析.数据处理.数据存储合为一体功能的爬虫框架. 2. Scrapy安装 1. 安装依赖包 yum install g ...

- Python的scrapy之爬取顶点小说网的所有小说

闲来无事用Python的scrapy框架练练手,爬取顶点小说网的所有小说的详细信息. 看一下网页的构造: tr标签里面的 td 使我们所要爬取的信息 下面是我们要爬取的二级页面 小说的简介信息: 下面 ...

- python爬虫scrapy框架——爬取伯乐在线网站文章

一.前言 1. scrapy依赖包: 二.创建工程 1. 创建scrapy工程: scrapy staratproject ArticleSpider 2. 开始(创建)新的爬虫: cd Artic ...

随机推荐

- Selenium2学习(八)-- 操作元素(键盘和鼠标事件)

前言 在前面的几篇中重点介绍了一些元素的到位方法,到位到元素后,接下来就是需要操作元素了.本篇总结了web页面常用的一些操作元素方法,可以统称为行为事件 有些web界面的选项菜单需要鼠标悬停在某个元素 ...

- Sql Server中一次更新多列数据

UPATE yourTableName SET column1 = xx, column2 = yy , column3 = zz WHERE yourCondition 举个例子,比如有这样一张表: ...

- IOS 触摸事件的处理

触摸事件的处理1.判断触摸点在谁身上: 调用所有UI控件的- (BOOL)pointInside:(CGPoint)point withEvent:(UIEvent *)event 2.pointIn ...

- MySQL30条规范解读

转载自:https://mp.weixin.qq.com/s?__biz=MjM5ODYxMDA5OQ==&mid=2651959906&idx=1&sn=2cbdc66cfb ...

- Poj 1961 KMP

题意:给定一个字符串,求他每一个前缀,如果他是周期的,求len/最短循环节. 分析: 复习一下KMP,之前有详细解析. 由于朴素匹配每次移动一位,KMP可以多移动 f[i] 位,f 就是失配函数,失配 ...

- 【翻译】苹果官网的命名规范之 Naming Properties and Data Types

苹果官方原文:Naming Properties and Data Types 前言:纯属练习英语和学习.翻译错误和不通顺的地方敬请谅解和指正.O(∩_∩)O 属性和数据类型的命名 本节讲述了属性定义 ...

- 转载 【MySql】Update批量更新与批量更新多条记录的不同值实现方法

批量更新 mysql更新语句很简单,更新一条数据的某个字段,一般这样写: UPDATE mytable SET myfield = 'value' WHERE other_field = 'other ...

- mybatis学习记录六——一对一、一对多和多对多查询

9 订单商品数据模型 9.1 数据模型分析思路 1.每张表记录的数据内容 分模块对每张表记录的内容进行熟悉,相当 于你学习系统 需求(功能)的过程. 2.每张表重要的字段设置 非空 ...

- 关于A*估价函数的总结

估价函数的优劣决定一个A*算法的好坏 360百科上是这样说的: (https://baike.so.com/doc/6223470-6436780.html) 关于估价函数h(n)与实际距离d(n)的 ...

- js读取跨域webapi传送回来的cookie 要点

1.webapi 返回cookie时,httpOnly=false 2.webapi 接收Origins 不能为* 3.js端 请求时,withCredentials必须: true //`wit ...