Spark Job的提交与task本地化分析(源码阅读)

Spark中任务的处理也要考虑数据的本地性(locality),Spark目前支持PROCESS_LOCAL(本地进程)、NODE_LOCAL(本地节点)、NODE_PREF、RACK_LOCAL(本地机架)、ANY(任何)几种。其他都很好理解,NODE_LOCAL会在spark日志中执行拉取数据所执行的task时,打印出来,因为Spark是移动计算,而不是移动数据的嘛。

那么什么是NODE_PREF?

当Driver应用程序刚刚启动,Driver分配获得的Executor很可能还没有初始化,所以有一部分任务的本地化级别被设置为NO_PREF.如果是ShuffleRDD,其本地性始终为NO_PREF。这两种本地化级别是NO_PREF的情况,在任务分配时会被优先分配到非本地节点执行,达到一定的优化效果。

那么下来我们从job的任务提交开始玩起~

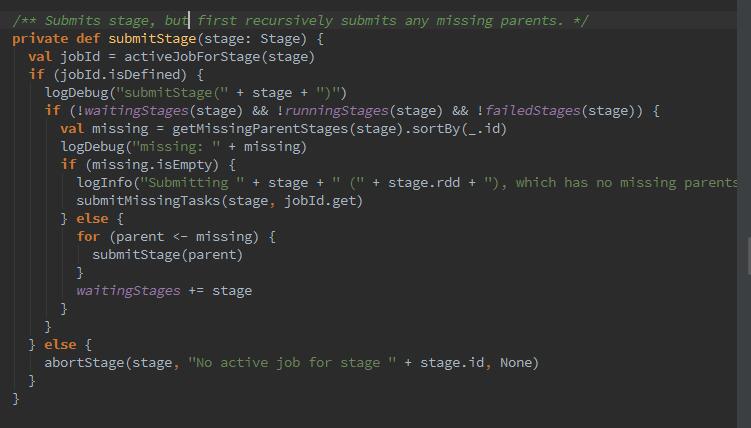

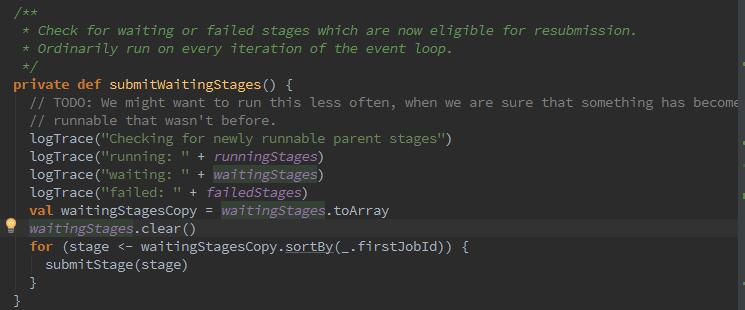

getMissingParentStages方法用来找到Stage的所有不可用的父Stage(宽依赖和窄依赖问题).从代码可以到这里是个递归的调用,submitWaitingStages实际上循环waitingStages中的stage并调用submitStaghe:

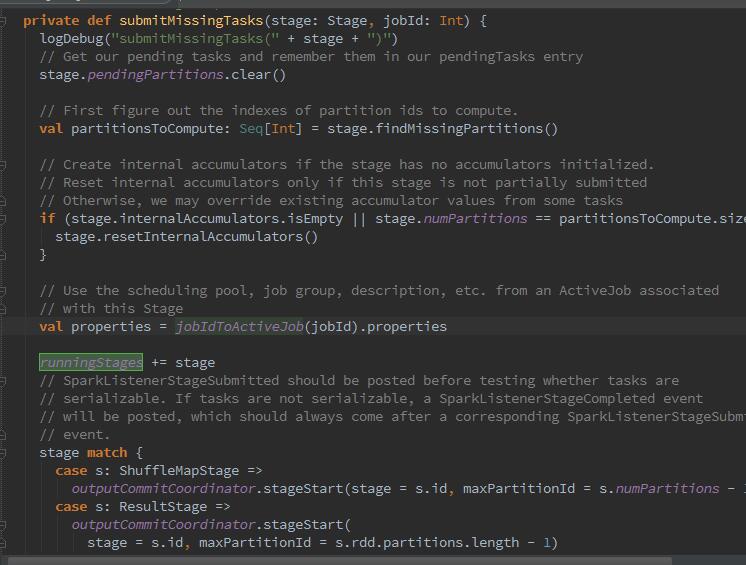

那么下来开始提交task,提交task的入口是submitMissingTasks,此函数在Stage没有可用的父stage时,被调用处理当前Stage未提交的任务。

1、那么在没有父stage时,会首先调用paendingPartitions.clear 用于清空pendingTasks.由于当前Stage的任务刚开始提交,所以需要清空,便于记录需要计算的任务。

2、将当前Stage加入运行中的Stage集合,是用HashSet进行构造的。

3、找出位计算的partition,如果Stage是map任务,那么outputLocs中partition对应的List为Nil,说明此partition还未计算。如果Stage不是map任务,那么需要获取stage的finalJob,调用finished方法判断每个partition的任务是否完成。

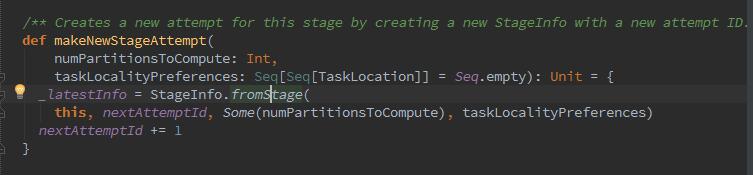

4、然后通过stage.makeNewStageAttemp,使用StageInfo.fromStage方法创建当前Stage的_latestInfo:

5、如果是Stage Map任务,那么序列化Stage的RDD及ShuffleDependency,如果Stage不是map任务,那么序列化Stage的RDD及resultOfJob的处理函数。最终这些序列化得到的字节数组需要用sc.broadcast进行广播。

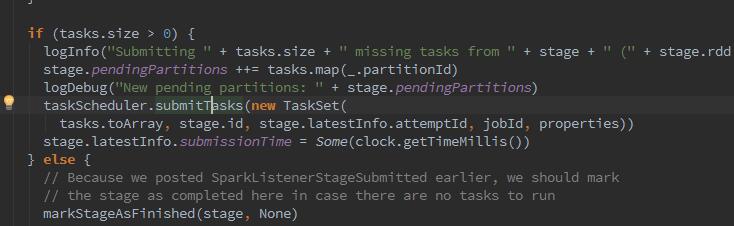

6、最后,创建所有Task、当前stage的id、jobId等信息创建TaskSet,并调用taskScheduler的submitTasks,批量提交Stage及其所有Task.

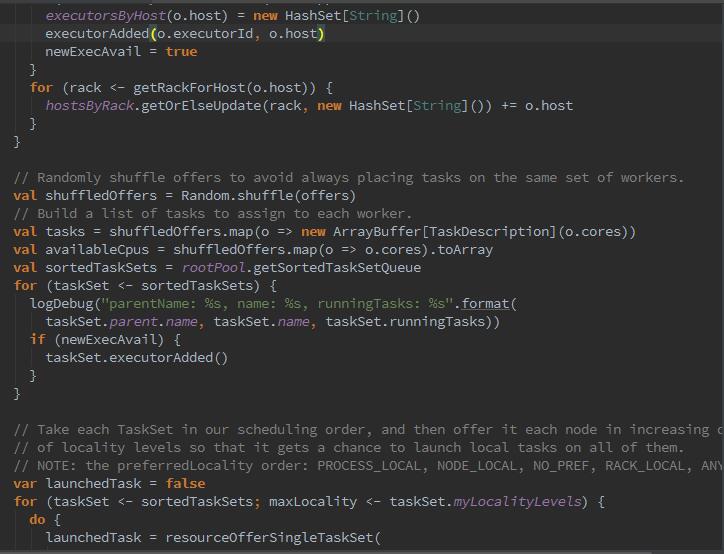

有可能同时有多个任务提交,所以就有了调度策略FIFO,那么下来调用LocalBackend的reviveOffers方法,向local-Actor发送ReviveOffers消息。localActor对ReviveOffers消息的匹配执行reviveOffers方法。调用TaskSchedulerImpl的resourceOffers方法分配资源,最后调用Executor的launchTask方法运行任务。

同时你会发现,这里有段代码,shuffleOffers = Random.shuffle(offers),是为了计算资源的分配与计算,对所有WorkerOffer随机洗牌,避免将任务总是分配给同样的WorkerOffer。

好了,知道了整个流程,下来我们来看一下本地化问题:

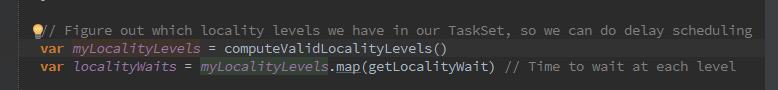

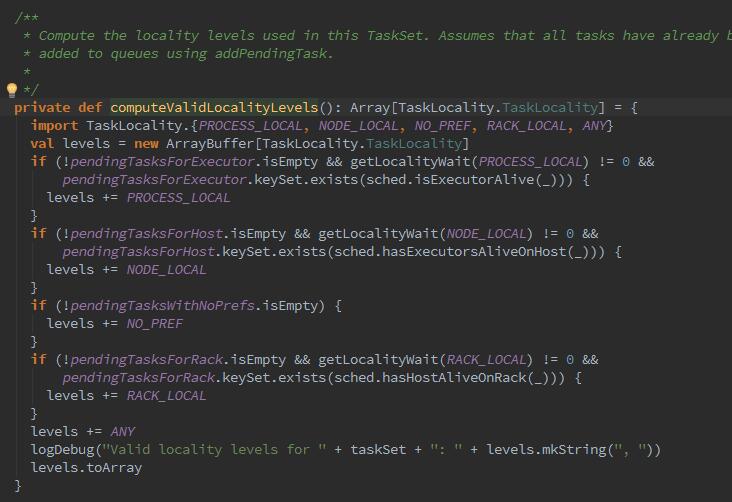

myLocalityLevles:当前TaskSetManager允许使用的本地化级别。那么这里的computeValidLocalityLevels方法是用于计算有效的本地化缓存级别。如果存在Executor中的有待执行的任务,且PROCESS_LOCAL本地化的等待时间不为0,且存在Executor已被激活,那么允许的本地化级别里包括PROCESS_LOCAL.

这里又发现新大陆,获取各个本地化级别的等待时间。

spark.locality.wait 本地化级别的默认等待时间

spark.locality.wait.process 本地进程的等待时间

spark.locality.wait.node 本地节点的等待时间

spark.locality.wait.rack 本地机架的等待时间

这些参数呢,在任务的运行很长且数量很多的情况下,适当调高这些参数可以显著提高性能,然而当这些参数值都已经超过任务的运行时长时,则需要调小这些参数。任何任务都希望被分配到可以从本地读取数据的节点上以得到最大的性能提升,然而每个任务的运行时长时不可预计的。当一个任务在分配时,如果没有满足最佳本地化(PROCESS_LOCAL)的资源时,如果固执的期盼得到最佳的资源,很可能被已经占用最佳资源但是运行时间很长的任务耽误,所以这些代码实现了当没有最佳本地化时,选择稍差点的资源。

Spark Job的提交与task本地化分析(源码阅读)的更多相关文章

- Spark Job的提交与task本地化分析(源码阅读八)

我们又都知道,Spark中任务的处理也要考虑数据的本地性(locality),Spark目前支持PROCESS_LOCAL(本地进程).NODE_LOCAL(本地节点).NODE_PREF.RACK_ ...

- Spark BlockManager的通信及内存占用分析(源码阅读九)

之前阅读也有总结过Block的RPC服务是通过NettyBlockRpcServer提供打开,即下载Block文件的功能.然后在启动jbo的时候由Driver上的BlockManagerMaster对 ...

- vuex源码阅读分析

这几天忙啊,有绝地求生要上分,英雄联盟新赛季需要上分,就懒着什么也没写,很惭愧.这个vuex,vue-router,vue的源码我半个月前就看的差不多了,但是懒,哈哈.下面是vuex的源码分析在分析源 ...

- Spark源码阅读之存储体系--存储体系概述与shuffle服务

一.概述 根据<深入理解Spark:核心思想与源码分析>一书,结合最新的spark源代码master分支进行源码阅读,对新版本的代码加上自己的一些理解,如有错误,希望指出. 1.块管理器B ...

- Flink源码分析 - 源码构建

原文地址:https://mp.weixin.qq.com/s?__biz=MzU2Njg5Nzk0NQ==&mid=2247483692&idx=1&sn=18cddc1ee ...

- 【Azure 应用服务】Azure Function App使用SendGrid发送邮件遇见异常消息The operation was canceled,分析源码逐步最终源端

问题描述 在使用Azure Function App的SendGrid Binging功能,调用SendGrid服务器发送邮件功能时,有时候遇见间歇性,偶发性异常.在重新触发SendGrid部分的Fu ...

- 鸿蒙内核源码分析(源码结构篇) | 内核每个文件的含义 | 百篇博客分析OpenHarmony源码 | v18.04

百篇博客系列篇.本篇为: v18.xx 鸿蒙内核源码分析(源码结构篇) | 内核每个文件的含义 | 51.c.h .o 前因后果相关篇为: v08.xx 鸿蒙内核源码分析(总目录) | 百万汉字注解 ...

- java分析源码-ReentrantLock

一.前言 在分析了 AbstractQueuedSynchronier 源码后,接着分析ReentrantLock源码,其实在 AbstractQueuedSynchronizer 的分析中,已经提到 ...

- easyloader [easyui_1.4.2] 分析源码,妙手偶得之

用easyui很久了,但是很少去看源码. 有解决不了的问题就去百度... 今日发现,easyui的源码不难懂. 而且结合 easyloader 可以非常方便的逐个研究easyui的组件. 但是, ea ...

随机推荐

- Exynos4412交叉编译环境搭建

Exynos4412交叉编译环境搭建 交叉编译:在PC机(x86平台)上开发程序,在ARM板上运行,提高开发.编译速度. 环境: Tiny4412SDK1506开发板 需要软件: arm-linux- ...

- Codeforces Round #432 Div. 1 C. Arpa and a game with Mojtaba

首先容易想到,每种素数是独立的,相互sg就行了 对于一种素数来说,按照的朴素的mex没法做... 所以题解的简化就是数位化 多个数同时含有的满参数因子由于在博弈中一同变化的,让他们等于相当于,那么这样 ...

- 搭建web服务器-tomcat+apache+mysql+eclipse

1. 下载并安装jdk 注意环境变量的配置: java_home: jdk的路径 path:.;%java_home%\bin;%java_home%\jre\bin classpath : .; ...

- 含隐变量模型求解——EM算法

1 EM算法的引入1.1 EM算法1.2 EM算法的导出2 EM算法的收敛性3EM算法在高斯混合模型的应用3.1 高斯混合模型Gaussian misture model3.2 GMM中参数估计的EM ...

- TC命令流量控制测试(针对具体IP和具体进程)

TC命令流量控制测试 这里测试系统为Linux操作系统,通过简单的TC命令来实现对带宽的控制. 1对具体IP地址的流量控制 这里采用iperf来进行带宽的测试,首先在服务器和客户端都安装上iperf软 ...

- 清除input[type=number]的默认样式

input[type=number] { -moz-appearance:textfield; } input[type=number]::-webkit-inner-spin-button, inp ...

- SDP(12): MongoDB-Engine - Streaming

在akka-alpakka工具包里也提供了对MongoDB的stream-connector,能针对MongoDB数据库进行streaming操作.这个MongoDB-connector里包含了Mon ...

- java如何输入数据

Java程序开发过程中,需要从键盘获取输入值是常有的事,但Java它偏偏就没有像c语言给我们提供的scanf(),C++给我们提供的cin()获取键盘输入值的现成函数!Java没有提供这样的函数也不代 ...

- Spark2.1.0官方文档

Spark 概述 Apache Spark是一个快速和通用的集群计算系统.它提供Java,scala,Python.R语言的APIs,以及支持一般执行图形的优化引擎. 它还支持一组丰富的高级工具,包括 ...

- redis笔记总结之redis数据类型及常用命令

三.常用命令 3.1 字符串类型(string) 字符串类型是Redis中最基本的数据类型,一个字符串类型的键允许存储的数据的最大容量为512MB. 3.1.1 赋值与取值: SET key valu ...