Scrapy-redis<数据库篇>

scrapy-redis爬虫数据库连接部分——windows准备做salve,Linux准备做master开展工作

首先处理简单的windows熟悉的环境——安装Redis服务和Redis可视化~可视化也可以省略,但作为新手推荐使用:

1、安装redis服务:链接: https://pan.baidu.com/s/1EA0I-gx9NEU78vjZeZVqJA 提取码: 4s4i ——直接next下去

2、安装redis可视化:链接: https://pan.baidu.com/s/1KQh_g2o0tQijHQRFpKjcng 提取码: ny9c

安装redis可视化~:

1、确保redis安装完成,确保redis服务正常开启

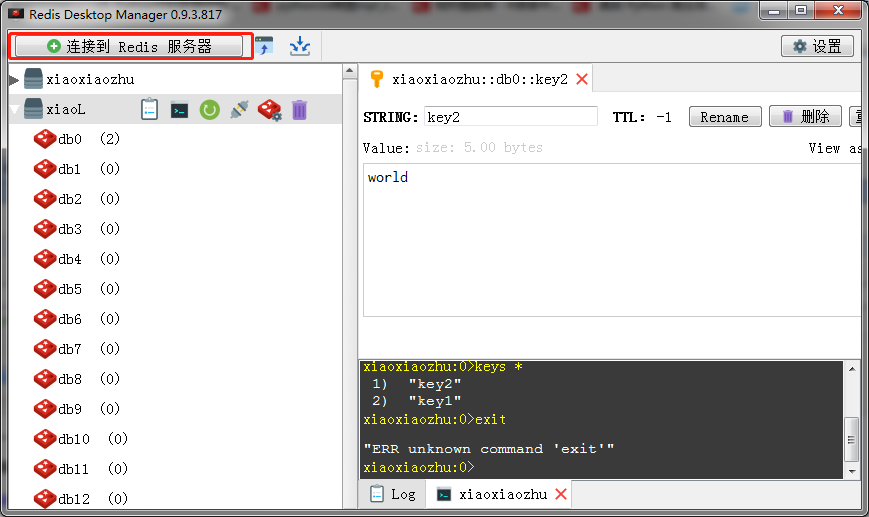

2、正常打开界面:

名字自定义~

验证为redis的密码~安装之后默认是空的就是这个——requirepass,直接连接,即可连接上windows本地的redis数据库

然后进行测试即可,测试详细内容百度。

不安装可视化的~就直接redis操作即可。

接下来是Linux服务里面安装redis:https://redis.io/download

安装完之后~直接进入redis-5.0.4文件夹:cd redis-5.0.4——>修改redis.conf文件:gedit redis.conf

修改三个属性:1.注释bind 127.0.0.1,以便其它ip访问,2.修改protected-mode yes,该改为no,3.设置密码 requirepass,默认是注释掉的,打开后设置密码。Over!

然后开始服务:sec/redis-server redis.conf

如果访问不了:

1、在linux下的防火墙中开放6379端口(与centos7以下版本开放端口的方式有区别):firewall-cmd --zone=public --add-port=6379/tcp --permanent

2、重启防火墙:systemctl restart firewalld

3、启动redis:src/redis-server redis.conf

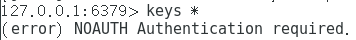

此时开始测试:打开另一个黑窗口,进入redis文件夹,输入:src/redis-cli,回车,先输入keys *,出现: ,则输入你的密码即可:auth "密码";

,则输入你的密码即可:auth "密码";

这时候无错误情况下Linux下的Redis安装完成。

直接进入RedisDesktop里面连接服务,需要输入Linux的ip地址,Linux的ip地址查询:ifconfig -a ,windows的ip地址查询:ipconfig;

名字自取——ip地址输入——端口输入正确,无改变的情况下是6379——输入redis设置的密码;

结束windows下连接Linux下redis服务

Scrapy-redis<数据库篇>的更多相关文章

- 基于Python,scrapy,redis的分布式爬虫实现框架

原文 http://www.xgezhang.com/python_scrapy_redis_crawler.html 爬虫技术,无论是在学术领域,还是在工程领域,都扮演者非常重要的角色.相比于其他 ...

- Scrapy+redis实现分布式爬虫

概述 什么是分布式爬虫 需要搭建一个由n台电脑组成的机群,然后在每一台电脑中执行同一组程序,让其对同一网络资源进行联合且分布的数据爬取. 原生Scrapy无法实现分布式的原因 原生Scrapy中调度器 ...

- scrapy+redis去重实现增量抓取

class ProjectnameDownloaderMiddleware(object): # Not all methods need to be defined. If a method is ...

- 爬虫--scrapy+redis分布式爬取58同城北京全站租房数据

作业需求: 1.基于Spider或者CrawlSpider进行租房信息的爬取 2.本机搭建分布式环境对租房信息进行爬取 3.搭建多台机器的分布式环境,多台机器同时进行租房数据爬取 建议:用Pychar ...

- Redis与Scrapy

Redis与Scrapy Redis与Scrapy Redis is an open source, BSD licensed, advanced key-value cache and store. ...

- python - scrapy 爬虫框架 ( redis去重 )

1. 使用内置,并加以修改 ( 自定义 redis 存储的 keys ) settings 配置 # ############### scrapy redis连接 ################# ...

- Python分布式爬虫打造搜索引擎完整版-基于Scrapy、Redis、elasticsearch和django打造一个完整的搜索引擎网站

Python分布式爬虫打造搜索引擎 基于Scrapy.Redis.elasticsearch和django打造一个完整的搜索引擎网站 https://github.com/mtianyan/Artic ...

- scrapy简单分布式爬虫

经过一段时间的折腾,终于整明白scrapy分布式是怎么个搞法了,特记录一点心得. 虽然scrapy能做的事情很多,但是要做到大规模的分布式应用则捉襟见肘.有能人改变了scrapy的队列调度,将起始的网 ...

- 第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询 1.elasticsearch(搜索引擎)的查询 elasticsearch是功能 ...

- 四十四 Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

1.elasticsearch(搜索引擎)的查询 elasticsearch是功能非常强大的搜索引擎,使用它的目的就是为了快速的查询到需要的数据 查询分类: 基本查询:使用elasticsearch内 ...

随机推荐

- Log4j2中RollingFile的文件滚动更新机制

一.什么是RollingFile RollingFileAppender是Log4j2中的一种能够实现日志文件滚动更新(rollover)的Appender. rollover的意思是当满足一定条件( ...

- 在本地没有安装Oracle的情况下,使用plsql远程连接数据库

远程连接数据库的方式不止一种.这里主要写在本地没有安装Oracle的情况下,使用plsql可视化工具远程连接数据库的方式. 一.前提 首先你本地得安装有plsql工具.具体的安装步骤就不多说了. 二. ...

- BZOJ_2038_[2009国家集训队]小Z的袜子(hose)_莫队

BZOJ_2038_[2009国家集训队]小Z的袜子(hose)_莫队 Description 作为一个生活散漫的人,小Z每天早上都要耗费很久从一堆五颜六色的袜子中找出一双来穿.终于有一天,小Z再也无 ...

- 【毕业原版】-《伦敦艺术大学毕业证书》UAL一模一样原件

☞伦敦艺术大学毕业证书[微/Q:865121257◆WeChat:CC6669834]UC毕业证书/联系人Alice[查看点击百度快照查看][留信网学历认证&博士&硕士&海归& ...

- 开发教程(四) MIP组件平台使用说明

组件审核平台用于上传 MIP 组件.经过自动校验之后,提交审核,通过审核的组件会定时推送到线上,供网站使用. 平台地址:https://www.mipengine.org/platform/ 1. 使 ...

- Linux上删除大量文件几种方式对比

目录 Linux上删除大量文件几种方式对比 1. rm删除:因为文件数量太多,rm无法删除(报错) 2. find查找删除:-exec 3. find查找删除:xargs 4. find调用-dele ...

- Python全国二级等级考试(2019)

一.前言 2018年9月随着全国计算机等级考试科目中加入“二级Python”,也确立了Python在国内的地位,猪哥相信Python语言势必会像PS那般普及.不久的将来,谁会Python谁就能获得女神 ...

- Protobuf 语言指南(proto3)

Protobuf 语言指南(proto3) Protocol Buffer是Google的语言中立的,平台中立的,可扩展机制的,用于序列化结构化数据 - 对比XML,但更小,更快,更简单.您可以定义数 ...

- final 关键字与安全发布 多线程中篇(十三)

final的通常理解 在Java中,final关键字可以用来修饰类.方法和变量(包括成员变量和局部变量) 大家应该都知道final表示最终的.最后的含义,也就是不能在继续 修饰类表示不能继承,修饰方法 ...

- 重学前端 --- Promise里的代码为什么比setTimeout先执行?

首先通过一段代码进入讨论的主题 var r = new Promise(function(resolve, reject){ console.log("a"); resolve() ...