TensorFlow笔记-03-张量,计算图,会话

TensorFlow笔记-03-张量,计算图,会话

- 搭建你的第一个神经网络,总结搭建八股

- 基于TensorFlow的NN:用张量表示数据,用计算图搭建神经网络,用会话执行计算图,优化线上的权重(参数),得到模型

- 张量(tensor):多维数组(列表)

- 阶:表示张量的维数

·· 维 数 ···· 阶 ········· 名 字 ········· 例 子 ············

·· 0-D ······ 0 ····· 标量 scalar ···· s=1 2 3

·· 1-D ······ 0 ····· 向量 vector ···· s=[1,2,3]

·· 2-D ······ 0 ····· 矩阵 matrix ···· s=[ [1,2,3], [4,5,6],[7,8,9] ]

·· n-D ······ 0 ····· 标量 tensor ···· s=[[[[[....n个

- 张量可以表示0阶到n阶的数组(列表)

- **数据类型:Tensorflow 的数据类型有 tf.float32,tf.int32 等

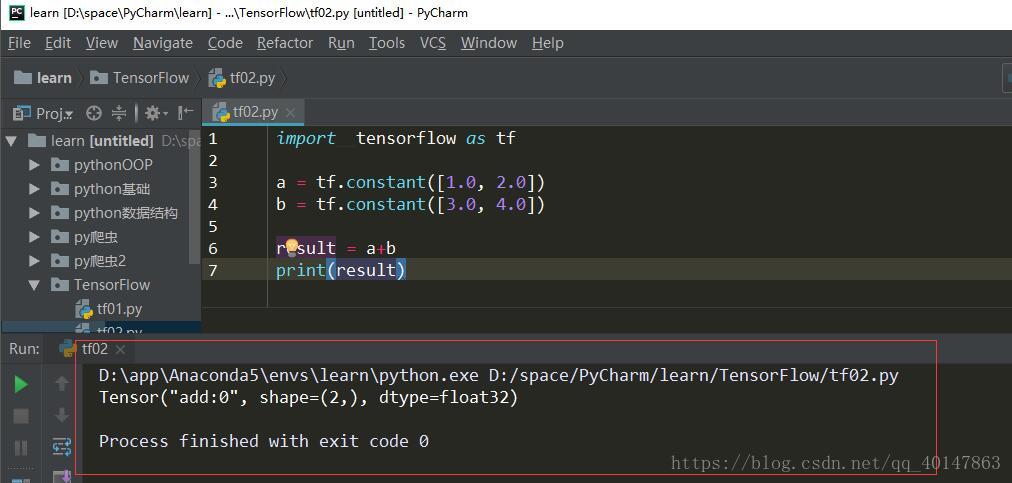

案例:两个张量的加法

# 两个张量的加法

import tensorflow as tf

a = tf.constant([1.0, 2.0])

b = tf.constant([3.0, 4.0])

result = a+b

print(result)

运行结果:

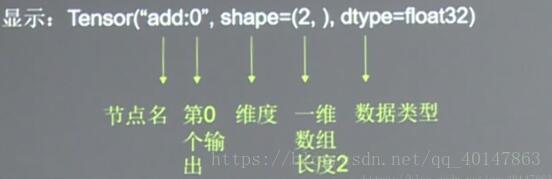

- 结果分析:

计算图

计算图(Graph):搭建神经网络的计算过程,是承载一个或多个计算机结点的一张图,只搭建网络,不运算

这里要提到另一个概念:神经元 (不是很好理解,慢慢就懂了)

神经网络的基本模型的神经元,神经元的基本模型其实就是数学中的乘加运算

我们搭建如下计算图:

X1,X2 表示输入,W1,W2分别是X1到X2的权重

该计算图表示:y = X1W1 + X2W2

(不能理解就记住,该计算图表示上面的这种含义)

# 两个张量的加法

import tensorflow as tf

# x 是一个一行两列的张量

x = tf.constant([[1.0, 2.0]])

# x 是一个两行一列的张量

w = tf.constant([[3.0], [4.0]])

'''

构建计算图,但不运算

y = XW

= x1*w1 + x2*w2

'''

# 矩阵相乘

y = tf.matmul(x, w)

print(y)

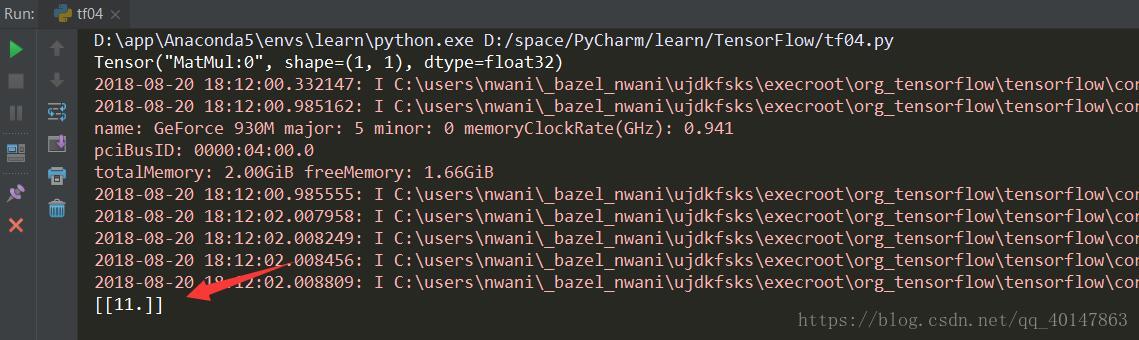

运行结果

Tensor("MatMul:0", shape=(1, 1), dtype=float32)

会话

- 会话(Session):执行计算图中的结点运算

- 我们用 with 结构实现,语法如下:

with tf.Session() as sess :

print(sess.run(y))

意思是:将 tf.Session 记为 sess,调用 tf.Session 下的 run 方法执行 y,y 也就是上面的计算图,也就是那个表达式

# 两个张量的加法

import tensorflow as tf

# x 是一个一行两列的张量

x = tf.constant([[1.0, 2.0]])

# x 是一个两行一列的张量

w = tf.constant([[3.0], [4.0]])

'''

构建计算图,但不运算

y = XW

= x1*w1 + x2*w2

'''

# 矩阵相乘

y = tf.matmul(x, w)

print(y)

# 会话:执行节点运算

with tf.Session() as sess:

print(sess.run(y))

运行结果

- y = 1.03.0 + 2.04.0 = 11

- 我们可以看到打印出了运算结果

更多文章:Tensorflow 笔记

- 本笔记不允许任何个人和组织转载

TensorFlow笔记-03-张量,计算图,会话的更多相关文章

- 吴裕雄 python 神经网络——TensorFlow 图、张量及会话

import tensorflow as tf g1 = tf.Graph() with g1.as_default(): v = tf.get_variable("v", [1] ...

- 20180929 北京大学 人工智能实践:Tensorflow笔记03

更改的程序部分如下: 另: 难?????????????见链接: https://www.bilibili.com/video/av22530538/?p=17 + (完)

- Tensorflow 笔记

TensorFlow笔记-08-过拟合,正则化,matplotlib 区分红蓝点 TensorFlow笔记-07-神经网络优化-学习率,滑动平均 TensorFlow笔记-06-神经网络优化-损失函数 ...

- 20180929 北京大学 人工智能实践:Tensorflow笔记04

20180929 北京大学 人工智能实践:Tensorflow笔记03(2018-09-30 00:01)

- TensorFlow 中的张量,图,会话

tensor的含义是张量,张量是什么,听起来很高深的样子,其实我们对于张量一点都不陌生,因为像标量,向量,矩阵这些都可以被认为是特殊的张量.如下图所示: 在TensorFlow中,tensor实际上就 ...

- TensorFlow笔记-06-神经网络优化-损失函数,自定义损失函数,交叉熵

TensorFlow笔记-06-神经网络优化-损失函数,自定义损失函数,交叉熵 神经元模型:用数学公式比表示为:f(Σi xi*wi + b), f为激活函数 神经网络 是以神经元为基本单位构成的 激 ...

- TensorFlow笔记-04-神经网络的实现过程,前向传播

TensorFlow笔记-04-神经网络的实现过程,前向传播 基于TensorFlow的NN:用张量表示数据,用计算图搭建神经网络,用会话执行计算图,优化线上的权重(参数),得到模型 张量(tenso ...

- TensorFlow笔记-01-开篇概述

人工智能实践:TensorFlow笔记-01-开篇概述 从今天开始,从零开始学习TensorFlow,有相同兴趣的同志,可以互相学习笔记,本篇是开篇介绍 Tensorflow,已经人工智能领域的一些名 ...

- TensorFlow笔记-05-反向传播,搭建神经网络的八股

TensorFlow笔记-05-反向传播,搭建神经网络的八股 反向传播 反向传播: 训练模型参数,在所有参数上用梯度下降,使用神经网络模型在训练数据上的损失函数最小 损失函数:(loss) 计算得到的 ...

随机推荐

- android--------验证码倒计时

在我们注册或者修改信息的时候,常会用到60s倒计时这个功能,写了这篇文章,大家共享一下: 效果图: 直接上代码: activity.java public class MainActivity ext ...

- hdu1864(01包)

最大报销额 Time Limit: 1000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others)Total Submi ...

- hibernate一级缓存和二级缓存的区别

http://blog.csdn.net/defonds/article/details/2308972 缓存是介于应用程序和物理数据源之间,其作用是为了降低应用程序对物理数据源访问的频次,从而提高了 ...

- vs2015 系统找不到指定的文件(异常来自HRESULT:0x80070002)问题的解决方法

vs2015 创建mvc项目时,弹出错误信息内容(系统找不到指定的文件(异常来自HRESULT:0x80070002)) 弹出窗体如下图所示: 导致整个原因是:未安装NuGet包 解决方法: 1)打开 ...

- hadoop hive install (5)

reference : http://dblab.xmu.edu.cn/blog/install-hive/ http://dblab.xmu.edu.cn/blog/hive-in-practice ...

- vue + element-ui Table的数据多选,多页选择数据回显,分页记录保存选中的数据。

业务的需要:我要对与会人员勾选,记录所选的与会人员,并且点击到别的页面上时也要记录所勾选的.第一次尝试,每次点击下一页数据都会清空.然后我就去element ui官网查看了api.实现如下: 在tab ...

- Java——多线程面试问题

body, table{font-family: 微软雅黑; font-size: 10pt} table{border-collapse: collapse; border: solid gray; ...

- 2018-2019-2 网络对抗技术 20165202 Exp4 恶意代码分析

博客目录 一.实践目标 二.实践内容 1.系统运行监控 2.恶意软件分析 三.实验步骤 四.基础问题回答 五.遇到的问题及解决 六.实验总结 一.实践目标 监控你自己系统的运行状态,看有没有可疑的程序 ...

- 逆向路由器固件之SQL注入 Part3

另寻他径 在前面的内容中,我们使用TEW-654TR路由器的tftp服务实现了获取目标的管理权限.但是要是tftp没有开放到外网怎么办?另寻他径:在这一篇中会我们来分析一个web应用上的漏洞. 初步分 ...

- UITableViewCell的高度与UILabel自适应

UITableViewCell内部只放了一个UILabel,Cell的高度随着UILabel内容的高度变化而变化,可重写UITableView的委托方法动态调整高度,还要设置UILabel.numbe ...