Hadoop实战:reduce端实现Join

项目描述

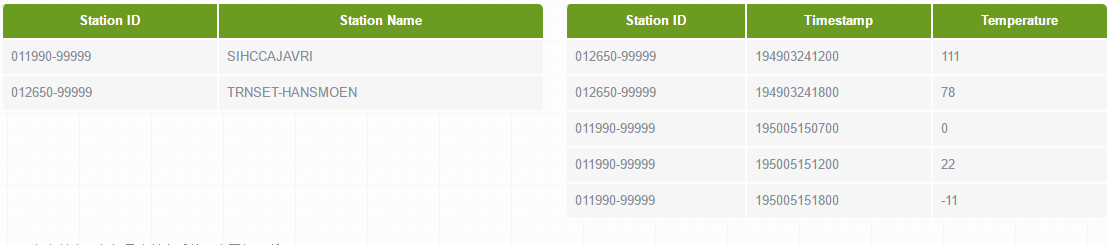

现在假设有两个数据集:气象站数据库和天气记录数据库,并考虑如何合二为一。一个典型的查询是:输出气象站的历史信息,同时各行记录也包含气象站的元数据信息。

气象站和天气记录合并之后的示意图如下所示。

测试数据

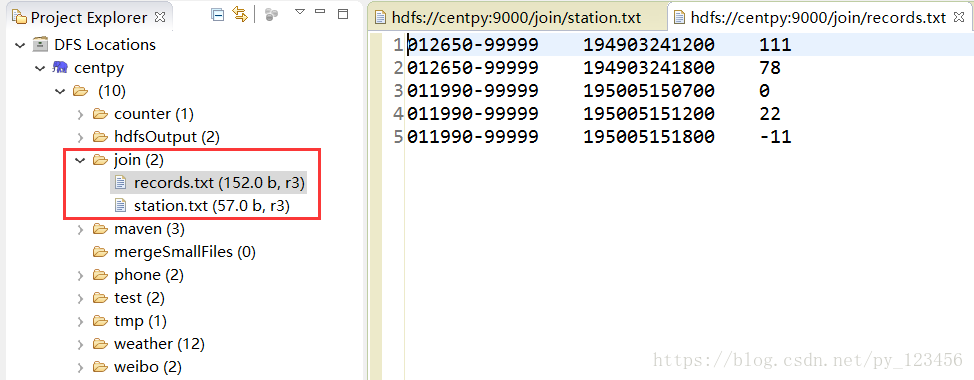

启动Hadoop集群,然后在hdfs中创建join文件夹用于存放测试数据station.txt和records.txt,他们分别代表气象站数据库和天气记录数据库。

项目代码

JoinStationMapper.java

package com.hadoop.Join; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; /**

* @author Zimo

*

*/

public class JoinStationMapper extends Mapper<LongWritable,Text,TextPair,Text>

{

protected void map(LongWritable key,Text value,Context context) throws IOException,InterruptedException

{

String line = value.toString();

String[] arr = line.split("\\s+");//解析气象站数据

int length = arr.length;

if(length==)

{//满足这种数据格式

//key=气象站id value=气象站名称

System.out.println("station="+arr[]+"");

context.write(new TextPair(arr[],""),new Text(arr[]));

}

}

}

JoinRecordMapper.java

package com.hadoop.Join; import java.io.IOException; import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper; /**

* @author Zimo

*

*/

public class JoinRecordMapper extends Mapper<LongWritable,Text,TextPair,Text>

{

protected void map(LongWritable key,Text value,Context context) throws IOException,InterruptedException

{

String line = value.toString();

String[] arr = line.split("\\s+",);//解析天气记录数据

int length = arr.length;

if(length==){

//key=气象站id value=天气记录数据

context.write(new TextPair(arr[],""),new Text(arr[]));

}

}

}

TextPair.java

package com.hadoop.Join; import java.io.*;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.WritableComparable; /**

* @author Zimo

*

*/

public class TextPair implements WritableComparable<TextPair>

{

private Text first; //Text 类型的实例变量first

private Text second;//Text 类型的实例变量second public TextPair() //无参构造方法

{

set(new Text(),new Text());

}

public TextPair(String first,String second) // Sting类型参数的构造方法

{

set(new Text(first),new Text(second));

}

public TextPair(Text first,Text second) // Text类型参数的构造方法

{

set(first,second);

}

public void set(Text first,Text second) //set方法

{

this.first=first;

this.second=second;

}

public Text getFirst() //getFirst方法

{

return first;

}

public Text getSecond() //getSecond方法

{

return second;

} //将对象转换为字节流并写入到输出流out中

@Override //------------ 序列化

public void write(DataOutput out) throws IOException //write方法

{

first.write(out);

second.write(out);

} //从输入流in中读取字节流反序列化为对象

@Override //------------反 序列化

public void readFields(DataInput in) throws IOException //readFields方法

{

first.readFields(in);

second.readFields(in);

} @Override

public int hashCode() //在mapreduce中,通过hashCode来选择reduce分区

{

return first.hashCode() *163+second.hashCode();

} @Override

public boolean equals(Object o) //equals方法,这里是两个对象的内容之间比较

{

if (o instanceof TextPair)

{

TextPair tp=(TextPair) o;

return first.equals(tp.first) && second.equals(tp.second);

}

return false;

} @Override

public String toString() //toString方法

{

return first +"\t"+ second;

}

@Override

public int compareTo(TextPair o)

{

// TODO Auto-generated method stub

if(!first.equals(o.first))

{

return first.compareTo(o.first);

}

else if(!second.equals(o.second))

{

return second.compareTo(o.second);

}

return 0;

} }

JoinReducer.java

package com.hadoop.Join; import java.io.IOException; import java.util.Iterator; import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer; /**

* @author Zimo

*

*/

public class JoinReducer extends Reducer< TextPair,Text,Text,Text>

{

protected void reduce(TextPair key, Iterable< Text> values,Context context) throws IOException,InterruptedException

{

Iterator< Text> iter = values.iterator();

Text stationName = new Text(iter.next());//气象站名称

while(iter.hasNext()){

Text record = iter.next();//天气记录的每条数据

Text outValue = new Text(stationName.toString()+"\t"+record.toString());

context.write(key.getFirst(),outValue);

}

}

}

JoinRecordWithStationName.java

package com.hadoop.Join; import java.io.InputStream;

import org.apache.hadoop.util.Tool;

import java.io.OutputStream;

import java.util.Set; import javax.lang.model.SourceVersion; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.conf.Configured;

import org.apache.hadoop.fs.FileSystem;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.io.WritableComparable;

import org.apache.hadoop.io.WritableComparator; import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Partitioner;

import org.apache.hadoop.mapreduce.lib.input.MultipleInputs;

import org.apache.hadoop.mapreduce.lib.input.TextInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.ToolRunner; /**

* @author Zimo

*

*/

public class JoinRecordWithStationName extends Configured implements Tool

{

public static class KeyPartitioner extends Partitioner< TextPair,Text>

{ public int getPartition(TextPair key,Text value,int numPartitions)

{

return (key.getFirst().hashCode()&Integer.MAX_VALUE) % numPartitions;

}

} public static class GroupingComparator extends WritableComparator

{

protected GroupingComparator()

{

super(TextPair.class,true);

}

@Override

public int compare(WritableComparable w1,WritableComparable w2)

{

TextPair ip1=(TextPair) w1;

TextPair ip2=(TextPair) w2;

Text l=ip1.getFirst();

Text r=ip2.getFirst();

return l.compareTo(r); }

}

public int run(String[] args) throws Exception

{

Configuration conf = new Configuration();// 读取配置文件 Path mypath=new Path(args[]);

FileSystem hdfs=mypath.getFileSystem(conf);

if (hdfs.isDirectory(mypath))

{

hdfs.delete(mypath,true);

} Job job = Job.getInstance(conf,"join");// 新建一个任务

job.setJarByClass(JoinRecordWithStationName.class);// 主类 Path recordInputPath = new Path(args[]);//天气记录数据源,这里是牵扯到多路径输入和多路径输出的问题。默认是从args[0]开始

Path stationInputPath = new Path(args[]);//气象站数据源

Path outputPath = new Path(args[]);//输出路径 //若只有一个输入和一个输出,则输入是args[0],输出是args[1]。

//若有两个输入和一个输出,则输入是args[0]和args[1],输出是args[2] MultipleInputs.addInputPath(job,recordInputPath,TextInputFormat.class,JoinRecordMapper.class);//读取天气记录Mapper

MultipleInputs.addInputPath(job,stationInputPath,TextInputFormat.class,JoinStationMapper.class);//读取气象站Mapper

FileOutputFormat.setOutputPath(job,outputPath);

job.setReducerClass(JoinReducer.class);// Reducer

job.setNumReduceTasks(); job.setPartitionerClass(KeyPartitioner.class);//自定义分区

job.setGroupingComparatorClass(GroupingComparator.class);//自定义分组 job.setMapOutputKeyClass(TextPair.class);

job.setMapOutputValueClass(Text.class); job.setOutputKeyClass(Text.class);

job.setOutputValueClass(Text.class); return job.waitForCompletion(true)?:;

} public static void main(String[] args) throws Exception

{

String[] args0={"hdfs://centpy:9000/join/records.txt"

,"hdfs://centpy:9000/join/station.txt"

,"hdfs://centpy:9000/join/out"

};

int exitCode=ToolRunner.run( new JoinRecordWithStationName(), args0);

System.exit(exitCode);

}

}

以上就是博主为大家介绍的这一板块的主要内容,这都是博主自己的学习过程,希望能给大家带来一定的指导作用,有用的还望大家点个支持,如果对你没用也望包涵,有错误烦请指出。如有期待可关注博主以第一时间获取更新哦,谢谢!

版权声明:本文为博主原创文章,未经博主允许不得转载。

Hadoop实战:reduce端实现Join的更多相关文章

- 第2节 mapreduce深入学习:15、reduce端的join算法的实现

reduce端的join算法: 例子: 商品表数据 product: pidp0001,小米5,1000,2000p0002,锤子T1,1000,3000 订单表数据 order: pid ...

- hadoop的压缩解压缩,reduce端join,map端join

hadoop的压缩解压缩 hadoop对于常见的几种压缩算法对于我们的mapreduce都是内置支持,不需要我们关心.经过map之后,数据会产生输出经过shuffle,这个时候的shuffle过程特别 ...

- Hadoop on Mac with IntelliJ IDEA - 10 陆喜恒. Hadoop实战(第2版)6.4.1(Shuffle和排序)Map端 内容整理

下午对着源码看陆喜恒. Hadoop实战(第2版)6.4.1 (Shuffle和排序)Map端,发现与Hadoop 1.2.1的源码有些出入.下面作个简单的记录,方便起见,引用自书本的语句都用斜体表 ...

- 升级版:深入浅出Hadoop实战开发(云存储、MapReduce、HBase实战微博、Hive应用、Storm应用)

Hadoop是一个分布式系统基础架构,由Apache基金会开发.用户可以在不了解分布式底层细节的情况下,开发分布式程序.充分利用集群的威力高速运算和存储.Hadoop实现了一个分布式文件系 ...

- Hadoop实战之三~ Hello World

本文介绍的是在Ubuntu下安装用三台PC安装完成Hadoop集群并运行好第一个Hello World的过程,软硬件信息如下: Ubuntu:12.04 LTS Master: 1.5G RAM,奔腾 ...

- 王家林的“云计算分布式大数据Hadoop实战高手之路---从零开始”的第十一讲Hadoop图文训练课程:MapReduce的原理机制和流程图剖析

这一讲我们主要剖析MapReduce的原理机制和流程. “云计算分布式大数据Hadoop实战高手之路”之完整发布目录 云计算分布式大数据实战技术Hadoop交流群:312494188,每天都会在群中发 ...

- Hadoop实战实例

Hadoop实战实例 Hadoop实战实例 Hadoop 是Google MapReduce的一个Java实现.MapReduce是一种简化的分布式编程模式,让程序自动分布 ...

- Haoop MapReduce 的Partition和reduce端的二次排序

先贴一张原理图(摘自hadoop权威指南第三版) 实际中看了半天还是不太理解其中的Partition,和reduce端的二次排序,最终根据实验来结果来验证自己的理解 1eg 数据如下 20140101 ...

- Hadoop经典案例(排序&Join&topk&小文件合并)

①自定义按某列排序,二次排序 writablecomparable中的compareto方法 ②topk a利用treemap,缺点:map中的key不允许重复:https://blog.csdn.n ...

随机推荐

- 对象流demo1----

对象流demo1: package com.etc.test; import java.io.BufferedInputStream; import java.io.BufferedOutputStr ...

- angular项目线上地址跳转或刷新报错的解决

引用地址:https://blog.csdn.net/qq_35415307/article/details/80707463 本地ng项目没问题,到了线上跳转刷新都会报404错误,相信这个问题每个做 ...

- Python-RabbitMQ消息队列的发布与订阅

RabbitMQ消息队列的发布与订阅类似于广播,一端发送消息,多个客户端可以同时接收到消息 fanout:所有绑定到exchange的queue都可以接收消息 消息发布端 # -*- coding:u ...

- C++知识点总结(二)

1.字符串的部分拷贝 ① 利用标准库函数strncpy(),可以将一字符串的一部分拷贝到另一个字符串中.strncpy()函数有3个参数:第一个参数是目录字符串:第二个参 数是源字符串:第三个参数是一 ...

- Android的系统结构简述

(该图片来自网络) Android系统结构主要分为四层,从上到下依次为,Application层,Application Framework层,lib层,Linux kernel层,下面对这四层进行简 ...

- [poj3264]rmq算法学习(ST表)

解题关键:rmq模板题,可以用st表,亦可用线段树等数据结构 log10和log2都可,这里用到了对数的换底公式 类似于区间dp,用到了倍增的思想 $F[i][j] = \min (F[i][j - ...

- MySql中的视图的概念及应用

视图的基本概念 视图是从一个或几个基本表(或者视图)导出的表.它与基本表不同,是一个虚表. 数据库只存放视图的定义,而不存放视图对应的数据,这些数据仍存放在原来的基本表中.所以基本表中的数据发生变化, ...

- github的简单操作

之前初学过一点git版本控制工具,利用github做仓库,照着github上的文档练习的了一下.不过那只篇只是照虎画猫(我的水平只能照着老虎画个猫模样,嘻嘻!). 最近在学hibernate,公司与家 ...

- SQL Server中通过设置非聚集索引(Non-Clustered index)来达到性能优化的目的

首先我们一下,在SQL Server 2014 Management Studio中,如何为一张表设置Non-Clustered index 具体可以参考 https://docs.microsof ...

- 【C#】截取字符串

几个经常用到的字符串的截取 string str="123abc456"; int i=3; 1 取字符串的前i个字符 str=str.Substring(0,i); // or ...