Python爬虫之『urlopen』

本文以爬取百度首页为示例来学习,python版本为python3.6.7,完整代码会在文章末附上

本次学习所用到的python框架:

urllib.request 本次学习所用到的函数:

urllib.request.urlopen():发送http的get请求

.read():读取抓到的内容

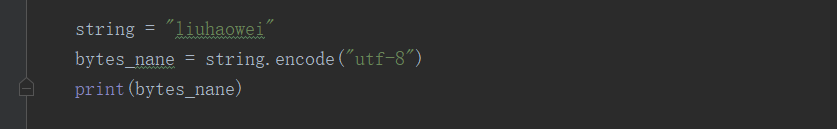

.decode("utf-8"):将获取的betys格式数据转换为string格式数据

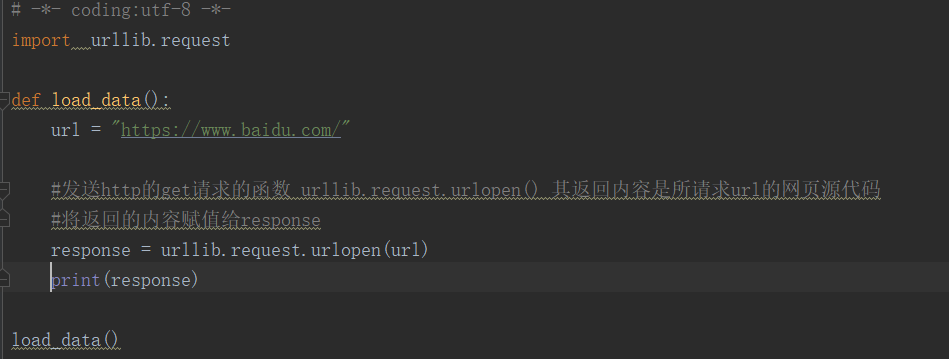

1.发送http的get请求使用的函数urllib.request.urlopen() ,其返回内容是所请求的url的网页源代码 可以将返回的内容赋给另外一个key

例如 response = urllib.request.urlopen(url)

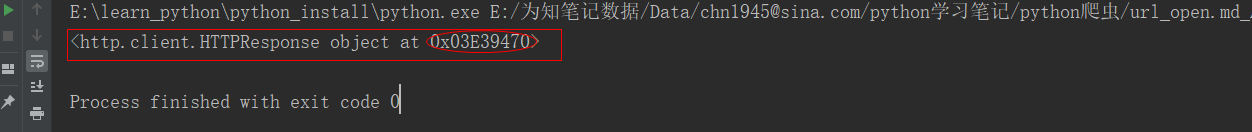

代码执行结果:

好像是存在内存里,这应该展示的是一个内存地址。

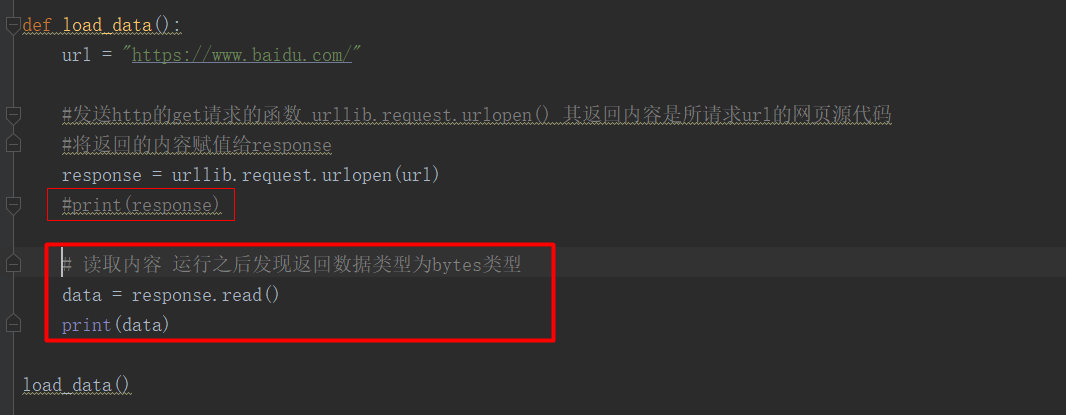

data = response.read() `将response的内容读出来赋值给data

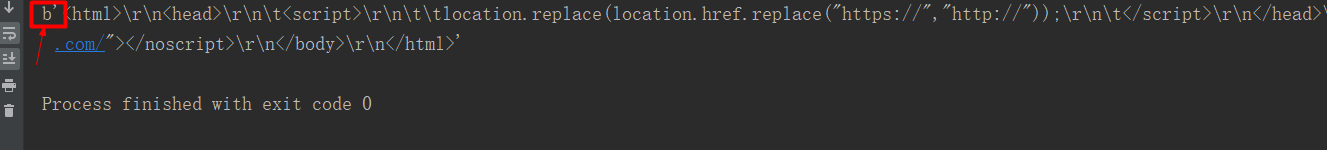

代码执行结果:获取的数据类型为bytes,没有可读性哈

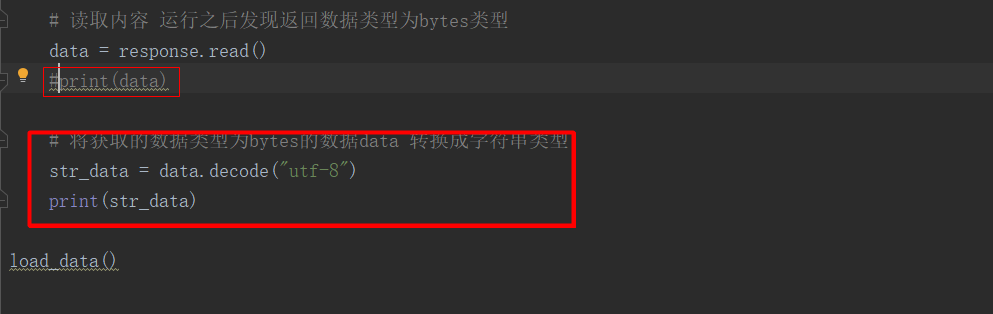

3.需要进行转换将data转换成字符串类型,用到函数.decode("utf-8")

str_data = data.decode("utf-8")

代码执行结果:【ps:将上面的https改为http】不截图了这里就能打印出url所对应的网页源代码了

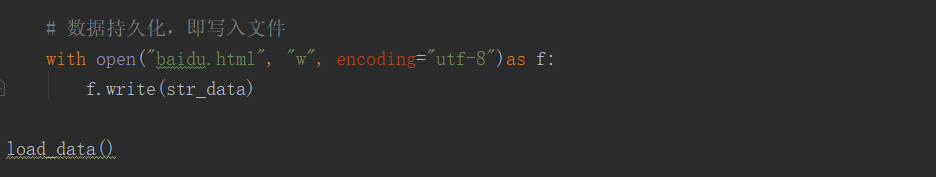

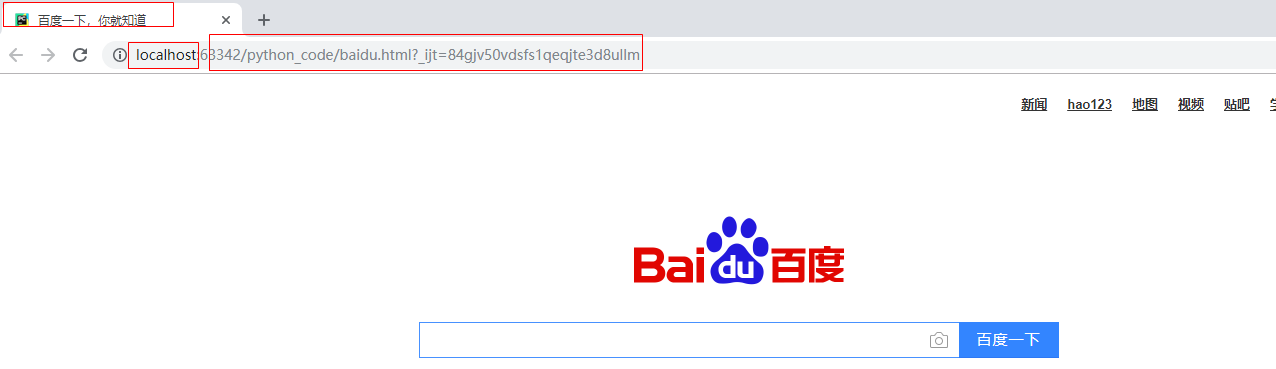

代码运行会生成一个baidu.html保存的是上面搜抓取的内容。

代码运行结果:

# -*- coding:utf-8 -*-

import urllib.request def load_data():

url = "http://www.baidu.com/" #发送http的get请求的函数 urllib.request.urlopen() 其返回内容是所请求url的网页源代码

#将返回的内容赋值给response

response = urllib.request.urlopen(url)

#print(response)

#读取内容 运行之后发现返回数据类型为bytes类型[做运维的小年轻]

data = response.read()

#print(data)

# 将获取的数据类型为bytes的数据data 转换成字符串类型

str_data = data.decode("utf-8")

#print(str_data)

#数据持久化,即写入文件

with open("baidu.html","w",encoding="utf-8")as f:

f.write(str_data)

load_data()

Python爬虫之『urlopen』的更多相关文章

- python爬虫之『入门基础』

HTTP请求 1.首先需要了解一下http请求,当用户在地址栏中输入网址,发送网络请求的过程是什么? 可以参考我之前学习的时候转载的一篇文章一次完整的HTTP事务过程–超详细 2.还需要了解一下htt ...

- 一个简单的开源PHP爬虫框架『Phpfetcher』

这篇文章首发在吹水小镇:http://blog.reetsee.com/archives/366 要在手机或者电脑看到更好的图片或代码欢迎到博文原地址.也欢迎到博文原地址批评指正. 转载请注明: 吹水 ...

- Python爬虫1-使用urlopen

GitHub代码练习地址:https://github.com/Neo-ML/PythonPractice/blob/master/SpiderPrac01_urlopen.py 爬虫简介- 爬虫定义 ...

- Python爬虫教程-02-使用urlopen

Spider-02-使用urlopen 做一个最简单的python爬虫,使用爬虫爬取:智联招聘某招聘信息的DOM urllib 包含模块 - urllib.request:打开和读取urls - ur ...

- 『Python题库 - 填空题』151道Python笔试填空题

『Python题库 - 填空题』Python笔试填空题 part 1. Python语言概述和Python开发环境配置 part 2. Python语言基本语法元素(变量,基本数据类型, 基础运算) ...

- 『Python题库 - 简答题』 Python中的基本概念 (121道)

## 『Python题库 - 简答题』 Python中的基本概念 1. Python和Java.PHP.C.C#.C++等其他语言的对比? 2. 简述解释型和编译型编程语言? 3. 代码中要修改不可变 ...

- 『009』Python

『004』索引-Language Python 准备更新中

- python爬虫成长之路(一):抓取证券之星的股票数据

获取数据是数据分析中必不可少的一部分,而网络爬虫是是获取数据的一个重要渠道之一.鉴于此,我拾起了Python这把利器,开启了网络爬虫之路. 本篇使用的版本为python3.5,意在抓取证券之星上当天所 ...

- python爬虫学习(6) —— 神器 Requests

Requests 是使用 Apache2 Licensed 许可证的 HTTP 库.用 Python 编写,真正的为人类着想. Python 标准库中的 urllib2 模块提供了你所需要的大多数 H ...

随机推荐

- caffe(7) solver及其配置

solver算是caffe的核心的核心,它协调着整个模型的运作.caffe程序运行必带的一个参数就是solver配置文件.运行代码一般为 # caffe train --solver=*_slover ...

- linux 常用文本操作相关命令

平时工作经常会对文本进行相关操作,包括读写.替换.统计等等,借此整理和学习一下有关命令. 1. cat 查看文件中的内容, -n 查看时为每一行加编号; -b 和-n类似,只不过对于空白行不编号: 2 ...

- 推荐《R数据可视化手册》高清英文版PDF+中文版PDF+源代码

绝大多数的绘图案例都是以强大.灵活制图而著称的R包ggplot2实现的,充分展现了ggplot2生动.翔实的一面.从如何画点图.线图.柱状图,到如何添加注解.修改坐标轴和图例,再到分面的使用和颜色的选 ...

- zabbix4.0 使用nginx前端安装

注:环境需求:centos7 1.安装阿里云yum源: rpm -ivh https://mirrors.aliyun.com/zabbix/zabbix/4.1/rhel/7/x86_64/zabb ...

- CSU 1446 Modified LCS 扩展欧几里得

要死了,这个题竟然做了两天……各种奇葩的错误…… HNU的12831也是这个题. 题意: 给你两个等差数列,求这两个数列的公共元素的数量. 每个数列按照以下格式给出: N F D(分别表示每个数列的长 ...

- main()函数的形参

main函数中的第一个参数argc代表的是向main函数传递的参数个数,第二个参数argv数组代表执行的程序名称和执行程序时输入的参数 #include <stdio.h> int mai ...

- 洛谷 P1176 路径计数2

P1176 路径计数2 题目描述 一个N×N的网格,你一开始在(1, 1),即左上角.每次只能移动到下方相邻的格子或者右方相邻的格子,问到达(N, N),即右下角有多少种方法. 但是这个问题太简单了, ...

- 读 Paxos 到 ZooKeeper ¥ 50大洋

一 初识 ZooKeeper 高效且可靠的分布式协调服务.解决分布式一致性问题 统一命名服务.配置管理服务.分布式锁服务. 使用: 比如配 ...

- struts2怎么返回一个字符串给jsp?(使用json)

我们都知道使用servlet时可以直接用PrintWriter对象的print方法来向页面传送一些字符串(可以是html标签和内容),然后在用RequestDispatcher来转向网页 虽Strut ...

- swift 动态设置UILabel的高度

import UIKit class ViewController3: UIViewController { override func viewDidLoad() { ...