第三百六十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)基本的索引和文档CRUD操作、增、删、改、查

第三百六十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)基本的索引和文档CRUD操作、增、删、改、查

elasticsearch(搜索引擎)基本的索引和文档CRUD操作

也就是基本的索引和文档、增、删、改、查、操作

注意:以下操作都是在kibana里操作的

elasticsearch(搜索引擎)都是基于http方法来操作的

GET 请求指定的页面信息,并且返回实体主体

POST 向指定资源提交数据进行处理请求,数据被包含在请求体中,POST请求可能会导致新的资源的建立和/或已有资源的修改

PUT 向服务器传送的数据取代指定的文档的内容

DELETE 请求服务器删除指定的页面

1、索引初始化,相当于创建一个数据库

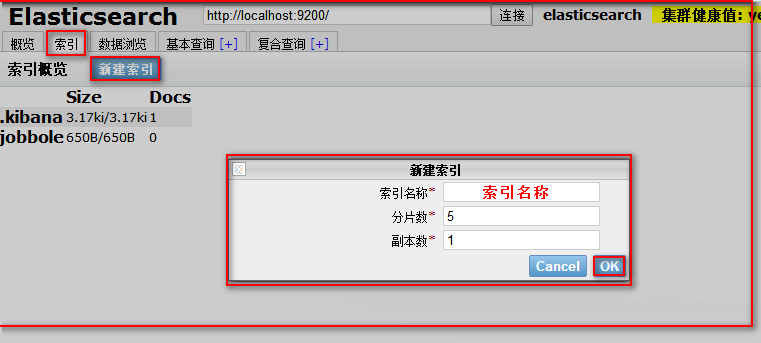

用kibana创建

代码说明

# 初始化索引(也就是创建数据库)

# PUT 索引名称

"""

PUT jobbole #设置索引名称

{

"settings": { #设置

"index": { #索引

"number_of_shards":5, #设置分片数

"number_of_replicas":1 #设置副本数

}

}

}

"""

代码

# 初始化索引(也就是创建数据库)

# PUT 索引名称 PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

}

我们也可以使用可视化根据创建索引

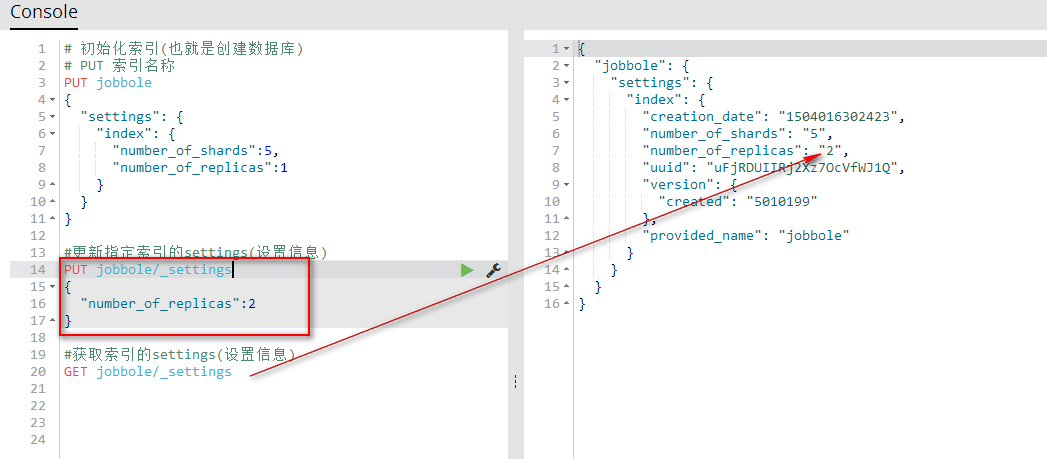

注意:索引一旦创建,分片数量不可修改,副本数量可以修改的

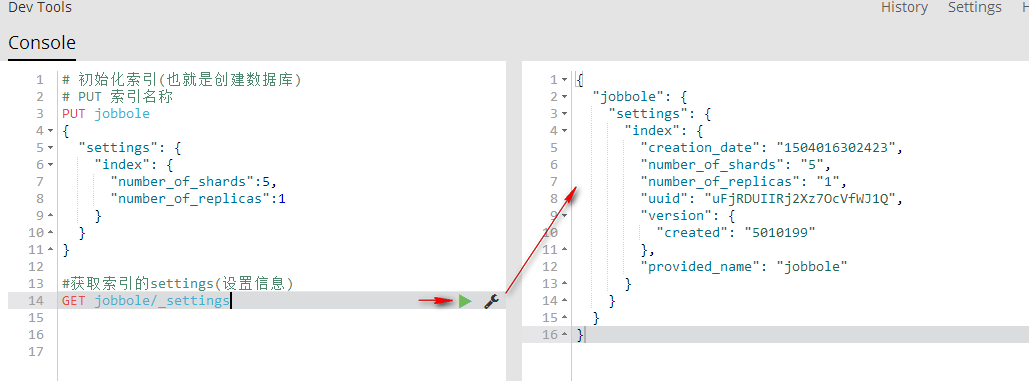

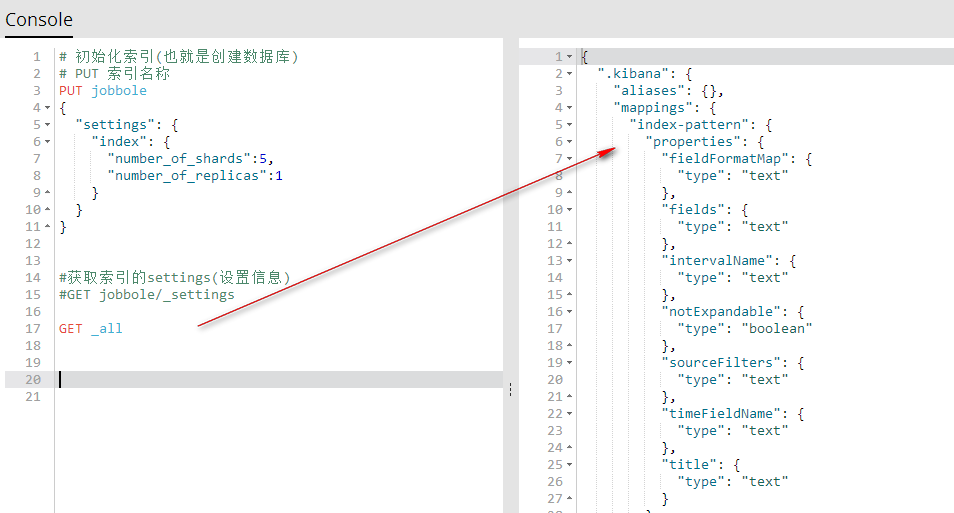

2、获取索引的settings(设置信息)

GET 索引名称/_settings 获取指定索引的settings(设置信息)

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #获取指定索引的settings(设置信息)

GET jobbole/_settings

GET _all/_settings 获取所有索引的settings(设置信息)

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #获取索引的settings(设置信息)

#GET jobbole/_settings #获取所有索引的settings(设置信息)

GET _all/_settings

GET .索引名称,索引名称/_settings 获取多个索引的settings(设置信息)

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #获取索引的settings(设置信息)

#GET jobbole/_settings #获取所有索引的settings(设置信息)

#GET _all/_settings

GET .kibana,jobbole/_settings

3、更新索引的settings(设置信息)

PUT 索引名称/_settings 更新指定索引的设置信息

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #更新指定索引的settings(设置信息)

PUT jobbole/_settings

{

"number_of_replicas":2

} #获取索引的settings(设置信息)

GET jobbole/_settings

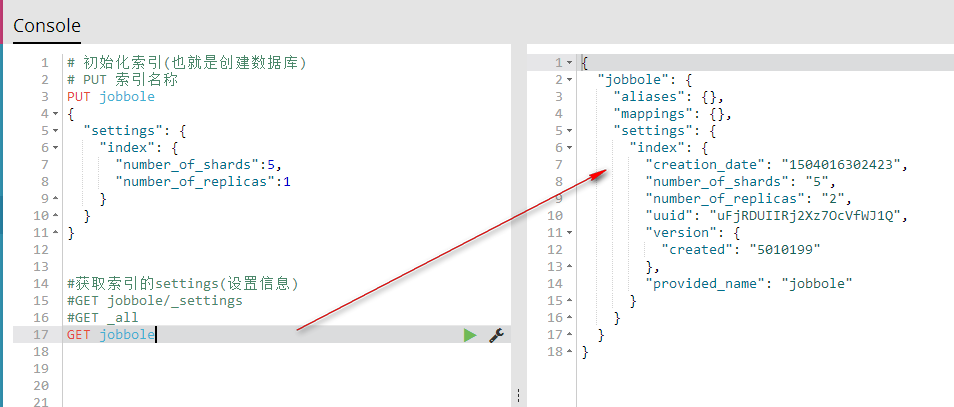

4、获取索引的(索引信息)

GET _all 获取所有索引的索引信息

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #获取索引的settings(设置信息)

#GET jobbole/_settings GET _all

GET 索引名称 获取指定的索引信息

# 初始化索引(也就是创建数据库)

# PUT 索引名称

PUT jobbole

{

"settings": {

"index": {

"number_of_shards":5,

"number_of_replicas":1

}

}

} #获取索引的settings(设置信息)

#GET jobbole/_settings

#GET _all

GET jobbole

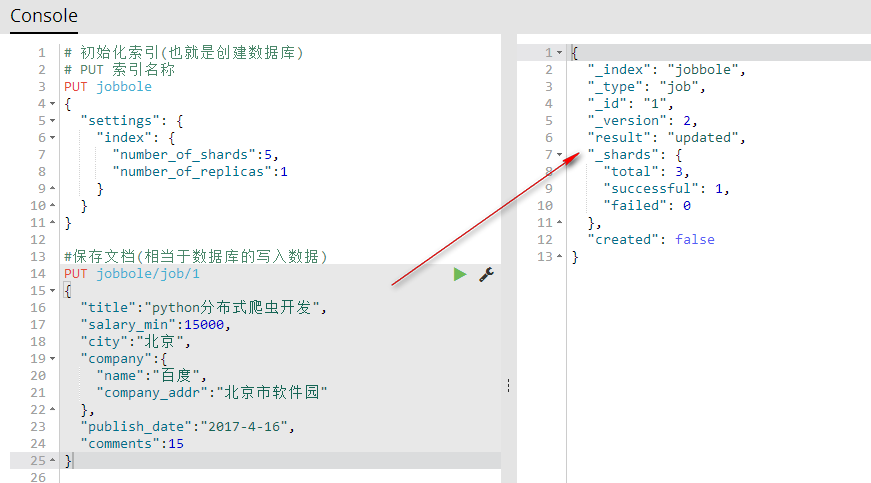

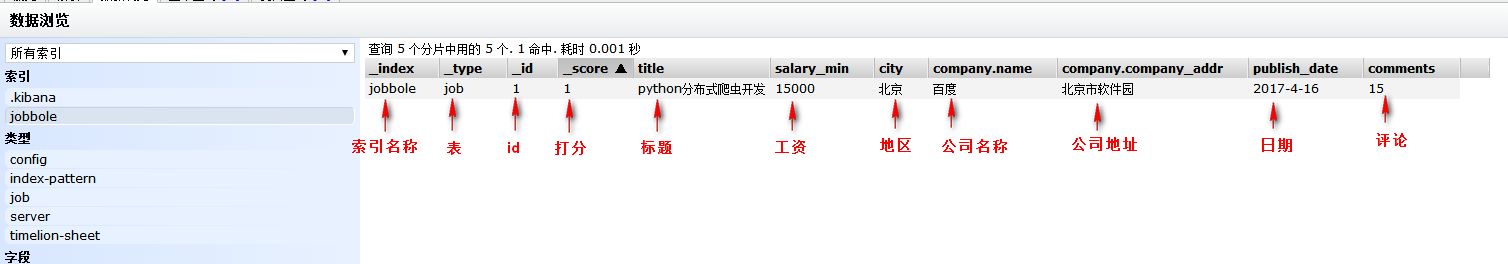

5、保存文档(相当于数据库的写入数据)

PUT index(索引名称)/type(相当于表名称)/1(相当于id){字段:值} 保存文档自定义id(相当于数据库的写入数据)

#保存文档(相当于数据库的写入数据)

PUT jobbole/job/1

{

"title":"python分布式爬虫开发",

"salary_min":15000,

"city":"北京",

"company":{

"name":"百度",

"company_addr":"北京市软件园"

},

"publish_date":"2017-4-16",

"comments":15

}

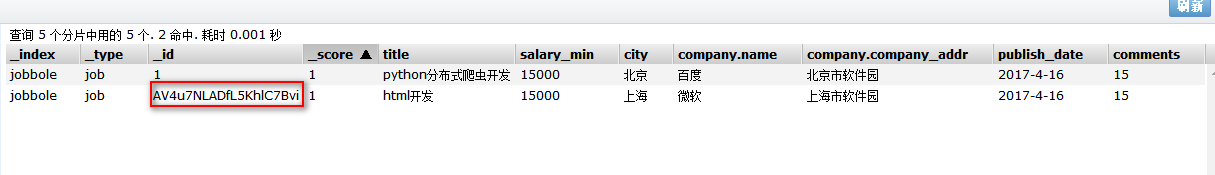

可视化查看

POST index(索引名称)/type(相当于表名称)/{字段:值} 保存文档自动生成id(相当于数据库的写入数据)

注意:自动生成id需要用POST方法

#保存文档(相当于数据库的写入数据)

POST jobbole/job

{

"title":"html开发",

"salary_min":15000,

"city":"上海",

"company":{

"name":"微软",

"company_addr":"上海市软件园"

},

"publish_date":"2017-4-16",

"comments":15

}

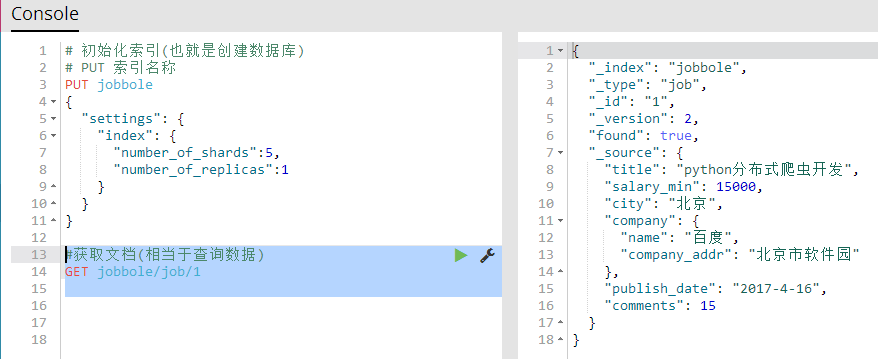

6、获取文档(相当于查询数据)

GET 索引名称/表名称/id 获取指定的文档所有信息

#获取文档(相当于查询数据)

GET jobbole/job/1

GET 索引名称/表名称/id?_source 获取指定文档的所有字段

GET 索引名称/表名称/id?_source=字段名称,字段名称,字段名称 获取指定文档的多个指定字段

GET 索引名称/表名称/id?_source=字段名称 获取指定文档的一个指定字段

#获取指定文档的所有字段

GET jobbole/job/1?_source

#获取指定文档的多个指定字段

GET jobbole/job/1?_source=title,city,company

#获取指定文档的一个指定字段

GET jobbole/job/1?_source=title

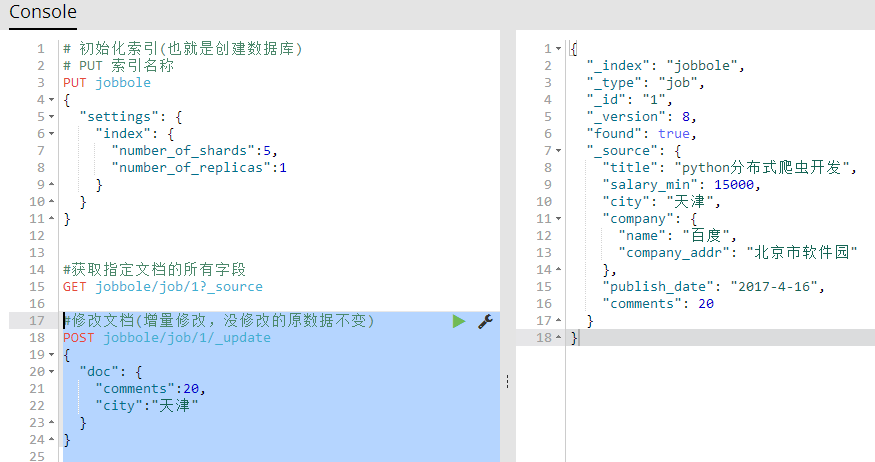

7、修改文档(相当于修改数据)

修改文档(用保存文档的方式,进行覆盖来修改文档)原有数据全部被覆盖

#修改文档(用保存文档的方式,进行覆盖来修改文档)

PUT jobbole/job/1

{

"title":"python分布式爬虫开发",

"salary_min":15000,

"city":"北京",

"company":{

"name":"百度",

"company_addr":"北京市软件园"

},

"publish_date":"2017-4-16",

"comments":20

}

修改文档(增量修改,没修改的原数据不变)【推荐】

POST 索引名称/表/id/_update

{

"doc": {

"字段":值,

"字段":值

}

}

#修改文档(增量修改,没修改的原数据不变)

POST jobbole/job/1/_update

{

"doc": {

"comments":20,

"city":"天津"

}

}

8、删除索引,删除文档

DELETE 索引名称/表/id 删除索引里的一个指定文档

DELETE 索引名称 删除一个指定索引

#删除索引里的一个指定文档

DELETE jobbole/job/1

#删除一个指定索引

DELETE jobbole

第三百六十二节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)基本的索引和文档CRUD操作、增、删、改、查的更多相关文章

- 第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能

第三百六十九节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现搜索功能 Django实现搜索功能 1.在Django配置搜索结果页的路由映 ...

- 第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中

第三百六十七节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)scrapy写入数据到elasticsearch中 前面我们讲到的elasticsearch( ...

- 第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询

第三百六十六节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的bool组合查询 bool查询说明 filter:[],字段的过滤,不参与打分must:[] ...

- 第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询

第三百六十五节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本查询 1.elasticsearch(搜索引擎)的查询 elasticsearch是功能 ...

- 第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理

第三百六十四节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mapping映射管理 1.映射(mapping)介绍 映射:创建索引的时候,可以预先定义字 ...

- 第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作

第三百六十三节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的mget和bulk批量操作 注意:前面讲到的各种操作都是一次http请求操作一条数据,如果想 ...

- 第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引

第三百六十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)倒排索引 倒排索引 倒排索引源于实际应用中需要根据属性的值来查找记录.这种索引表中的每一项都包 ...

- 第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念

第三百六十节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)的基本概念 elasticsearch的基本概念 1.集群:一个或者多个节点组织在一起 2.节点 ...

- 第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门搜索

第三百七十一节,Python分布式爬虫打造搜索引擎Scrapy精讲—elasticsearch(搜索引擎)用Django实现我的搜索以及热门 我的搜素简单实现原理我们可以用js来实现,首先用js获取到 ...

随机推荐

- Function.apply()在提升程序性能方面的技巧

我们先从Math.max()函数说起,Math.max后面可以接任意个参数,最后返回所有参数中的最大值. 比如 alert(Math.max(5,8)) //8alert(Math.max(5,7 ...

- (原创)C++11改进我们的程序之move和完美转发

本次要讲的是右值引用相关的几个函数:std::move, std::forward和成员的emplace_back,通过这些函数我们可以避免不必要的拷贝,提高程序性能.move是将对象的状态或者所有权 ...

- Android 拍照

android调用camera时,可以自己写一个activity,赋上相关参数,打开前camera就可以了: 需要申请的permission,在AndroidManifest.xml中添加: < ...

- 如何优雅的退出/关闭/重启gunicorn进程

在工作中,会发现gunicorn启动的web服务,无论怎么使用kill -9 进程号都是无法杀死gunicorn,经过我一番百度和谷歌,发现想要删除gunicorn进程其实很简单. 1. 寻找mast ...

- sql随机查询数据order by newid()

方法1:最普通的写法,性能慢 ID,name FROM dt_keyword ORDER BY NEWID() 方法2:性能还可以 //先给数据库增加一列ALTER TABLE dt_keyword ...

- BI--SAP BI的权限管理

源地址 :http://silverw0396.iteye.com/blog/229274 一.sapBI的用户分类 There are different types of users in SAP ...

- Linux内核分析:recv、recvfrom、recvmsg函数实现

先看一下这三个函数的声明: #include <sys/types.h> #include <sys/socket.h> ssize_t recv(int sockfd, vo ...

- LeetCode: Convert Sorted Array to Binary Search Tree 解题报告

Convert Sorted Array to Binary Search Tree Given an array where elements are sorted in ascending ord ...

- source activate my_env 失败,source not found

今天连接到服务器后,安装anaconda.虽然在安装过程中选择将anaconda加入到系统变量中去.而且在 ~/.bashrc 中确实有 export PATH="/home/xnh/ana ...

- python 下载虾米音乐

#!/usr/bin/env python2 # coding:utf-8 import urllib import re import sys import urllib2 # xml => ...