Python爬虫教程-22-lxml-etree和xpath配合使用

Python爬虫教程-22-lxml-etree和xpath配合使用

- lxml:python 的HTML/XML的解析器

- 官网文档:https://lxml.de/

- 使用前,需要安装安 lxml 包

- 功能:

- 1.解析HTML:使用 etree.HTML(text) 将字符串格式的 html 片段解析成 html 文档

- 2.读取xml文件

- 3.etree和XPath 配合使用

lxml 的安装

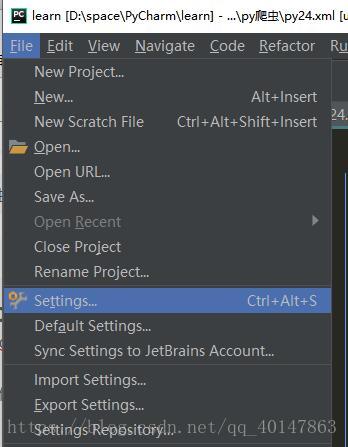

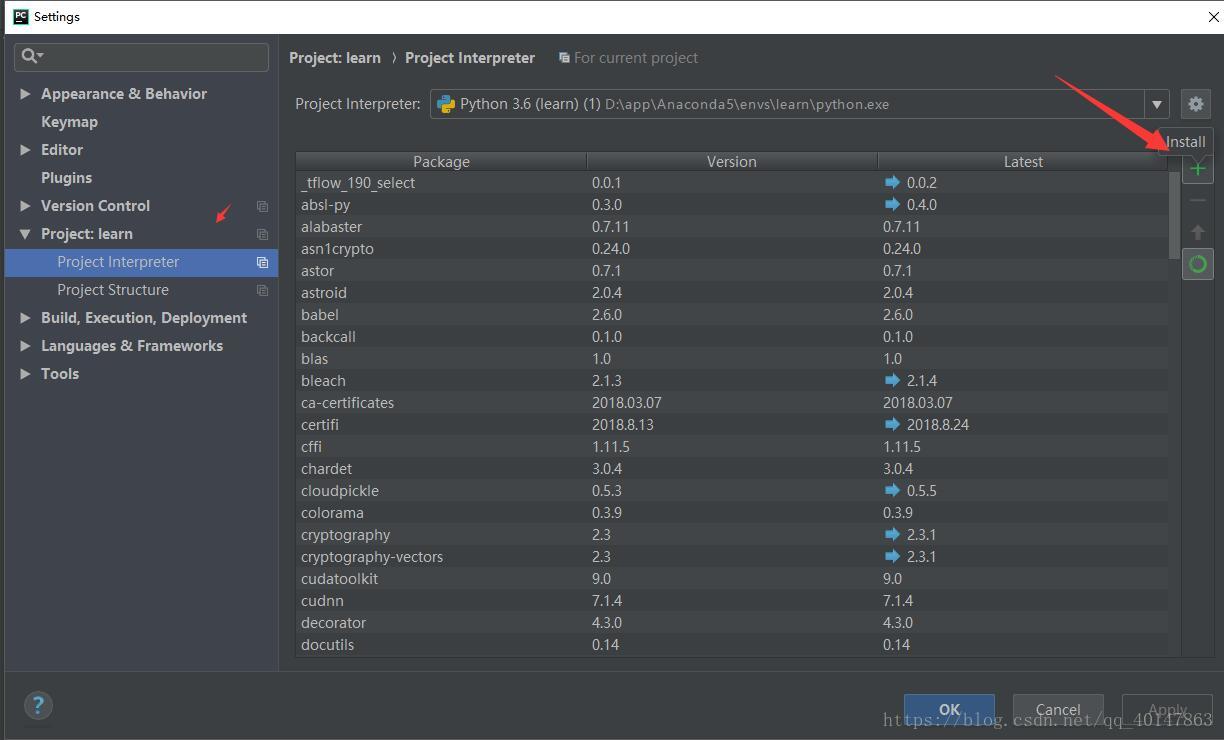

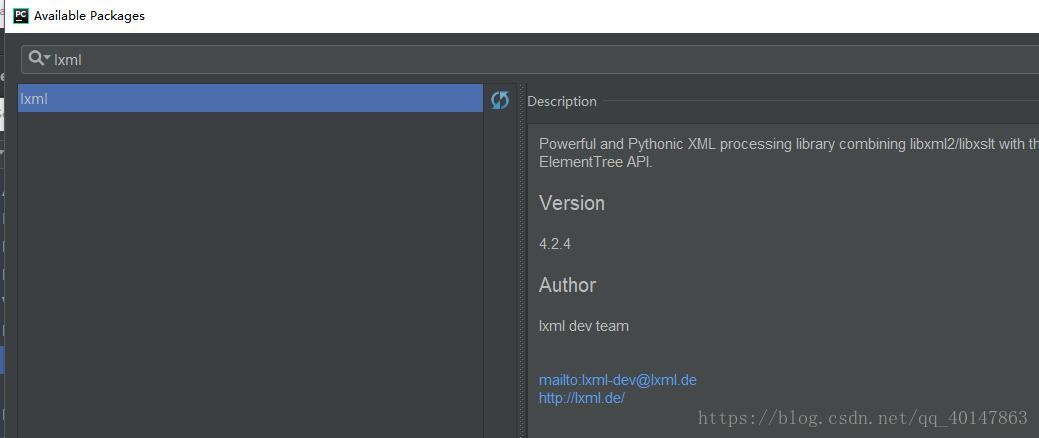

- 【PyCharm】>【file】>【settings】>【Project Interpreter】>【+】 >【lxml】>【install】

- 具体操作截图:

lxml-etree 的使用

- 案例v25文件:https://xpwi.github.io/py/py爬虫/py25etree.py

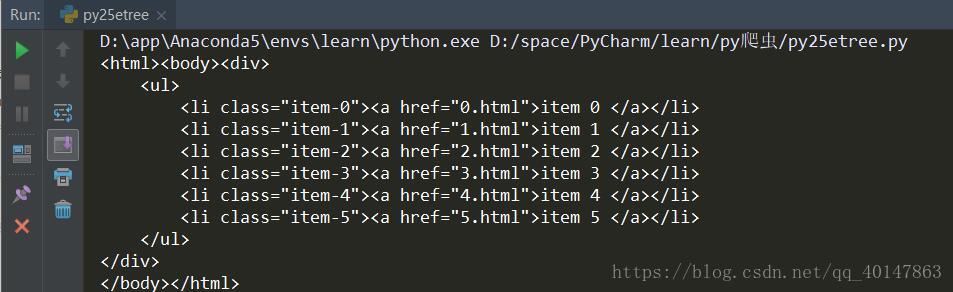

- 用 lxml 来解析HTML代码

# 先安装lxml

# 用 lxml 来解析HTML代码

from lxml import etree

text = '''

<div>

<ul>

<li class="item-0"><a href="0.html">item 0 </a></li>

<li class="item-1"><a href="1.html">item 1 </a></li>

<li class="item-2"><a href="2.html">item 2 </a></li>

<li class="item-3"><a href="3.html">item 3 </a></li>

<li class="item-4"><a href="4.html">item 4 </a></li>

<li class="item-5"><a href="5.html">item 5 </a></li>

</ul>

</div>

'''

# 利用 etree.HTML 把字符串解析成 HTML 文件

html = etree.HTML(text)

s = etree.tostring(html).decode()

print(s)

运行结果

lxml-etree 的使用

- 案例v26etree2文件:https://xpwi.github.io/py/py爬虫/py26etree2.py

- 读取xml文件:

# lxml-etree读取文件

from lxml import etree

xml = etree.parse("./py24.xml")

sxml = etree.tostring(xml, pretty_print=True)

print(sxml)

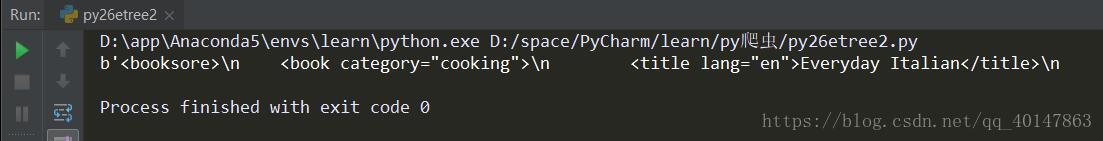

运行结果

etree和XPath 配合使用

- 案例v26expath.文件:https://xpwi.github.io/py/py爬虫/py26expath.py

- etree和XPath 配合使用:

# lxml-etree读取文件

from lxml import etree

xml = etree.parse("./py24.xml")

print(type(xml))

# 查找所有 book 节点

rst = xml.xpath('//book')

print(type(rst))

print(rst)

# 查找带有 category 属性值为 sport 的元素

rst2 = xml.xpath('//book[@category="sport"]')

print(type(rst2))

print(rst2)

# 查找带有category属性值为sport的元素的book元素下到的year元素

rst3 = xml.xpath('//book[@category="sport"]/year')

rst3 = rst3[0]

print('-------------\n',type(rst3))

print(rst3.tag)

print(rst3.text)

运行结果

etree和XPath 配合使用结果

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

Python爬虫教程-22-lxml-etree和xpath配合使用的更多相关文章

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫教程-33-scrapy shell 的使用

本篇详细介绍 scrapy shell 的使用,也介绍了使用 xpath 进行精确查找 Python爬虫教程-33-scrapy shell 的使用 scrapy shell 的使用 条件:我们需要先 ...

- Python爬虫教程-25-数据提取-BeautifulSoup4(三)

Python爬虫教程-25-数据提取-BeautifulSoup4(三) 本篇介绍 BeautifulSoup 中的 css 选择器 css 选择器 使用 soup.select 返回一个列表 通过标 ...

- Python爬虫教程-24-数据提取-BeautifulSoup4(二)

Python爬虫教程-24-数据提取-BeautifulSoup4(二) 本篇介绍 bs 如何遍历一个文档对象 遍历文档对象 contents:tag 的子节点以列表的方式输出 children:子节 ...

- Python爬虫教程-23-数据提取-BeautifulSoup4(一)

Beautiful Soup是python的一个库,最主要的功能是从网页抓取数据,查看文档 https://www.crummy.com/software/BeautifulSoup/bs4/doc. ...

- Python爬虫教程-21-xpath 简介

本篇简单介绍 xpath 在python爬虫方面的使用,想要具体学习 xpath 可以到 w3school 查看 xpath 文档 xpath文档:http://www.w3school.com.cn ...

- Python爬虫教程-18-页面解析和数据提取

本篇针对的数据是已经存在在页面上的数据,不包括动态生成的数据,今天是对HTML中提取对我们有用的数据,去除无用的数据 Python爬虫教程-18-页面解析和数据提取 结构化数据:先有的结构,再谈数据 ...

- Python爬虫教程-21-xpath

本篇简单介绍 xpath 在python爬虫方面的使用,想要具体学习 xpath 可以到 w3school 查看 xpath 文档 Python爬虫教程-21-xpath 什么是 XPath? XPa ...

随机推荐

- 基础篇:3.3)规范化:3d装配图

本章目的:规范化3d零件装配图,弄清楚装配层级划分,这也是机械的基本功夫. 1.装配通用原则 在装配建模设计中,应遵循以下通用原则:a)所有的装配单元应具有唯一性和稳定性,不允许冗余元素存在: //就 ...

- 洛谷 P3204 [HNOI2010]公交线路

题面 luogu 题解 矩阵快速幂\(+dp\) 其实也不是很难 先考虑朴素状压\(dp\) \(f[i][S]\) 表示最慢的车走到了\(i\),\([i, p+i-1]\)的覆盖情况 状态第一位一 ...

- CF1067D. Computer Game(斜率优化+倍增+矩阵乘法)

题目链接 https://codeforces.com/contest/1067/problem/D 题解 首先,如果我们获得了一次升级机会,我们一定希望升级 \(b_i \times p_i\) 最 ...

- Which mb sdconnect c4 worth the money?

MB SD connect C4 with laptop v2018.5 Version avaiable now ,It is ready to work after you get it ,wor ...

- init_config_file.lua

--[[ 读取限流配置 --]] --获取共享内存 local limit_req_store = ngx.shared.limit_req_store --初始化拒绝 URI 列表 reject_u ...

- 微信小程序踩坑

微信小程序自定义属性data-xx使用注意事项 data-xx采用驼峰式命名时,数据传递打印显示(以jxsName与jxsname打印显示对比) data-xx全小写命名时,数据传递打印显示

- oracle--dump 事务槽

01,创建环境 SQL> create table t3 (id int); Table created. SQL); row created. SQL); row created. SQL); ...

- TortoiseGit学习系列之TortoiseGit是什么?

写该文章目的 肯定有人会遇到这样的问题: 最近换了一份新工作,新公司的源码管理都是使用GIT,习惯了之前的TFS和SVN进行项目源码管理和团队开发,第一次使用GIT进行团队开发和源码管理,颇有一些不习 ...

- 012-MD5Utils工具类模板

package ${enclosing_package}; import java.math.BigInteger; import java.security.MessageDigest; impor ...

- js中的闭包理解一

闭包是一个比较抽象的概念,尤其是对js新手来说.书上的解释实在是比较晦涩,对我来说也是一样. 但是他也是js能力提升中无法绕过的一环,几乎每次面试必问的问题,因为在回答的时候.你的答案的深度,对术语的 ...