Hive笔记之导出查询结果

一、导出到本地

导出查询结果到本地:

INSERT OVERWRITE LOCAL DIRECTORY "/tmp/hive-result/t_visit_video"

SELECT * FROM t_visit_video ;

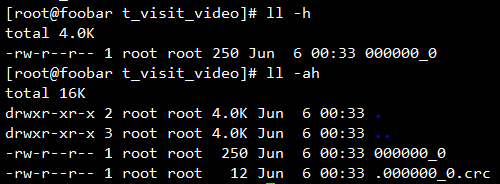

导出到的本地路径不必已经存在,会自动创建父目录,导出的查询结果会是一个文件夹,文件夹下存放着本次查询的结果,如果结果集比较大的话会分块存放。

每个数据块还会有一个CRC校验文件,此文件为隐藏文件,用于校验此块的数据有效性。

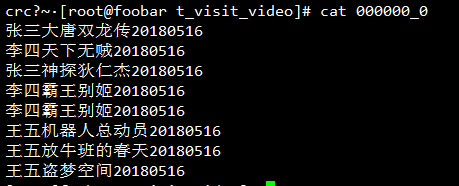

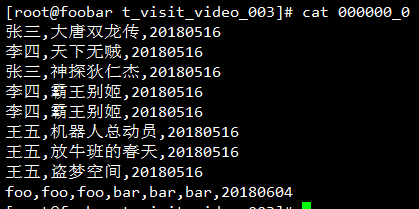

但是当查看导出的数据文件时发现悲剧了,列与列之间好像是没有东西分隔啊:

其实是有东西分隔的,这个字符就是^A,只不过这是一个不可见字符,这个字符在vim中可见,使用vim编辑一下它(或者使用cat -A):

看到了,列与列之间确实是有一个^A分隔符的。

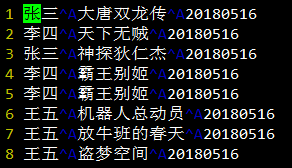

如果不希望使用^A作为分隔符,可以在导出数据的时候使用ROW FORMAT DELIMITED FIELDS TERMINITED BY ","来指定列与列之间的分隔符,来重新导出一下:

INSERT OVERWRITE LOCAL DIRECTORY "/tmp/hive-result/t_visit_video_002"

ROW FORMAT DELIMITED FIELDS TERMINATED BY ","

SELECT * FROM t_visit_video ;

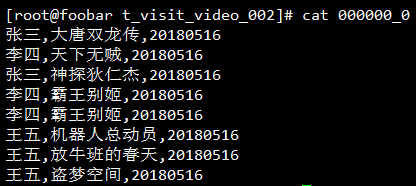

再查看一下导出的本地文件,发现列与列之间的分隔符是逗号了:

也许你会认为自己已经得到了CSV格式,如果这样的话就踩坑了,因为它并不符合CSV的RFC4180。简单地来证明一下,在上面的表插入一行巨多逗号然后重新导出:

INSERT INTO t_visit_video PARTITION (day="20180604") SELECT "foo,foo,foo", "bar,bar,bar";

INSERT OVERWRITE LOCAL DIRECTORY "/tmp/hive-result/t_visit_video_003"

ROW FORMAT DELIMITED FIELDS TERMINATED BY ","

SELECT * FROM t_visit_video ;

查看导出结果:

注意看最后一行,如果按照CSV的格式去解析的话最后得到的结果一定是错的,一定要确保所指定的列分隔符不包含在列数据中出现,这是在导出数据指定分隔时需要注意的一个坑。

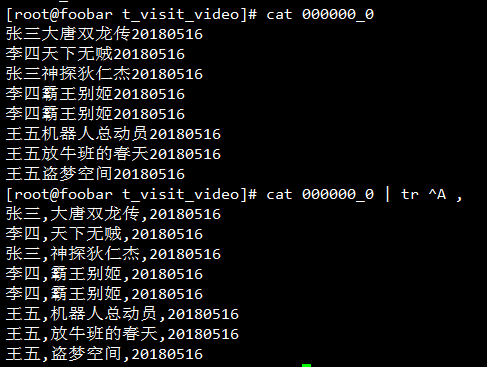

Hive导出数据时指定分隔符的语法长的令人发指,说实话我是记不住的,这里可以耍个小聪明,可以先将数据按照默认的分隔符^A导出,然后使用tr将^A替换为想要的分隔符:

注意这个^V是先按Ctrl+V,告诉终端我下一个字符要输入一个特殊字符,然后按CTRL+A打出。

注:使用默认分隔符导出的Hive查询结果在程序中处理的时候使用split("\x01")或者split("\001")来切分列。

二、导出到HDFS

导出到HDFS跟导出到本地差不多,只是没有LOCAL,加LOCAL后面的是本地路径,否则的话就是HDFS路径:

INSERT OVERWRITE DIRECTORY "/test/hive-export/t_visit_video"

SELECT * FROM t_visit_video;

查看HDFS上导出的目录:

[root@foobar ~]# hadoop fs -ls /test/hive-export/t_visit_video

Found 1 items

-rwxr-xr-x 1 root supergroup 283 2018-06-08 00:04 /test/hive-export/t_visit_video/000000_0

和导出到本地一样,只不过是位置换到了HDFS而已。

同样的,导出到HDFS也可以指定列分隔符:

INSERT OVERWRITE DIRECTORY "/test/hive-export/t_visit_video_002"

ROW FORMAT DELIMITED FIELDS TERMINATED BY ","

SELECT * FROM t_visit_video;

查看列分隔符是否设置正确:

[root@foobar ~]# hadoop fs -ls /test/hive-export/t_visit_video_002

Found 1 items

-rwxr-xr-x 1 root supergroup 283 2018-06-08 00:12 /test/hive-export/t_visit_video_002/000000_0

[root@foobar ~]# hadoop fs -cat /test/hive-export/t_visit_video_002/000000_0

张三,大唐双龙传,20180516

李四,天下无贼,20180516

张三,神探狄仁杰,20180516

李四,霸王别姬,20180516

李四,霸王别姬,20180516

王五,机器人总动员,20180516

王五,放牛班的春天,20180516

王五,盗梦空间,20180516

foo,foo,foo,bar,bar,bar,20180604

三、导出到其它Hive表

导出到其它表的语法和导出到目录类似,只是目的地变成了表名,如果目标表是个分区表的话还要指定所要插入的分区。

下面是一个简单的例子,先复制一份表结构,然后将其中一个分区的数据拷贝一份:

CREATE TABLE t_visit_video_20180516 LIKE t_visit_video;

INSERT OVERWRITE TABLE t_visit_video_copy PARTITION (day="20180516")

SELECT * FROM t_visit_video WHERE day="20180516";

同样的,这里可以使用INTO表示追加到指定的分区,也可以使用OVERWRITE表示覆盖指定分区。

上面的方式适用于表已经存在的情况,如果想使用一个新表来保存查询结果但是又不想手动创建的话,可以让其自动创建表结构:

CREATE TABLE t_visit_video_20180516 AS SELECT * FROM t_visit_video WHERE day='20180516';

这种方法常用于将查询结果集导出为临时表时使用。

四、定时查询并备份结果集

hive -e可以用来指定一些命令,hive -f可以用来指定一个脚本文件,可以将导出脚本的逻辑写个小脚本,借助于crontab定时执行此脚本,即可实现对Hive表查询并备份。

下面是一个小小的例子,定时将hive表前一天的张三看过的电影导出到某个目录下,同时记录操作日志:

#! /bin/bash day=`date '+%Y%m%d' -d 'day ago'`

if [ $1 ]; then

day=$1

fi

hive="/opt/hive/apache-hive-2.3.3-bin/bin/hive"

dest_dir="/tmp/hive-result/t_visit_video_$day"

log_file="`dirname $0`/backup.log" echo "[`date '+%F %T'`] $day begin bakcup" >> $log_file

hive -e "INSERT OVERWRITE LOCAL DIRECTORY '$dest_dir' SELECT * FROM test_003.t_visit_video WHERE day='$day' AND username='张三'"

echo "[`date '+%F %T'`] $day begin end" >> $log_file

将上面的脚本加入到crontab即可实现定时导出查询结果:

0 1 * * * /root/hive/backup/backup.sh

.

Hive笔记之导出查询结果的更多相关文章

- 笔记-mysql 导出查询结果

语法: The SELECT ... INTO OUTFILE 'file_name' [options] form of SELECT writes the selected rows to a f ...

- 从零自学Hadoop(17):Hive数据导入导出,集群数据迁移下

阅读目录 序 将查询的结果写入文件系统 集群数据迁移一 集群数据迁移二 系列索引 本文版权归mephisto和博客园共有,欢迎转载,但须保留此段声明,并给出原文链接,谢谢合作. 文章是哥(mephis ...

- 【转】Impala导出查询结果到文件

[转载出处]http://blog.csdn.net/jobschen/article/details/68942574 想用impala-shell 命令行中将查询的结果导出到本地文件,想当然的以为 ...

- OpenSceneGraph 笔记--如何导出三角形数据

OpenSceneGraph 笔记--如何导出三角形数据 转载:http://blog.csdn.net/pizi0475/article/details/5384389 在OpenSceneGrap ...

- 导出查询结果到excle

实现功能 输入查询结果 点击导出查询结果 导出到excle表.

- MVC学习笔记---MVC导出excel(数据量大,非常耗时的,异步导出)

要在ASP.NET MVC站点上做excel导出功能,但是要导出的excel文件比较大,有几十M,所以导出比较费时,为了不影响对界面的其它操作,我就采用异步的方式,后台开辟一个线程将excel导出到指 ...

- SQL查询(笔记2——实体查询)

SQL查询(笔记2——实体查询) 二.实体查询 如果查询返回了某个数据表的全部数据列,且该数据表有对应的持久化类映射,我们就把查询结果转换成实体查询.将查询结果转换成实体,可以使用SQLQuery提供 ...

- MyBatis:学习笔记(3)——关联查询

MyBatis:学习笔记(3)--关联查询 关联查询 理解联结 SQL最强大的功能之一在于我们可以在数据查询的执行中可以使用联结,来将多个表中的数据作为整体进行筛选. 模拟一个简单的在线商品购物系统, ...

- 利用sqoop将hive数据导入导出数据到mysql

一.导入导出数据库常用命令语句 1)列出mysql数据库中的所有数据库命令 # sqoop list-databases --connect jdbc:mysql://localhost:3306 ...

随机推荐

- TP 等框架在配置虚拟主机伪静态注意事项

在配置虚拟主机的伪静态 .htaccess 文件时需要注意 ? 符号的添加与否处理 例如TP 框架来讲 无 ? 符号,在有的虚拟主机中必须这样配置,否则无法解析(试了多个公司的虚拟主机只要加了?符号就 ...

- 【百度】大型网站的HTTPS实践(二)——HTTPS加密算法介绍

大型网站的HTTPS实践(二)——HTTPS加密算法介绍 原创 网络通信/物联网 作者:AIOps智能运维 时间:2018-11-09 15:09:43 358 0 前言 在上一篇文章中,我们简要 ...

- [转帖] IIS 与 HTTP/2 的介绍.

HTTP/2 on IIS https://blogs.iis.net/davidso/http2 Friday, September 11, 2015 Windows 10 HTTP2 In Oct ...

- [细品java]ThreadLocal源码学习

ThreadLocal是线程局部变量,其中保存了特定于该线程的值.每个线程都拥有一份独立的副本值,即每个线程修改变量值不影响其他线程该变量的副本值.这些特定于线程的值保存在Thread对象中,当线程终 ...

- userData Behavior

https://msdn.microsoft.com/zh-cn/vstudio/ms531424 userData Behavior This topic documents a feature o ...

- 关于nginx的一点记录

(1) 安装nginx官网下载:http://nginx.org下载适合Windows的安装包,是一个压缩包,直接解压就可以了. (2) 启动nginx有三种方式启动:a. 双击nginx.exe图标 ...

- Ubuntu和Windows相互共享文件夹

一.Ubuntu访问Windows共享文件夹 1.对需要共享文件夹右击->属性->共享 2.选择要与其共享的用户,选择好用户点击有点添加按钮添加,然后点击下方的共享按钮 3.完成共享 4. ...

- Multiple Instance Learning

///////////////////////////////////////////推荐学习组////////////////////////////// http://www.robots.ox. ...

- linq 获取实体列表中的某个字段返回ilist<string>

var list = list.Select(t => t.Field<string>("列名")).ToList(); var list = list.Se ...

- [洛谷P4723]【模板】线性递推

题目大意:求一个满足$k$阶齐次线性递推数列$a_i$的第$n$项. 即:$a_n=\sum\limits_{i=1}^{k}f_i \times a_{n-i}$ 题解:线性齐次递推,先见洛谷题解, ...