node:爬虫爬取网页图片

前言

周末自己在家闲着没事,刷着微信,玩着手机,发现自己的微信头像该换了,就去网上找了一下头像,看着图片,自己就想着作为一个码农,可以把这些图片都爬取下来做成一个微信小程序,说干就干,了解一下基本都知道怎么做了,整理分享一波给大家。

目录:

- 安装node,并下载依赖

- 搭建服务

- 请求我们要爬取的页面,返回json

安装node

我们开始安装node,可以去node官网下载node下载地址,下载完成后运行node使用,

node -v

安装成功后会出现你所安装的版本号。

接下来我们使用node, 打印出hello world,新建一个名为index.js文件输入

console.log('hello world')

运行这个文件

node index.js

就会在控制面板上输出hello world

搭建服务器

新建一个·名为node的文件夹

首先你需要下载express依赖

npm install express

在新建一个名为demo.js的文件

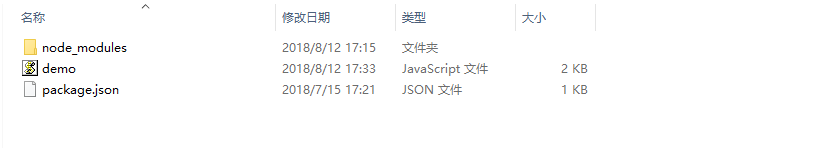

项目目录结构

如图:

在demo.js引入下载的express

const express = require('express');

const app = express();

app.get('/index', function(req, res) {

res.end('111')

})

var server = app.listen(8081, function() {

var host = server.address().address

var port = server.address().port

console.log("应用实例,访问地址为 http://%s:%s", host, port)

})

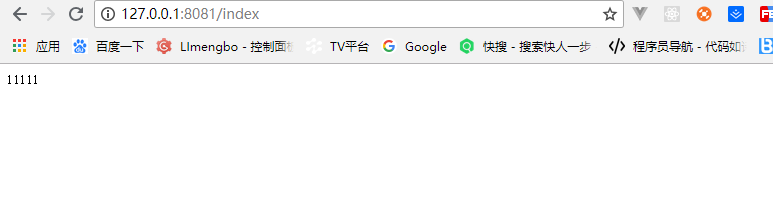

运行效果

运行node demo.js简单的服务就搭起来了,如图:

请求我们要爬取的页面

首先下载需要的依赖

npm install superagent

npm install superagent-charset

npm install cheerio

superagent 是用来发起请求的,是一个轻量的,渐进式的ajax api,可读性好,学习曲线低,内部依赖nodejs原生的请求api,适用于nodejs环境下.,也可以使用http发起请求

superagent-charset防止爬取下来的数据乱码,更改字符格式

cheerio为服务器特别定制的,快速、灵活、实施的jQuery核心实现.。

安装完依赖就可以引入了

var superagent = require('superagent');

var charset = require('superagent-charset');

charset(superagent);

const cheerio = require('cheerio');

引入之后就请求我们的地址,https://www.qqtn.com/tx/weixintx_1.html

const baseUrl = 'https://www.qqtn.com/'

这些设置完之后就是发请求了,接下来请看完整代码demo.js

var superagent = require('superagent');

var charset = require('superagent-charset');

charset(superagent);

var express = require('express');

var baseUrl = 'https://www.qqtn.com/'; //输入任何网址都可以

const cheerio = require('cheerio');

var app = express();

app.get('/index', function(req, res) {

//设置请求头

res.header("Access-Control-Allow-Origin", "*");

res.header('Access-Control-Allow-Methods', 'PUT, GET, POST, DELETE, OPTIONS');

res.header("Access-Control-Allow-Headers", "X-Requested-With");

res.header('Access-Control-Allow-Headers', 'Content-Type');

//类型

var type = req.query.type;

//页码

var page = req.query.page;

type = type || 'weixin';

page = page || '1';

var route = `tx/${type}tx_${page}.html`

//网页页面信息是gb2312,所以chaeset应该为.charset('gb2312'),一般网页则为utf-8,可以直接使用.charset('utf-8')

superagent.get(baseUrl + route)

.charset('gb2312')

.end(function(err, sres) {

var items = [];

if (err) {

console.log('ERR: ' + err);

res.json({ code: 400, msg: err, sets: items });

return;

}

var $ = cheerio.load(sres.text);

$('div.g-main-bg ul.g-gxlist-imgbox li a').each(function(idx, element) {

var $element = $(element);

var $subElement = $element.find('img');

var thumbImgSrc = $subElement.attr('src');

items.push({

title: $(element).attr('title'),

href: $element.attr('href'),

thumbSrc: thumbImgSrc

});

});

res.json({ code: 200, msg: "", data: items });

});

});

var server = app.listen(8081, function() {

var host = server.address().address

var port = server.address().port

console.log("应用实例,访问地址为 http://%s:%s", host, port)

})

运行demo.js就会返回我们拿到的数据,一个简单的node爬虫就完成了。希望可以到 项目node爬虫 上点一个 star 作为你对这个项目的认可与支持,谢谢。

node:爬虫爬取网页图片

注:本文著作权归作者,由demo大师代发,拒绝转载,转载需要作者授权

node:爬虫爬取网页图片的更多相关文章

- erlang 爬虫——爬取网页图片

说起爬虫,大家第一印象就是想到了python来做爬虫.其实,服务端语言好些都可以来实现这个东东. 在我们日常上网浏览网页的时候,经常会看到一些好看的图片,我们就希望把这些图片保存下载,或者用户用来做桌 ...

- Python多线程爬虫爬取网页图片

临近期末考试,但是根本不想复习!啊啊啊啊啊啊啊!!!! 于是做了一个爬虫,网址为 https://yande.re,网页图片为动漫美图(图片带点颜色........宅男福利 github项目地址为:h ...

- Python爬虫爬取网页图片

没想到python是如此强大,令人着迷,以前看见图片总是一张一张复制粘贴,现在好了,学会python就可以用程序将一张张图片,保存下来. 今天逛贴吧看见好多美图,可是图片有点多,不想一张一张地复制粘贴 ...

- java爬虫-简单爬取网页图片

刚刚接触到“爬虫”这个词的时候是在大一,那时候什么都不明白,但知道了百度.谷歌他们的搜索引擎就是个爬虫. 现在大二.再次燃起对爬虫的热爱,查阅资料,知道常用java.python语言编程,这次我选择了 ...

- python3爬虫爬取网页思路及常见问题(原创)

学习爬虫有一段时间了,对遇到的一些问题进行一下总结. 爬虫流程可大致分为:请求网页(request),获取响应(response),解析(parse),保存(save). 下面分别说下这几个过程中可以 ...

- python requests库爬取网页小实例:爬取网页图片

爬取网页图片: #网络图片爬取 import requests import os root="C://Users//Lenovo//Desktop//" #以原文件名作为保存的文 ...

- Python3简单爬虫抓取网页图片

现在网上有很多python2写的爬虫抓取网页图片的实例,但不适用新手(新手都使用python3环境,不兼容python2), 所以我用Python3的语法写了一个简单抓取网页图片的实例,希望能够帮助到 ...

- python爬虫-爬取百度图片

python爬虫-爬取百度图片(转) #!/usr/bin/python# coding=utf-8# 作者 :Y0010026# 创建时间 :2018/12/16 16:16# 文件 :spider ...

- 利用Python爬取网页图片

最近几天,研究了一下一直很好奇的爬虫算法.这里写一下最近几天的点点心得.下面进入正文: 你可能需要的工作环境: Python 3.6官网下载 我们这里以sogou作为爬取的对象. 首先我们进入搜狗图片 ...

随机推荐

- Android Studio 2.3更换默认的ConstraintLayout布局

首先打开你的Android Sudio安装目录,我的为D:\Program Files\Android\Android Studio,进入到以下文件夹\plugins\android\lib\temp ...

- 新手必须掌握的Linux命令(上)

1.1强大好用的Shell 通常来讲,计算机硬件是有运算器,控制器,存储器,输入/ 输出设备等共同组成的,而让各种硬件设备各司其职且又能协同运行的东西就是系统内核.Linux系统的内核负责完成对 ...

- PAT甲级1013. Battle Over Cities

PAT甲级1013. Battle Over Cities 题意: 将所有城市连接起来的公路在战争中是非常重要的.如果一个城市被敌人占领,所有从这个城市的高速公路都是关闭的.我们必须立即知道,如果我们 ...

- Windows系统默认调试器设置

Windows系统默认调试器设置 1.使用运行打开drwtsn32 -i 注册华生医生到注册表如图: 2.使用运行打开drwtsn32可以进行一些常用的设置如图: 3. 注册表设置: HKEY_LOC ...

- [转].net reactor 学习系列(四)---.net reactor应用场景

前面已经学习了.net reactor一些基础知识,现在准备学习下实际的应用场景,只是简单的保护和许可证发放场景.如果想应用更高级的场景比如自动化程序许可证的发放及自定义客户端的过期提示等等就需要自己 ...

- 实施CMMI3的体会

公司从去年年底开始实施CMMI3,记得当初上培训课的时候,听着老师介绍过程管理,项目管理,工程过程,支持过程这四大类过程域的时候,全部门上下听得稀里糊涂,从未想到这个鬼东西还这么复杂,这么麻烦. 公司 ...

- XmlnsDefinitionAttribute Is Pretty Nifty

When we want to declaratively use our custom controls or reference the types we defined in XAML, we ...

- ssh 远程登陆指定端口

ssh 到指定端口 ssh -p xx user@ip xx 为 端口号 user为用户名 ip为要登陆的ip SSH 原理及远程登录 http://www.ruanyifeng ...

- jeecms运行出现 Expected to read 4 bytes, read 0 bytes before connection was unexpectedly lost.解决

在/WEB-INF/config/application-context.xml中添加红色字体内容: <bean id="dataSource" class="co ...

- [Linux] git send-email的使用

1. git send-email is included in an individual package, named "git-email":$ sudo apt-get i ...