MapReduce原理——Shuffle机制

在Map方法之后,Reduce方法之前的数据处理过程称之为Shuffle.

Map方法输出的数据会获得对应的分区,进入环形缓冲区(缓冲区一半写索引,另一半写数据)。数据达到缓冲区的80%会发生溢写。在溢写之前会对key索引进行快排(按照数据字典),最后对分区进行归并排序。在归并后还可进行对数据的压缩,帮助将数据写入磁盘中。

Partition分区

要求将统计结果按照条件输出到不同的文件中(分区)。比如手机号按照归属地不同身份输出到不同文件中(分区)

源码分析

以wordCount

在driver中添加代码

instance.setNumReduceTasks(2);

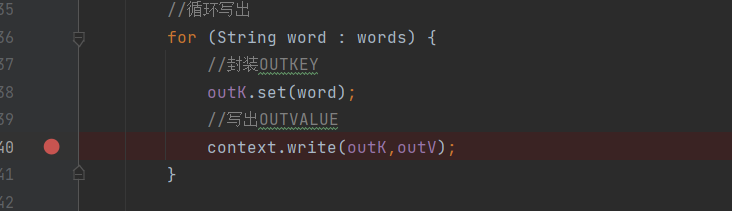

在mapper中的context.write()方法打断点

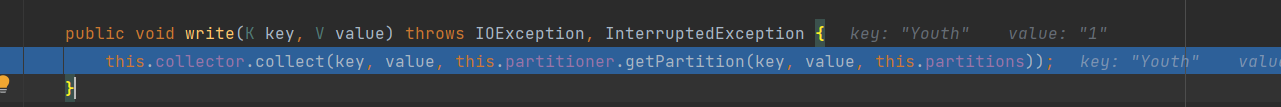

进入最后的write()方法里,collector就是环形缓冲区,然后进去参数里的方法

进入获得分区的方法 getPartition()

public int getPartition(K key, V value, int numReduceTasks) {

return (key.hashCode() & Integer.MAX_VALUE) % numReduceTasks;

}

这个方法是设置的默认分区,根据key的hashCode对ReduceTask个数取模得到的,用户没法控制那个key存储到分区中。

自定义Partitioner步骤:

定义类继承Partitioner,重写getPartitioner()方法

在job驱动中设置定义的partitioner.

设置reducetask的数量。

自定义设置分区案例

package com.rsh.mapreduce.partitioner2; import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Partitioner; public class ProvincePartitioner extends Partitioner<Text,FlowBean>{

@Override

public int getPartition(Text text, FlowBean flowBean, int numPartitions) { int partition;

String phone = text.toString();

String prePhone = phone.substring(0, 3); if("136".equals(prePhone)){

partition = 0;

} else if ("137".equals(prePhone)) {

partition = 1;

}else if ("138".equals(prePhone)) {

partition = 2;

}else if ("139".equals(prePhone)) {

partition = 3;

}else {

partition = 4;

} return partition;

} }

package com.rsh.mapreduce.partitioner2; import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat; import java.io.IOException; public class FlowDriver {

public static void main(String[] args) throws IOException, InterruptedException, ClassNotFoundException {

//获取job对象

Configuration configuration = new Configuration();

Job job = Job.getInstance(configuration); //关联本driver类

job.setJarByClass(FlowDriver.class); //关联Mapper、Reducer类

job.setMapperClass(FlowMapper.class);

job.setReducerClass(FlowReducer.class); //设置Map的outKV类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(FlowBean.class); //设置程序最终输出类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(FlowBean.class); job.setPartitionerClass(ProvincePartitioner.class); job.setNumReduceTasks(5); //设置程序的输入输出路径

FileInputFormat.setInputPaths(job,new Path("D:\\hadoopMR\\MRInput\\flow.txt"));

FileOutputFormat.setOutputPath(job,new Path("D:\\hadoopMR\\MROutput5")); //提交job

boolean b = job.waitForCompletion(true);

System.exit(b ? 0 : 1);

}

}

MapReduce原理——Shuffle机制的更多相关文章

- MapReduce(五) mapreduce的shuffle机制 与 Yarn

一.shuffle机制 1.概述 (1)MapReduce 中, map 阶段处理的数据如何传递给 reduce 阶段,是 MapReduce 框架中最关键的一个流程,这个流程就叫 Shuffle:( ...

- Hadoop(17)-MapReduce框架原理-MapReduce流程,Shuffle机制,Partition分区

MapReduce工作流程 1.准备待处理文件 2.job提交前生成一个处理规划 3.将切片信息job.split,配置信息job.xml和我们自己写的jar包交给yarn 4.yarn根据切片规划计 ...

- MapReduce框架原理--Shuffle机制

Shuffle机制 Mapreduce确保每个reducer的输入都是按键排序的.系统执行排序的过程(Map方法之后,Reduce方法之前的数据处理过程)称之为Shuffle. partition分区 ...

- 【待完成】[MapReduce_9] MapReduce 的 Shuffle 机制

0. 说明 待补充...

- Hadoop(十四)MapReduce原理分析

前言 上一篇我们分析了一个MapReduce在执行中的一些细节问题,这一篇分享的是MapReduce并行处理的基本过程和原理. Mapreduce是一个分布式运算程序的编程框架,是用户开发“基于had ...

- Hadoop — MapReduce原理解析

1. 概述 Mapreduce是一个分布式运算程序的编程框架,是用户开发"基于hadoop的数据分析应用"的核心框架: Mapreduce核心功能是将用户编写的业务逻辑代码和自带默 ...

- MapReduce原理2

MapReduce的shuffle机制 1.概述 mapreduce中,map阶段处理的数据如何传递给reduce阶段,是mapreduce框架中最关键的一个流程,这个流程就叫shuffle: shu ...

- MAPREDUCE原理篇2

mapreduce的shuffle机制 概述: mapreduce中,map阶段处理的数据如何传递给reduce阶段,是mapreduce框架中最关键的一个流程,这个流程就叫shuffle: shuf ...

- Hadoop_18_MapRduce 内部的shuffle机制

1.Mapreduce的shuffle机制: Mapreduce中,map阶段处理的数据如何传递给Reduce阶段,是mapreduce框架中最关键的一个流程,这个流程就叫shuffle 将mapta ...

- MapReduce实例2(自定义compare、partition)& shuffle机制

MapReduce实例2(自定义compare.partition)& shuffle机制 实例:统计流量 有一份流量数据,结构是:时间戳.手机号.....上行流量.下行流量,需求是统计每个用 ...

随机推荐

- 一类(One-Class)分类器

本文摘自博客和论文,参考文献请看文末. 一类分类技术概念 与传统的分类技术不同,一类分类技术仅采用隶属于一个类别的样本来训练分类器,其通常被用于某种极端场景,即训练样本仅包含正常样本,而异常样本不可得 ...

- 电脑本地安装不同版本MySQL

本地已经安装了mysql5.7版本,想测试mysql8版本的用法,想在一台电脑同时配置不同版本的mysql在不同端口号,看起来简单,实现起来其实挺多坑的,总结下实战经验和大家分享下 一.下载安装 下载 ...

- postgresql的mysql外部数据扩展mysql_fdw编译及安装

下载mysql_fdw项目文件:https://pgxn.org/dist/mysql_fdw/ 注:我使用的是ubuntu18.04,可以直接在仓库查看是否有二级制安装文件,当然是有的啦,这是很方便 ...

- 【LeetCode】三数之和+四数之和(双指针)

之所以放在一起是因为,"四数之和"的解题方法基本与"三数之和"一致 由此我们可以推出n数之和的解法 本质上,我们只是使用双指针的方法降低此类问题的时间复杂度 当 ...

- 用Redis实现延迟队列,我研究了两种方案,发现并不简单

大家好,我是三友~~ 背景 前段时间有个小项目需要使用延迟任务,谈到延迟任务,我脑子第一时间一闪而过的就是使用消息队列来做,比如RabbitMQ的死信队列又或者RocketMQ的延迟队列,但是奈何这是 ...

- .NET 支付宝SDK新版 AlipayEasySDK 配置文件详细说明

config代码: using Tea; namespace Alipay.EasySDK.Kernel { /// <summary> /// 客户端配置参数模型 /// </su ...

- fiddler的简单使用

一.fiddler接口测试介绍 二.fiddler过滤器的使用 fiddler可以指定只抓哪些包,通过filters实现 如果需要抓取多个网站,各个需要抓取的网站之间用分号隔开 三.fiddler抓取 ...

- 下午小博(java小知识)

抽象类: 抽象类中可以构造方法 抽象类中可以存在普通属性,方法,静态属性和方法 抽象类中可以存在抽象方法如果一个类中有一个抽象方法,那么当前类一定是抽象类:抽象类中不一定有抽象方法 抽象类中的抽象方法 ...

- 修改Element - plus的样式

把显示再浏览器上的对应css选择器全部写上,并且添加 !important </script> <style lang='scss' scoped> //修改 element ...

- 滴水2.c++构造 与 继承

1.构造函数特点 2.析构函数的特点: 析构函数前面必须有~ 3.继承 一个子类可以有多个父类 作业1. #include<stdio.h> struct DateInfo { int y ...