IMDB电影排行爬取分析

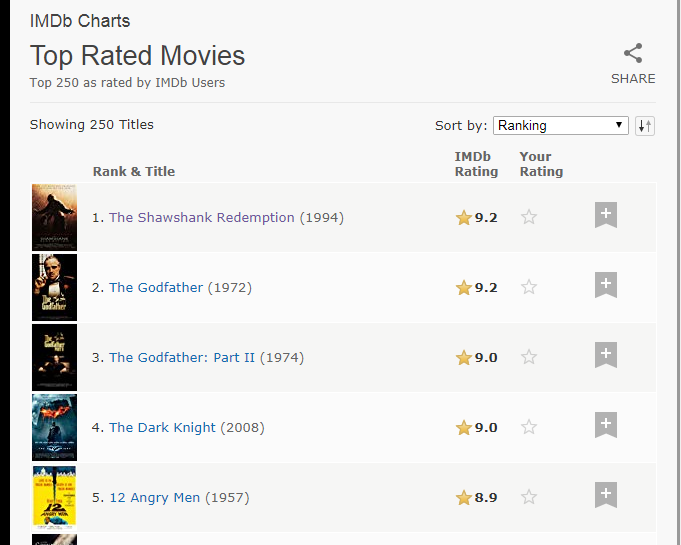

一.打开IMDB电影T250排行可以看见250条电影数据,电影名,评分等数据都可以看见

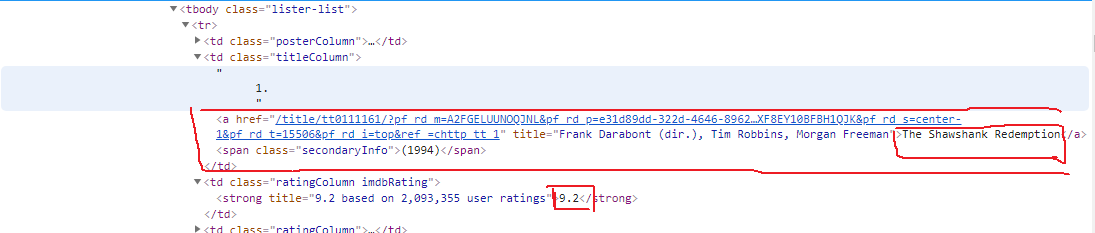

按F12进入开发者模式,找到这些数据对应的HTML网页结构,如下所示

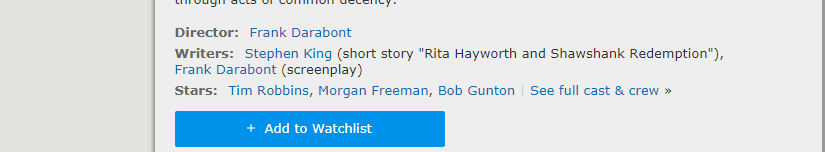

可以看见里面有链接,点击链接可以进入电影详情页面,这可以看见导演,编剧,演员信息

同样查看HTML结构,可以找到相关信息的节点位置

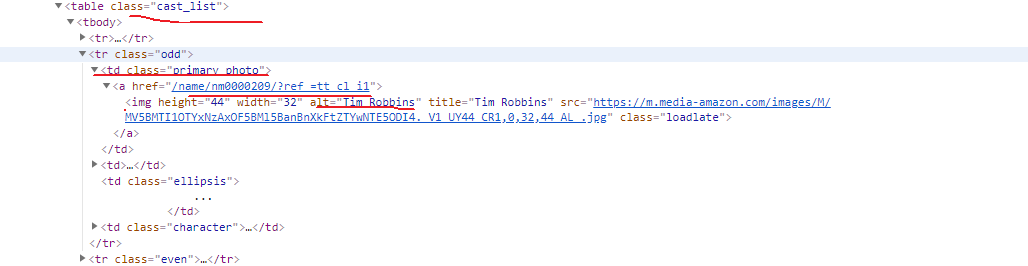

演员信息可以在这个页面的cast中查看完整的信息

HTML页面结构

分析完整个要爬取的数据,现在来获取首页250条电影信息

1.整个爬虫代码需要使用的相关库

import re

import pymysql

import json

import requests

from bs4 import BeautifulSoup

from requests.exceptions import RequestException

2.请求首页的HTML网页,(如果请求不通过可以添加相关Header),返回网页内容

def get_html(url):

response=requests.get(url)

if response.status_code==200:

#判断请求是否成功

return response.text

else:

return None

3.解析HTML

def parse_html(html):

#进行页面数据提取

soup = BeautifulSoup(html, 'lxml')

movies = soup.select('tbody tr')

for movie in movies:

poster = movie.select_one('.posterColumn')

score = poster.select_one('span[name="ir"]')['data-value']

movie_link = movie.select_one('.titleColumn').select_one('a')['href']

#电影详情链接

year_str = movie.select_one('.titleColumn').select_one('span').get_text()

year_pattern = re.compile('\d{4}')

year = int(year_pattern.search(year_str).group())

id_pattern = re.compile(r'(?<=tt)\d+(?=/?)')

movie_id = int(id_pattern.search(movie_link).group())

#movie_id不使用默认生成的,从数据提取唯一的ID

movie_name = movie.select_one('.titleColumn').select_one('a').string

#使用yield生成器,生成每一条电影信息

yield {

'movie_id': movie_id,

'movie_name': movie_name,

'year': year,

'movie_link': movie_link,

'movie_rate': float(score)

}

4.我们可以保存文件到txt文本

def write_file(content):

with open('movie12.txt','a',encoding='utf-8')as f:

f.write(json.dumps(content,ensure_ascii=False)+'\n') def main():

url='https://www.imdb.com/chart/top'

html=get_html(url)

for item in parse_html(html):

write_file(item) if __name__ == '__main__':

main()

5.数据可以看见

6.如果成功了,可以修改代码保存数据到MySQL,使用Navicat来操作非常方便先连接到MySQL

db = pymysql.connect(host="localhost", user="root", password="********", db="imdb_movie")

cursor = db.cursor()

创建数据表

CREATE TABLE `top_250_movies` (

`id` int(11) NOT NULL,

`name` varchar(45) NOT NULL,

`year` int(11) DEFAULT NULL,

`rate` float NOT NULL,

PRIMARY KEY (`id`)

)

接下来修改代码,操作数据加入数据表

def store_movie_data_to_db(movie_data):

sel_sql = "SELECT * FROM top_250_movies \

WHERE id = %d" % (movie_data['movie_id'])

try:

cursor.execute(sel_sql)

result = cursor.fetchall()

except:

print("Failed to fetch data")

if result.__len__() == 0:

sql = "INSERT INTO top_250_movies \

(id, name, year, rate) \

VALUES ('%d', '%s', '%d', '%f')" % \

(movie_data['movie_id'], movie_data['movie_name'], movie_data['year'], movie_data['movie_rate'])

try:

cursor.execute(sql)

db.commit()

print("movie data ADDED to DB table top_250_movies!")

except:

# 发生错误时回滚

db.rollback()

else:

print("This movie ALREADY EXISTED!!!")

运行

def main():

url='https://www.imdb.com/chart/top'

html=get_html(url)

for item in parse_html(html):

store_movie_data_to_db(item) if __name__ == '__main__':

main()

查看Navicat,可以看到保存到mysql的数据。

IMDB电影排行爬取分析的更多相关文章

- 豆瓣电影信息爬取(json)

豆瓣电影信息爬取(json) # a = "hello world" # 字符串数据类型# b = {"name":"python"} # ...

- scrapy-redis实现爬虫分布式爬取分析与实现

本文链接:http://blog.csdn.net/u012150179/article/details/38091411 一 scrapy-redis实现分布式爬取分析 所谓的scrapy-redi ...

- Scrapy项目 - 实现豆瓣 Top250 电影信息爬取的爬虫设计

通过使Scrapy框架,掌握如何使用Twisted异步网络框架来处理网络通讯的问题,进行数据挖掘和对web站点页面提取结构化数据,可以加快我们的下载速度,也可深入接触各种中间件接口,灵活的完成各种需求 ...

- 用Python爬取分析【某东618】畅销商品销量数据,带你看看大家都喜欢买什么!

618购物节,辰哥准备分析一波购物节大家都喜欢买什么?本文以某东为例,Python爬取618活动的畅销商品数据,并进行数据清洗,最后以可视化的方式从不同角度去了解畅销商品中,名列前茅的商品是哪些?销售 ...

- Python 从底层结构聊 Beautiful Soup 4(内置豆瓣最新电影排行榜爬取案例)

1. 前言 什么是 Beautiful Soup 4 ? Beautiful Soup 4(简称 BS4,后面的 4 表示最新版本)是一个 Python 第三方库,具有解析 HTML 页面的功能,爬虫 ...

- python 豆瓣top250电影的爬取

我们先看一下豆瓣的robot.txt 然后我们查看top250的网页链接和源代码 通过对比不难发现网页间只是start数字发生了变化. 我们可以知道电影内容都存在ol标签下的 div class属性为 ...

- 豆瓣电影top250爬取并保存在MongoDB里

首先回顾一下MongoDB的基本操作: 数据库,集合,文档 db,show dbs,use 数据库名,drop 数据库 db.集合名.insert({}) db.集合名.update({条件},{$s ...

- Python爬虫+可视化教学:爬取分析宠物猫咪交易数据

前言 各位,七夕快到了,想好要送什么礼物了吗? 昨天有朋友私信我,问我能用Python分析下网上小猫咪的数据,是想要送一只给女朋友,当做礼物. Python从零基础入门到实战系统教程.源码.视频 网上 ...

- Scrapy项目 - 数据简析 - 实现豆瓣 Top250 电影信息爬取的爬虫设计

一.数据分析截图(weka数据分析截图 ) 本例实验,使用Weka 3.7对豆瓣电影网页上所罗列的上映电影信息,如:标题.主要信息(年份.国家.类型)和评分等的信息进行数据分析,Weka 3.7数据分 ...

随机推荐

- influxDB+telefraf+grafana

此贴自己记录 下载grafana https://grafana.com/grafana/download?platform=windows 从官网下载influxDB\telefraf的方法 : h ...

- qemu常见选项解析

1 -hda file -hdb file.-hdc file.-hdd file 把文件当成hard disk 0.hard disk 1.hard disk 2和hard disk 3. 2 -a ...

- Bootstrap Tooltip源码分析

/* ======================================================================== * Bootstrap: tooltip.js ...

- 我为什么从python转向go

应puppet大拿刘宇的邀请,我去西山居运维团队做了一个简短分享,谈谈为什么我要将我们的项目从python转向go. 坦白的讲,在一帮python用户面前讲为什么放弃python转而用go其实是一件压 ...

- POJ 2104 HDU 2665 主席树 解决区间第K大

两道题都是区间第K大询问,数据规模基本相同. 解决这种问题, 可以采用平方划分(块状表)复杂度也可以接受,但是实际表现比主席树差得多. 这里大致讲一下我对主席树的理解. 首先,如果对于某个区间[L,R ...

- 如何给自己的博客上添加个flash宠物插件

最近在一些博主的博客上看到一些小宠物的挂件,很有趣,访客到了网站后可以耍耍小宠物,增加网站的趣味性,在功能强大的博客系统上看到有这样的小宠物挂件还是蛮有趣的. 多次差找资料后,终于在http://ww ...

- E20180109-E

auxilary adj. 辅助的; 备用的,补充的; 附加的; 副的; n. 助动词; 辅助者,辅助人员; 附属机构,附属团体; 辅助设备;

- bzoj 1087: [SCOI2005]互不侵犯King【状压dp】

显然是状压,设f[i][j][k]为1到i行选j个king,并且第i行状态为k的方案数,判断是否可行然后枚举转移即可 先把可行状态预处理出来会变快 #include<iostream> # ...

- Akka源码分析-Cluster-Metrics

一个应用软件维护的后期一定是要做监控,akka也不例外,它提供了集群模式下的度量扩展插件. 其实如果读者读过前面的系列文章的话,应该是能够自己写一个这样的监控工具的.简单来说就是创建一个actor,它 ...

- (数论)51NOD 1135 原根

设m是正整数,a是整数,若a模m的阶等于φ(m),则称a为模m的一个原根.(其中φ(m)表示m的欧拉函数) 给出1个质数P,找出P最小的原根. Input 输入1个质数P(3 <= P &l ...