大二暑假第七周总结--开始学习Hadoop基础(六)

复习关于Hadoop的操作语句以及重点

Shell版

- 跳转目录到Hadoop:

cd /usr/local/hadoop

启动Hadoop:

./sbin/start-dfs.sh

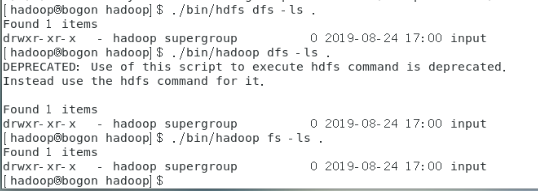

注意:Hadoop实际上有三种shell命令方式:hadoop fs/hadoop dfs/hdfs dfs,hadoop fs适用于任何不同的文件系统,比如本地文件系统和HDFS文件系统,hadoop dfs只能适用于HDFS文件系统,hdfs dfs跟hadoop dfs的命令作用一样,也只能适用于HDFS文件系统(使用命令前需要先启动Hadoop)

- 在HDFS上创建/user/hadoop目录:

./bin/hdfs dfs –mkdir –p /user/hadoop

(“-p”表示如果是多级目录,则父目录和子目录一起创建,这里“/user/hadoop”就是一个多级目录,因此必须使用参数“-p”,否则会出错)列出当前目录下的所有目录或者文件:./bin/hdfs dfs –ls . (“.”表示HDFS中的当前用户目录,也就是“/user/hadoop”目录,等价于./bin/hdfs dfs –ls /user/hadoop,如果要列出HDFS上所有目录:./bin/hdfs dfs –ls ),使用先对路径创建文件夹:./bin/hdfs dfs –mkdir /input(在/user/hadoop目录下创建了input文件夹)

- 删除input目录:

./bin/hdfs dfs –rm –r /input

(“-r”参数表示如果删除“/input”目录及其子目录下的所有内容,如果要删除的一个目录包含了子目录,则必须使用“-r”参数,否则会执行失败)

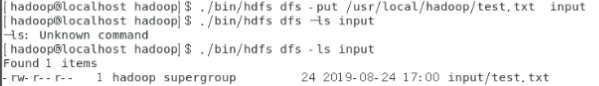

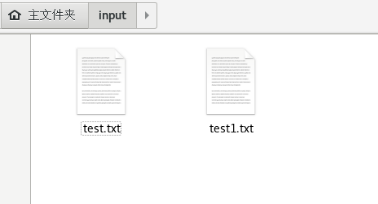

- 上传本地文件(/usr/local/hadoop/test.txt)到HDFS的input目录:

./bin/hdfs dfs -put /usr/local/hadoop/test.txt input

可以使用ls查看是否上传到HDFS中

注意:图片中显示-ls:Unknown command是由于在从电脑复制命令到虚拟机时产生编码错误,在第二个命令时没有出现这个问题,所以在复制的时候注意编码问题。

- 查看HDFS中的test.TXT文件:

./bin/hdfs dfs –cat input/text.txt

- 将文件下载到本地usr/local/hadoop目录下:

./bin/hdfs dfs -get input/test.txt /usr/local/hadoop

- 将HDFS上的test.txt文件复制到HDFS上另一个位于根目录的input目录:

./bin/hdfs dfs -cp input/test.txt /input

- 上传到HDFS的文件以覆盖的形式上传:

./bin/hadoop fs -copyFromLocal -f /home/hadoop/input/test.txt /input/test.txt

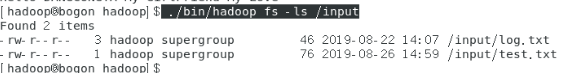

- 显示 HDFS 中指定的文件的读写权限、大小、创建时间、路径等信息

./bin/hadoop fs -ls /input

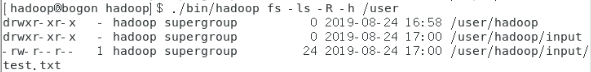

- 给定HDFS中某一个目录,输出该目录下的所有文件的读写权限、大小、创建时间、路径等信息,如果该文件是目录,则递归输出该目录下所有文件相关信息

./bin/hadoop fs -ls -R -h /user

- 删除HDFS中指定的文件

./bin/hadoop fs -rm /user/hadoop/input/log.txt

- 向 HDFS 中指定的文件追加内容,由用户指定内容追加到原有文件的结尾

./bin/hadoop fs -appendToFile /home/hadoop/input/testadd.txt /input/test.txt

向HDFS中指定的文件追加内容,由用户指定内容追加到原有文件的开头(采用的方法是先将HDFS中的文件下载到本地,然后使用cat添加到开头,然后将文件上传)

hadoop fs -get /input/test.txt /home/hadoop/input

cat /home/hadoop/input/test.txt >> /home/hadoop/input/testadd.txt

mv /home/hadoop/input/testadd.txt /home/hadoop/input/test.txt

hadoop fs -put -f /home/hadoop/input/test.txt /input 从HDFS中下载指定文件,如果本地文件中药下载的文件名称相同,则自动对下载的文件重命名

if $(hadoop fs -test -e /home/hadoop/input/test.txt);

then $(hadoop fs -copyToLocal /input/test.txt /home/hadoop/input/test.txt);

else $(hadoop fs -copyToLocal /input/test.txt /home/hadoop/input/test1.txt);

fi

大二暑假第七周总结--开始学习Hadoop基础(六)的更多相关文章

- 大二暑假第五周总结--开始学习Hadoop基础(四)

简单学习MapReduce并进行WordCount实践 分布式并行编程: MapReduce设计的一个理念就是“计算向数据靠拢”,将复杂的,运行于大规模集群上的并行计算过程高度地抽象到两个函数:Map ...

- 大二暑假第三周总结--开始学习Hadoop基础(二)

简单学习NoSQL数据库理论知识 NoSQL数据库具有以下几个特点: 1.灵活的可扩展性(支持在多个节点上进行水平扩张) 2.灵活的数据模型(与关系数据库中严格的关系模型相反,显得较为松散) 3.与与 ...

- 大二暑假第二周总结--开始学习Hadoop基础(一)

一.简单视频学习Hadoop的处理架构 二.简单视频学习分布式文件系统HDFS并进行简单的实践操作 简单操作教程:http://dblab.xmu.edu.cn/blog/290-2/ 注意:在建立H ...

- 大二暑假第六周总结--开始学习Hadoop基础(五)

简单学习数据仓库HIVE HIVE是一个构建于Hadoop顶端的数据仓库工具 支持大规模数据存储,分析,具有良好的可扩展性 某种程度上可以看做是用户编程接口,本身不存储和处理数据 依赖分布式系统HDF ...

- 20145330第七周《Java学习笔记》

20145330第七周<Java学习笔记> 第十三章 时间与日期 认识时间与日期 时间的度量 GMT(格林威治标准时间):现在不是标准时间 世界时(UT):1972年UTC出来之前,UT等 ...

- Redis总结(五)缓存雪崩和缓存穿透等问题 Web API系列(三)统一异常处理 C#总结(一)AutoResetEvent的使用介绍(用AutoResetEvent实现同步) C#总结(二)事件Event 介绍总结 C#总结(三)DataGridView增加全选列 Web API系列(二)接口安全和参数校验 RabbitMQ学习系列(六): RabbitMQ 高可用集群

Redis总结(五)缓存雪崩和缓存穿透等问题 前面讲过一些redis 缓存的使用和数据持久化.感兴趣的朋友可以看看之前的文章,http://www.cnblogs.com/zhangweizhon ...

- Pytorch_第七篇_深度学习 (DeepLearning) 基础 [3]---梯度下降

深度学习 (DeepLearning) 基础 [3]---梯度下降法 Introduce 在上一篇"深度学习 (DeepLearning) 基础 [2]---神经网络常用的损失函数" ...

- 大二暑假第一周总结--初次安装配置Hadoop

本次配置主要使用的教程:http://dblab.xmu.edu.cn/blog/install-hadoop-in-centos/ 以下是自己在配置中的遇到的一些问题和解决方法,或者提示 一.使用虚 ...

- 暑假第七周总结(安装MongoDB和Tomcat以及MongoDB进行编程实践)

本周主要对MongoDB和Tomcat进行了安装,两项安装都遇到了一些问题.其中在对MongoDB安装过程中出现了什么没有秘钥安全证书的,最终找了一堆教程重复了好多遍之后安装成功,虽然在启动和关闭的时 ...

随机推荐

- 「NOIP2009」靶形数独

传送门 Luogu 解题思路 这题其实挺简单的. 首先要熟悉数独,我们应该要优先搜索限制条件多的行,也就是可能方案少的行,显然这样可以剪枝,然后再发挥一下dfs的基本功就可以了. 细节注意事项 爆搜题 ...

- 0. GC 前置知识

阅读<垃圾回收的算法与实现>时记录的一些笔记. 对象 在GC的世界中,对象表示的是"通过应用程序利用的数据的集合" 头 我们将对象中保存对象本身信息的部分称为头.头主要 ...

- No 'Access-Control-Allow-Origin'跨域问题- (mysql-thinkphp) (6)

因为ajax请求一个服务的时候,服务器端,比如thinkphp端,或者java框架,它会检测,你请求时候的域名,就是http请求的时候,request header不是会把客户端的Request UR ...

- zabbix 监控linux tcp连接数

zabbix 监控linux tcp连接数 作者:尹正杰 版权声明:原创作品,谢绝转载!否则将追究法律责任. 一.TCP的状态概述 1>.端口状态转换 2>.TCP 三次握手 3>. ...

- springboot2.1以javabean整合rabbitmq及自动注入rabbitmqTemplate为空问题

springboot集成rabbitmq之前也写过,这次再来个总结,总体来讲比较简单 主要就是配置属性文件,将属性以javabean的形式注入,配置工厂,对象等原来以xml<bean>形式 ...

- Java提升二:Lambda表达式与方法引用

1.Lambda表达式 1.1.定义 lambda表达式是对于函数式接口(只含有一个抽象方法的接口)的简洁实现方式.它与匿名内部类的作用相似,但是就使用范围而言,匿名内部类更为广泛,而lambda表达 ...

- pyhton中matplotlib箱线图的绘制(matplotlib双轴图、箱线图、散点图以及相关系数矩阵图))

//2019.07.23 1.箱形图,又称为盒式图,一般可以很好地反映出数据分布的特征,也可以进行多项数据之间分布特征的比较,它主要包含五个基础数据:中位数,两个上下分位数以及上下边缘线数据 其中的一 ...

- JuJu团队11月29号工作汇报

JuJu团队11月29号工作汇报 JuJu Scrum 团队成员 今日工作 剩余任务 困难 于达 生成所有mini batch, 支持不同batch_size 优化代码 熟悉julia 婷婷 ...

- java时间差

以下代码没什么意义,只是记录 long mstart = System.nanoTime(); int mIndex = 0 ; for (int i = 0; i < 100000000; i ...

- Asp.net禁用site.Mobile.Master

RT,在asp.net新的项目中遇到的一个问题.项目使用了Boostrap后网页打开是正常的,但是换成移动端打开这个网页的时候就奇怪了.很多样式不见了.原来是自动切换到了site.Mobile.Mas ...