Spark中Task数量的分析

本文主要说一下Spark中Task相关概念、RDD计算时Task的数量、Spark Streaming计算时Task的数量。

Task作为Spark作业执行的最小单位,Task的数量及运行快慢间接决定了作业运行的快慢。

开始

先说明一下Spark作业的几个核心概念:

Job(作业):Spark根据行动操作触发提交作业,以行动操作将我们的代码切分为多个Job。

Stage(调度阶段):每个Job中,又会根据宽依赖将Job划分为多个Stage(包括ShuffleMapStage和ResultStage)。

Task(任务):真正执行计算的部分。Stage相当于TaskSet,每个Stage内部包含了多个Task,将各个Task下发到各个Executor执行计算。

每个Task的处理逻辑完全一样,不同的是对应处理的数据。即:移动计算而不是移动数据。

Partition(分区):这个是针对RDD而言的,RDD内部维护了分区列表,表示数据在集群中存放的不同位置。

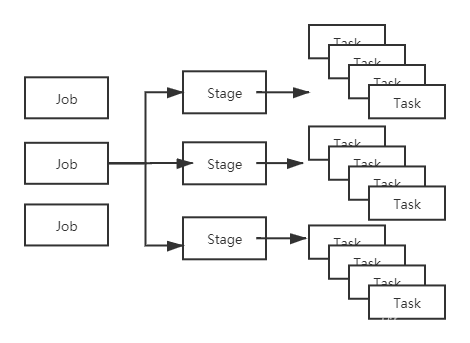

Job、Stage、Task的对应关系如下:

Task是真正干活的,所以说是它间接决定了Spark程序的快慢也不过分。

再看看Spark任务提交时的几个相关配置:

num-executors:配置执行任务的Executor的数量。

executor-cores:每个Executor的核的数量。此核非彼核,它不是机器的CPU核,可以理解为Executor的一个线程。

每个核同时只可以执行一个Task。

也就是说一个Spark应用同时执行的任务数 = 用于执行任务的Executor数 * 每个Executor的核数。

spark.executor.memory:每个Executor的内存大小。

spark.default.parallelism:RDD的默认分区数。

在我们没有指定这个参数的前提下,如果是shuffle操作,这个值默认是父RDD中分区数较大的那个值;如果是普通操作,这个值的默认大小取决于集群管理器(YARN, Local这些)。

以YARN为例,如果我们没有指定,它的大小就是所有用于执行任务的Executor核的总数。

spark.sql.shuffle.partitions:这个配置是针对于Spark SQL在shuffle时的默认分区数。默认值是200。只对Spark SQL起作用。

RDD计算时Task的数量

在基于RDD计算时,Task的数量 = RDD的分区数。

所以调整RDD分区的数量就可以变相的调整Task的数量。

所以当RDD计算跑的很慢时,可以通过适当的调整RDD分区数来实现提速。

看看Spark.parallelize生成RDD时的源码实现:

def parallelize[T: ClassTag](

seq: Seq[T],

numSlices: Int = defaultParallelism): RDD[T] = withScope {

assertNotStopped()

new ParallelCollectionRDD[T](this, seq, numSlices, Map[Int, Seq[String]]())

}

// 这里的taskScheduler.defaultParallelism就是

// 取的配值中spark.default.parallelism的值。

def defaultParallelism: Int = {

assertNotStopped()

taskScheduler.defaultParallelism

}

可以发现通过Spark.parallelize创建的RDD分区,如果我们不指定分区数,那么分区数就是由配置的spark.default.parallelism来决定。

Spark读Hive、HDFS时的Task数量

这块之后补上来。。。

Spark Streaming流处理时的Task数量

Spark Streaming作为Spark中用于流处理的一员,它的原理就是运行一个接收器接收数据,然后将接收的数据按块进行存储,之后划分Job,执行Task处理数据。

ok,Spark Streaming最后也会转换成Task进行数据的处理,也就是Task运行速度也会影响它处理数据的速度。

Spark Streaming中Task的数量是由用来存储接收到数据的Block数来决定的。

那么只要控制Block的数量就可以控制Task的数量。

如下代码所示,Block是由一个定时器定时生成的。

// 块生成间隔时间

private val blockIntervalMs = conf.getTimeAsMs("spark.streaming.blockInterval", "200ms")

// 一个定时器,按块生成间隔时间定时根据接收到的数据生成块。

private val blockIntervalTimer = new RecurringTimer(clock, blockIntervalMs, updateCurrentBuffer, "BlockGenerator")

所以Block的数量 = 批处理间隔时间 / 块生成间隔时间。

块生成间隔时间是由配置spark.streaming.blockInterval决定的,默认是200ms,最小是50ms。

所以当Spark Streaming的Task数量成为性能的瓶颈时,可以通过调整参数来调整Task的数量。

总结

1、Task是Spark的最小执行单位,Executor每个核同时只能执行一个Task。

2、RDD计算时,Task数量与分区数对应;Spark Streaming中,Task数量由Block数决定。

3、根据分配的资源以及作业的运行情况,适当调整Task数量。

4、移动计算而不是移动数据。

end. 个人理解,如果偏差欢迎指正。

个人公众号:码农峰,定时推送行业资讯,持续发布原创技术文章,欢迎大家关注。

Spark中Task数量的分析的更多相关文章

- Spark中Task,Partition,RDD、节点数、Executor数、core数目(线程池)、mem数

Spark中Task,Partition,RDD.节点数.Executor数.core数目的关系和Application,Driver,Job,Task,Stage理解 from:https://bl ...

- 【原】 Spark中Task的提交源码解读

版权声明:本文为原创文章,未经允许不得转载. 复习内容: Spark中Stage的提交 http://www.cnblogs.com/yourarebest/p/5356769.html Spark中 ...

- 【原】Spark中Client源码分析(二)

继续前一篇的内容.前一篇内容为: Spark中Client源码分析(一)http://www.cnblogs.com/yourarebest/p/5313006.html DriverClient中的 ...

- 【原】Spark中Master源码分析(二)

继续上一篇的内容.上一篇的内容为: Spark中Master源码分析(一) http://www.cnblogs.com/yourarebest/p/5312965.html 4.receive方法, ...

- 【原】 Spark中Worker源码分析(二)

继续前一篇的内容.前一篇内容为: Spark中Worker源码分析(一)http://www.cnblogs.com/yourarebest/p/5300202.html 4.receive方法, r ...

- Spark中Task,Partition,RDD、节点数、Executor数、core数目的关系和Application,Driver,Job,Task,Stage理解

梳理一下Spark中关于并发度涉及的几个概念File,Block,Split,Task,Partition,RDD以及节点数.Executor数.core数目的关系. 输入可能以多个文件的形式存储在H ...

- 【原】Spark中Master源码分析(一)

Master作为集群的Manager,对于集群的健壮运行发挥着十分重要的作用.下面,我们一起了解一下Master是听从Client(Leader)的号召,如何管理好Worker的吧. 1.家当(静态属 ...

- Spark中决策树源码分析

1.Example 使用Spark MLlib中决策树分类器API,训练出一个决策树模型,使用Python开发. """ Decision Tree Classifica ...

- 【原】Spark中Client源码分析(一)

在Spark Standalone中我们所谓的Client,它的任务其实是由AppClient和DriverClient共同完成的.AppClient是一个允许app(Client)和Spark集群通 ...

随机推荐

- 实现TabControl 选项卡首个标签缩进的方法

借用一张网图说明需求 在网上找了一圈,没有找到直接通过API或者重绘TabControl 的解决方法,最后灵机一动想到了一个折(tou)中(lan)的解决办法 Tab1.TabPages.Clear( ...

- vue中axios的post请求使用form表单格式发送数据

vue使用插件qs实现 (qs 是一个增加了一些安全性的查询字符串解析和序列化字符串的库.) 在jquery中的ajax的方法已将此封装,所以不需要再次序列化 1. 安装 在项目中使用命令行工具输 ...

- 关于 Xpath 定位

关于 Xpath 定位 问: // 和 / 的区别 表达式 描述 nodename 选取此节点的所有子节点. / 从根节点选取. // 从匹配选择的当前节点选择文档中的节点,而不考虑它们的位置. . ...

- Python 语言基础

Python 语言基础 Python 开发环境 计算机组成 编程语言(计算机语言)是人们为了控制计算机,而设计的一种符号和文字的组合,从而实现向计算机发出指令. 形式是符号和文字的组合 目的是为了控制 ...

- Ubuntu16.04中Mysql 5.7 安装配置

记录在Ubuntu 16.04安装Mysql 5.7时遇到的一些问题. Mysql安装 使用如下命令进行安装: 1 sudo apt-get install mysql-server mysql-cl ...

- JacksonUtil

package org.linlinjava.litemall.core.util; import com.fasterxml.jackson.core.type.TypeReference; imp ...

- jquey ajax 将变量值封装json传入JAVA action获取解析

最近在做一个小小的功能模块,前台有很多的数据需要传入到后台,前台页面设计如下: 看起来不是很清楚,总之表单中的数据都要提交到后台进行处理,然后插入到数据库,而且是一起提交到后台的,实现的方法大致有两种 ...

- 72)PHP,session基本原理和登录验证

(1) (2) 所以 你要是开了session,那么就会有session数据,但是假如在你的php脚本中没有开放发session,就不会有session数据

- UFT场景恢复

场景恢复: 在脚本运行中可能会出现一些非预期事件.错误.程序崩溃等情况,阻止脚本继续执行下去,在此情况下脚本可能暂停执行, 直到某些界面被操作之后才会继续执行下去,为了处理这一类事件因此存在场景恢复. ...

- TB3_Autorace之交通杆检测

利用blob检测算法识别交通杆,控制TB3机器人完成对交通杆的起停动作! 上一篇博文中<TB3_Autorace之路标检测>订阅了原始图像信息,经过SIFT检测识别出道路交通标志,这里我们 ...