python爬取数据保存到Excel中

# -*- conding:utf-8 -*- # 1.两页的内容

# 2.抓取每页title和URL

# 3.根据title创建文件,发送URL请求,提取数据

import requests

from lxml import etree

import time, random, xlwt # 专家委员会成员的xpath(‘//tbody//tr[@height='29']’) class Doc_spider(object): def __init__(self):

self.base_url = 'http://www.bjmda.com'

self.url = 'http://www.bjmda.com/Aboutus/ShowClass.asp?ClassID=12&page={}'

self.headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/52.0.2743.116 Safari/537.36'} def get_request(self, url):

'''发送请求,返回html'''

response = requests.get(url, headers=self.headers).content.decode('gbk')

# time.sleep(random.random())

html = etree.HTML(response)

return html def parse_page_html(self, html, url):

'''提取列表页的专家委员会title和URL''' url_lists = html.xpath('//tr/td[2]/a[2]/@href')[1:]

temp_lists = html.xpath('//tr/td[2]/a[2]/text()')[1:]

title_lists = [title.rstrip() for title in temp_lists] urls = []

titles = [] for i in range(len(title_lists)):

url = self.base_url + url_lists[i]

title = title_lists[i]

urls.append(url)

titles.append(title) return urls, titles def parse_detail(self, html):

'''详细页的提取数据,返回每组列表信息''' lists = html.xpath("//td[@id='fontzoom']//tr")

content_list = []

for list in lists:

contents = list.xpath('.//td//text()')

new = []

for i in contents:

new.append(''.join(i.split()))

content_list.append(new) return content_list def save_excel(self, sheet_name, contents, worksheet, workbook):

'''保存数据到Excel''' # 创建一个workbook 设置编码

#workbook = xlwt.Workbook()

# 创建一个worksheet

#worksheet = workbook.add_sheet(sheet_name) try: for i in range(len(contents)):

if len(contents[i+1])>1:

content_list = contents[i + 1] # 写入excel

# 参数对应 行, 列, 值

worksheet.write(i, 0, label=content_list[0])

worksheet.write(i, 1, label=content_list[1])

worksheet.write(i, 2, label=content_list[2])

if len(contents[i+1])>3:

worksheet.write(i, 3, label=content_list[3]) # 保存

#workbook.save(sheet_name + '.xls')

# time.sleep(0.1)

except:

print(sheet_name,'保存OK') pass def run(self):

# 1.发送专家委员会列表页请求

urls = [self.url.format(i + 1) for i in range(2)] # 创建一个workbook 设置编码

workbook = xlwt.Workbook() for url in urls:

html = self.get_request(url)

# 2.提取委员会的title和URL

list_urls, titles = self.parse_page_html(html, url) for i in range(len(list_urls)):

url_detail = list_urls[i]

# 每个委员会的名称

title_detail = titles[i]

# 3.创建每个委员会文件,发送每个委员会的请求

html_detail = self.get_request(url_detail)

# 4.提取专家委员会详细页的内容

contents = self.parse_detail(html_detail)

# 保存每个委员会的所有人 # 创建一个worksheet

worksheet = workbook.add_sheet(title_detail)

self.save_excel(title_detail, contents,worksheet,workbook)

workbook.save('专家委员会.xls')

print('保存结束,请查看') if __name__ == '__main__':

doc = Doc_spider()

doc.run()

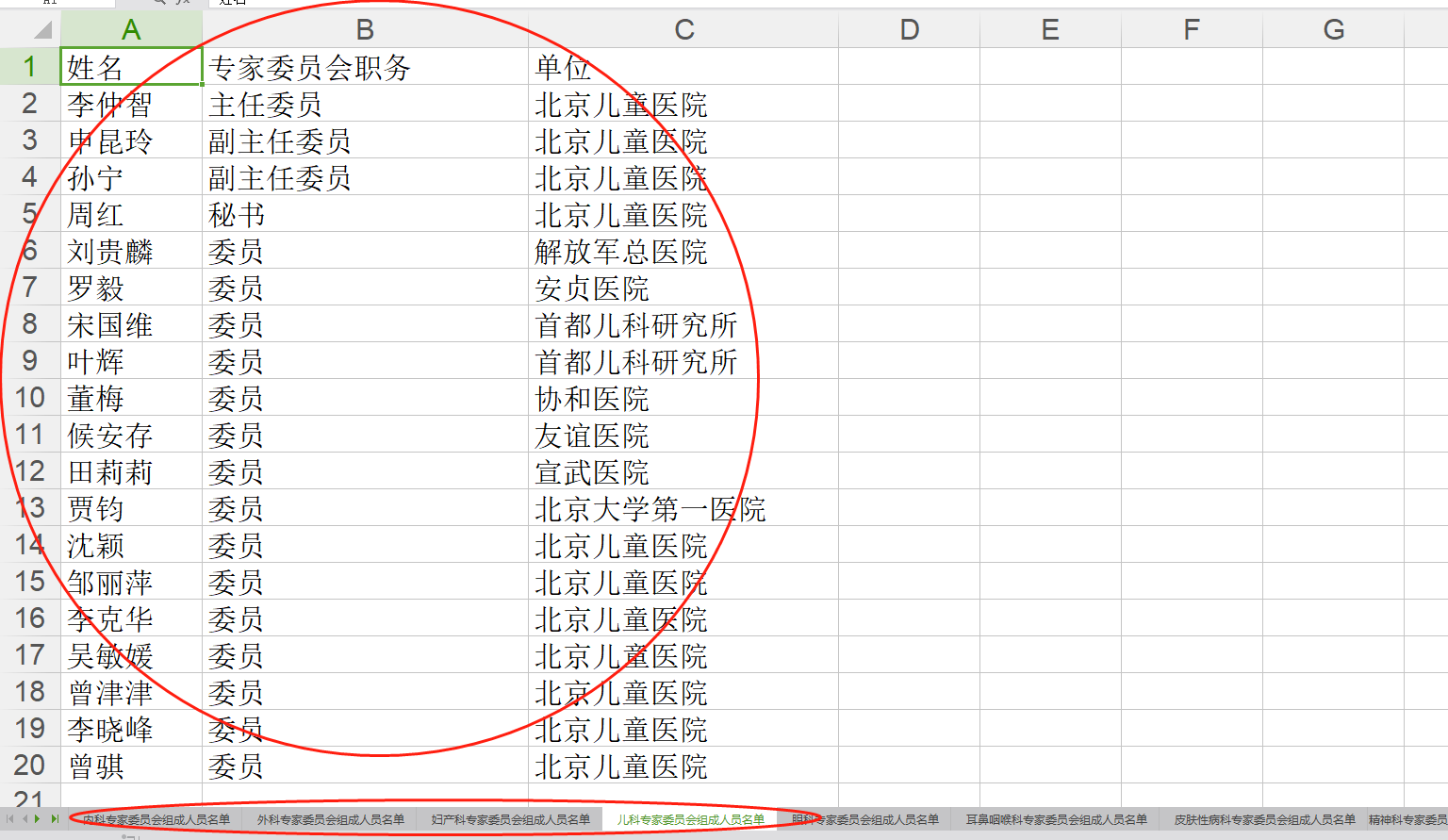

这个小程序可以爬取该网站的医生专家的信息,分不同的专科保存到同一个Excel中。

# -*- conding:utf-8 -*- import xlwt # 创建工作workbook

workbook = xlwt.Workbook() # 创建工作表worksheet,填入表名

worksheet = workbook.add_sheet('表名') # 在表中写入相应的数据

worksheet.write(0, 0, 'hello world')

worksheet.write(1, 1, '你好') # 保存表

workbook.save('hello.xls')

python爬取数据保存到Excel中的更多相关文章

- 「拉勾网」薪资调查的小爬虫,并将抓取结果保存到excel中

学习Python也有一段时间了,各种理论知识大体上也算略知一二了,今天就进入实战演练:通过Python来编写一个拉勾网薪资调查的小爬虫. 第一步:分析网站的请求过程 我们在查看拉勾网上的招聘信息的时候 ...

- python之scrapy爬取数据保存到mysql数据库

1.创建工程 scrapy startproject tencent 2.创建项目 scrapy genspider mahuateng 3.既然保存到数据库,自然要安装pymsql pip inst ...

- 关于爬取数据保存到json文件,中文是unicode解决方式

流程: 爬取的数据处理为列表,包含字典.里面包含中文, 经过json.dumps,保存到json文件中, 发现里面的中文显示未\ue768这样子 查阅资料发现,json.dumps 有一个参数.ens ...

- 将爬取的数据保存到mysql中

为了把数据保存到mysql费了很多周折,早上再来折腾,终于折腾好了 安装数据库 1.pip install pymysql(根据版本来装) 2.创建数据 打开终端 键入mysql -u root -p ...

- 1.scrapy爬取的数据保存到es中

先建立es的mapping,也就是建立在es中建立一个空的Index,代码如下:执行后就会在es建lagou 这个index. from datetime import datetime fr ...

- Excel文件数据保存到SQL中

1.获取DataTable /// <summary> /// 查询Excel文件中的数据 /// </summary> /// <param name="st ...

- c# 抓取和解析网页,并将table数据保存到datatable中(其他格式也可以,自己去修改)

使用HtmlAgilityPack 基础请参考这篇博客:https://www.cnblogs.com/fishyues/p/10232822.html 下面是根据抓取的页面string 来解析并保存 ...

- Sql数据保存到Excel文件中

public string ExportExcel( DataSet ds,string saveFileName) { try { if (ds == null) return "数据库为 ...

- 爬取伯乐在线文章(四)将爬取结果保存到MySQL

Item Pipeline 当Item在Spider中被收集之后,它将会被传递到Item Pipeline,这些Item Pipeline组件按定义的顺序处理Item. 每个Item Pipeline ...

随机推荐

- ionic之AngularJS扩展动态组件

目录: 1. 模态对话框 : $ionicModal 2. 上拉菜单 : $ionicActionSheet 3. 弹出框 : $ionicPopup 4. 浮动框 : $ionicPopover 5 ...

- array_column() 函数[二维数组转为一维数组]

array_column() 函数 输出数组中某个键值的集合[二维数组转为一位数组] <?php // 表示由数据库返回的可能记录集的数组 $a = array( array( 'id' =&g ...

- 如何在Ubuntu上安装Wine 2.6

Wine(Wine不是模拟器)是一种开源兼容层软件应用程序,可以让Linux和Unix用户通过Winelib软件库在他们的系统上运行Windows软件. sudo add-apt-repository ...

- struct结构的一些内容

srtuct结构的定义: 访问修饰符 struct 结构名{ //方法体 } 结构定义的特点: 1.结构中可以有字段(属性),也可以有方法 2.定义时,结构的字段不能被赋初值 3.结构和类一样都有默 ...

- overflow实现隐藏滚动条同时又可以滚动

.scroll-list ul{ white-space: nowrap; -webkit-overflow-scrolling: touch; overflow-x: auto; overflow- ...

- Fiddler抓取Intellij Idea中执行的web网络请求

首先可以打开命令行 输入:ipconfig 找到本机配置的IP地址 这里是: 192.168.97.122 或者打开Fiddler 点击如下图片中的小三角符号:将鼠标放在online的位置,也可以看到 ...

- TensorFlow车牌识别实践(1)

本文对公开的文章进行验证,从环境搭建到运行到结果分析. 1,文章:基于TensorFlow的车牌号识别系统 文章(译文) http://www.cnblogs.com/Jsmile2017/p/680 ...

- vue学习图解

vue2.0版本的学习图解个人心得!本文为原创禁止转载!!转载需要注明出处,谢谢合作!!!

- jsTree插件简介(三)

UI-plugin JSTree的UI插件:用来处理选择.不选和鼠标悬浮树选项的插件. 一.属性包括: 1.select_limit:指定一次可以选中几个节点,默认为-1,表示无限制选中. 2.sel ...

- 搭建Cookie池

很多时候我们在对网站进行数据抓取的时候,可以抓取一部分页面或者接口,这部分可能没有设置登录限制.但是如果要抓取大规模数据的时候,没有登录进行爬取会出现一些弊端.对于一些设置登录限制的页面,无法爬取对于 ...