ClickHouse入门:表引擎-HDFS

前言

插件及服务器版本

服务器:ubuntu 16.04

Hadoop:2.6

ClickHouse:20.9.3.45

文章目录

- 简介

- 引擎配置

- HDFS表引擎的两种使用形式

- 引用

简介

ClickHouse的HDFS引擎可以对接hdfs,这里假设HDFS环境已经配置完成,本文测试使用的HDFS版本为2.6

HDFS引擎定义方法如下:

ENGINE = HDFS(hdfs_uri,format)

参数定义:

- hdfs_uri表示HDFS的文件存储路径

- format表示文件格式(指ClickHouse支持的文件格式,常见有CSV、TSV和JSON等)

HDFS表引擎两种使用方式:

- 即负责读文件也负责写文件

- 只负责读文件,文件写入工作则由外部系统完成

引擎配置

由于hdfs配置了HA,如果不做配置,创建一张只负责读文件的表,并查询数据,会报如下错误:

Code: 210. DB::Exception: Received from localhost:9000.

DB::Exception: Unable to connect to HDFS: InvalidParameter: Cannot parse URI:

hdfs://mycluster, missing port or invalid HA configuration

Caused by: HdfsConfigNotFound: Config key: dfs.ha.namenodes.mycluster not found.

需要做如下配置解决问题

1、拷贝hdfs-site.xml文件至/etc/clickhouse-server,并修改文件名为hdfs-client.xml

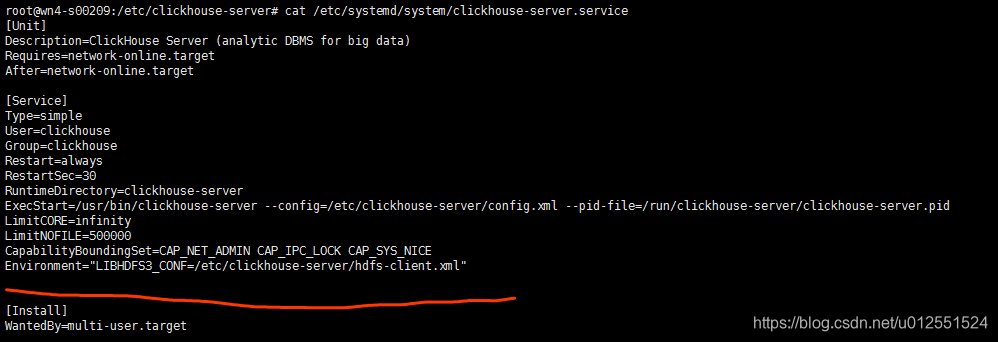

2、修改ClickHouse Server启动文件,添加环境变量Environment=“LIBHDFS3_CONF=/etc/clickhouse-server/hdfs-client.xml”

备注:

这里测试环境为ubuntu环境,启动服务用systemctl启动,所以修改启动文件的路径为:vi /etc/systemd/system/clickhouse-server.service

3、加载并重启clickhouse-serversystemctl daemon-reload

systemctl restart clickhouse-server.service

4、测试

新创建一张只读表,对应的hdfs上已经提前放了一个测试文件 1.txt

CREATE TABLE test_hdfs

(

id Int32

)

ENGINE HDFS('hdfs://mycluster/1.txt','CSV');

查询表里的数据

HDFS表引擎的两种使用形式

即负责读文件,也负责写文件

创建一张新表

CREATE TABLE test_hdfs_read

(

id Int32,

name String

)

ENGINE HDFS('hdfs://mycluster/test','CSV');

插入数据

insert into test_hdfs_read values (1,'tracy');

查询表数据并查看hdfs目录情况

这里可以看到hdfs目录下多了一个test文件

只负责读文件,文件写入工作则由外部系统完成

这种形式类似于hive的外挂表,由其它系统直接将文件直接写入HDFS,通过参数hdsfs_ui和format与HDFS的文件路径、文件格式建立映射,其中hdfs_uri支持以下几种常见的配置方法:

1. 绝对路径:会指定路径上的单个文件,例如hdfs://mycluster/1.txt

2. *通配符:匹配所有字符,例如hdfs://mycluster/ * ,会读取hdfs://mycluster/路径下的所有文件

3. ?通配符:匹配单个字符,例如hdfs://mycluster/test_?.txt会匹配所有test_?.txt的文件,?代表任意字符

4. {M…N}数字区间:匹配指定数字的文件,例如路径hdfs://mycluster/test_{1…3}.txt,则会读取hdfs://mycluster/路径下的文件test_1.txt,test_2.txt,test_3.txt在hdfs新建一个目录,并放3个文件

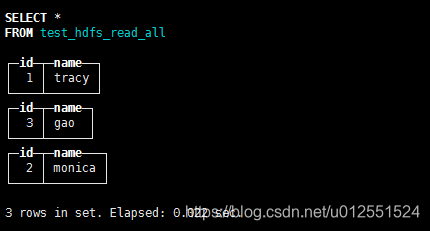

测试*通配符

CREATE TABLE test_hdfs_read_all

(

`id` Int32,

`name` String

)

ENGINE = HDFS('hdfs://mycluster/test_hdfs_read/*', 'CSV')

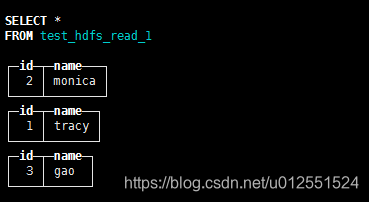

测试?通配符

CREATE TABLE test_hdfs_read_1

(

`id` Int32,

`name` String

)

ENGINE = HDFS('hdfs://mycluster/test_hdfs_read/test_?.csv', 'CSV')

测试数字区间通配符通配符

CREATE TABLE test_hdfs_read_2

(

`id` Int32,

`name` String

)

ENGINE = HDFS('hdfs://mycluster/test_hdfs_read/test_{2..3}.csv', 'CSV')

这里只匹配了test_2和test_3,所以只有两条记录

引用

https://github.com/ClickHouse/ClickHouse/issues/8159

ClickHouse入门:表引擎-HDFS的更多相关文章

- UniqueMergeTree:支持实时更新删除的 ClickHouse 表引擎

UniqueMergeTree 开发的业务背景 首先,我们看一下哪些场景需要用到实时更新. 我们总结了三类场景: 第一类是业务需要对它的交易类数据进行实时分析,需要把数据流同步到 ClickHouse ...

- ClickHouse(10)ClickHouse合并树MergeTree家族表引擎之ReplacingMergeTree详细解析

目录 建表语法 数据处理策略 资料分享 参考文章 MergeTree拥有主键,但是它的主键却没有唯一键的约束.这意味着即便多行数据的主键相同,它们还是能够被正常写入.在某些使用场合,用户并不希望数据表 ...

- clickhouse入门到实战及面试

第一章. clickhouse入门 一.ClickHouse介绍 ClickHouse(开源)是一个面向列的数据库管理系统(DBMS),用于在线分析处理查询(OLAP). 关键词:开源.面向列.联机分 ...

- Clickhouse 入门

clickhouse 简介 ck是一个列式存储的数据库,其针对的场景是OLAP.OLAP的特点是: 数据不经常写,即便写也是批量写.不像OLTP是一条一条写 大多数是读请求 查询并发较少,不适合放置先 ...

- ClickHouse入门笔记

ClickHouse笔记 目录 ClickHouse笔记 第 1 章 ClickHouse 入门 列式储存的好处: 第 2 章 ClickHouse 的安装 第 3 章 数据类型 整型 浮点型 布尔型 ...

- Clickhouse 分布式表&本地表 &ClickHouse实现时序数据管理和挖掘

一.CK 分布式表和本地表 (1)CK是一个纯列式存储的数据库,一个列就是硬盘上的一个或多个文件(多个分区有多个文件),关于列式存储这里就不展开了,总之列存对于分析来讲好处更大,因为每个列单独存储,所 ...

- Clickhouse 分布式表&本地表

CK 分布式表和本地表 ck的表分为两种: 分布式表 一个逻辑上的表, 可以理解为数据库中的视图, 一般查询都查询分布式表. 分布式表引擎会将我们的查询请求路由本地表进行查询, 然后进行汇总最终返回给 ...

- innodb数据库批量转换表引擎为MyISAM

2013.0106 innodb数据库批量转换表引擎为MyISAM 来源:本站原创 PHP, 数据库, 系统技术 超过488名童鞋围观 1条评论 <?php //连接数据库 $host='lo ...

- Mysql MyISAM数据库批量转换表引擎为Innodb

Mysql MyISAM数据库批量转换表引擎为Innodb 最近在做事物处理需要把表结构都改为带有支持事物的Innodb引擎格式, 把里面数据库 用户名.密码 等信息修改为你自己的,放在网站下运行即可 ...

随机推荐

- IIS应用程序池配置详解及优化

参数说明 1.常规 属性名称 属性详解 NET CLR 版本 配置应用程序池,以加载特定版本的 .NET CLR.选定的 CLR版本应与应用程序所使用的相应版本的 .NET Framework 对应. ...

- .net MVC 微信公众号 点击菜单拉取消息时的事件推送

官方文档:https://mp.weixin.qq.com/wiki?t=resource/res_main&id=mp1421141016&token=&lang=zh_CN ...

- 安利一个基于Spring Cloud 的面试刷题系统。面试、毕设、项目经验一网打尽

推荐: 接近100K star 的Java学习/面试指南 Github 95k+点赞的Java面试/学习手册.pdf 今天给小伙伴们推荐一个朋友开源的面试刷题系统. 这篇文章我会从系统架构设计层面详解 ...

- flowable 实现多实例-会签-动态配置人员 参考demo

会签 即多人执行当前任务 设置判断数 通过 例如:设置了是半数通过即可通过当前节点 如果当前是4人那就是2人即通过 如果是6人那就是三人即通过 如果是5人 即三人通过 看各位的判断值是如何书写 这个值 ...

- Linux腾讯云下安装mysql

百度云盘下载地址https://pan.baidu.com/s/1MqUEdeqZuQbq-veLuVItQQ 将下载好的mysql-5.7.14-linux-glibc2.5-x86_64.tar. ...

- [Machine Learning] 逻辑回归 (Logistic Regression) -分类问题-逻辑回归-正则化

在之前的问题讨论中,研究的都是连续值,即y的输出是一个连续的值.但是在分类问题中,要预测的值是离散的值,就是预测的结果是否属于某一个类.例如:判断一封电子邮件是否是垃圾邮件:判断一次金融交易是否是欺诈 ...

- Linux性能优化:CPU性能分析工具--vmstat

Blog:博客园 个人 目录 参数说明 输出信息说明 procs memory swap io system cpu 示例 vmstat是Virtual Meomory Statistics(虚拟内存 ...

- 【Go】四舍五入在go语言中为何如此困难

四舍五入是一个非常常见的功能,在流行语言标准库中往往存在 Round 的功能,它最少支持常用的 Round half up 算法. 而在 Go 语言中这似乎成为了难题,在 stackoverflow ...

- 【转载】VUE的背景图引入

我现在的项目要将登录页面的背景引一图片做为背景图片,按原jsp中的写法,发现无法找到背景图片,最后从网上查资料,采用上面的写法,成功显示出背景图片,参考网址 https://blog.csdn.net ...

- HTTP ERROR400的问题解决

今天写添加功能,在点添加提交时报了一个"HTTP ERROR 400"的错误,如图, 请求提交的代码死活跳转不到后台,郁闷中,开启debug功能,开始一步步排查, 1.先单独把跳转 ...