HBase学习之路 (十一)HBase的协过滤器

协处理器—Coprocessor

1、 起源

Hbase 作为列族数据库最经常被人诟病的特性包括:无法轻易建立“二级索引”,难以执 行求和、计数、排序等操作。比如,在旧版本的(<0.92)Hbase 中,统计数据表的总行数,需 要使用 Counter 方法,执行一次 MapReduce Job 才能得到。虽然 HBase 在数据存储层中集成 了 MapReduce,能够有效用于数据表的分布式计算。然而在很多情况下,做一些简单的相 加或者聚合计算的时候,如果直接将计算过程放置在 server 端,能够减少通讯开销,从而获 得很好的性能提升。于是,HBase 在 0.92 之后引入了协处理器(coprocessors),实现一些激动 人心的新特性:能够轻易建立二次索引、复杂过滤器(谓词下推)以及访问控制等。

2、介绍

协处理器有两种:observer 和 endpoint

Observer 类似于传统数据库中的触发器,当发生某些事件的时候这类协处理器会被 Server 端调用。Observer Coprocessor 就是一些散布在 HBase Server 端代码中的 hook 钩子, 在固定的事件发生时被调用。比如:put 操作之前有钩子函数 prePut,该函数在 put 操作执 行前会被 Region Server 调用;在 put 操作之后则有 postPut 钩子函数

以 HBase0.92 版本为例,它提供了三种观察者接口:

RegionObserver:提供客户端的数据操纵事件钩子:Get、Put、Delete、Scan 等。

WALObserver:提供 WAL 相关操作钩子。

MasterObserver:提供 DDL-类型的操作钩子。如创建、删除、修改数据表等。

到 0.96 版本又新增一个 RegionServerObserver

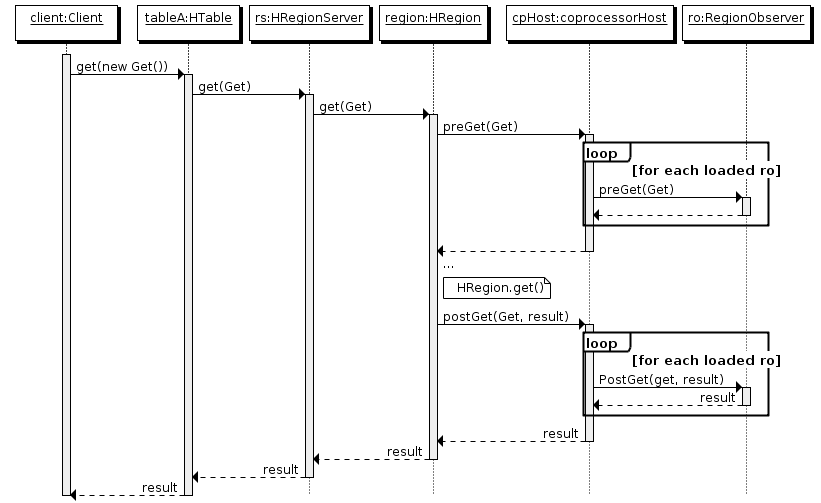

下图是以 RegionObserver 为例子讲解 Observer 这种协处理器的原理:

1、客户端发出 put 请求

2、该请求被分派给合适的 RegionServer 和 region

3、coprocessorHost 拦截该请求,然后在该表上登记的每个 RegionObserver 上调用 prePut()

4、如果没有被 prePut()拦截,该请求继续送到 region,然后进行处理

5、region 产生的结果再次被 CoprocessorHost 拦截,调用 postPut()

6、假如没有 postPut()拦截该响应,最终结果被返回给客户端

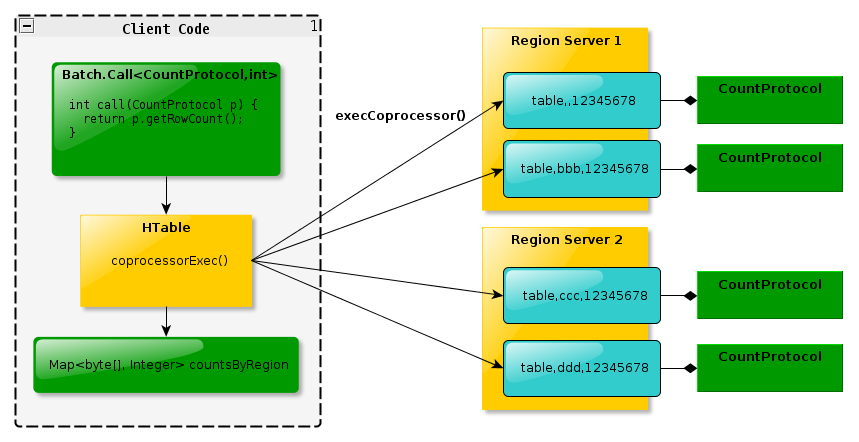

Endpoint 协处理器类似传统数据库中的存储过程,客户端可以调用这些 Endpoint 协处 理器执行一段 Server 端代码,并将 Server 端代码的结果返回给客户端进一步处理,最常见 的用法就是进行聚集操作。如果没有协处理器,当用户需要找出一张表中的最大数据,即 max 聚合操作,就必须进行全表扫描,在客户端代码内遍历扫描结果,并执行求最大值的 操作。这样的方法无法利用底层集群的并发能力,而将所有计算都集中到 Client 端统一执行, 势必效率低下。利用 Coprocessor,用户可以将求最大值的代码部署到 HBase Server 端,HBase 将利用底层 cluster 的多个节点并发执行求最大值的操作。即在每个 Region 范围内执行求最 大值的代码,将每个 Region 的最大值在 Region Server 端计算出,仅仅将该 max 值返回给客 户端。在客户端进一步将多个 Region 的最大值进一步处理而找到其中的最大值。这样整体 的执行效率就会提高很多

下图是 EndPoint 的工作原理:

3、总结

Observer 允许集群在正常的客户端操作过程中可以有不同的行为表现

Endpoint 允许扩展集群的能力,对客户端应用开放新的运算命令

Observer 类似于 RDBMS 中的触发器,主要在服务端工作

Endpoint 类似于 RDBMS 中的存储过程,主要在服务端工作

Observer 可以实现权限管理、优先级设置、监控、ddl 控制、二级索引等功能

Endpoint 可以实现 min、max、avg、sum、distinct、group by 等功能

协处理加载方式

协处理器的加载方式有两种,我们称之为静态加载方式(Static Load)和动态加载方式 (Dynamic Load)。静态加载的协处理器称之为 System Coprocessor,动态加载的协处理器称 之为 Table Coprocessor。

1、 静态加载

通过修改 hbase-site.xml 这个文件来实现,启动全局 aggregation,能过操纵所有的表上 的数据。只需要添加如下代码:

<property>

<name>hbase.coprocessor.user.region.classes</name>

<value>org.apache.hadoop.hbase.coprocessor.AggregateImplementation</value>

</property>

为所有 table 加载了一个 cp class,可以用”,”分割加载多个 class

2、 动态加载

启用表 aggregation,只对特定的表生效。通过 HBase Shell 来实现。

(1)停用表 disable 'guanzhu'

(2)添加协处理器 alter 'guanzhu', METHOD => 'table_att', 'coprocessor' => 'hdfs://myha01/hbase/guanzhu.jar|com.study.hbase.cp.HbaseCoprocessorTest|1001|'

(3)启用表 enable 'guanzhu'

3、 协处理器卸载

同样是3步

disable 'mytable'

alter 'mytable',METHOD=>'table_att_unset',NAME=>'coprocessor$1'

enable 'mytable'

案例(二级索引)

说明:二狗子是王宝强的粉丝

关注表:二狗子关注了王宝强 rowKey='ergouzi' cell="star:wangbaoqiang"

put 'guanzhu', 'ergouzi', 'cf:star', 'wangbaoqiang'

粉丝表:二狗子是王宝强的粉丝 rowKey="wangbaoqiang" cell="fensi:ergouzi"

put 'fans', 'wangbaoqiang', 'cf:fensi', 'ergouzi'

java实现代码

public class HbaseCoprocessorTest extends BaseRegionObserver{

static Configuration conf = HBaseConfiguration.create();

static Connection conn = null;

static Table table = null;

static {

conf.set("hbase.zookeeper.quorum", "hadoop1:2181,hadoop2:2181,hadoop3:2181");

try {

conn = ConnectionFactory.createConnection(conf);

table = conn.getTable(TableName.valueOf("fans"));

} catch (IOException e) {

e.printStackTrace();

}

}

/**

* 此方法是在真正的put方法调用之前进行调用

* 参数put为table.put(put)里面的参数put对象,是要进行插入的那条数据

*

* 例如:要向关注表里面插入一条数据 姓名:二狗子 关注的明星:王宝强

* shell语句:put 'guanzhu','ergouzi', 'cf:star', 'wangbaoqiang'

*

* */

@Override

public void prePut(ObserverContext<RegionCoprocessorEnvironment> e, Put put, WALEdit edit, Durability durability)

throws IOException {

//获取put对象里面的rowkey'ergouzi'

byte[] row = put.getRow();

//获取put对象里面的cell

List<Cell> list = put.get("cf".getBytes(), "star".getBytes());

Cell cell = list.get(0);

//创建一个新的put对象

Put new_put = new Put(cell.getValueArray());

new_put.addColumn("cf".getBytes(), "fensi".getBytes(), row);

table.put(new_put);

conn.close();

}

}

打成jar包,命名为guanzhu.jar,将其上传到HDFS目录/hbase下面

[hadoop@hadoop1 ~]$ hadoop fs -put guanzhu.jar /hbase

打开hbase shell命令,按顺序呢执行(提前已经创建好guanzhu和fans表)

hbase(main):001:0> disable 'guanzhu'

0 row(s) in 2.8850 seconds hbase(main):002:0> alter 'guanzhu', METHOD => 'table_att', 'coprocessor' => 'hdfs://myha01/hbase/guanzhu.jar|com.study.hbase.cp.HbaseCoprocessorTest|1001|'

Updating all regions with the new schema...

1/1 regions updated.

Done.

0 row(s) in 2.7570 seconds hbase(main):003:0> enable 'guanzhu'

0 row(s) in 2.3400 seconds hbase(main):004:0> desc 'guanzhu'

Table guanzhu is ENABLED

guanzhu, {TABLE_ATTRIBUTES => {coprocessor$1 => 'hdfs://myha01/hbase/guanzhu.jar|com.study.hbase.cp.HbaseCoproce

ssorTest|1001|'}

COLUMN FAMILIES DESCRIPTION

{NAME => 'cf', BLOOMFILTER => 'ROW', VERSIONS => '1', IN_MEMORY => 'false', KEEP_DELETED_CELLS => 'FALSE', DATA_

BLOCK_ENCODING => 'NONE', TTL => 'FOREVER', COMPRESSION => 'NONE', MIN_VERSIONS => '0', BLOCKCACHE => 'true', BL

OCKSIZE => '65536', REPLICATION_SCOPE => '0'}

1 row(s) in 0.0500 seconds hbase(main):005:0> put 'guanzhu', 'ergouzi', 'cf:star', 'wangbaoqiang'

0 row(s) in 0.3050 seconds hbase(main):006:0> scan 'guanzhu'

ROW COLUMN+CELL

ergouzi column=cf:star, timestamp=1522759023001, value=wangbaoqiang

1 row(s) in 0.0790 seconds hbase(main):007:0> scan 'fans'

ROW COLUMN+CELL

\x00\x00\x00\x19\x00\x00\x00 column=cf:fensi, timestamp=1522759022996, value=ergouzi

\x0C\x00\x07ergouzi\x02cfsta

r\x7F\xFF\xFF\xFF\xFF\xFF\xF

F\xFF\x04wangbaoqiang

1 row(s) in 0.0330 seconds hbase(main):008:0>

HBase学习之路 (十一)HBase的协过滤器的更多相关文章

- HBase 学习之路(八)——HBase协处理器

一.简述 在使用HBase时,如果你的数据量达到了数十亿行或数百万列,此时能否在查询中返回大量数据将受制于网络的带宽,即便网络状况允许,但是客户端的计算处理也未必能够满足要求.在这种情况下,协处理器( ...

- HBase学习之路 (二)HBase集群安装

前提 1.HBase 依赖于 HDFS 做底层的数据存储 2.HBase 依赖于 MapReduce 做数据计算 3.HBase 依赖于 ZooKeeper 做服务协调 4.HBase源码是java编 ...

- HBase学习之路 (三)HBase集群Shell操作

进入HBase命令行 在你安装的随意台服务器节点上,执行命令:hbase shell,会进入到你的 hbase shell 客 户端 [hadoop@hadoop1 ~]$ hbase shell S ...

- HBase学习之路 (一)HBase基础介绍

产生背景 自 1970 年以来,关系数据库用于数据存储和维护有关问题的解决方案.大数据的出现后, 好多公司实现处理大数据并从中受益,并开始选择像 Hadoop 的解决方案.Hadoop 使用分 布式文 ...

- HBase 学习之路(九)——HBase容灾与备份

一.前言 本文主要介绍Hbase常用的三种简单的容灾备份方案,即CopyTable.Export/Import.Snapshot.分别介绍如下: 二.CopyTable 2.1 简介 CopyTabl ...

- HBase 学习之路(六)——HBase Java API 的基本使用

一.简述 截至到目前(2019.04),HBase 有两个主要的版本,分别是1.x 和 2.x ,两个版本的Java API有所不同,1.x 中某些方法在2.x中被标识为@deprecated过时.所 ...

- 大数据学习之路之HBASE

Hadoop之HBASE 一.HBASE简介 HBase是一个开源的.分布式的,多版本的,面向列的,半结构化的NoSql数据库,提供高性能的随机读写结构化数据的能力.它可以直接使用本地文件系统,也可以 ...

- 【Hbase学习之二】Hbase 搭建

环境 虚拟机:VMware 10 Linux版本:CentOS-6.5-x86_64 客户端:Xshell4 FTP:Xftp4 jdk8 hadoop-3.1.1 hbase-2.1.3 一.单机模 ...

- Hbase 学习(十) HBase Snapshots

HBase Snapshots允许你对一个表进行快照(即可用副本),它不会对Region Servers产生很大的影响,它进行复制和 恢复操作的时候不包括数据拷贝.导出快照到另外的集群也不会对Regi ...

随机推荐

- PHP错误日志和内存查看

1.通过命令查看服务器上一共开了多少的 php-cgi 进程: ps -fe |grep "php-fpm"|grep "pool"|wc -l 2.查看FPM ...

- WCF之maxConnections

<bindings> <netTcpBinding> <binding name="TcpBinding" closeTimeout="00 ...

- BZOJ2663 [Beijing wc2012]灵魂宝石

Description 平面中有\(n\)个黑点和\(n\)个白点.这些点组成\(n\)对,但是你不知道它们的对应关系.若某队中黑点白点距离\(<R\),则它是好的:\(>R\)则不是好的 ...

- drupal7 hook_validate

原文:function hook_validate function hook_validate($node, $form, &$form_state) { if (isset($node-& ...

- 空间数据的WKT和WKB表现形式

WKT(well-known text)是一种文本标记语言,该格式由开放地理空间联盟(OGC)制定,用于表示矢量数据中的几何对象,在数据传输与数据库存储时,常 用到它的二进制形式,即WKB(well- ...

- Ubuntu 安装python

1. wget http://mirrors.sohu.com/python/3.6.0/Python-3.6.0.tar.xz wget https://www.python.org/ftp/pyt ...

- gitlab 灾备

Gitlab创建备份 使用Gitlab一键安装包安装Gitlab非常简单,同样的备份恢复与迁移也非常简单.使用一条命令即可创建完整的Gitlab备份: gitlab-rake gitlab:ba ...

- 机器学习中正则惩罚项L0/L1/L2范数详解

https://blog.csdn.net/zouxy09/article/details/24971995 原文转自csdn博客,写的非常好. L0: 非零的个数 L1: 参数绝对值的和 L2:参数 ...

- 3 个简单、优秀的 Linux 网络监视器

作者: Carla Schroder 译者: LCTT geekpi 用 iftop.Nethogs 和 vnstat 了解更多关于你的网络连接. 你可以通过这三个 Linux 网络命令,了解有关你网 ...

- Fiddler下Firefox提示“您的连接并不安全”的解决办法

一.版本信息 Firefox 最新版本V46.0.1 Fiddler 最新版本V4.6.2.3 二.错误信息 开启fiddlers的https协议捕获的方法,百度上可以查到不再赘述,直接放张图(Too ...