python --爬虫基础 --爬猫眼top 100 使用 requests 库的基本操作

import requests

import re

import json

import time def get_page(url): # 获取页数

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'} # 請求頭信息

response = requests.get(url, headers=headers)

if response.status_code == 200: # 判断响应

return response.text

else:

None def parse_one_page(html): # 整理代码

pattern = re.compile(

'<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>',

re.S) # re.S是非换行匹配空白符,匹配换行内的所有字符

items = re.findall(pattern, html)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2], # strip(除去字符串左右两端的/N/T)

'actor': item[3].strip()[3:] # 取前三个人的名字 } def write_to_file(content):

with open('result.txt', 'a', encoding='utf -8') as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n') def main(offset): # 定义运行函数

url = 'http://maoyan.com/board/4?offset='+str(offset)

#url = 'http://maoyan.com/board/4?offset=' + str(offset)

html = get_page(url)

for i in parse_one_page(html):

print(i)

write_to_file(i) if __name__ == '__main__':

for i in range(30):

main(i*10)

输出结果

D:\ProgramData\Anaconda3\python.exe C:/Users/Administrator/PycharmProjects/untitled3/pachong/demo1pachong.py

{'index': '1', 'image': 'http://p1.meituan.net/movie/20803f59291c47e1e116c11963ce019e68711.jpg@160w_220h_1e_1c', 'title': '霸王别姬', 'actor': '张国荣,张丰毅,巩俐'}

{'index': '2', 'image': 'http://p0.meituan.net/movie/283292171619cdfd5b240c8fd093f1eb255670.jpg@160w_220h_1e_1c', 'title': '肖申克的救赎', 'actor': '蒂姆·罗宾斯,摩根·弗里曼,鲍勃·冈顿'}

{'index': '3', 'image': 'http://p0.meituan.net/movie/54617769d96807e4d81804284ffe2a27239007.jpg@160w_220h_1e_1c', 'title': '罗马假日', 'actor': '格利高里·派克,奥黛丽·赫本,埃迪·艾伯特'}

{'index': '4', 'image': 'http://p0.meituan.net/movie/e55ec5d18ccc83ba7db68caae54f165f95924.jpg@160w_220h_1e_1c', 'title': '这个杀手不太冷', 'actor': '让·雷诺,加里·奥德曼,娜塔莉·波特曼'}

{'index': '5', 'image': 'http://p1.meituan.net/movie/f5a924f362f050881f2b8f82e852747c118515.jpg@160w_220h_1e_1c', 'title': '教父', 'actor': '马龙·白兰度,阿尔·帕西诺,詹姆斯·肯恩'}

{'index': '6', 'image': 'http://p1.meituan.net/movie/0699ac97c82cf01638aa5023562d6134351277.jpg@160w_220h_1e_1c', 'title': '泰坦尼克号', 'actor': '莱昂纳多·迪卡普里奥,凯特·温丝莱特,比利·赞恩'}

{'index': '7', 'image': 'http://p0.meituan.net/movie/da64660f82b98cdc1b8a3804e69609e041108.jpg@160w_220h_1e_1c', 'title': '唐伯虎点秋香', 'actor': '周星驰,巩俐,郑佩佩'}

{'index': '8', 'image': 'http://p0.meituan.net/movie/b076ce63e9860ecf1ee9839badee5228329384.jpg@160w_220h_1e_1c', 'title': '千与千寻', 'actor': '柊瑠美,入野自由,夏木真理'}

{'index': '9', 'image': 'http://p0.meituan.net/movie/46c29a8b8d8424bdda7715e6fd779c66235684.jpg@160w_220h_1e_1c', 'title': '魂断蓝桥', 'actor': '费雯·丽,罗伯特·泰勒,露塞尔·沃特森'}

{'index': '10', 'image': 'http://p0.meituan.net/movie/230e71d398e0c54730d58dc4bb6e4cca51662.jpg@160w_220h_1e_1c', 'title': '乱世佳人', 'actor': '费雯·丽,克拉克·盖博,奥利维娅·德哈维兰'}

........

Process finished with exit code 0

本文知识点

1:首先判断需要爬取的网址

http://maoyan.com/board/4?offset=

可以得知 随着点击下一页, offset= 的数字 会以10的倍数增长

2:抓取首页信息

创建 get_page(url)方法 传入参数url

def get_page(url): # 获取页数

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/63.0.3239.132 Safari/537.36'} # 請求頭信息

response = requests.get(url, headers=headers)

if response.status_code == 200: # 判断响应

return response.text

else:

None def parse_one_page(html): # 整理代码

pattern = re.compile(

'<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>',

re.S) # re.S是非换行匹配空白符,匹配换行内的所有字符

items = re.findall(pattern, html)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2], # strip(除去字符串左右两端的/N/T)

'actor': item[3].strip()[3:] # 取前三个人的名字 }

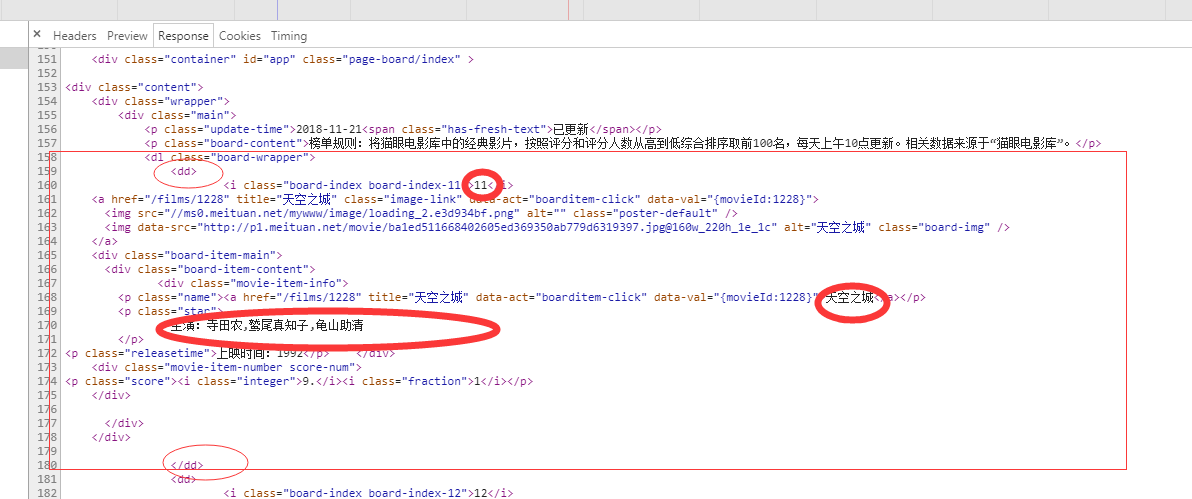

分析原网页的html内容可知

需要的内容在<dd>..</dd>内 之后通过正则提取内容

正则用到的知识点

/w 匹配字母

/W 匹配非字母

/d 匹配任意数字

/D 匹配任意非数字

/s 匹配任意空白符

. 匹配任意除了换行符以外的数字

* 匹配0个或者多个

? 匹配任意0个或1 个正则表达的片段

match() 起始位置匹配正则表达式

compile() 这个方法将正则表达式翻译成正则表达式对象

sub() 类似replace() 替换

findall() 搜索整个字符串.然后配备正则表达式返回的所有内容.,返回为列表内容

修饰符 r.S 使. 匹配包括换行符内的所有内容

<dd>

<i class="board-index board-index-12">12</i>

<a href="/films/9025" title="喜剧之王" class="image-link" data-act="boarditem-click" data-val="{movieId:9025}">

<img src="//ms0.meituan.net/mywww/image/loading_2.e3d934bf.png" alt="" class="poster-default" />

<img data-src="http://p1.meituan.net/movie/18e3191039d5e71562477659301f04aa61905.jpg@160w_220h_1e_1c" alt="喜剧之王" class="board-img" />

</a>

<div class="board-item-main">

<div class="board-item-content">

<div class="movie-item-info">

<p class="name"><a href="/films/9025" title="喜剧之王" data-act="boarditem-click" data-val="{movieId:9025}">喜剧之王</a></p>

<p class="star">

主演:周星驰,莫文蔚,张柏芝

</p>

<p class="releasetime">上映时间:1999-02-13(中国香港)</p> </div>

<div class="movie-item-number score-num">

<p class="score"><i class="integer">9.</i><i class="fraction">2</i></p>

</div>

</div>

</div>

</dd>

比如获取第一段想获取电影排名

正则表达式为

<dd>.*?board-index.*?(.*?)</i>

输出结果 12

其中红色为需要描述的地方,类似获取内容的截取点,绿色的地方为可以贪婪获取的地方(意思就是我给了头 ,给了尾 ' .*? ' 的地方你乐意是什么是什么. 其中('.*?'内的是需要返回的内容))

3 整理获取的内容

现在获取的内容是杂乱的. 需要将匹配的内容处理下.

def parse_one_page(html): # 整理代码

pattern = re.compile(

'<dd>.*?board-index.*?>(.*?)</i>.*?data-src="(.*?)".*?name.*?a.*?>(.*?)</a>.*?star.*?>(.*?)</p>',

re.S) # re.S是非换行匹配空白符,匹配换行内的所有字符

items = re.findall(pattern, html)

for item in items:

yield {

'index': item[0],

'image': item[1],

'title': item[2], # strip(除去字符串左右两端的/N/T)

'actor': item[3].strip()[3:] # 取前三个人的名字 }

其中 re.compile() , re.findall() 方法已经介绍. r.S是解释符

在利用生成器 yield 将内容生成字典的形式

4,写入文件

def write_to_file(content):

with open('result.txt', 'a', encoding='utf -8') as f:

f.write(json.dumps(content, ensure_ascii=False) + '\n')

获取字典通过json的dumps()方法实现字典的序列化

并且指定ensure_ascii 为False 这样可以保证输出的中文内容

大概就是这样. 内容不足后续补充

python --爬虫基础 --爬猫眼top 100 使用 requests 库的基本操作的更多相关文章

- python --爬虫基础 --爬取今日头条 使用 requests 库的基本操作, Ajax

'''思路一: 由于是Ajax的网页,需要先往下划几下看看XHR的内容变化二:分析js中的代码内容三:获取一页中的内容四:获取图片五:保存在本地 使用的库1. requests 网页获取库 2.fro ...

- Python爬虫笔记一(来自MOOC) Requests库入门

Python爬虫笔记一(来自MOOC) 提示:本文是我在中国大学MOOC里面自学以及敲的一部分代码,纯一个记录文,如果刚好有人也是看的这个课,方便搬运在自己电脑上运行. 课程为:北京理工大学-嵩天-P ...

- Python爬虫基础--爬取车模照片

import urllib from urllib import request, parse from lxml import etree class CarModel: def __init__( ...

- python爬虫-基础入门-爬取整个网站《3》

python爬虫-基础入门-爬取整个网站<3> 描述: 前两章粗略的讲述了python2.python3爬取整个网站,这章节简单的记录一下python2.python3的区别 python ...

- python爬虫-基础入门-爬取整个网站《2》

python爬虫-基础入门-爬取整个网站<2> 描述: 开场白已在<python爬虫-基础入门-爬取整个网站<1>>中描述过了,这里不在描述,只附上 python3 ...

- python爬虫-基础入门-爬取整个网站《1》

python爬虫-基础入门-爬取整个网站<1> 描述: 使用环境:python2.7.15 ,开发工具:pycharm,现爬取一个网站页面(http://www.baidu.com)所有数 ...

- Python爬虫基础

前言 Python非常适合用来开发网页爬虫,理由如下: 1.抓取网页本身的接口 相比与其他静态编程语言,如java,c#,c++,python抓取网页文档的接口更简洁:相比其他动态脚本语言,如perl ...

- from appium import webdriver 使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium)

使用python爬虫,批量爬取抖音app视频(requests+Fiddler+appium) - 北平吴彦祖 - 博客园 https://www.cnblogs.com/stevenshushu/p ...

- python爬虫-基础入门-python爬虫突破封锁

python爬虫-基础入门-python爬虫突破封锁 >> 相关概念 >> request概念:是从客户端向服务器发出请求,包括用户提交的信息及客户端的一些信息.客户端可通过H ...

随机推荐

- 插件 uploadify

一.属性 属性名称 默认值 说明 auto true 设置为true当选择文件后就直接上传了,为false需要点击上传按钮才上传 . buttonClass ” 按钮样式 buttonCursor ‘ ...

- Docs命令大全 备用

#1 一: net use \\ip\ipc$ " " /user:" " 建立IPC空链接 net use \\ip\ipc$ "密码" ...

- Gcc对头文件与库文件的搜索路径

一.简介 对头文件与库文件的搜索路径不太清楚,编译.运行时老碰到问题,ldd查看程序的链接时,总是出现unkown链接. 二.头文件 gcc 在编译时寻找所需要的头文件 : 1)搜寻会从-I开始 2) ...

- 我们为什么要在 PHPStorm 中标记目录

问题来源 (1)要开发的项目位于PHPStorm打开的项目的二级目录下,使用PHPStorm来开发Laravel项目 提供的教程在代码自动定位和智能提醒方面,存在无效的情况: (2)使用gulp作为项 ...

- sql查询磁盘空间并发预警邮件

检测磁盘空间,如果低于设置的预警值则发出一封预警邮件,这样的事情可以用SQL server的作业可以做,关键SQL语句如下例子所示: DECLARE @TableText NVARCHAR(MAX)= ...

- Chrome Command Line API 参考

- UVa 11419 SAM I AM (最小覆盖数)

题意:给定一个 n * m 的矩阵,有一些格子有目标,每次可以消灭一行或者一列,问你最少要几次才能完成. 析:把 行看成 X,把列看成是 Y,每个目标都连一条线,那么就是一个二分图的最小覆盖数,这个答 ...

- view添加虚线边框

CAShapeLayer *border = [CAShapeLayer layer]; border.strokeColor = SLColorLine.CGCo ...

- GPS原理及其应用

第一章 绪论 GPS定位原理: 卫星轨道未知情况下,通过几个已知站点观测卫星,利用卫星信号的多普勒效应,就可以确定卫星轨道. 卫星轨道已知情况下,用户观测卫星信号,就可以确定用户的位置. 这原来是在海 ...

- 如何学习C++? C++ Primer第三版中文版

C++只是一门工具,要在实际项目中才能感受到它的伟大.是慢慢积累的(任何知识都是,冰冻三尺非一日之寒),它的思想是慢慢领悟的. 知道它的语法不代表你会用,你会用不代表你就会建造起高水平的作品,这是一个 ...