Python爬虫教程-07-post介绍(百度翻译)(上)

Python爬虫教程-07-post介绍(百度翻译)(上)

- 访问网络两种方法

- get:

- 利用参数给服务器传递信息

- 参数为dict,使用parse编码

- post :(今天给大家介绍的post)

- 一般向服务器传递参数使用

- post是把信息自动加密处理

- 使用post传递信息,需要用到data参数

- 使用post意味着http的请求头信息可能需要更改:

- Content-Type:application/x-www.form-urlencode

- Content-Length:数据长度

- 简而言之,一旦更改请求的方法,注意其他请求头部信息相适应

- urllib.parse.urlencode可以将字符串自动转换成上面的格式

案例v7

- post经典案例,就是百度翻译

- 利用parse模块模拟post请求

- 分析步骤

- 1.打开开发者工具F12>【Network】>【XHR】>【Headers】

- 2.尝试简单的单词,查看发出的请求

- 3.找到请求地址URL,请求的方式Method

- 4.找到参数的传递格式Content-Type, 参数样式Form Data

- 编写代码

# 案例v7百度翻译

from urllib import request,parse

# 导入json包,负责处理json格式的模块

import json

'''

大致流程:

1.利用data构造内容,然后urlopen打开

2.返回一个json格式的结果

3.结果就应该是服务器返回的释义

'''

baseurl = 'http://fanyi.baidu.com/sug'

# 存放用来模拟form的数据,一定是dict格式

keyword = input("请输入需要翻译的内容:")

data = {

'kw': keyword

}

# print(data)

# 需要使用parse模块对data进行编码

data = parse.urlencode(data)

data = data.encode('utf-8')

# print("编码后的data:",data)

# print("编码后的data类型:",type(data))

# 当需要类型为bytes时:在数据的后面加上: data = data.encode('utf-8')

# 构造请求头,请求头部至少包含:

# 1.传入数据的长度

# 2.request要求传入的请求是一个dict格式

# 有了headers,data,url就可以尝试发出请求

rsp = request.urlopen(baseurl,data=data)

json_data = rsp.read().decode()

# 把json字符串转换为字典

json_data = json.loads(json_data)

# print(json_data)

for item in json_data['data']:

if item['k'] == keyword:

print(item['k'], ": ", item['v'])

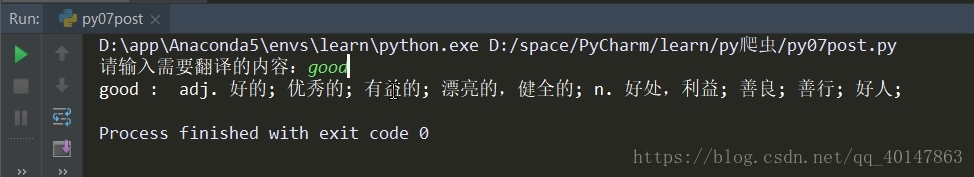

运行结果

更多文章链接:Python 爬虫随笔

- 本笔记不允许任何个人和组织转载

Python爬虫教程-07-post介绍(百度翻译)(上)的更多相关文章

- Python爬虫教程-06-爬虫实现百度翻译(requests)

使用python爬虫实现百度翻译(requests) python爬虫 上一篇介绍了怎么使用浏览器的[开发者工具]获取请求的[地址.状态.参数]以及使用python爬虫实现百度翻译功能[urllib] ...

- Python爬虫教程-01-爬虫介绍

Spider-01-爬虫介绍 Python 爬虫的知识量不是特别大,但是需要不停和网页打交道,每个网页情况都有所差异,所以对应变能力有些要求 爬虫准备工作 参考资料 精通Python爬虫框架Scrap ...

- Python爬虫【实战篇】百度翻译

先看代码 import requests headers = { "User-Agent": "Mozilla/5.0 (Macintosh; Intel Mac OS ...

- Python爬虫教程-00-写在前面

鉴于好多人想学Python爬虫,缺没有简单易学的教程,我将在CSDN和大家分享Python爬虫的学习笔记,不定期更新 基础要求 Python 基础知识 Python 的基础知识,大家可以去菜鸟教程进行 ...

- Python爬虫教程-12-爬虫使用cookie爬取登录后的页面(人人网)(上)

Python爬虫教程-12-爬虫使用cookie(上) 爬虫关于cookie和session,由于http协议无记忆性,比如说登录淘宝网站的浏览记录,下次打开是不能直接记忆下来的,后来就有了cooki ...

- Python爬虫教程-08-post介绍(百度翻译)(下)

Python爬虫教程-08-post介绍(下) 为了更多的设置请求信息,单纯的通过urlopen已经不太能满足需求,此时需要使用request.Request类 构造Request 实例 req = ...

- Python爬虫教程-34-分布式爬虫介绍

Python爬虫教程-34-分布式爬虫介绍 分布式爬虫在实际应用中还算是多的,本篇简单介绍一下分布式爬虫 什么是分布式爬虫 分布式爬虫就是多台计算机上都安装爬虫程序,重点是联合采集.单机爬虫就是只在一 ...

- Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍

本篇介绍项目开发的过程中,对 Setting 文件的配置和使用 Python爬虫教程-32-Scrapy 爬虫框架项目 Settings.py 介绍 settings.py 文件的使用 想要详细查看 ...

- Python爬虫教程-30-Scrapy 爬虫框架介绍

从本篇开始学习 Scrapy 爬虫框架 Python爬虫教程-30-Scrapy 爬虫框架介绍 框架:框架就是对于相同的相似的部分,代码做到不出错,而我们就可以将注意力放到我们自己的部分了 常见爬虫框 ...

随机推荐

- GDB:从单线程调试到多线程调试(MFiX单步调试)

GDB:从单线程调试到多线程调试 1. 裸跑GDB 1.1 安装GDB sudo apt-get install gdb 1.2 编译程序 由于需要调试,因此编译的时候需要添加-g编译参数: 1.3 ...

- C#控制台画图形

static void Main(string[] args) { //九九乘法 Console.WriteLine("九九乘法口诀"); ; i <= ; i++) { ; ...

- IDE神器intellij idea的基本使用 (转载)

一.关于新建工程,导入工程,配置jdk,tomcat这里不做过多的讲述,必定网络上关于此类配置一堆一堆的. 二.编码快捷键(比较常用的快捷键)该套快捷键选择的是:Mac OS X 10.5+ 1. a ...

- linux 安装php bz2扩展

折腾了半天,最大的坑就是我是用lnmp一键安装php环境,php7下面没有ext文件夹,有个include下面虽然有个ext 但是里面没有需要的bz2 也尝试去pecl 和 pear 上面去找 无 ...

- Mac版sublime text右键open in browser 不能识别中文名解决办法

问题描述: Mac下sublime text下打开中文命名的html文件,右键open in browser,浏览器无反应. 解决思路: 要么适应软件,要么改进软件来适应. 1. 将中文名的html ...

- WPF中C#代码触发鼠标点击事件

1.如下代码; <Button x:Name="btnTest" Click="btnTest_Click"> <Button.Trigger ...

- WPF DataTemplate與ControlTemplate

一. 前言 什麼是DataTemplate? 什麼是ControlTemplate? 在stackoverflow有句簡短的解釋 "A DataTemplate, therefore ...

- maven多模块下新建子模块

选中parent模块,右键选择new---others 选择Maven---Maven Module,点击下一步 填写Module Name,其他默认,点击下一步 默认,下一步 默认,点击完成

- git hub 建立公钥

1. 执行 $ eval "$(ssh-agent -s)" 2. 增加 ssh $ ssh-add ~/.ssh/id_rsa 3. 复制 生成的key (执行下面命令后就相当 ...

- Toolstrip 工具栏控件

工具栏是另一种获取应用程序主要功能的常用方法,比起菜单更直观. Tool strip 控件是由system.Windows.forms.Toolstrip类提供的,作用是创建易于自定义的常用工具栏 ...