Python疫情爬取输出到txt文件

在网上搬了一个代码,现在不适用了,改了改

import requests

import json

def Down_data():

url = 'https://view.inews.qq.com/g2/getOnsInfo?name=disease_h5'

headers = {

'user-agent': 'Mozilla/5.0 (Linux; Android 6.0; Nexus 5 Build/MRA58N) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/78.0.3904.108 Mobile Safari/537.36'

}

r = requests.get(url, headers)

res = json.loads(r.text)

data_res = json.loads(res['data'])

return data_res

def Parse_data1():

data = Down_data()

list = ['截至时间:' + str(data['lastUpdateTime']) + '\n'

'全国确诊人数:' + str(data['chinaTotal']['confirm']) + '\n'

'今日新增确诊:' + str(

data['chinaAdd']['confirm']) + '\n'

'全国疑似:' + str(data['chinaTotal']['suspect']) + '\n'

'今日新增疑似:' + str(

data['chinaAdd']['suspect']) + '\n'

'全国治愈:' + str(data['chinaTotal']['heal']) + '\n'

'今日新增治愈:' + str(

data['chinaAdd']['heal']) + '\n'

'全国死亡:' + str(data['chinaTotal']['dead']) + '\n'

'今日新增死亡:' + str(

data['chinaAdd']['dead']) + '\n']

result = ''.join(list)

with open('疫情查询.txt', 'a+', encoding="utf-8") as f:

f.write(result + '\n')

def Parse_data2():

data = Down_data()['areaTree'][0]['children']

path = str(input('请输入你要查询的省份:'))

for i in data:

if path in i['name']:

for item in i['children']:

list_city = [

'地区: ' + str(item['name']) + ' '

' 确诊人数:' + str(item['total']['confirm']),

' 新增确诊:' + str(item['today']['confirm']),

' 治愈:' + str(item['total']['heal']),

# ' 新增治愈:' + str(item['today']['heal']),

' 死亡:' + str(item['total']['dead']) + '\n',

# ' 新增死亡:' + str(item['today']['dead']) + '\n'

]

res_city = ''.join(list_city)

with open('疫情查询.txt', 'a+', encoding="utf-8") as f:

f.write(res_city)

Down_data()

Parse_data1()

Parse_data2()

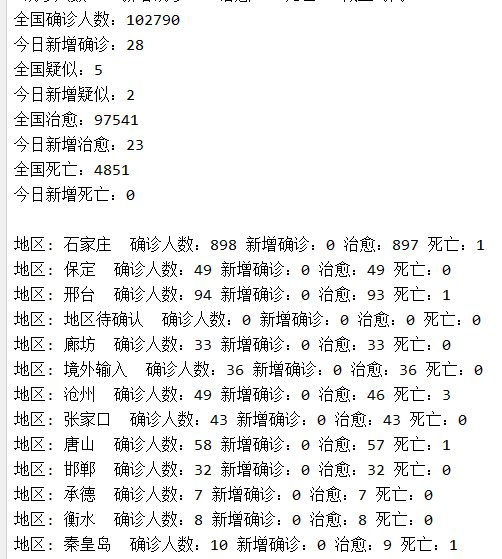

效果:

Python疫情爬取输出到txt文件的更多相关文章

- Python实例---爬取下载喜马拉雅音频文件

PyCharm下python爬虫准备 打开pycharm 点击设置 点击项目解释器,再点击右边+号 搜索相关库并添加,例如:requests 喜马拉雅全网递归下载 打开谷歌/火狐浏览器,按F12打开开 ...

- python连续爬取多个网页的图片分别保存到不同的文件夹

python连续爬取多个网页的图片分别保存到不同的文件夹 作者:vpoet mail:vpoet_sir@163.com #coding:utf-8 import urllib import ur ...

- 用Python爬虫爬取广州大学教务系统的成绩(内网访问)

用Python爬虫爬取广州大学教务系统的成绩(内网访问) 在进行爬取前,首先要了解: 1.什么是CSS选择器? 每一条css样式定义由两部分组成,形式如下: [code] 选择器{样式} [/code ...

- Python爬虫爬取全书网小说,程序源码+程序详细分析

Python爬虫爬取全书网小说教程 第一步:打开谷歌浏览器,搜索全书网,然后再点击你想下载的小说,进入图一页面后点击F12选择Network,如果没有内容按F5刷新一下 点击Network之后出现如下 ...

- Scrapy教程——搭建环境、创建项目、爬取内容、保存文件

1.创建项目 在开始爬取之前,您必须创建一个新的Scrapy项目.进入您打算存储代码的目录中,运行新建命令. 例如,我需要在D:\00Coding\Python\scrapy目录下存放该项目,打开命令 ...

- python之爬取网页数据总结(一)

今天尝试使用python,爬取网页数据.因为python是新安装好的,所以要正常运行爬取数据的代码需要提前安装插件.分别为requests Beautifulsoup4 lxml 三个插件 ...

- 一个简单的python爬虫,爬取知乎

一个简单的python爬虫,爬取知乎 主要实现 爬取一个收藏夹 里 所有问题答案下的 图片 文字信息暂未收录,可自行实现,比图片更简单 具体代码里有详细注释,请自行阅读 项目源码: # -*- cod ...

- 全球疫情爬取APP版

全球疫情统计APP图表展示: 将该任务分解成三部分来逐个实现: ①爬取全球的疫情数据存储到云服务器的MySQL上 ②在web项目里添加一个servlet,通过参数的传递得到对应的json数据 ③设计A ...

- python定时器爬取豆瓣音乐Top榜歌名

python定时器爬取豆瓣音乐Top榜歌名 作者:vpoet mail:vpoet_sir@163.com 注:这些小demo都是前段时间为了学python写的,现在贴出来纯粹是为了和大家分享一下 # ...

随机推荐

- [USACO20FEB]Equilateral Triangles P 题解

优雅的暴力. 设三个点为 \((i,j,k)\),则有 \(6\) 个未知数即 \(x_i,x_j,x_k,y_i,y_j,y_k\).又因为有 \(2\) 条关于这 \(6\) 个未知数的方程 \( ...

- C# 线程与任务

线程 线程:对于所有需要等待的操作,例如移动文件,数据库和网络访问都需要一定的时间,此时就可以启动一个新的线程,同时完成其他任务.一个进程的多个线程可以同时运行在不同的CPU上或多核CPU的不同内核上 ...

- WPF之转换器

IValueConverter的用法1. COnvert方法object Convert( object value, Type targetType, object parameter, Cultu ...

- 一文让你明白CPU上下文切换

我们都知道,Linux 是一个多任务操作系统,它支持远大于 CPU 数量的任务同时运行.当然,这些任务实际上并不是真的在同时运行,而是因为系统在很短的时间内,将 CPU 轮流分配给它们,造成多任务同时 ...

- 领域驱动模型DDD(一)——服务拆分策略

前言 领域驱动模型设计在业界也喊了几年口号了,但是对于很多"务实"的程序员来说,纸上谈"术"远比敲代码难得太多太多.本人能力有限,在拜读相关作品时既要隐忍书中晦 ...

- CTF--这好像不是文件上传

打开题目F12看到一个被注释的跳转. 访问可以知道是一个文件包含 经过测试,该文件禁止了input.data关键字.并禁止了phar://协议. 使用php://filter读取题目源码得到 http ...

- [转载]详解ssh端口转发(二)

关于使用ssh portforwarding来进行FQ的操作,网络上已经有很多很好的文章,我在这里只是画两个图解释一下. 首先要记住一件事情就是: SSH 端口转发自然需要 SSH 连接,而 SSH ...

- 【死磕NIO】— 探索 SocketChannel 的核心原理

大家好,我是大明哥,一个专注于[死磕 Java]系列创作的程序员. [死磕 Java ]系列为作者「chenssy」 倾情打造的 Java 系列文章,深入分析 Java 相关技术核心原理及源码. 死磕 ...

- 深度学习训练过程中的学习率衰减策略及pytorch实现

学习率是深度学习中的一个重要超参数,选择合适的学习率能够帮助模型更好地收敛. 本文主要介绍深度学习训练过程中的6种学习率衰减策略以及相应的Pytorch实现. 1. StepLR 按固定的训练epoc ...

- oracle 跨分区查询效率,Oracle分区表做跨分区查询

问:有一张大表,其中按时间字段(TIME_ID)进行表分区(按季度分区),但是如果业务人员做跨季度的大批量数据的查询时,未能走TIME_ID分区索引,导致全表扫描.此种情况该如何处理? 示例解析: 1 ...