hadoop 源码编译

hadoop 源码编译

1、准备jar

1) hadoop-2.7.2-src.tar.gz

2) jdk-8u144-linux-x64.tar.gz

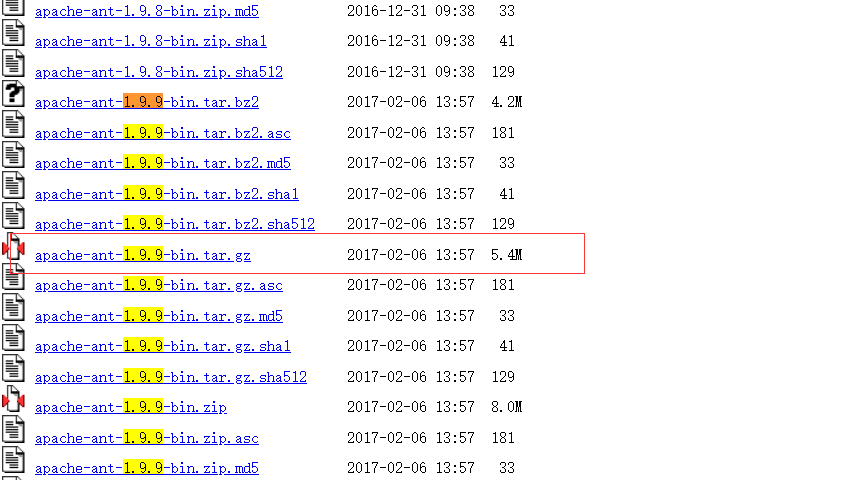

3) apach-ant-1.9.9-bin.tar.gz

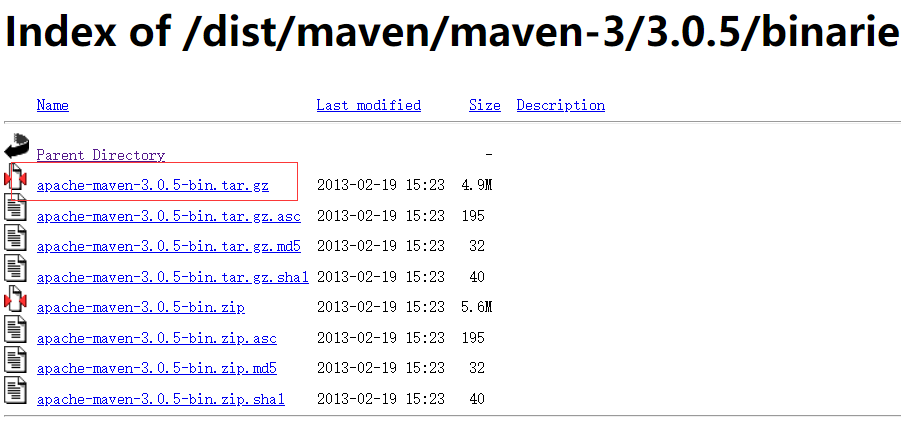

4) apache-maven-3.0.5-bin.tar.gz

5) protobuf-2.5.0.tar.gz

2、

2.1、maven 配置

下载 3.0.5 版本 https://archive.apache.org/dist/maven/maven-3/3.0.5/binaries/

放到 /opt/module 下面 tar -zxvf 解压

再 "vi conf/settings.xml" 配置镜像地址

<mirror>

<id>nexus-aliyun</id>

<mirrorOf>central</mirrorOf>

<name>Nexus aliyun</name>

<url>http://maven.aliyun.com/nexus/content/groups/public</url>

</mirror>

配置maven路径 vi /etc/profile

#MAVEN_HOME

export MAVEN_HOME=#MAVEN_HOME

export MAVEN_HOME=/opt/module/apache-maven-3.0.5

export PATH=$PATH:$MAVEN_HOME/bin

2.2、

下载 https://archive.apache.org/dist/ant/binaries/

解压,再

#ANT_HOME

export ANT_HOME=/opt/module/apache-ant-1.9.9

export PATH=$PATH:$ANT_HOME/bin

安装 glibc-header, g++, make, cmake

#yum install glibc-headers

#yum install gcc-c++

#yum install make

#yum install cmake

下载 protobuf-2.5.0.tar.gz, 在/opt/module下解压

./configure

make

make check

make install

ldconfig

vi /etc/profile

#LD_LIBRARY_PATH

export LD_LIBRARY_PATH=/opt/module/protobuf-2.5.

export PATH=$PATH:$LD_LIBRARY_PATH

source /etc/profile

yum install openssl-devel

yum install ncurses-devel

hadoop 源码编译的更多相关文章

- Hadoop源码编译过程

一. 为什么要编译Hadoop源码 Hadoop是使用Java语言开发的,但是有一些需求和操作并不适合使用java,所以就引入了本地库(Native Libraries)的概念,通 ...

- hadoop源码编译

为何要自行编译hadoop源码,往往是由于官方提供的hadoop发行版都是基于32位操作系统,在操作hadoop时会发生warn. 准备软件: 1)JDK 2)Hadoop源码 3)Maven 4 ...

- Hadoop源码编译环境搭建

准备工具: maven 3.0.0版本或者更高版本(配置中心库) protocbuff 2.5.0 http://www.zlib.net/ git bash(Windows环境可以用此工具执行编译命 ...

- hadoop源码编译——2.5.0版本

强迫症必治: WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using b ...

- Hadoop 源码编译导出

https://svn.apache.org/repos/asf/hadoop/common/branches/branch-trunk-win/BUILDING.txt http://www.src ...

- hadoop源码编译--maven安装

一 下载maven bin包并解压 $ wget http://mirror.bit.edu.cn/apache/maven/maven-3/3.3.9/binaries/apache-maven-3 ...

- hadoop-1.2.0源码编译

以下为在CentOS-6.4下hadoop-1.2.0源码编译步骤. 1. 安装并且配置ant 下载ant,将ant目录下的bin文件夹加入到PATH变量中. 2. 安装git,安装autoconf, ...

- Hadoop源码阅读环境搭建(IDEA)

拿到一份Hadoop源码之后,经常关注的两件事情就是 1.怎么阅读?涉及IDEA和Eclipse工程搭建.IDEA搭建,选择源码,逐步导入即可:Eclipse可以选择后台生成工程,也可以选择IDE导入 ...

- Hadoop,HBase,Zookeeper源码编译并导入eclipse

基本理念:尽可能的参考官方英文文档 Hadoop: http://wiki.apache.org/hadoop/FrontPage HBase: http://hbase.apache.org/b ...

随机推荐

- hdu 6465 线性变换高斯消元

http://acm.hdu.edu.cn/showproblem.php?pid=6465 题意 给你三个点,再给你经过线性变换后的三个点,然后q次询问,给你一个点,需要你输出线性变换后的点 题解 ...

- Windows安装RabbitMQ并设置数据存储目录

一.安装Elang 下载otp_win64_xx.x.exe,当前使用otp_win64_21.3.exe版本,按步骤完成安装. 下载地址:http://www.erlang.org/download ...

- 《一起学netty》

o文章摘自 netty 官网(netty.io) netty 是一个异步的,事件驱动的网络应用通信框架,可以让我们快速编写可靠,高性能,高可扩展的服务端和客户端 样例一:discard ser ...

- python操作时间

一.问题背景 在对数据进行操作的时候我们总是会遇到数据类型是date类型的数据,这种数据会让我们在使用和操作的过程中遇到一些问题,比如int类型和date类型不对等,string类型和date类型不对 ...

- linux中查找包含指定内容的文件

Linux查找文件内容的常用方法 ##文件名+内容 grep -r "查询内容" 文件目录 ##只显示包含内容的文件名 grep -r -l "查询内容" 文件 ...

- 如何判断服务器之间的服务是否可用?ping 还是 telnet?

1. 背景 机器A需要调用机器B的服务,为此要保证服务的可用性,我们有时候用ping,有时候用telent来验证机器A和B的连通性,但有时候会出现这种情况,A可以ping通B,但A调用B的服务会一直报 ...

- 时间复杂度o(1), o(n), o(logn), o(nlogn)

1.时间复杂度o(1), o(n), o(logn), o(nlogn).算法时间复杂度的时候有说o(1), o(n), o(logn), o(nlogn),这是算法的时空复杂度的表示.不仅仅用于表示 ...

- Winform 通过 WebBrowser 与 JS 交互

Winform 通过 WebBrowser 与 JS 交互 魏刘宏 2019.08.17 之前在使用 Cef (可在 Winform 或 WPF 程序中嵌入 Chrome 内核的网页浏览器的组件)时, ...

- Winform中设置ZedGraph多条Y轴时坐标轴左右显示设置

场景 Winform中实现ZedGraph的多条Y轴(附源码下载): https://blog.csdn.net/BADAO_LIUMANG_QIZHI/article/details/1001322 ...

- WEBAPI 设置上传文件大小

参考资料:https://stackoverflow.com/questions/33399267/cors-error-when-uploading-larger-files https:// ...