python爬虫笔记之爬取足球比赛赛程

目标:爬取某网站比赛赛程,动态网页,则需找到对应ajax请求(具体可参考:https://blog.csdn.net/you_are_my_dream/article/details/53399949)

# -*- coding:utf-8 -*-

import sys

import re

import urllib.request link = "https://***"

r = urllib.request.Request(link)

r.add_header('User-Agent','Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.115 Safari/537.36')

html = urllib.request.urlopen(r,timeout=500).read()

html = bytes.decode(html,encoding="gbk")

#返回大量json,需提取 #找出返回json中对应正则匹配的字符串

js = re.findall('"n":"(.*?)"',html)

i=0 #循环打印比赛信息

try:

while(1):

#将字符串Unicode转化为中文,并输出

print (js[i].encode('utf-8').decode('unicode_escape'),js[i+1].encode('utf-8').decode('unicode_escape'),"VS",js[i+2].encode('utf-8').decode('unicode_escape'))

i=i+3

#当所有赛程爬取结束时,会报错“IndexError:list index out of range”,所以进行异常处理

except IndexError:

print ("finished")

总结注意点:

1、python 3 采用这个import urllib.request

因为urllib和urllib2合体了。

2、字符串Unicode转为中文需注意python3与python2的表示方法不同:

python3:print 字符串.encode('utf-8').decode('unicode_escape')

python2:print 字符串.decode('unicode_escape')

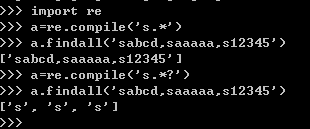

3、re.findall()

关于这个函数,他的输出内容规律可以参考我之前写的:http://www.cnblogs.com/4wheel/p/8497121.html

【"n":"(.*?)"】 这个表达式只输出(.*?)这部分(为什么,还是参考我之前写的那篇文章),加上问号就是非贪婪模式,不加就是贪婪模式,顺便实践解释下贪婪模式

example:

总结:非贪婪模式就是在满足正则表达式的情况下,尽可能少的匹配。

相反,贪婪模式就是在满足正则表达式的情况下,尽可能多的匹配。

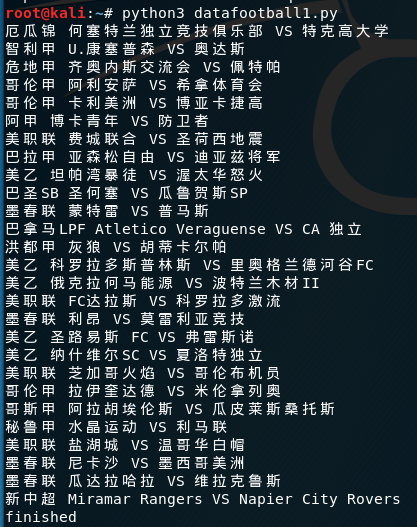

so,爬取结果为:

python爬虫笔记之爬取足球比赛赛程的更多相关文章

- Python爬虫教程-17-ajax爬取实例(豆瓣电影)

Python爬虫教程-17-ajax爬取实例(豆瓣电影) ajax: 简单的说,就是一段js代码,通过这段代码,可以让页面发送异步的请求,或者向服务器发送一个东西,即和服务器进行交互 对于ajax: ...

- 【转载】教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神

原文:教你分分钟学会用python爬虫框架Scrapy爬取心目中的女神 本博文将带领你从入门到精通爬虫框架Scrapy,最终具备爬取任何网页的数据的能力.本文以校花网为例进行爬取,校花网:http:/ ...

- Python爬虫实例:爬取B站《工作细胞》短评——异步加载信息的爬取

很多网页的信息都是通过异步加载的,本文就举例讨论下此类网页的抓取. <工作细胞>最近比较火,bilibili 上目前的短评已经有17000多条. 先看分析下页面 右边 li 标签中的就是短 ...

- Python爬虫实例:爬取猫眼电影——破解字体反爬

字体反爬 字体反爬也就是自定义字体反爬,通过调用自定义的字体文件来渲染网页中的文字,而网页中的文字不再是文字,而是相应的字体编码,通过复制或者简单的采集是无法采集到编码后的文字内容的. 现在貌似不少网 ...

- Python爬虫实例:爬取豆瓣Top250

入门第一个爬虫一般都是爬这个,实在是太简单.用了 requests 和 bs4 库. 1.检查网页元素,提取所需要的信息并保存.这个用 bs4 就可以,前面的文章中已经有详细的用法阐述. 2.找到下一 ...

- python爬虫-基础入门-爬取整个网站《3》

python爬虫-基础入门-爬取整个网站<3> 描述: 前两章粗略的讲述了python2.python3爬取整个网站,这章节简单的记录一下python2.python3的区别 python ...

- python爬虫-基础入门-爬取整个网站《2》

python爬虫-基础入门-爬取整个网站<2> 描述: 开场白已在<python爬虫-基础入门-爬取整个网站<1>>中描述过了,这里不在描述,只附上 python3 ...

- python爬虫-基础入门-爬取整个网站《1》

python爬虫-基础入门-爬取整个网站<1> 描述: 使用环境:python2.7.15 ,开发工具:pycharm,现爬取一个网站页面(http://www.baidu.com)所有数 ...

- Python 爬虫入门之爬取妹子图

Python 爬虫入门之爬取妹子图 来源:李英杰 链接: https://segmentfault.com/a/1190000015798452 听说你写代码没动力?本文就给你动力,爬取妹子图.如果 ...

随机推荐

- 改善C#程序的建议7:正确停止线程

原文:改善C#程序的建议7:正确停止线程 开发者总尝试对自己的代码有更多的控制.“让那个还在工作的线程马上停止下来”就是诸多要求中的一种.然而事与愿违,这里面至少存在两个问题: 第一个问题是:正如线程 ...

- Caliburn.Micro 自定义View和ViewModel的匹配规则

使用TypeMappingConfiguration类 //Override the default subnamespaces var config = new TypeMappingConfigu ...

- CentOS7 firewall与iptables防火墙的使用与开放端口

如何关闭firewall并开启iptables防火墙 如何使用firewall防火墙 如何关闭firewall并开启iptables防火墙 1.停止firewall systemctl stop fi ...

- QTableWidget简单应用之文件浏览器

实现下面这个简单的文件浏览功能,常用的QTableWidget设置都用到了. 基本设置 ui->tableWidget->setColumnCount(5); //设置表格列数 ui- ...

- 配置 ClientIDMode 控件ID生成规则

废话不说先例子: <asp:GridView ID="grd" runat="server"AutoGenerateColumns="False ...

- Codility---FrogJmp

Task description A small frog wants to get to the other side of the road. The frog is currently loca ...

- vue+TS(CLI3)

1.用CLI3创建项目 查看当前CLI的版本,如果没有安装CLI3的 使用npm install --global vue-cli来安装CLI 安装好CLI 可以创建项目了 使用vue create ...

- 30443数据查询语言DQL

5.4 SQL的数据查询功能 数据查询是数据库最常用的功能.在关系数据库中,查询操作是由SELECT语句来完成.其语法格式如下: SELECT column_expression FROM table ...

- PHP实现图片(文件)上传

这几天整理做过的php项目,感觉这个经常会用到,传上来共享一下咯 首先,前端界面 1.表单的首行需要加上enctype="multipart/form-data",需要上传的图片必 ...

- 阿里云部署Redis服务器远程连接问题

昨天在阿里云免费领了一个月的云服务器,就着最近学的SpringBoot,准备做一个SpringBoot与Redis的整合. 因为以前用的Redis都是安装在本地的,使用过程中没遇到什么大问题,可是一旦 ...