ajax的get方法获取豆瓣电影前10页的数据

# _*_ coding : utf-8 _*_

# @Time : 2021/11/2 11:45

# @Author : 秋泊酱 # 1页数据 电影条数20

# https://movie.douban.com/j/chart/top_list?type=5&interval_id=100%3A90&action=&

# start=0&limit=20 # 2页数据

# https://movie.douban.com/j/chart/top_list?type=5&interval_id=100%3A90&action=&

# start=20&limit=20 # 3页数据

# https://movie.douban.com/j/chart/top_list?type=5&interval_id=100%3A90&action=&

# start=40&limit=20 # 4页数据

# https://movie.douban.com/j/chart/top_list?type=5&interval_id=100%3A90&action=&

# start=60&limit=20 # page页 1 2 3 4

# start开始 0 20 40 60 # 算法

# start (page - 1)*20 # 下载豆瓣电影前10页的数据

# (1) 请求对象的定制

# (2) 获取响应的数据

# (3) 下载数据 import urllib.parse

import urllib.request # 1) 请求对象的定制

def create_request(page):

# 请求路径

base_url = 'https://movie.douban.com/j/chart/top_list?type=5&interval_id=100%3A90&action=&'

# 请求参数

data = {

'start': (page - 1) * 20,

'limit': 20

}

# 常用 urllib.parse.urlencode(data) 解析data字典中的参数进行url拼接

data = urllib.parse.urlencode(data)

# 请求资源链接的拼接

url = base_url + data

# 请求头

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/92.0.4515.159 Safari/537.36'

}

# 请求对象的定制(url参数传递,headers参数传递)

request = urllib.request.Request(url=url, headers=headers)

# 函数返回

return request # 2) 获取响应的数据

def get_content(request):

# 模拟浏览器B,向服务器S,发送请求

response = urllib.request.urlopen(request)

# 获取响应数据(read读方法返回字节形式二进制数据.decode解密)

content = response.read().decode('utf-8')

# 函数返回

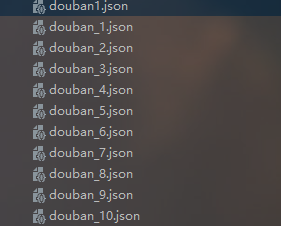

return content # 3) 下载数据

def down_load(page,content):

# python的字符串拼接,两边都要是str字符串类型

with open('douban_' + str(page) + '.json', 'w', encoding='utf-8')as fp:

# 向文件中写入

fp.write(content) # 程序的入口

if __name__ == '__main__':

start_page = int(input('请输入起始的页码'))

end_page = int(input('请输入结束的页面')) for page in range(start_page,end_page+1):

#每一页都有自己的请求对象的定制

request = create_request(page)

#获取响应的数据

content = get_content(request)

#下载

down_load(page,content)

ajax的get方法获取豆瓣电影前10页的数据的更多相关文章

- 如何获取豆瓣电影 API Key

如何获取豆瓣电影 API Key 豆瓣 API Key 不能使用了 ! solutions & !== ? https://frodo.douban.com/api/v2/subject_co ...

- python 获取当天和前几天时间数据

python 获取当天和前几天时间数据 import datetime from datetime import datetime, date, timedelta def dayDateRange( ...

- 解决 MySQL 比如我要拉取一个消息表中用户id为1的前10条最新数据

我们都知道,各种主流的社交应用或者阅读应用,基本都有列表类视图,并且都有滑到底部加载更多这一功能, 对应后端就是分页拉取数据.好处不言而喻,一般来说,这些数据项都是按时间倒序排列的,用户只关心最新的动 ...

- 【学习笔记】Python 3.6模拟输入并爬取百度前10页密切相关链接

[学习笔记]Python 3.6模拟输入并爬取百度前10页密切相关链接 问题描述 通过模拟网页,实现百度搜索关键词,然后获得网页中链接的文本,与准备的文本进行比较,如果有相似之处则代表相关链接. me ...

- python爬虫实战 获取豆瓣排名前250的电影信息--基于正则表达式

一.项目目标 爬取豆瓣TOP250电影的评分.评价人数.短评等信息,并在其保存在txt文件中,html解析方式基于正则表达式 二.确定页面内容 爬虫地址:https://movie.douban.co ...

- 利用AJAX JAVA 通过Echarts实现豆瓣电影TOP250的数据可视化

mysql表的结构 数据(数据是通过爬虫得来的,本篇文章不介绍怎么爬取数据,只介绍将数据库中的数据可视化): 下面就是写代码了: 首先看一下项目目录: 数据库层 业务逻辑层 pac ...

- 【Python爬虫】:使用高性能异步多进程爬虫获取豆瓣电影Top250

在本篇博文当中,将会教会大家如何使用高性能爬虫,快速爬取并解析页面当中的信息.一般情况下,如果我们请求网页的次数太多,每次都要发出一次请求,进行串行执行的话,那么请求将会占用我们大量的时间,这样得不偿 ...

- 获取豆瓣电影数据(R与API获取网页数据)

一般成熟的网站都会有反爬虫策略,例如限制访问次数,限制访问 IP,动态显示数据等.爬虫和反爬虫就是一直相爱相杀地互相钳制.如果要通过爬虫来获取某些大型网站的数据,那是一件很费时费力的活.小白总遭遇过在 ...

- sql分组(orderBy、GroupBy)获取每组前一(几)条数据

sql数据库实现分组并取每组的前1(几)条数据 测试数据准备工作: 根据某一个字段分组取最大(小)值所在行的数据: 创建表并且插入数据 ),Val )) , 'a1--a的第一个值') , 'b2b2 ...

随机推荐

- 请求既有multipartFile,也有实体的解决方案

上回书我们说到,我们在发文件上传请求的时候,携带数据 this.fileData.append('trainName', this.dataModel.trainName); // 添加培训名称 然后 ...

- 【vue】使用 Video.js 播放视频

目录 安装 引入 使用 参考文档 环境: vue 2.0+ element ui (这里的代码用了elmentui的按钮样式,可以不用elment ui的样式) 安装 在项目中安装 video.js. ...

- Springboot中使用Redisson实现分布式锁

1. 概述 老话说的好:便宜没好货,有价值的商品,即使再贵,也有人会买. 言归正传,今天继续讨论有关"锁"的话题,synchronized 和 ReentrantLock 大家应该 ...

- Go语言核心36讲(导读)--学习笔记

目录 开篇词 | 跟着学,你也能成为Go语言高手 导读 | 写给0基础入门的Go语言学习者 导读 | 学习专栏的正确姿势 开篇词 | 跟着学,你也能成为Go语言高手 Go 语言是由 Google 出品 ...

- JavaScript数组 几个常用方法

前言 数组方法有太多了,本文记录一些本人容易记错的一些数组方法,用于巩固及复习. 后续会慢慢的将其他数组方法添加进来. 善用数组方法可以使数据处理变的优雅且简单. 那下面让我们开始吧: filter( ...

- 重磅 | 阿里开源首个 Serverless 开发者平台 Serverless Devs

Serverless 从概念提出到应用,已经走过了 8 个年头,开发者对 Serverless 的使用热情不断高涨.为帮助开发者实现一键体验多云产品,极速部署 Serverless 项目,10 月 2 ...

- 第21篇-加载与存储指令之iload、_fast_iload等(3)

iload会将int类型的本地变量推送至栈顶.模板定义如下: def(Bytecodes::_iload , ubcp|____|clvm|____, vtos, itos, iload , _ ); ...

- ElasticSearch IK热词自动热更新原理与Golang实现

热更新概述 ik分词器本身可以从配置文件加载扩张词库,也可以从远程HTTP服务器加载. 从本地加载,则需要重启ES生效,影响比较大.所以,一般我们都会把词库放在远程服务器上.这里主要有2种方式: 借助 ...

- 【二食堂】Beta - Scrum Meeting 12

Scrum Meeting 12 例会时间:5.27 20:00~20:10 进度情况 组员 当前进度 今日任务 李健 1. 知识图谱导出功能完成 issue 1. 继续完成文本保存的工作 issue ...

- UltraSoft - Alpha - Scrum Meeting 5

Date: Apr q9th, 2020. Scrum 情况汇报 进度情况 组员 负责 昨日进度 后两日任务 CookieLau PM 统筹个人进度,协助推进进度 辅助前后端连接工作 刘zh 前端 完 ...