docker 部署 zookeeper+kafka 集群

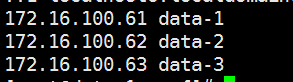

主机三台

172.16.100.61

172.16.100.62

172.16.100.63

Docker 版本 当前最新版

# 部署zk有2种方法

## 注意 \后不要跟空格

一 . 端口映射

172.16.100.61 执行

docker run -tid --name=zk- \

--restart=always \

--privileged=true \

-p : \

-p : \

-p : \

-e ZOO_MY_ID= \

-e ZOO_SERVERS=server.="0.0.0.0:2888:3888 server.2=172.16.100.62:2888:3888 server.3=172.16.100.63:2888:3888" \

-v /data/kafka_cluster/zookeeper/data:/data \

zookeeper:latest

172.16.100.62 执行

docker run -tid --name=zk- \

--restart=always \

--privileged=true \

-p : \

-p : \

-p : \

-e ZOO_MY_ID= \

-e ZOO_SERVERS=server.="172.16.100.61:2888:3888 server.2=0.0.0.0:2888:3888 server.3=172.16.100.63:2888:3888" \

-v /data/kafka_cluster/zookeeper/data:/data \

zookeeper:latest

172.16.100.63 执行

docker run -tid --name=zk- \

--restart=always \

--privileged=true \

-p : \

-p : \

-p : \

-e ZOO_MY_ID= \

-e ZOO_SERVERS=server.="172.16.100.61:2888:3888 server.2=172.16.100.62:2888:3888 server.3=0.0.0.0:2888:3888" \

-v /data/kafka_cluster/zookeeper/data:/data \

zookeeper:latest

#查看集群状态

docker exec -it zk- bash ./bin/zkServer.sh status

二.直接走宿主机IP

每台机器都执行一次,只需要修改 ZOO_MY_ID 即可 只要ZOO_SERVERS 和你的ID一致即可

docker run -tid --name=zk- \

--restart=always \

--privileged=true \

--net=host \

-e ZOO_MY_ID= \

-e ZOO_SERVERS=server.="172.16.100.61:2888:3888 server.2=172.16.100.62:2888:3888 server.3=172.16.100.63:2888:3888" \

-v /data/kafka_cluster/zookeeper/data:/data \

zookeeper:latest

### 上述zk检查过后没有问题就可以进行下一步了 ###

解析主机名

注意: kafka-logs-data-1 是主机的名字 如果你的主机是xxx 那这里应该改为kafka-logs-xxx

同时我映射了本地的hosts到容器里,所有容器获取到的主机名就是宿主机的名字

在61执行

docker run -itd --name=kafka \

--restart=always \

--net=host \

--privileged=true \

-v /etc/hosts:/etc/hosts \

-v /data/kafka_cluster/kafka/data:/kafka/kafka-logs-data- \

-v /data/kafka_cluster/kafka/logs:/opt/kafka/logs \

-e KAFKA_ADVERTISED_HOST_NAME=172.16.100.61 \

-e HOST_IP=172.16.100.61 \

-e KAFKA_ADVERTISED_PORT= \

-e KAFKA_ZOOKEEPER_CONNECT=172.16.100.61:,172.16.100.62:,172.16.100.63: \

-e KAFKA_BROKER_ID= \

-e KAFKA_HEAP_OPTS="-Xmx8196M -Xms8196M" \

wurstmeister/kafka:0.10.1.1

在62执行

docker run -itd --name=kafka \

--restart=always \

--net=host \

--privileged=true \

-v /etc/hosts:/etc/hosts \

-v /data/kafka_cluster/kafka/data:/kafka/kafka-logs-data- \

-v /data/kafka_cluster/kafka/logs:/opt/kafka/logs \

-e KAFKA_ADVERTISED_HOST_NAME=172.16.100.62 \

-e HOST_IP=172.16.100.62 \

-e KAFKA_ADVERTISED_PORT= \

-e KAFKA_ZOOKEEPER_CONNECT=172.16.100.61:,172.16.100.62:,172.16.100.63: \

-e KAFKA_BROKER_ID= \

-e KAFKA_HEAP_OPTS="-Xmx8196M -Xms8196M" \

wurstmeister/kafka:0.10.1.1

在63执行

docker run -itd --name=kafka \

--restart=always \

--net=host \

--privileged=true \

-v /etc/hosts:/etc/hosts \

-v /data/kafka_cluster/kafka/data:/kafka/kafka-logs-data- \

-v /data/kafka_cluster/kafka/logs:/opt/kafka/logs \

-e KAFKA_ADVERTISED_HOST_NAME=172.16.100.63 \

-e HOST_IP=172.16.100.63 \

-e KAFKA_ADVERTISED_PORT= \

-e KAFKA_ZOOKEEPER_CONNECT=172.16.100.61:,172.16.100.62:,172.16.100.63: \

-e KAFKA_BROKER_ID= \

-e KAFKA_HEAP_OPTS="-Xmx8196M -Xms8196M" \

wurstmeister/kafka:0.10.1.1

##创建topic test

#订阅

docker exec -it kafka bash /opt/kafka/bin/kafka-console-consumer.sh --bootstrap-server 172.16.100.61:9092,172.16.100.62:9092,172.16.100.63:9092 --topic test --from-beginning

#发送消息

docker exec -it kafka bash /opt/kafka/bin/kafka-console-producer.sh --broker-list 172.16.100.61:9092,172.16.100.62:9092,172.16.100.63:9092 --topic test

docker 部署 zookeeper+kafka 集群的更多相关文章

- Docker搭建Zookeeper&Kafka集群

最近在学习Kafka,准备测试集群状态的时候感觉无论是开三台虚拟机或者在一台虚拟机开辟三个不同的端口号都太麻烦了(嗯..主要是懒). 环境准备 一台可以上网且有CentOS7虚拟机的电脑 为什么使用虚 ...

- 在kubernetes上部署zookeeper,kafka集群

本文采用网上镜像:mirrorgooglecontainers/kubernetes-zookeeper:1.0-3.4.10 准备共享存储:nfs,glusterfs,seaweed或其他,并在no ...

- Linux Centos7 环境搭建Docker部署Zookeeper分布式集群服务实战

Zookeeper完全分布式集群服务 准备好3台服务器: [x]A-> centos-helios:192.168.19.1 [x]B-> centos-hestia:192.168.19 ...

- Zookeeper+Kafka集群部署(转)

Zookeeper+Kafka集群部署 主机规划: 10.200.3.85 Kafka+ZooKeeper 10.200.3.86 Kafka+ZooKeeper 10.200.3.87 Kaf ...

- Zookeeper+Kafka集群部署

Zookeeper+Kafka集群部署 主机规划: 10.200.3.85 Kafka+ZooKeeper 10.200.3.86 Kafka+ZooKeeper 10.200.3.87 Kaf ...

- zookeeper+kafka集群安装之二

zookeeper+kafka集群安装之二 此为上一篇文章的续篇, kafka安装需要依赖zookeeper, 本文与上一篇文章都是真正分布式安装配置, 可以直接用于生产环境. zookeeper安装 ...

- 搭建zookeeper+kafka集群

搭建zookeeper+kafka集群 一.环境及准备 集群环境: 软件版本: 部署前操作: 关闭防火墙,关闭selinux(生产环境按需关闭或打开) 同步服务器时间,选择公网ntpd服务器或 ...

- Docker 部署 RocketMQ Dledger 集群模式( 版本v4.7.0)

文章转载自:http://www.mydlq.club/article/97/ 系统环境: 系统版本:CentOS 7.8 RocketMQ 版本:4.7.0 Docker 版本:19.03.13 一 ...

- zookeeper+kafka集群安装之一

zookeeper+kafka集群安装之一 准备3台虚拟机, 系统是RHEL64服务版. 1) 每台机器配置如下: $ cat /etc/hosts ... # zookeeper hostnames ...

随机推荐

- 禁用wps的云文档,恢复到清爽的状态

wps安装完成后,默认会开启云文档功能,每次打开表格.文档都会显示乱七八糟的一些东西,很麻烦 不得已只好手动为wps“瘦身”: 在wps表格或者文档的快捷方式上右键,选择打开文件所在位置 找到一个最新 ...

- 1925: [Sdoi2010]地精部落

1925: [Sdoi2010]地精部落 Time Limit: 10 Sec Memory Limit: 64 MB Submit: 1929 Solved: 1227 [Submit][Statu ...

- 搭建高可用mysql系列(2)-- Percona XtraDB Cluster 安装

本文主要介绍在 centos 下 Percona XtraDB Cluster(下文简称PXC) 的安装, 个人的系统版本信息如下: [root@c2-d09 worker]# more /etc/r ...

- h5py

解决办法: sudo apt-get install libhdf5-dev sudo apt-get install python-h5py

- sudo: java: command not found

背景:搭建了jumpserver,给开发划分了所有权限,但是开发那边账户不能执行java命令 报错:sudo: java: command not found 解决方法: 在用户管理权限配置sudoe ...

- Spring源码分析(二十)准备环境

摘要: 本文结合<Spring源码深度解析>来分析Spring 5.0.6版本的源代码.若有描述错误之处,欢迎指正. prepareRefresh函数主要是做些准备工作,例如对系统属性及环 ...

- 1347: Last Digit (周期函数)

1347: Last Digit Submit Page Summary Time Limit: 1 Sec Memory Limit: 128 Mb Submitted: ...

- POJ 3468 A Simple Problem with Integers(线段树模板之区间增减更新 区间求和查询)

A Simple Problem with Integers Time Limit: 5000MS Memory Limit: 131072K Total Submissions: 140120 ...

- BAT面试总结——iOS开发高级工程师

序言 之前也面试别人,现在轮到自己找工作,怎么说呢,现在轮到自己出去面试,怎么说呢,其实还是挺紧张的,原以为自己不会因此紧张或者焦虑,实际上,还是有的,在没找到合适的工作的时候,甚至晚上有点睡不着觉, ...

- Math(初学)

package day01; public class Case12 { public static void main(String[] args) { System.out.println(Mat ...