强化学习算法Policy Gradient

1 算法的优缺点

1.1 优点

在DQN算法中,神经网络输出的是动作的q值,这对于一个agent拥有少数的离散的动作还是可以的。但是如果某个agent的动作是连续的,这无疑对DQN算法是一个巨大的挑战,为了解决这个问题,前辈们将基于值的方法改成了基于策略的方法,即输出动作的概率。

1.2 缺点

策略梯度算法应用未来损失的return作为更新迭代的依据,即在一个回合过后,在这一回合中,若执行的某一动作的动作价值R大,则会加在下一回合选择这一动作的概率,反之,若执行的某一动作的动作价值R小,则会在下一回合选择这一动作的概率减小。因此,要想用return做为预测动作概率的神经网络更新的依据,就必须先拥有一个决策链,才能将return计算出来,因此每一个更新是在一个回合结束后才能更新一个。更新的速率比较慢

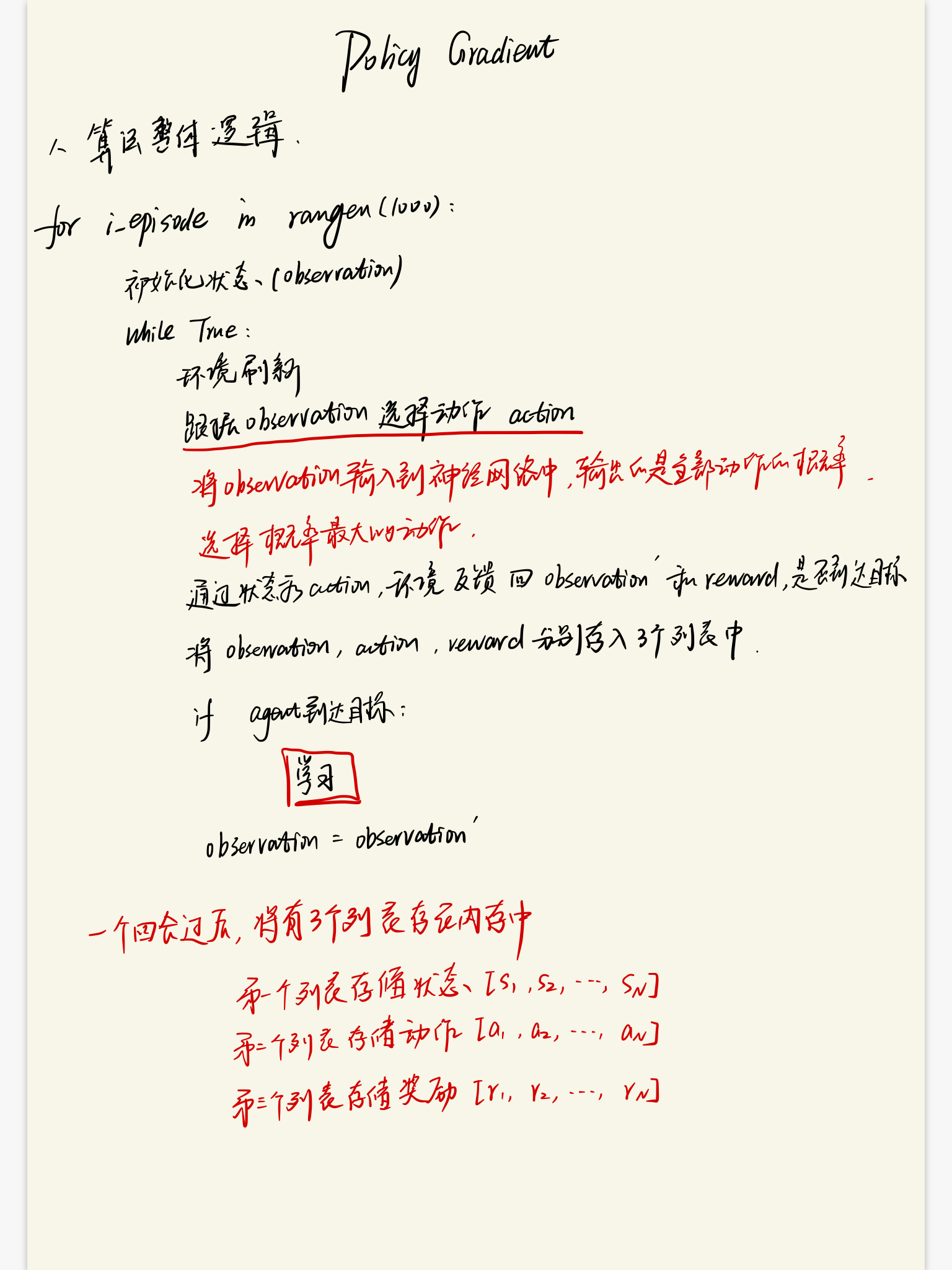

2 算法的流程

2.1 算法的整体逻辑

2.2 算法的更新逻辑

强化学习算法Policy Gradient的更多相关文章

- 深度学习-深度强化学习(DRL)-Policy Gradient与PPO笔记

Policy Gradient 初始学习李宏毅讲的强化学习,听台湾的口音真是费了九牛二虎之力,后来看到有热心博客整理的很细致,于是转载来看,当作笔记留待复习用,原文链接在文末.看完笔记再去听一听李宏毅 ...

- 强化学习七 - Policy Gradient Methods

一.前言 之前我们讨论的所有问题都是先学习action value,再根据action value 来选择action(无论是根据greedy policy选择使得action value 最大的ac ...

- 深度学习课程笔记(十四)深度强化学习 --- Proximal Policy Optimization (PPO)

深度学习课程笔记(十四)深度强化学习 --- Proximal Policy Optimization (PPO) 2018-07-17 16:54:51 Reference: https://b ...

- 一文读懂 深度强化学习算法 A3C (Actor-Critic Algorithm)

一文读懂 深度强化学习算法 A3C (Actor-Critic Algorithm) 2017-12-25 16:29:19 对于 A3C 算法感觉自己总是一知半解,现将其梳理一下,记录在此,也 ...

- 强化学习算法DQN

1 DQN的引入 由于q_learning算法是一直更新一张q_table,在场景复杂的情况下,q_table就会大到内存处理的极限,而且在当时深度学习的火热,有人就会想到能不能将从深度学习中借鉴方法 ...

- 基于Keras的OpenAI-gym强化学习的车杆/FlappyBird游戏

强化学习 课程:Q-Learning强化学习(李宏毅).深度强化学习 强化学习是一种允许你创造能从环境中交互学习的AI Agent的机器学习算法,其通过试错来学习.如上图所示,大脑代表AI Agent ...

- 告别炼丹,Google Brain提出强化学习助力Neural Architecture Search | ICLR2017

论文为Google Brain在16年推出的使用强化学习的Neural Architecture Search方法,该方法能够针对数据集搜索构建特定的网络,但需要800卡训练一个月时间.虽然论文的思路 ...

- 强化学习(十三) 策略梯度(Policy Gradient)

在前面讲到的DQN系列强化学习算法中,我们主要对价值函数进行了近似表示,基于价值来学习.这种Value Based强化学习方法在很多领域都得到比较好的应用,但是Value Based强化学习方法也有很 ...

- 强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods)

强化学习读书笔记 - 13 - 策略梯度方法(Policy Gradient Methods) 学习笔记: Reinforcement Learning: An Introduction, Richa ...

随机推荐

- 一起学习Boost标准库--Boost.StringAlgorithms库

概述 在未使用Boost库时,使用STL的std::string处理一些字符串时,总是不顺手,特别是当用了C#/Python等语言后trim/split总要封装一个方法来处理.如果没有形成自己的com ...

- C++设计模式 ==> 装饰(者)模式

简介 装饰模式指的是在不必改变原类文件和使用继承的情况下,动态地扩展一个对象的功能.它是通过创建一个包装对象,也就是装饰来包裹真实的对象.装饰模式使用对象嵌套的思想,实现对一个对象动态地进行选择性的属 ...

- Javaweb学习(三):Servlet程序

好了,既然开发环境已经配置好了.那么我们首先要搞定得便是servlet了,至于为什么不先去研究jsp,这是因为jsp与servlet本就是一体两面,jsp其本身经过编译.载入.转化等步骤最终会成为se ...

- 题解 P1550 【[USACO08OCT]打井Watering Hole】

题面(翻译有点问题,最后一句话) 农民John 决定将水引入到他的n(1<=n<=300)个牧场.他准备通过挖若 干井,并在各块田中修筑水道来连通各块田地以供水.在第i 号田中挖一口井需要 ...

- XtraEditors四、TextEdit、ButtonEdit、PictureEdit、RadioGroup、PopupContainerEdit

TextEdit控件 以文本框的形式绑定各种形式的选择框: 文本框设置 输入 密码 字符 时, 要有 * 号掩盖输入的字符, 代码如下: textEdit1.Properties.PasswordCh ...

- 【Alpha 冲刺】 1/12

1. 任务明细及任务量 Alpha版本任务安排(非固化版本,视情况调整,若有遗漏,及时补充) 职务 姓名 预期负责的模块页面 模块页面/任务明细 难度系数(0~1)(根据UI/功能实现难度划分) 预计 ...

- jmeter接口测试4-使用数据库mysql构造参数

jmeter测试中,测试数据一般和测试用例分离 测试数据一般可以使用csv构造,进行参数化 但也可以使用mysql等数据库构造 方案一:一个线程循环调用mysql数据,不是并发,不适用于性能测试,更适 ...

- 装饰器 python 你也可以叫语法糖

1.最简单的装饰器不带入参 def func(): pass def decorate(func) def wrapper(): return func() return wrapper 使用 @ ...

- HDU 3342 Legal or Not(有向图判环 拓扑排序)

Legal or Not Time Limit: 2000/1000 MS (Java/Others) Memory Limit: 32768/32768 K (Java/Others)Tota ...

- kafka 部署

Windows平台kafka环境的搭建 https://blog.csdn.net/u010054969/article/details/70241478