02.Scrapy-Demo

Scrapy入门实战

采集目标:采集西祠网的IP代理 包括 IP PORT

1. 新建项目

scrapy startproject xicidailiSpider

# scrapy 新建项目 项目名

2. 创建爬虫

scrapy genspider xicidaili xicidaili.com

# scrapy 产生爬虫 爬虫名字 网站域名

# 注意:爬虫名字一定不能与项目名字一致!

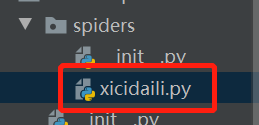

可以看到,在项目的spiders下得到了一个爬虫文件

解释爬虫文件

import scrapy # 导入scrapy

# 创建爬虫类 并且继承自scrapy.Spider --> 爬虫最基础的类

# 另外几个类都是继承自这个类

class XicidailiSpider(scrapy.Spider):

#爬虫名字 --> 必须唯一

name = 'xicidaili'

# 允许采集的域名

allowed_domains = ['xicidaili.com']

# 开始采集的网站

start_urls = ['http://xicidaili.com/']

# 解析响应数据 提取数据 或者网址等 response就是网页源码

def parse(self, response):

pass

3. 分析网址

提取数据

- 正则表达式(基础 必回 难掌握)

- XPath --> 从HTML中国提取数据语法

- CSS --> 从HTML中国提取数据语法

response.xpath("xpath语法").get()

get() 是得到一个元素

getall() 是多个元素

class XicidailiSpider(scrapy.Spider):

name = 'xicidaili'

allowed_domains = ['xicidaili.com']

start_urls = ['https://www.xicidaili.com/nn/']

# start_urls = [f'https://www.xicidaili.com/nn/{page}' for page in range(1,3685)] def parse(self, response):

# 提取数据

# response.xpath("//tr/td[2]/text()")

selectors = response.xpath("//tr")

for selector in selectors:

ip = selector.xpath("./td[2]/text()").get() # . 在当前节点下继续选择

port = selector.xpath("./td[3]/text()").get() # ip = selector.xpath("./td[2]/text()").extract_first() # 与get等价

# port = selector.xpath("./td[3]/text()").extract_first()

print(ip,port)

4. 运行爬虫

scrapy crawl 爬虫名字

# 翻页操作

next_page = response.xpath('//a[@class="next_page"]/@href').get()

if next_page:

print(next_page)

# 拼接网址

next_url = response.urljoin(next_page)

yield scrapy.Request(next_url,callback=self.parse) # yield 生成器

# Request() 发送请求 类似requests.get()

# callback 是回调函数 将发出去的请求得到的响应还交给自己(self.parse)处理

# 注意:回调函数不要写() 只写方法名字

02.Scrapy-Demo的更多相关文章

- c#&.NET3.0高级程序设计-02 Enum Demo

Enum 实例 using System; using System.Collections.Generic; public class MyClass { enum EmpType ...

- scrapy爬取58同城二手房问题与对策

测试环境: win10,单机爬取,scrapy1.5.0,python3.6.4,mongodb,Robo 3T 其他准备: 代理池:测试环境就没有用搭建的flask抓代理,因为我找到的几个免费网站有 ...

- 爬虫——scrapy框架

Scrapy是一个异步处理框架,是纯Python实现的爬虫框架,其架构清晰,模块之间的耦合程度低,可拓展性强,可以灵活完成各种需求.我们只需要定制几个模块就可以轻松实现一个爬虫. 1.架构 Scra ...

- 05 爬虫之scrapy

一 scrapy框架简介 01 什么是scrapy: Scrapy是一个为了爬取网站数据,提取结构性数据而编写的应用框架,非常出名,非常强悍.所谓的框架就是一个已经被集成了各种功能(高性能异步下载,队 ...

- py库: scrapy (深坑未填)

scrapy 一个快速高级的屏幕爬取及网页采集框架 http://scrapy.org/ 官网 https://docs.scrapy.org/en/latest/ Scrapy1.4文档 http: ...

- 萌新学习Python爬取B站弹幕+R语言分词demo说明

代码地址如下:http://www.demodashi.com/demo/11578.html 一.写在前面 之前在简书首页看到了Python爬虫的介绍,于是就想着爬取B站弹幕并绘制词云,因此有了这样 ...

- Scrapy 概览笔记

本项目代码可参考 imzhizi/myspider: a scrapy demo with elasticsearch 虚拟环境的创建 建议爬虫项目都创建虚拟环境 虚拟环境在 Python 项目中真的 ...

- Python Scrapy 实战

Python Scrapy 什么是爬虫? 网络爬虫(英语:web crawler),也叫网络蜘蛛(spider),是一种用来自动浏览万维网的网络机器人.其目的一般为编纂网络索引. Python 爬虫 ...

- Scrapy--1安装和运行

1.Scrapy安装问题 一开始是按照官方文档上直接用pip安装的,创建项目的时候并没有报错, 然而在运行 scrapy crawl dmoz 的时候错误百粗/(ㄒoㄒ)/~~比如: ImportEr ...

- python3高级编程

1. SMTP发送邮件 internet相关协议: http:网页访问相关,httplib,urllib,xmlrpclib ftp:文件传输相关, ftplib, urllib nntp:新闻和帖子 ...

随机推荐

- 01Java核心-冷门知识001-包

1)导入静态方法和静态域 import 可以加上static关键字,导入静态的方法和静态域. 例如: package com.gail.test; import static java.lang.Sy ...

- Nexus Repository Manager 3(CVE-2019-7238) 远程代码执行漏洞复现

0x00 漏洞背景 Nexus Repository Manager 3是一款软件仓库,可以用来存储和分发Maven,NuGET等软件源仓库.其3.14.0及之前版本中,存在一处基于OrientDB自 ...

- Unity 游戏框架搭建 2019 (五十二~五十四) 什么是库?&第四章总结&第五章简介

在上一篇,我们对框架和架构进行了一点探讨.我们在这一篇再接着探讨. 什么是库呢? 来自同一位大神的解释: 库, 插到 既有 架构 中, 补充 特定 功能. 很形象,库就是搞这个的.我们的库最初存在的目 ...

- IC-二进制, 自然数, 有符号数

https://mp.weixin.qq.com/s/9rGs9yN-OvLvEclnDZr87Q 零. 概念和结论 1. 数:概念名,指代物体的多少,即物体的量的概念: 2. 值:概念属性,数的 ...

- Second Space could let suspect play two different roles easily

Have you guys heard about a pretty good feature called "Second Space"? Manufacturers like ...

- MyBatis特性详解

缓存简介 一般我们在系统中使用缓存技术是为了提升数据查询的效率.当我们从数据库中查询到一批数据后将其放入到混存中(简单理解就是一块内存区域),下次再查询相同数据的时候就直接从缓存中获取数据就行了. 这 ...

- (Java实现) 拦截导弹

1260:[例9.4]拦截导弹(Noip1999) 时间限制: 1000 ms 内存限制: 65536 KB 提交数: 4063 通过数: 1477 [题目描述] 某国为了防御敌国的导弹袭击,发展出一 ...

- (Java实现) 车站

题目描述 火车从始发站(称为第1站)开出,在始发站上车的人数为a,然后到达第2站,在第2站有人上.下车,但上.下车的人数相同,因此在第2站开出时(即在到达第3站之前)车上的人数保持为a人.从第3站起( ...

- Java实现 LeetCode_0038_CountandSay

package javaLeetCode.primary; import java.util.Scanner; public class CountandSay_38 { public static ...

- python json unicode utf-8处理总结

1.直接输出字典中文 在python中经常遇见直接print dict(字典),或者dict转json,但是没有给特定的参数,然后打印json字符串,输出的中文就成了unicode码的情况,如下: d ...