深度学习面试题03:改进版梯度下降法Adagrad、RMSprop、Momentum、Adam

目录

Adagrad法

RMSprop法

Momentum法

Adam法

参考资料

发展历史

标准梯度下降法的缺陷

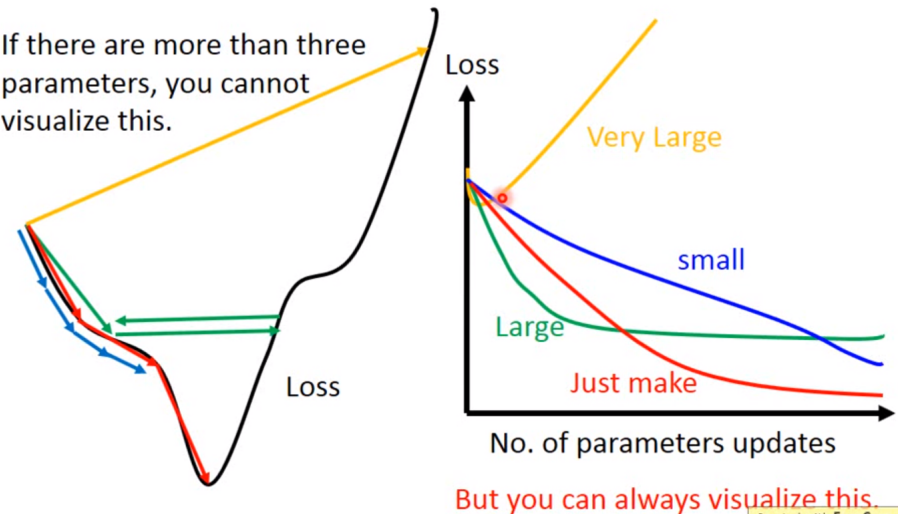

如果学习率选的不恰当会出现以上情况

因此有一些自动调学习率的方法。一般来说,随着迭代次数的增加,学习率应该越来越小,因为迭代次数增加后,得到的解应该比较靠近最优解,所以要缩小步长η,那么有什么公式吗?比如: ,但是这样做后,所有参数更新时仍都采用同一个学习率,即学习率不能适应所有的参数更新。

,但是这样做后,所有参数更新时仍都采用同一个学习率,即学习率不能适应所有的参数更新。

解决方案是:给不同的参数不同的学习率

|

Adagrad法 |

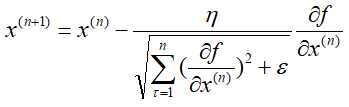

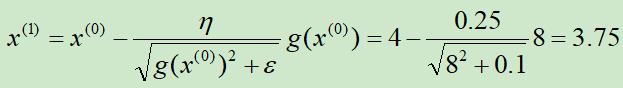

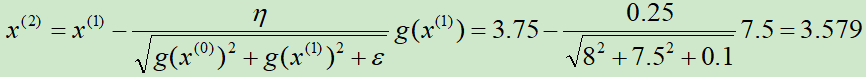

假设N元函数f(x),针对一个自变量研究Adagrad梯度下降的迭代过程,

可以看出,Adagrad算法中有自适应调整梯度的意味(adaptive gradient),学习率需要除以一个东西,这个东西就是前n次迭代过程中偏导数的平方和再加一个常量最后开根号。

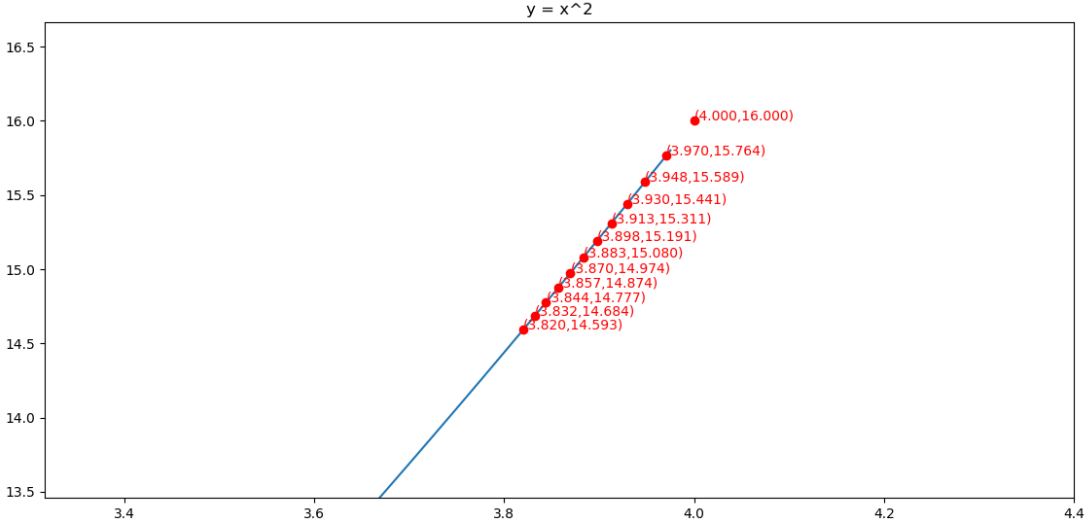

举例:使用Adagrad算法求y = x2的最小值点

导函数为g(x) = 2x

初始化x(0) = 4,学习率η=0.25,ε=0.1

第①次迭代:

第②次迭代:

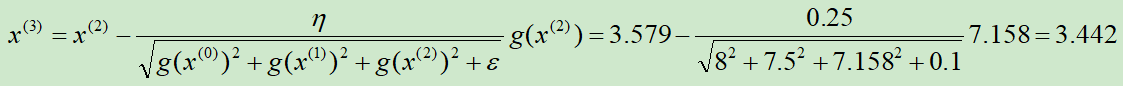

第③次迭代:

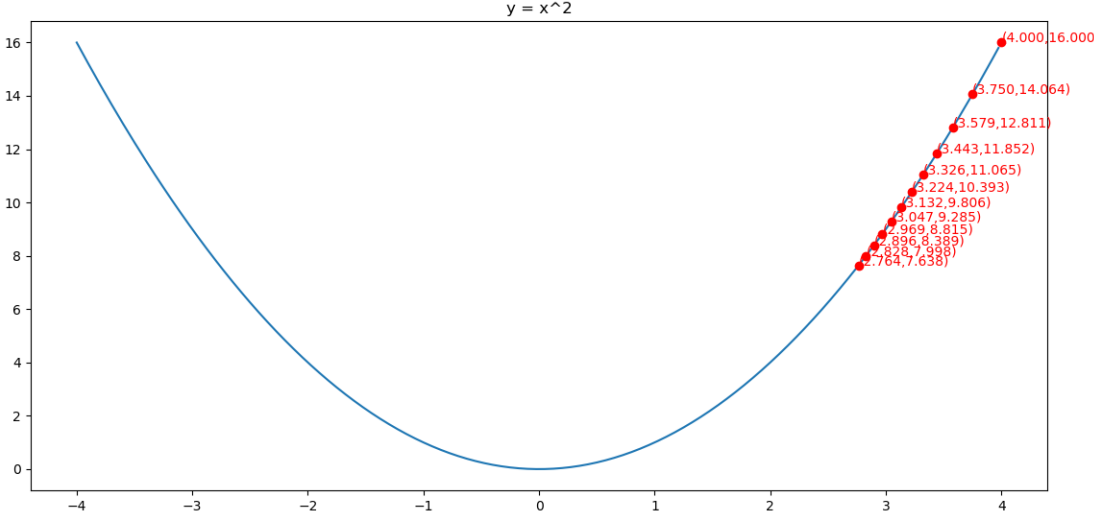

求解的过程如下图所示

对应代码为:

缺点:由于分母是累加梯度的平方,到后面累加的比较大时,会导致梯度更新缓慢

|

RMSprop法 |

AdaGrad算法在迭代后期由于学习率过小,可能较难找到一个有用的解。为了解决这一问题,RMSprop算法对Adagrad算法做了一点小小的修改,RMSprop使用指数衰减只保留过去给定窗口大小的梯度,使其能够在找到凸碗状结构后快速收敛。

假设N元函数f(x),针对一个自变量研究RMSprop梯度下降的迭代过程,

可以看出分母不再是一味的增加,它会重点考虑距离他较近的梯度(指数衰减的效果),也就不会出现Adagrad到后期收敛缓慢的问题

举例:使用RMSprop算法求y = x2的最小值点

导函数为h(x) = 2x

初始化g(0) = 1,x(0) = 4,ρ=0.9,η=0.01,ε=10-10

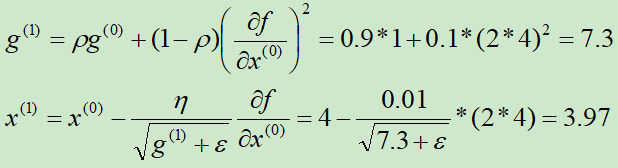

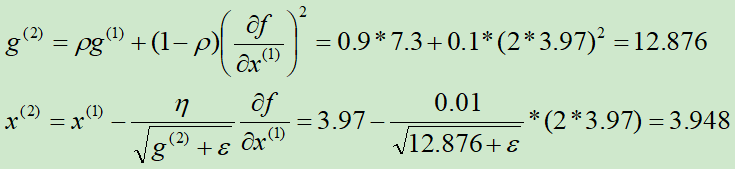

第①次迭代:

第②次迭代:

求解的过程如下图所示

对应代码为:

|

Momentum法 |

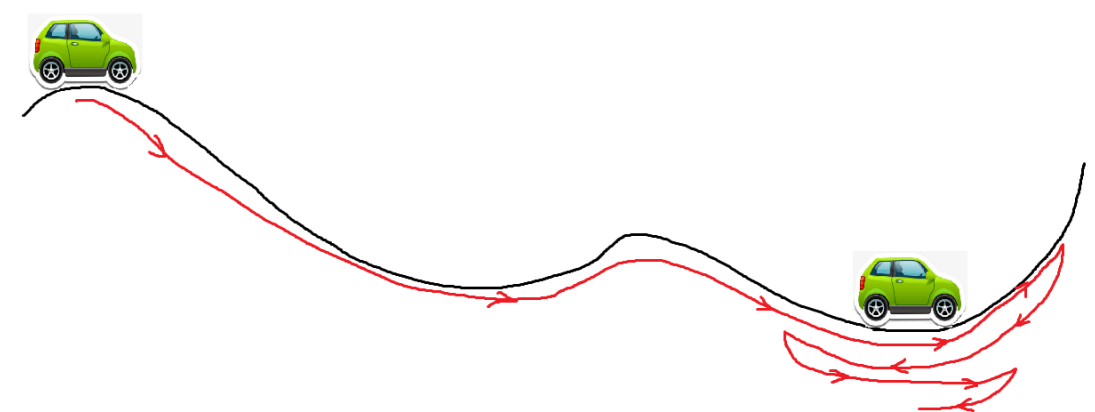

Momentum是动量的意思,想象一下,一个小车从高坡上冲下来,他不会停在最低点,因为他还有一个动量,还会向前冲,甚至可以冲过一些小的山丘,如果面对的是较大的坡,他可能爬不上去,最终又会倒车回来,折叠几次,停在谷底。

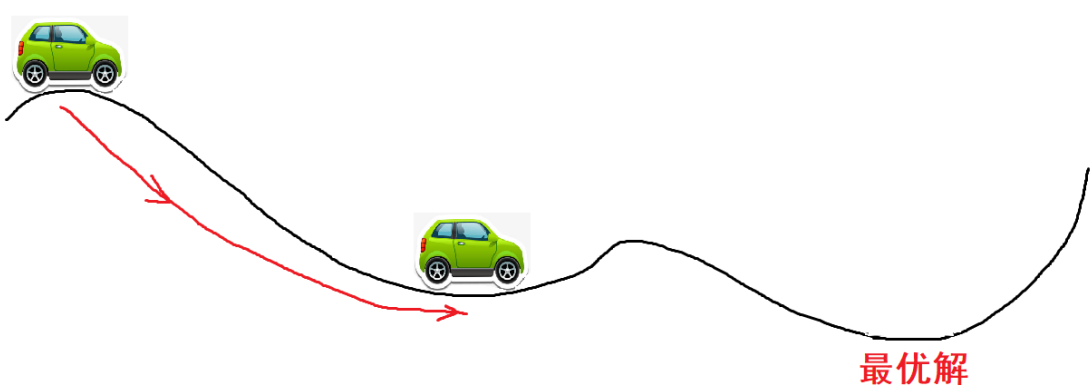

如果使用的是没有动量的梯度下降法,则可能会停到第一个次优解

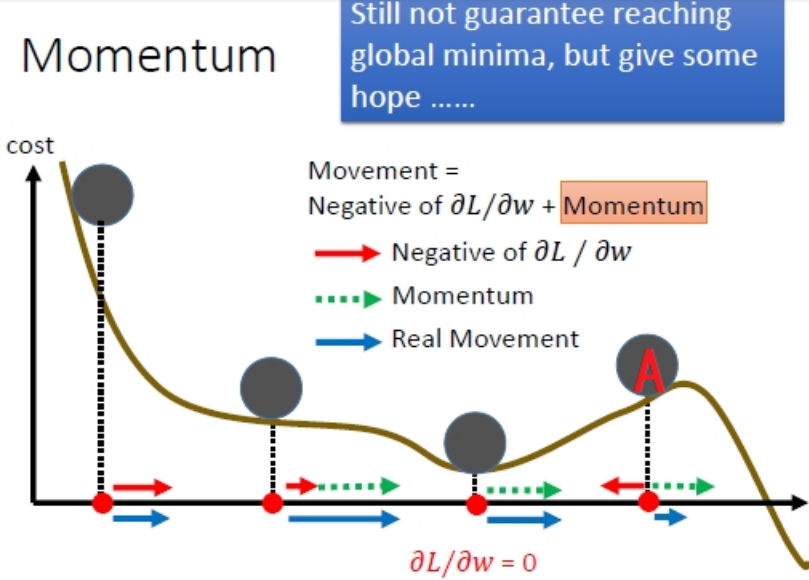

最直观的理解就是,若当前的梯度方向与累积的历史梯度方向一致,则当前的梯度会被加强,从而这一步下降的幅度更大。若当前的梯度方向与累积的梯度方向不一致,则会减弱当前下降的梯度幅度。

从这幅图可以看出来,当小球到达A点处,负梯度方向的红箭头朝着x轴负向,但是动量方向(绿箭头)朝着x轴的正向并且长度大于红箭头,因此小球在A处还会朝着x轴正向移动。

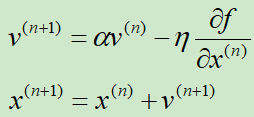

下面正式介绍Momentum法

假设N元函数f(x),针对一个自变量研究Momentum梯度下降的迭代过程,

v表示动量,初始v=0

α是一个接近于1的数,一般设置为0.9,也就是把之前的动量缩减到0.9倍

η是学习率

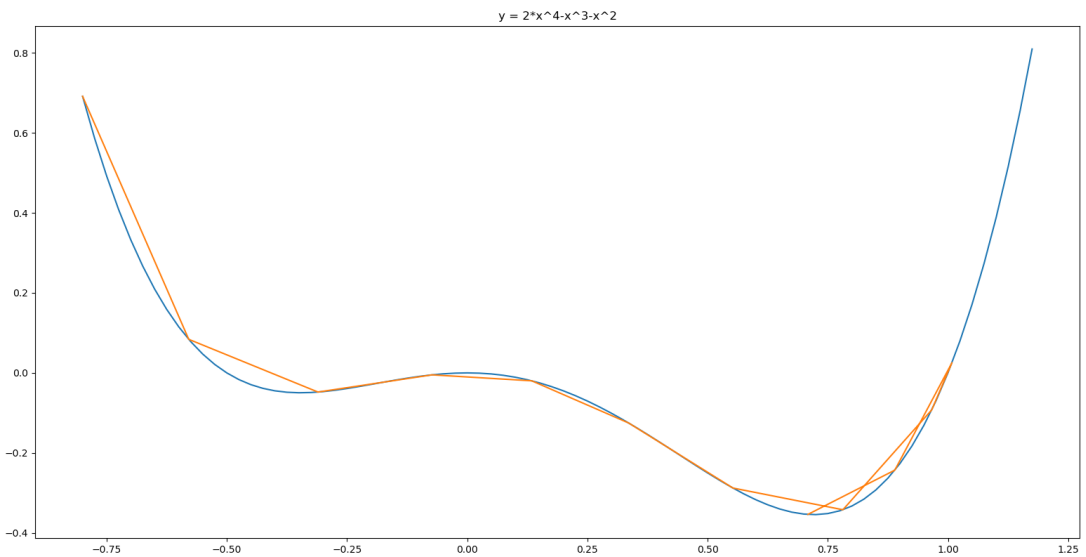

下面通过一个例子演示一下,求y = 2*x^4-x^3-x^2的极小值点

可以看出从-0.8开始迭代,依靠动量成功越过第一个次优解,发现无法越过最优解,折叠回来,最终收敛到最优解。对应代码如下

|

Adam法 |

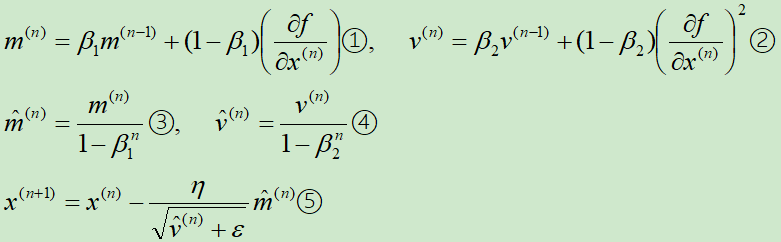

Adam实际上是把momentum和RMSprop结合起来的一种算法

假设N元函数f(x),针对一个自变量研究Adam梯度下降的迭代过程,

下面依次解释这五个式子:

在①式中,注意m(n)是反向的动量与梯度的和(而在Momentum中是正向动量与负梯度的和,因此⑤式对应的是减号)

在②式中,借鉴的是RMSprop的指数衰减

③和④式目的是纠正偏差

⑤式进行梯度更新

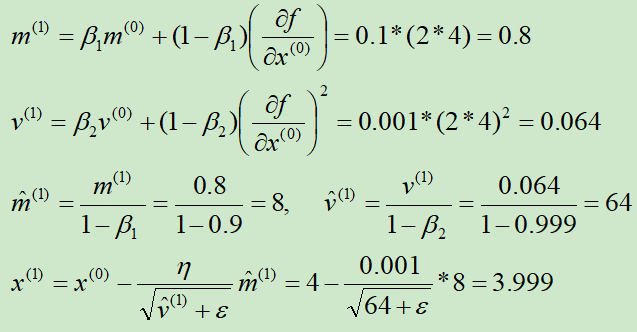

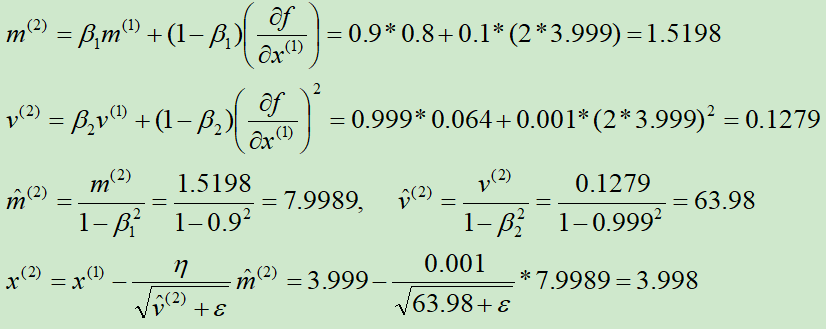

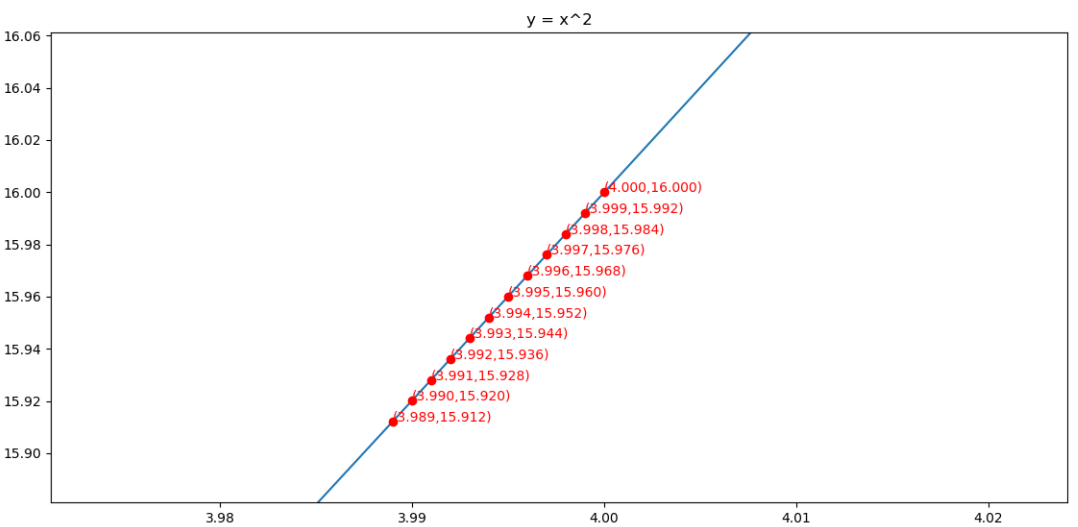

举例:使用Adagrad算法求y = x2的最小值点

导函数为h(x) = 2x

初始化x(0) = 4,m(0) = 0,v(0) = 0,β1=0.9,β2=0.999,ε=10-8,η = 0.001

第①次迭代:

第②次迭代:

求解的过程如下图所示

对应代码为:

|

参考资料 |

李宏毅——一天搞懂深度学习

深度学习中优化方法——momentum、Nesterov Momentum、AdaGrad、Adadelta、RMSprop、Adam

https://blog.csdn.net/u012328159/article/details/80311892

《图解深度学习与神经网络:从张量到TensorFlow实现》_张平

深度学习面试题03:改进版梯度下降法Adagrad、RMSprop、Momentum、Adam的更多相关文章

- ubuntu之路——day8.1 深度学习优化算法之mini-batch梯度下降法

所谓Mini-batch梯度下降法就是划分训练集和测试集为等分的数个子集,比如原来有500W个样本,将其划分为5000个baby batch,每个子集中有1000个样本,然后每次对一个mini-bat ...

- 深度学习面试题29:GoogLeNet(Inception V3)

目录 使用非对称卷积分解大filters 重新设计pooling层 辅助构造器 使用标签平滑 参考资料 在<深度学习面试题20:GoogLeNet(Inception V1)>和<深 ...

- 深度学习面试题27:非对称卷积(Asymmetric Convolutions)

目录 产生背景 举例 参考资料 产生背景 之前在深度学习面试题16:小卷积核级联卷积VS大卷积核卷积中介绍过小卷积核的三个优势: ①整合了三个非线性激活层,代替单一非线性激活层,增加了判别能力. ②减 ...

- 深度学习面试题13:AlexNet(1000类图像分类)

目录 网络结构 两大创新点 参考资料 第一个典型的CNN是LeNet5网络结构,但是第一个引起大家注意的网络却是AlexNet,Alex Krizhevsky其实是Hinton的学生,这个团队领导者是 ...

- [源码解析] 深度学习流水线并行GPipe (2) ----- 梯度累积

[源码解析] 深度学习流水线并行GPipe (2) ----- 梯度累积 目录 [源码解析] 深度学习流水线并行GPipe (2) ----- 梯度累积 0x00 摘要 0x01 概述 1.1 前文回 ...

- 深度学习笔记之【随机梯度下降(SGD)】

随机梯度下降 几乎所有的深度学习算法都用到了一个非常重要的算法:随机梯度下降(stochastic gradient descent,SGD) 随机梯度下降是梯度下降算法的一个扩展 机器学习中一个反复 ...

- 深度学习面试题21:批量归一化(Batch Normalization,BN)

目录 BN的由来 BN的作用 BN的操作阶段 BN的操作流程 BN可以防止梯度消失吗 为什么归一化后还要放缩和平移 BN在GoogLeNet中的应用 参考资料 BN的由来 BN是由Google于201 ...

- 深度学习面试题20:GoogLeNet(Inception V1)

目录 简介 网络结构 对应代码 网络说明 参考资料 简介 2014年,GoogLeNet和VGG是当年ImageNet挑战赛(ILSVRC14)的双雄,GoogLeNet获得了第一名.VGG获得了第二 ...

- 深度学习面试题05:激活函数sigmod、tanh、ReLU、LeakyRelu、Relu6

目录 为什么要用激活函数 sigmod tanh ReLU LeakyReLU ReLU6 参考资料 为什么要用激活函数 在神经网络中,如果不对上一层结点的输出做非线性转换的话,再深的网络也是线性模型 ...

随机推荐

- 【亲测可行,图片宽度高度自适应】c# Graphics MeasureString精确测量字体宽度

, , ) { int count = number.Length; //需要配置的字段 //Font f = new Font("Microsoft Sans Serif", f ...

- 利用.bat脚本使得可运行jar开机自动运行

1.利用Elipse到处可运行的jar包 2.写.bat脚本[点此下载],相应目录自己根据需要修改即可 3.将此脚本放在"启动"文件夹中

- springboot学习入门简易版八---springboot2.0多环境配置、整合mybatis mysql8+(19-20)

2.11 SpringBoot多环境配置(19) application.properties中配置 Spring.profiles.active=prd 配置环境: Application-dev ...

- Jenkins配置Publish Over SSH讲解说明

原创 Jenkins配置Publish Over SSH讲解说明 2018-08-22 11:59:30 M.Blog 阅读数 3764更多 分类专栏: Jenkins 版权声明:本文为博主原创文 ...

- phpmyadmin教程

phpmyadmin教程 管理页进入phpmyadmin 打开C:\wamp\apps\phpmyadmin3.5.1下的配置文件:config.inc 修改密码创建与修改数据库.数据表 字段类型 I ...

- Linux磁盘管理——日志文件系统与数据一致性

参考:Linux磁盘管理——Ext2文件系统 数据不一致 上图是Ext2结构图,其他FS结构类似. 一般来说,我们将 inode table 与 data block 称为数据区:至于其他例如 sup ...

- P1072 Hankson 的趣味题[数论]

题目描述 Hanks 博士是 BT(Bio-Tech,生物技术) 领域的知名专家,他的儿子名叫 Hankson.现在,刚刚放学回家的 Hankson 正在思考一个有趣的问题. 今天在课堂上,老师讲解了 ...

- 大数据之路week07--day06 (Sqoop 的使用)

Sqoop的使用一(将数据库中的表数据上传到HDFS) 首先我们先准备数据 1.没有主键的数据(下面介绍有主键和没有主键的使用区别) -- MySQL dump 10.13 Distrib 5.1.7 ...

- 《少年先疯队》第八次团队作业:Alpha冲刺1-5

博文简要信息表: 项目 内容 软件工程 https://www.cnblogs.com/nwnu-daizh/ 本次实验链接地址 https://www.cnblogs.com/nwnu-daizh/ ...

- robot framework 笔记(一)

背景: 平时使用rf时会用到一些方法,长时间不用就会忘记,本文用来记录当做自己的小笔记 内容持续更新中········ 一.robot framework 大小写转换 1.转换小写: ${low} E ...