elk之logstash

环境:

centos7

jdk8

1.创建Logstash源

rpm --import https://artifacts.elastic.co/GPG-KEY-elasticsearch

touch /etc/yum.repos.d/logstash.repo

vi /etc/yum.repos.d/logstash.repo

[logstash-.x]

name=Elasticsearch repository for .x packages

baseurl=https://artifacts.elastic.co/packages/5.x/yum

gpgcheck=

gpgkey=https://artifacts.elastic.co/GPG-KEY-elasticsearch

enabled=

autorefresh=

type=rpm-md

2.使用yum安装logstash

yum makecache

yum install logstash -y

3.利用 log4j 搜集日志

a.pom.xml 引入

<dependency>

<groupId>log4j</groupId>

<artifactId>log4j</artifactId>

<version>1.2.</version>

<scope>provided</scope>

</dependency>

b.log4j.properties添加

log4j.rootLogger = debug, socket

log4j.appender.socket=org.apache.log4j.net.SocketAppender

log4j.appender.socket.Port=

log4j.appender.socket.RemoteHost=192.168.158.128

log4j.appender.socket.layout = org.apache.log4j.PatternLayout

log4j.appender.socket.layout.ConversionPattern = %d [%t] %-5p %c - %m%n

c.在logstash服务器上添加配置 log4j-to-es.conf

output 是输出到elasticsearch,可翻阅前面的文章 elk之elasticsearch安装

input {log4j {type => "log4j-json" port => }}

output {

elasticsearch {

action => "index"

hosts => "192.168.158.128:9200"

index => "applog"

}

}

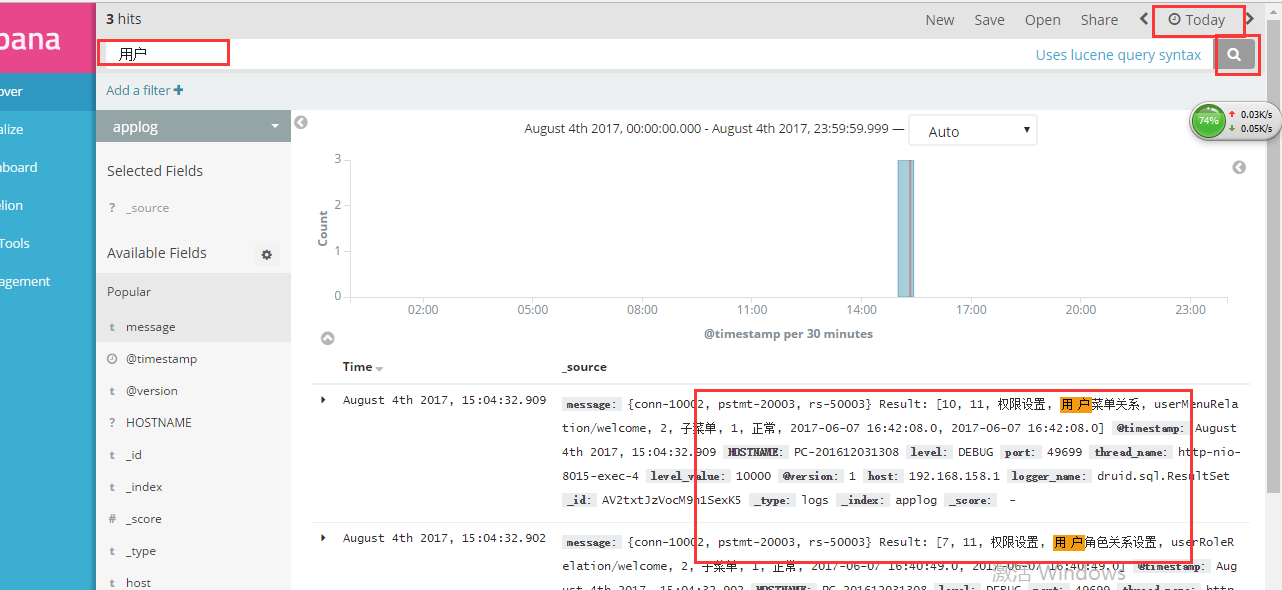

然后重启 logstash ,打开kibana 指定 index or pattern 为我们这里配置的 applog,设置搜索时间就可以查看到日志了

4.利用logback 搜集日志

a.pom.xml 引入

<dependency>

<groupId>net.logstash.logback</groupId>

<artifactId>logstash-logback-encoder</artifactId>

<version>4.6</version>

</dependency>

b.配置logback.xml,添加appender

<?xml version="1.0" encoding="UTF-8"?>

<configuration>

<!-- 文件输出格式 -->

<property name="PATTERN"

value="%d{yyyy-MM-dd HH:mm:ss.SSS} [%t] %-5level %logger{50} - %msg%n" />

<!-- test文件路径 -->

<property name="LOG_HOME" value="C:/Users/Administrator/Desktop/logs" /> <!-- 控制台输出 -->

<appender name="STDOUT" class="ch.qos.logback.core.ConsoleAppender">

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符 -->

<pattern>${PATTERN}</pattern>

</encoder>

</appender> <!-- logstash 收集日志 -->

<appender name="stash" class="net.logstash.logback.appender.LogstashTcpSocketAppender">

<destination>192.168.158.128:</destination>

<encoder charset="UTF-8" class="net.logstash.logback.encoder.LogstashEncoder" />

</appender> <!-- 按照每天生成日志文件 -->

<appender name="FILE"

class="ch.qos.logback.core.rolling.RollingFileAppender">

<rollingPolicy class="ch.qos.logback.core.rolling.TimeBasedRollingPolicy">

<!--日志文件输出的文件名 -->

<FileNamePattern>${LOG_HOME}/yun.%d{yyyyMMdd}.log

</FileNamePattern>

<!--日志文件保留天数 -->

<!-- <MaxHistory></MaxHistory> -->

</rollingPolicy>

<encoder class="ch.qos.logback.classic.encoder.PatternLayoutEncoder">

<!--格式化输出:%d表示日期,%thread表示线程名,%-5level:级别从左显示5个字符宽度%msg:日志消息,%n是换行符 -->

<pattern>${PATTERN}</pattern>

</encoder>

<!--日志文件最大的大小 -->

<triggeringPolicy

class="ch.qos.logback.core.rolling.SizeBasedTriggeringPolicy">

<MaxFileSize>500MB</MaxFileSize>

</triggeringPolicy>

</appender> <logger name="org.springframework.web" level="DEBUG" additivity="false">

<appender-ref ref="STDOUT" />

</logger> <logger name="druid.sql" level="DEBUG" additivity="false">

<appender-ref ref="FILE" />

<appender-ref ref="STDOUT" />

<appender-ref ref="stash" />

</logger>

<logger name="com.yun" level="DEBUG" additivity="false">

<appender-ref ref="FILE" />

<appender-ref ref="STDOUT" />

<appender-ref ref="stash" />

</logger> <!-- 日志输出级别 -->

<root level="DEBUG">

<appender-ref ref="FILE" />

<appender-ref ref="STDOUT" />

<appender-ref ref="stash" />

</root>

</configuration>

c.logstash服务器上添加配置 logback-to-es.conf

input {tcp {port => codec => "json_lines"}}

output {

elasticsearch {

action => "index"

hosts => "192.168.158.128:9200"

index => "applog"

}

}

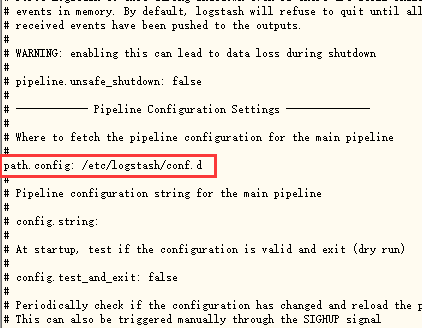

配置目录请认准 /etc/logstash/conf.d

可以打开 logstash.yml 查看 cat /etc/logstash/logstash.yml

d.重启logstash,启动项目产生日志,然后去kibana 查看日志

5.利用filebeat搜集日志

elk之logstash的更多相关文章

- 使用ELK(Elasticsearch + Logstash + Kibana) 搭建日志集中分析平台实践--转载

原文地址:https://wsgzao.github.io/post/elk/ 另外可以参考:https://www.digitalocean.com/community/tutorials/how- ...

- ELk(Elasticsearch, Logstash, Kibana)的安装配置

目录 ELk(Elasticsearch, Logstash, Kibana)的安装配置 1. Elasticsearch的安装-官网 2. Kibana的安装配置-官网 3. Logstash的安装 ...

- [转] ELK 之 Logstash

[From] https://blog.csdn.net/iguyue/article/details/77006201 ELK 之 Logstash 简介: ELK 之 LogstashLogsta ...

- CentOS 6.x ELK(Elasticsearch+Logstash+Kibana)

CentOS 6.x ELK(Elasticsearch+Logstash+Kibana) 前言 Elasticsearch + Logstash + Kibana(ELK)是一套开源的日志管理方案, ...

- 基于CentOS6.5或Ubuntu14.04下Suricata里搭配安装 ELK (elasticsearch, logstash, kibana)(图文详解)

前期博客 基于CentOS6.5下Suricata(一款高性能的网络IDS.IPS和网络安全监控引擎)的搭建(图文详解)(博主推荐) 基于Ubuntu14.04下Suricata(一款高性能的网络ID ...

- 键盘侠Linux干货| ELK(Elasticsearch + Logstash + Kibana) 搭建教程

前言 Elasticsearch + Logstash + Kibana(ELK)是一套开源的日志管理方案,分析网站的访问情况时我们一般会借助 Google / 百度 / CNZZ 等方式嵌入 JS ...

- 【转】ELK(ElasticSearch, Logstash, Kibana)搭建实时日志分析平台

[转自]https://my.oschina.net/itblog/blog/547250 摘要: 前段时间研究的Log4j+Kafka中,有人建议把Kafka收集到的日志存放于ES(ElasticS ...

- ELK——安装 logstash 2.2.0、elasticsearch 2.2.0 和 Kibana 3.0

本文内容 Elasticsearch logstash Kibana 参考资料 本文介绍安装 logstash 2.2.0 和 elasticsearch 2.2.0,操作系统环境版本是 CentOS ...

- CentOS 7.x安装ELK(Elasticsearch+Logstash+Kibana)

第一次听到ELK,是新浪的@ARGV 介绍内部使用ELK的情况和场景,当时触动很大,原来有那么方便的方式来收集日志和展现,有了这样的工具,你干完坏事,删除日志,就已经没啥作用了. 很多企业都表示出他们 ...

- ELK(ElasticSearch, Logstash, Log4j)系统日志搭建

1.elk平台介绍 Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等. Logsta ...

随机推荐

- 20171205xlVBA往返航班组合

'ClassPlan Public Org As String Public Des As String Public FlyNo As String Public StartDate As Vari ...

- Vue.js示例:文本编辑器。使用_.debounce()反抖动函数

Markdown编辑器 https://cn.vuejs.org/v2/examples/index.html 新知识: Underscore.js库 用于弥补标准库,方便了JavaScript的编程 ...

- centOS 6.5安装python和nginx

一.安装python3.5 1.安装python3.5

- python-部分redis

数据量非常大时想向数据库中保存的时候,可以在中间加一个队列(队列的长度可以控制),可能数据库一个个取会效率慢一些,但是不会服务端不会蹦 redis: 端口6379 1.本质:向内存中存数据 2.对内存 ...

- 使用antd-mobile的ImagePicker组件实现图片的上传

这篇文章主要是记录一下在开发钉钉微应用时,实现图片上传及显示功能的过程. 这个项目用的dingyou-dingtalk-mobile这个脚手架,可直接在NowaGui上创建.这是一个关于钉钉微应用的脚 ...

- python 常用代码

获取标签名 h1 class 是h1usersoup.find(name="h1", attrs={"class":"h1user"});获 ...

- 美团点评MySQL数据库高可用架构从MMM到MHA+Zebra以及MHA+Proxy的演进

本文介绍最近几年美团点评MySQL数据库高可用架构的演进过程,以及我们在开源技术基础上做的一些创新.同时,也和业界其它方案进行综合对比,了解业界在高可用方面的进展,和未来我们的一些规划和展望. MMM ...

- 十三、MVC的WEB框架(Structs2)

一.Structs2的应用 Structs2是基于MVC的WEB框架.一般基于框架的程序要运行成功,对于JAR包的版本,配置文件的正确性有着苛刻的要求,一个地方错了,都会导致框架程序运行出错. 1.首 ...

- MapReduce(一)

MapReduce(一) 一.介绍 百度百科: MapReduce是一种编程模型,用于大规模数据集(大于1TB)的并行运算.概念"Map(映射)"和"Reduce(归约) ...

- 使用Postman在Chrome下进行rest请求测试

1.首先下载postman,我已经下载好,放在云盘里了. http://pan.baidu.com/s/1c1YoGKS 密码 dgfw 2.打开Chrome,点击更多工具->扩展程序~打开. ...