Python 2.7_Second_try_爬取阳光电影网_获取电影下载地址并写入文件 20161207

1、昨天文章http://www.cnblogs.com/Mr-Cxy/p/6139705.html 是获取电影网站主菜单 然后获取每个菜单下的电影url

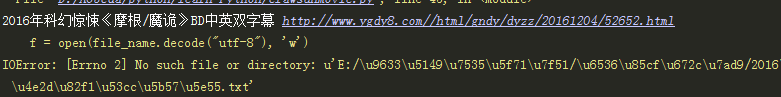

2、今天是对电影url 进行再次解析获取下载地址 并写入文件

4、python 代码

#coding:utf-8

import requests

from bs4 import BeautifulSoup as bs #爬取入口

rooturl="http://www.ygdy8.com/index.html"

#获取网页源码

res=requests.get(rooturl)

#网站编码gb2312

res.encoding='gb2312'

#网页源码

html=res.text

soup=bs(html,'html.parser')

cate_urls = []

for cateurl in soup.select('.contain ul li a'):

#网站分类标题

cate_name=cateurl.text.encode('utf-8')

#分类url 进行再次爬取

cate_url="http://www.ygdy8.com/"+ cateurl['href']

cate_urls.append(cate_url)

print "网站一级菜单:",cate_name,"菜单网址:",cate_url

# newdir = "E:/moive24/"+ cate_name

# os.makedirs(newdir.decode("utf-8"))

# print "创建分类目录成功------" + newdir

#每个菜单url 解析

for i in range(len(cate_urls)):

cate_listurl=cate_urls[i]

res = requests.get(cate_listurl)

res.encoding = 'gb2312'

html = res.text

soup = bs(html, 'html.parser')

print "正在解析第"+str(i+1)+"个链接",cate_urls[i]

contenturls=[]

contents=soup.select('.co_content8 ul')[0].select('a')

#print contents

for title in contents:

moivetitle=title.text.encode('utf-8')

moiveurl="http://www.ygdy8.com/"+ title['href']

contenturls.append(moiveurl)

print moivetitle,moiveurl

# file_name=newdir +'/'+ moivetitle +'.txt'

# print file_name

# f = open(file_name.decode("utf-8"), "wb")

# f.close()

res = requests.get(moiveurl)

res.encoding = 'gb2312'

html = res.text

soup = bs(html, 'html.parser')

moive_sources=soup.select('#Zoom span tbody tr td a')

for source in moive_sources:

moive_source=source['href']

#print moive_source

f=open('E:/moive24/moive.txt','a')

f.write(moive_source.encode("utf-8") + "\n")

f.close

Python 2.7_Second_try_爬取阳光电影网_获取电影下载地址并写入文件 20161207的更多相关文章

- 利用Python网络爬虫爬取学校官网十条标题

利用Python网络爬虫爬取学校官网十条标题 案例代码: # __author : "J" # date : 2018-03-06 # 导入需要用到的库文件 import urll ...

- Python 2.7_First_try_爬取阳光电影网_20161206

之前看过用Scrapy 框架建立项目爬取 网页解析时候用的Xpath进行解析的网页元素 这次尝试用select方法匹配元素 1.入口爬取页面 http://www.ygdy8.com/index.ht ...

- python实战项目 — 爬取中国票房网年度电影信息并保存在csv

import pandas as pd import requests from bs4 import BeautifulSoup import time def spider(url, header ...

- python爬虫:爬取易迅网价格信息,并写入Mysql数据库

本程序涉及以下方面知识: 1.python链接mysql数据库:http://www.cnblogs.com/miranda-tang/p/5523431.html 2.爬取中文网站以及各种乱码处 ...

- 用python爬虫简单爬取 笔趣网:类“起点网”的小说

首先:文章用到的解析库介绍 BeautifulSoup: Beautiful Soup提供一些简单的.python式的函数用来处理导航.搜索.修改分析树等功能. 它是一个工具箱,通过解析文档为用户提供 ...

- python实战项目 — 爬取 校花网图片

重点: 1. 指定路径创建文件夹,判断是否存在 2. 保存图片文件 # 获得校花网的地址,图片的链接 import re import requests import time import os ...

- Python爬取猪肉价格网并获取Json数据

场景 猪肉价格网站: http://zhujia.zhuwang.cc/ 注: 博客: https://blog.csdn.net/badao_liumang_qizhi 关注公众号 霸道的程序猿 获 ...

- python实战项目 — 爬取 妹子图网,保存图片到本地

重点: 1. 用def函数 2. 使用 os.path.dirname("路径保存") , 实现每组图片保存在独立的文件夹中 方法1: import requests from l ...

- Python的scrapy之爬取顶点小说网的所有小说

闲来无事用Python的scrapy框架练练手,爬取顶点小说网的所有小说的详细信息. 看一下网页的构造: tr标签里面的 td 使我们所要爬取的信息 下面是我们要爬取的二级页面 小说的简介信息: 下面 ...

随机推荐

- 解决CentOS6.4 Docker "Couldn't connect to Docker daemon ..." 问题

OS: CentOS6.4 #uname -r 2.6.32-504.1.3.el6.x86_64 安装完毕fig,并完成相应配置时执行如下命令出错(fig安装参见:http://www.fig.sh ...

- http_build_query()就是将一个数组转换成url 问号?后面的参数字符串,并且会自动进行urlencode处理,及它的逆向函数

http_build_query()就是将一个数组转换成url 问号?后面的参数字符串,并且会自动进行urlencode处理 例如: $data = array( 'foo'=>'bar', ' ...

- linux dns 连外网

以下设置对所用的Linux系统如Redhat/Ubuntu/Debian/CentOS等都有效,但您必须是管理员root或者具有管理员权限 vim /etc/resolv.conf 在其中加入: na ...

- Codeforces Round #378 (Div. 2) A B C D 施工中

A. Grasshopper And the String time limit per test 1 second memory limit per test 256 megabytes input ...

- 练习2:雨淋湿了一道题,9个数字只能看清楚4个,第一个肯定不是1 [X * (Y3 + Z)]^2 = 8MN9,求出各个数字

题目上的X代表的未知数,不一定是同一个数字. 其实这道题,直接一推敲答案就出来了,首先,积德尾数是9,说明 X*(Y3 + Z)的值尾数是3,3的因子只有1和3,所以X只有1和3候选,但是题目说第一个 ...

- Node.js知识点

1. 入口文件app.js里的路由,按顺序执行: 2.

- tkprof

http://blog.csdn.net/pan_tian/article/details/7677338 需要调整的语句符合以下几点: (1).CPU占用过多 (2).Parse,Execute,F ...

- Java 应用性能调优实践

Java 应用性能优化是一个老生常谈的话题,笔者根据个人经验,将 Java 性能优化分为 4 个层级:应用层.数据库层.框架层.JVM 层.通过介绍 Java 性能诊断工具和思路,给出搜狗商业平台的性 ...

- bootstrap-轮播图

<!-- 1.写一个父级,class为carousel slide:添加滑动的效果 data-interval 图片轮播间隔时间,单位ms data-ride="carousel&qu ...

- jspSmartUpload上传下载全攻略

http://blog.itpub.net/92037/viewspace-788900/