统计学习方法:罗杰斯特回归及Tensorflow入门

作者:桂。

时间:2017-04-21 21:11:23

链接:http://www.cnblogs.com/xingshansi/p/6743780.html

前言

看到最近大家都在用Tensorflow,一查才发现火的不行。想着入门看一看,Tensorflow使用手册第一篇是基于MNIST的手写数字识别的,用到softmax regression,而这个恰好与我正在看的《统计信号处理》相关。本文借此梳理一下:

1)罗杰斯特回归

2)Softmax Regression

3)基于Tensorflow的MNIST手写数字识别框架

内容为自己的学习记录,其中多有借鉴他人的地方,最后一并给出链接。

一、罗杰斯特回归(Logistic Regression)

A-问题描述

一般说的Logistic回归,是指二分类问题。

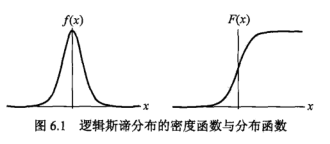

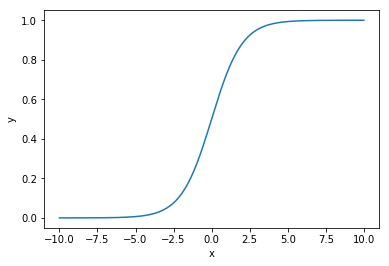

对于连续的变量X,如果说它服从Logistic回归,则:

对应概率密度以及分布函数:

F(x)更像是一个threshold,f(x)的表达式也利于求导。

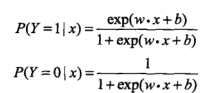

定义Logistic 回归模型:

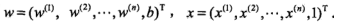

为输入,

为输入, 为对应输出,二项Logistic回归对应如下模型:

为对应输出,二项Logistic回归对应如下模型:

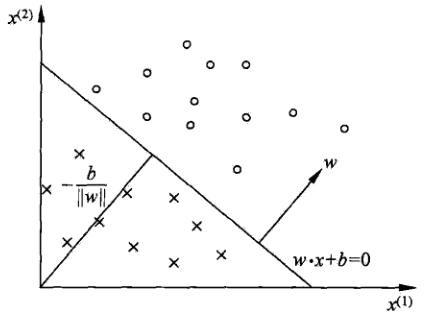

联系到之前写的感知机:

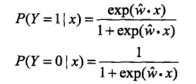

分类时,对应概率:

为正的概率大,为负的概率小,这个指数有点像把正/负→进行指数处理,这样就容易理解了。

有时为了表示方便,记: ,则表达式简化为:

,则表达式简化为:

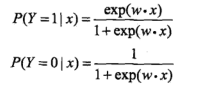

为什了叫Logistic regression呢?

这样明显是一个线性回归的表达式。

B-理论分析

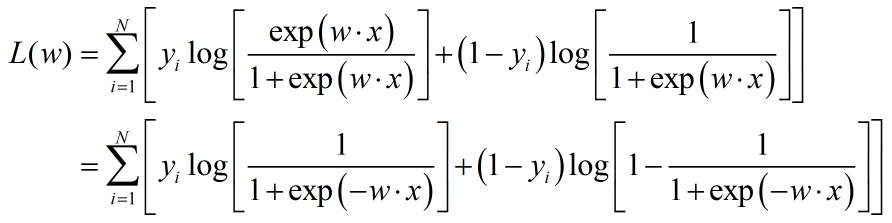

对于参数的求解,同感知机一样,就是求解w。利用最大似然求解:

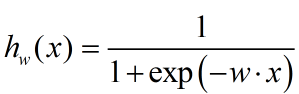

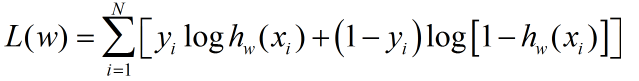

定义sigmoid函数:

准则函数重新写为:

可以借助梯度下降或者牛顿法,这几个方法之前已经有过介绍。

利用求解得到的w,即可以进行概率判断,哪个概率大就判给哪个类别,整个思路与感知机也是一样的:

C-理论应用

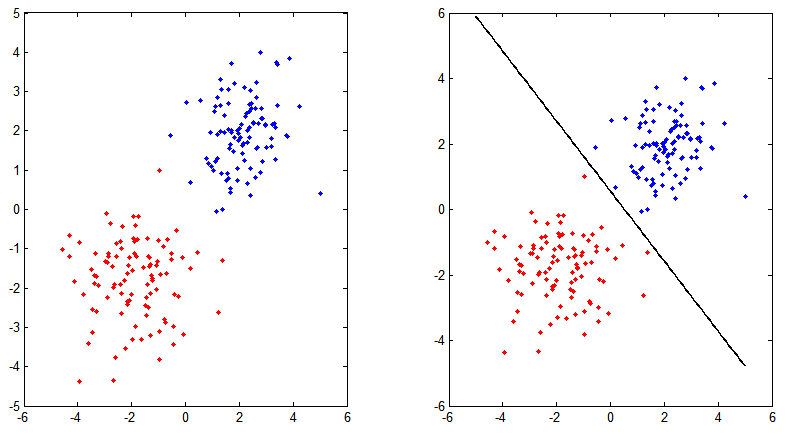

用一个code说明其工作原理,还是借助之前感知器用的例子,因为Logistic回归可以认为是Softmax回归的特例,这里借用softmax框架给出对应代码:

%Logistic regression

clear all; close all; clc;

%Every category samples

N = 100;

X = [randn(N,2)+2*ones(N,2);...

randn(N,2)-2*ones(N,2)];

figure;

subplot 121

label = [ones(N,1);2*ones(N,1)];

plot(X(label==1,1),X(label==1,2),'b.');hold on;

plot(X(label==2,1),X(label==2,2),'r.');hold on;

%%Train

numClass = 2;

parm.learningRate = 0.5;

pram.iter = 5000;

parm.precost = 0;

X = [ones(size(X,1),1), X]';

[nfeatures, nsamples] = size(X);

W = zeros(nfeatures, numClass);

% 1, 2, 3 -> 001, 010, 100.

groundTruth = full(sparse(label, 1:nsamples, 1));

for i = 1:pram.iter

rsp = W'*X;

rsp = bsxfun(@minus, rsp, max(rsp, [], 1));

rsp = exp(rsp);

prob = bsxfun(@rdivide, rsp, sum(rsp));

% compute gradient based on current probability

grad = - X * (groundTruth - prob)' / nsamples ;

% update W

W(:,2:end) = W(:,2:end) - parm.learningRate * grad(:,2:end);

% compute cost

logProb = log(prob);

idx = sub2ind(size(logProb), label', 1:size(logProb, 2));

parm.cost = - sum(logProb(idx)) / nsamples;

if i~=0 && abs(parm.cost - parm.precost) / parm.cost <= 1e-4

break;

end

parm.precost = parm.cost;

end

%Predict

rsp = W' * X;

[~, prediction] = max(rsp, [], 1);

subplot 122

X = X(2:end,:)';

plot(X(prediction==1,1),X(prediction==1,2),'b.');hold on;

plot(X(prediction==2,1),X(prediction==2,2),'r.');hold on;

x = -5:.1:5;

b = W(1,2);

y = -W(2,2)/W(3,2)*x-b/W(3,2);

plot(x,y,'k','linewidth',2);

对应结果图:

二、Softmax 回归

Logistic回归分析的是两类,对于多类的情形,通常称为:Softmax 回归。基于概率所以soft,概率中最大值所以Max。

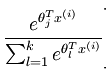

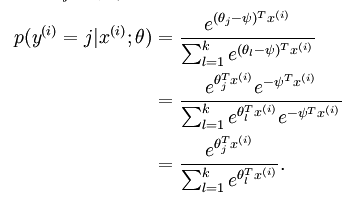

其实这个式子可以理解为Y=K时,$w_k*x = 0$,上面式子可以表述为,为了与下面表述一致,这里w改为$\theta$表示:

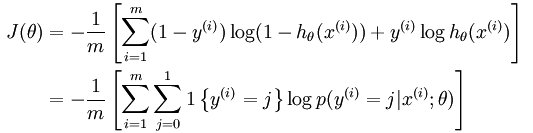

假设样本个数为m,同logistic回归类似,Softmax准则函数可以写为:

进一步写为:

思路同Logistic回归,同样利用梯度下降/牛顿-Rapson可以求解。求解出w:

其中,

分类的思路与Logistic回归也是完全一致。另外在求解的时候,可以发现:

求解的时候,都减去一个数,是不影响结果的。前面提到Y=K时,$w_k*x = 0$,其实有一个为零就行,哪一类是无所谓的,所以优化只优化K-1,给出代码:

%Test Softmax Regression

clear all; close all; clc;

N = 100;

X = [randn(N,2)+5*ones(N,2);...

randn(N,2)-1*ones(N,2);...

randn(N,2)-4*ones(N,2)];

figure;

subplot 121

label = [ones(N,1);2*ones(N,1);3*ones(N,1)];

plot(X(label==1,1),X(label==1,2),'b.');hold on;

plot(X(label==2,1),X(label==2,2),'r.');hold on;

plot(X(label==3,1),X(label==3,2),'k.');hold on;

title('Orignal Data')

%%Train

numClass = 3;

learningRate = 0.5;

X = [ones(size(X,1),1), X]';

[nfeatures, nsamples] = size(X);

W = zeros(nfeatures, numClass);

% 1, 2, 3 -> 001, 010, 100.

groundTruth = full(sparse(label, 1:nsamples, 1));

iter = 5000;

precost = 0;

for i = 1:iter

rsp = W'*X;

rsp = bsxfun(@minus, rsp, max(rsp, [], 1));

rsp = exp(rsp);

prob = bsxfun(@rdivide, rsp, sum(rsp));

% compute gradient based on current probability

grad = - X * (groundTruth - prob)' / nsamples ;

% update W

W(:,2:end) = W(:,2:end) - learningRate * grad(:,2:end);

% compute cost

logProb = log(prob);

idx = sub2ind(size(logProb), label', 1:size(logProb, 2));

cost = - sum(logProb(idx)) / nsamples;

if i~=0 && abs(cost - precost) / cost <= 1e-4

break;

end

precost = cost;

end

%Predict

rsp = W' * X;

[~, prediction] = max(rsp, [], 1);

subplot 122

X = X(2:end,:)';

plot(X(prediction==1,1),X(prediction==1,2),'b.');hold on;

plot(X(prediction==2,1),X(prediction==2,2),'r.');hold on;

plot(X(prediction==3,1),X(prediction==3,2),'k.');hold on;

title('Prediction')

对应结果(线性可分时,结果正确,线性不可分时,边界点容易出现错误,如下图):

而实际应用中,我们不愿将任何一个$\theta$直接置零,而是保留所有 ,但此时我们需要对代价函数做一个改动:加入权重衰减。准则函数变为:

,但此时我们需要对代价函数做一个改动:加入权重衰减。准则函数变为:

这个时候只要将上面对应的code按如下修改即可:

grad = - X * (groundTruth - prob)' / nsamples +.02 * W;%lamdba = 0.02

% grad = - X * (groundTruth - prob)' / nsamples ;

% update W

% W(:,2:end) = W(:,2:end) - learningRate * grad(:,2:end);

W = W - learningRate * grad;

三、基于Tensorflow的MNIST手写数字识别

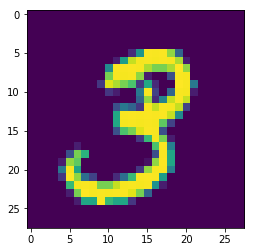

MNIST数据库是一个手写数字识别数据库,

MNIST(Mixed National Institude of Standards and Technology database),由几万张图片组成,其中每个照片像素为28*28(在读取时已经被拉成28*28=784的向量了),训练数据集train:55000个样本,验证数据集validation:5000个样本,测试数据集:10000个样本。

首先分别读取训练和测试数据:

import numpy as np

import matplotlib.pyplot as plt

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("MNIST_data/", one_hot=True)

先看看数据长什么样,任意读取一张图片:

#imshow data

imgTol = mnist.train.images

img = np.reshape(imgTol[1,:],[28,28])

plt.imshow(img)

大概就是这个样子(其实是个gray图).

下面开始对数据进行基于Softmax Regression的处理。

首先创建一个会话(session),为什么需要创建session可以参考Tensorflow基本用法:

import tensorflow as tf

sess = tf.InteractiveSession()

通过为输入图像和目标输出类别创建节点,来开始构建计算图:

sess = tf.InteractiveSession()

x = tf.placeholder("float", shape=[None, 784])

y_ = tf.placeholder("float", shape=[None, 10])

其中'None'表示该维度大小不指定。

我们现在为模型定义权重W和偏置b。可以将它们当作额外的输入量,但是TensorFlow有一个更好的处理方式:变量。一个变量代表着TensorFlow计算图中的一个值,能够在计算过程中使用,甚至进行修改。在机器学习的应用过程中,模型参数一般用Variable来表示:

W = tf.Variable(tf.zeros([784,10]))

b = tf.Variable(tf.zeros([10]))

变量需要通过seesion初始化后,才能在session中使用。这一初始化步骤为,为初始值指定具体值(本例当中是全为零),并将其分配给每个变量,可以一次性为所有变量完成此操作:

sess.run(tf.initialize_all_variables())

初始化完成后,接下来可以实现Softmax Regression了:

y = tf.nn.softmax(tf.matmul(x,W) + b)

softmax是tf.nn下的一个函数,tf.nn包含了很多神经网络的组件,tf.matmul在tensorflow里的意义是矩阵相乘。给出损失函数(交叉熵):

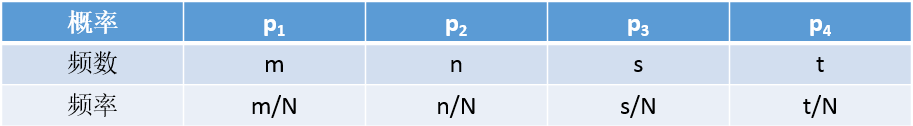

交叉熵没听过其实也不要紧,Maximum Likelihood(ML, 最大似然)估计应该都知道吧?

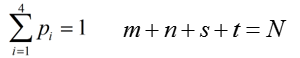

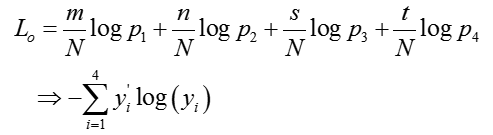

其中N为样本总数,且

我们频数以及频率是观测得到的,如何估计概率呢?我们通常用最大似然:

如果变形一下呢?同除以N:

最大似然估计不就是最小交叉熵估计?另一方面,交叉熵对误差的衡量类似联合概率密度的作用。给出对应code:

cross_entropy = -tf.reduce_sum(y_*tf.log(y))

reduce.sum为求和,reduce.mean为求取均值。有了准则函数以及理论框架,利用梯度下降进行训练:

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)

这里利用小批量梯度mini-batch下降,batch = 50个训练样本:

for i in range(1100):

batch = mnist.train.next_batch(50)

train_step.run(feed_dict={x: batch[0], y_: batch[1]})

训练后进行预测并打印:

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

给出总的code:

import numpy as np

import matplotlib.pyplot as plt

import tensorflow as tf

from tensorflow.examples.tutorials.mnist import input_data

mnist = input_data.read_data_sets("MNIST_data/", one_hot=True) #imshow data

#imgTol = mnist.train.images

#img = np.reshape(imgTol[1,:],[28,28])

#plt.imshow(img) sess = tf.InteractiveSession()

x = tf.placeholder("float", shape=[None, 784])

y_ = tf.placeholder("float", shape=[None, 10])

W = tf.Variable(tf.zeros([784,10]))

b = tf.Variable(tf.zeros([10]))

sess.run(tf.global_variables_initializer())

y = tf.nn.softmax(tf.matmul(x,W) + b)

cross_entropy = -tf.reduce_sum(y_*tf.log(y))

train_step = tf.train.GradientDescentOptimizer(0.01).minimize(cross_entropy)

for i in range(1100):

batch = mnist.train.next_batch(50)

train_step.run(feed_dict={x: batch[0], y_: batch[1]}) correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels}))

预测结果为:91.56%.

参考:

- Softmax regression:http://deeplearning.stanford.edu/wiki/index.php/Softmax_Regression

- 李航:《统计学习方法》

- Tensorflow官网文档:https://www.tensorflow.org/get_started/mnist/beginners

- http://tensorfly.cn/tfdoc/tutorials/mnist_pros.html

统计学习方法:罗杰斯特回归及Tensorflow入门的更多相关文章

- 统计学习方法6—logistic回归和最大熵模型

目录 logistic回归和最大熵模型 1. logistic回归模型 1.1 logistic分布 1.2 二项logistic回归模型 1.3 模型参数估计 2. 最大熵模型 2.1 最大熵原理 ...

- (转)TensorFlow 入门

TensorFlow 入门 本文转自:http://www.jianshu.com/p/6766fbcd43b9 字数3303 阅读904 评论3 喜欢5 CS224d-Day 2: 在 Da ...

- TensorFlow 入门之手写识别(MNIST) softmax算法

TensorFlow 入门之手写识别(MNIST) softmax算法 MNIST flyu6 softmax回归 softmax回归算法 TensorFlow实现softmax softmax回归算 ...

- 统计学习方法学习(四)--KNN及kd树的java实现

K近邻法 1基本概念 K近邻法,是一种基本分类和回归规则.根据已有的训练数据集(含有标签),对于新的实例,根据其最近的k个近邻的类别,通过多数表决的方式进行预测. 2模型相关 2.1 距离的度量方式 ...

- 李航《统计学习方法》CH01

CH01 统计学方法概论 前言 章节目录 统计学习 监督学习 基本概念 问题的形式化 统计学习三要素 模型 策略 算法 模型评估与模型选择 训练误差与测试误差 过拟合与模型选择 正则化与交叉验证 正则 ...

- 转:TensorFlow入门(六) 双端 LSTM 实现序列标注(分词)

http://blog.csdn.net/Jerr__y/article/details/70471066 欢迎转载,但请务必注明原文出处及作者信息. @author: huangyongye @cr ...

- 统计学习方法:CART算法

作者:桂. 时间:2017-05-13 14:19:14 链接:http://www.cnblogs.com/xingshansi/p/6847334.html . 前言 内容主要是CART算法的学 ...

- 《统计学习方法》笔记三 k近邻法

本系列笔记内容参考来源为李航<统计学习方法> k近邻是一种基本分类与回归方法,书中只讨论分类情况.输入为实例的特征向量,输出为实例的类别.k值的选择.距离度量及分类决策规则是k近邻法的三个 ...

- TensorFlow 入门之手写识别CNN 三

TensorFlow 入门之手写识别CNN 三 MNIST 卷积神经网络 Fly 多层卷积网络 多层卷积网络的基本理论 构建一个多层卷积网络 权值初始化 卷积和池化 第一层卷积 第二层卷积 密集层连接 ...

随机推荐

- 使用promise手动封装ajax函数

最近在做一个单页应用,node和浏览器仅通过json传输数据,因为是只有自己用等于是锻炼一下自己,所以也不用考虑seo的问题,node端我已经写好了,但是浏览器端想要用ajax原生太麻烦,用封装的函数 ...

- 3555: [Ctsc2014]企鹅QQ

3555: [Ctsc2014]企鹅QQ Time Limit: 20 Sec Memory Limit: 256 MBSubmit: 696 Solved: 294[Submit][Status ...

- 用Jquery做一个时间日期选择器

今天我们就用Jquery做一个时间日期选择器,当打开网页时,文本框里面显示的是当前的日期,点击文本框可以出现年.月.日的下拉菜单,并且可以选择,会根据年份的选择判断是否是闰年,从而改变二月的天数,闰年 ...

- Protobuf 在Ubuntu 14上的编译与使用

前言 一直知道Google开源的一个与语言无关的数据交换协议:protobuf.只知道是一种不同于json和XML的格式,还有就是性能特别的好(这在Java和C++的实现确实是!) 最近闲下来看了下G ...

- Entity Framework — ( Database First )

什么是Entity Framework Entity Framework是微软以 ADO.NET 为基础所发展出来的对象关系对应 (O/R Mapping) 解决方案.将数据存储从域对象自动映射到关系 ...

- ORACLE 12C 基础

连接到PDB数据库 CMD窗口:sqlplus 用户名/密码@localhost:1521/PDB数据库名 示例:sqlplus xiaozijie/Abc4681101@localhost:1 ...

- ICC_lab总结——ICC_lab6:版图完成

ICC_workshop的最后一个实验了.在这次的实验中,由于我使用ICC的版本与workshop的lab不是同一个版本,因此在后面的实验过程不是很顺利,主要是在LVS的过程中,最后的LVS没有通过. ...

- python遍历一个目录,输出所有文件名

python遍历一个目录,输出所有文件名 python os模块 os import os def GetFileList(dir, fileList): newDir = dir if os. ...

- MySQL基础入门-第一课 新建数据库(linux版本)

MySQL linux 登录MySQL sudo ),name ),phone ) ); # 或者 ),name ),phone )); 数据类型 数据类型 大小(字节) 用途 格式 INT ...

- 相机标定:kalibr标定工具箱使用总结

1 多相机标定 1.1采集图像和IMU 1.2制作Bag包 1)组织文件结构 ~/kalibr_workspace/test/stereo_calib bagsrc cam0 (1+time(0))* ...