实例学习——爬取豆瓣音乐TOP250数据

开发环境:(Windows)eclipse+pydev+MongoDB

豆瓣TOP网址:传送门

一、连接数据库

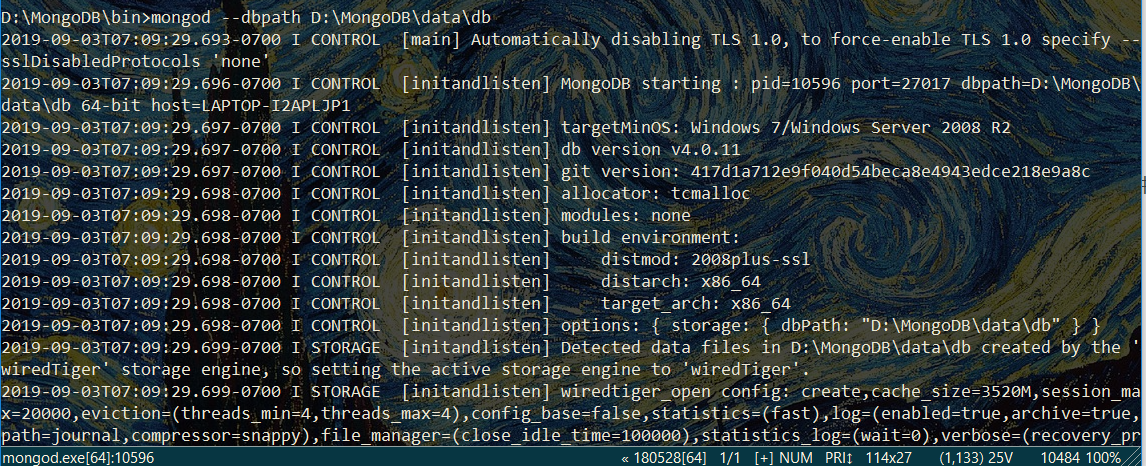

打开MongoDBx下载路径,新建名为data的文件夹,在此新建名为db的文件夹,db文件夹即用于存储数据

在bin路径下输入配置信息——>mongod --dbpath D:\MongoDB\data\db (此处为存储文件路径)

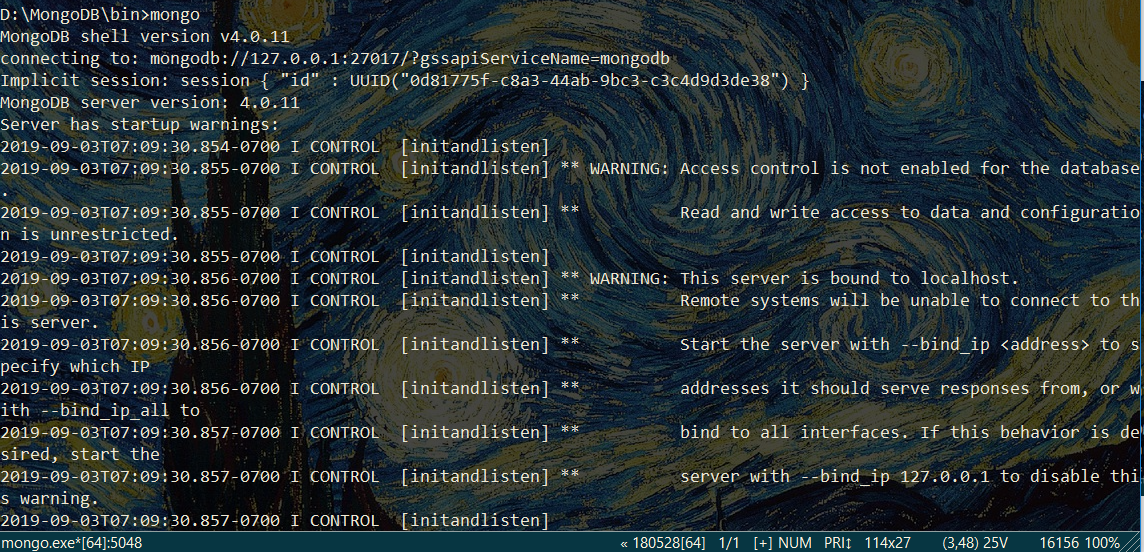

再打开新的命令行窗口,输入——>mongo

注意:启动服务的命令行窗口不要关闭

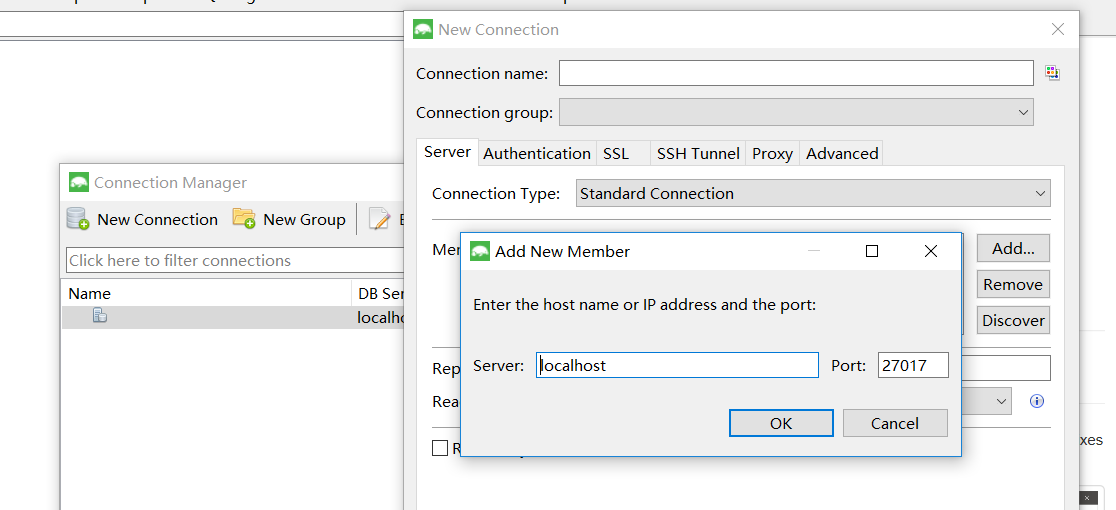

打开可视化管理工具Robomongo,点击Connections对话框,在右侧新建connect

保持默认设置,单击save,最后单击Connect即可连接到数据库

### 二、运行爬虫

# -*- coding:utf-8 -*-

import pymongo

from lxml import etree

import re

import requests

import time

client =pymongo.MongoClient('localhost',27017) #创建并连接数据库

mydb = client['mydb']

musictop = mydb['musictop']

headers = {'User=Agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/76.0.3809.132 Safari/537.36'} #请求头

def get_url_music(url): #获得详细url的函数

html = requests.get(url, headers = headers)

selector = etree.HTML(html.text)

music_hrefs = selector.xpath('//a[@class="nbg"]/@href')

for music_href in music_hrefs:

get_music_info(music_href)

def get_music_info(url): #获取详细信息的函数

html = requests.get(url, headers=headers)

selector = etree.HTML(html.text)

name = selector.xpath('//*[@id="wrapper"]/h1/span/text()')[0] #xpath

author = re.findall('表演者:.*?>(.*?)</a>',html.text,re.S)[0] #正则表达式

styles = re.findall('<span class="pl">流派:</span> (.*?)<br/>',html.text,re.S)

if len(styles)==0:

style = '未知'

else:

style = styles[0].strip()

time = re.findall('发行时间:</span> (.*?)<br/>',html.text,re.S)[0].strip()

publishers = re.findall('出版者:.*?>(.*?)</a>',html.text,re.S)

if len(publishers)==0:

publisher = "未知"

else:

publisher = publishers[0].strip()

score =selector.xpath('//*[@id="interest_sectl"]/div/div[2]/strong/text()')[0]

print(name,author,style,time,publisher,score)

info = {

'name':name,

'author':author,

'style':style,

'time':time,

'publisher':publisher,

'score':score,

}

musictop.insert_one(info)

if __name__=='__main__': #主程序入口

urls = ['https://music.douban.com/top250?start={}'.format(str(i)) for i in range(0,250,25)]

for url in urls:

get_url_music(url)

time.sleep(2)

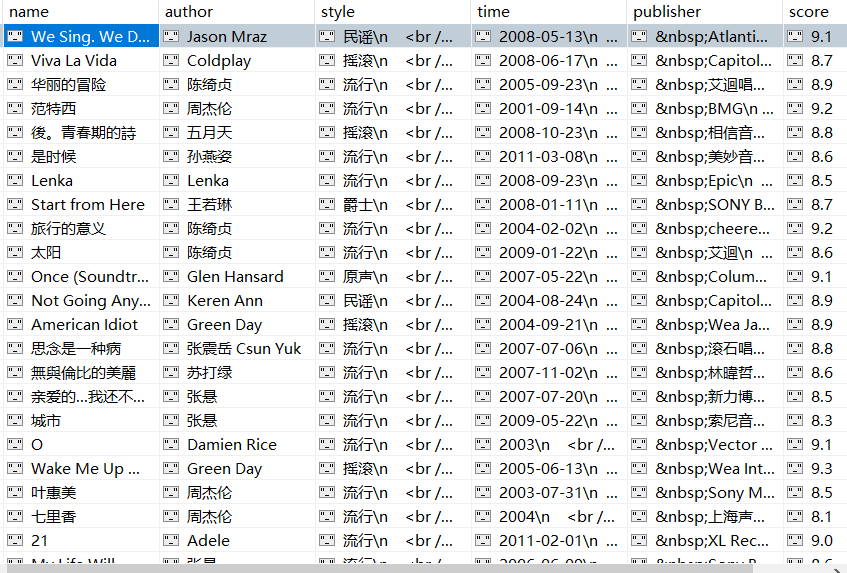

成果展示:

获取author字段信息时,采用正则是因为各详细页中标签位置略有不同,若通过定位标签获取信息,一些详细页信息匹配可能出错。

“表演者”字段在网页源代码中的相对位置是一样,可考虑正则表达式获取信息。

流派、发行时间、出版者信息若用Xpath方式爬取,会数据杂乱,多个标签嵌套,甚至存在乱码符号。

实例学习——爬取豆瓣音乐TOP250数据的更多相关文章

- 实例学习——爬取豆瓣网TOP250数据

开发环境:(Windows)eclipse+pydev 网址:https://book.douban.com/top250?start=0 from lxml import etree #解析提取数据 ...

- Python爬虫小白入门(七)爬取豆瓣音乐top250

抓取目标: 豆瓣音乐top250的歌名.作者(专辑).评分和歌曲链接 使用工具: requests + lxml + xpath. 我认为这种工具组合是最适合初学者的,requests比pytho ...

- 爬取豆瓣音乐TOP250的数据

参考网址:https://music.douban.com/top250 因为详细页的信息更丰富,本次爬虫在详细页中进行,因此先爬取进入详细页的网址链接,进而爬取数据. 需要爬取的信息有:歌曲名.表演 ...

- 一起学爬虫——通过爬取豆瓣电影top250学习requests库的使用

学习一门技术最快的方式是做项目,在做项目的过程中对相关的技术查漏补缺. 本文通过爬取豆瓣top250电影学习python requests的使用. 1.准备工作 在pycharm中安装request库 ...

- Python爬虫:现学现用xpath爬取豆瓣音乐

爬虫的抓取方式有好几种,正则表达式,Lxml(xpath)与BeautifulSoup,我在网上查了一下资料,了解到三者之间的使用难度与性能 三种爬虫方式的对比. 这样一比较我我选择了Lxml(xpa ...

- python2.7爬取豆瓣电影top250并写入到TXT,Excel,MySQL数据库

python2.7爬取豆瓣电影top250并分别写入到TXT,Excel,MySQL数据库 1.任务 爬取豆瓣电影top250 以txt文件保存 以Excel文档保存 将数据录入数据库 2.分析 电影 ...

- scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250

scrapy爬虫框架教程(二)-- 爬取豆瓣电影TOP250 前言 经过上一篇教程我们已经大致了解了Scrapy的基本情况,并写了一个简单的小demo.这次我会以爬取豆瓣电影TOP250为例进一步为大 ...

- python 爬虫&爬取豆瓣电影top250

爬取豆瓣电影top250from urllib.request import * #导入所有的request,urllib相当于一个文件夹,用到它里面的方法requestfrom lxml impor ...

- 【转】爬取豆瓣电影top250提取电影分类进行数据分析

一.爬取网页,获取需要内容 我们今天要爬取的是豆瓣电影top250页面如下所示: 我们需要的是里面的电影分类,通过查看源代码观察可以分析出我们需要的东西.直接进入主题吧! 知道我们需要的内容在哪里了, ...

随机推荐

- poj 3684 Physics Experiment 弹性碰撞

Physics Experiment Time Limit: 1000MS Memory Limit: 65536K Total Submissions: 1489 Accepted: 509 ...

- python中assert的用法

assert:断言 格式: assert 表达式 [, 参数] 当表达式为真时,程序继续往下执行: 当表达式为假时,抛出AssertionError错误,并将 参数 输出 举例: def foo( ...

- C++入门经典-例4.5-利用循环求n的阶乘

1:代码如下: // 4.5.cpp : 定义控制台应用程序的入口点. // #include "stdafx.h" #include <iostream> using ...

- Entity Framework Code First使用者的福音 --- EF Power Tool使用记之一

下次会为大家深入解析这个小工具. 最先看到这个工具是在EF产品组最新的博客文章上,http://blogs.msdn.com/b/adonet/archive/2011/05/18/ef-power ...

- du和df目录大小不一致

最近遇到个问题 df查看基本没有空间了 但是查找大文件 也基本没有 ,原来是之前的大文件删除了 没有生效导致的 用如下命令,查找到相关进程ID 然后kill就行了 lsof | grep delete ...

- cinder-----常用命令

云硬盘的创建查询 #创建卷类型 cinder type-create rbd #rbd是云硬盘类型名称,可自行定义 #查询卷类型 cinder type-list #卷类型扩展规格 cinder ty ...

- [doker]ubuntu18安装doker

ubuntu安装doker很简单,分4个步骤: Step1:更新资源库并安装apt-transprot-https软件包. 在安装Docker前, 首拉取最新的软件资源库 wangju@wangju- ...

- 再谈 Devstack(Rocky)

目录 文章目录 目录 前言 网络拓扑 运行环境 要点 步骤 前言 之前写过一篇<Openstack 实现技术分解 (1) 开发环境 - Devstack 部署案例详解>,随着 Devsta ...

- 60第K个排列

题目:给出集合 [1,2,3,…,n],其所有元素共有 n! 种排列.按大小顺序列出所有排列情况,并一一标记,当 n = 3 时, 所有排列如下: "123" &quo ...

- 47全排列II

题目:给定一个可包含重复数字的序列,返回所有不重复的全排列. 示例: 输入:[1,1,2]输出:[[1,1,2],[1,2,1],[2,1,1]] 来源:https://leetcode-cn.com ...