python scrapy 实战简书网站保存数据到mysql

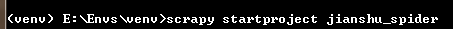

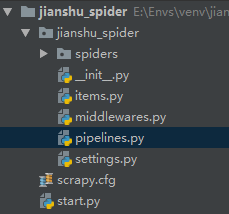

1:创建项目

2:创建爬虫

3:编写start.py文件用于运行爬虫程序

# -*- coding:utf-8 -*-

#作者: baikai

#创建时间: 2018/12/14 14:09

#文件: start.py

#IDE: PyCharm

from scrapy import cmdline

cmdline.execute("scrapy crawl js".split())

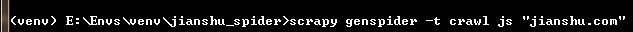

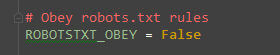

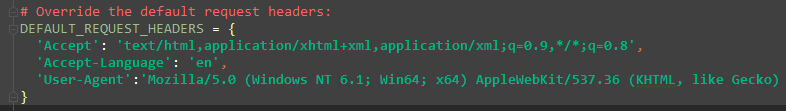

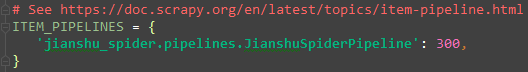

4:设置settings.py文件的相关设置

爬取详情页数据

编写items.py文件

# -*- coding: utf-8 -*-

# Define here the models for your scraped items

#

# See documentation in:

# https://doc.scrapy.org/en/latest/topics/items.html

import scrapy

class ArticleItem(scrapy.Item):

# 定义我们需要的存储数据字段

title=scrapy.Field()

content=scrapy.Field()

article_id=scrapy.Field()

origin_url=scrapy.Field()

author=scrapy.Field()

avatar=scrapy.Field()

pub_time=scrapy.Field()

编写js.py

# -*- coding: utf-8 -*-

import scrapy

from scrapy.linkextractors import LinkExtractor

from scrapy.spiders import CrawlSpider, Rule

from jianshu_spider.items import ArticleItem

class JsSpider(CrawlSpider):

name = 'js'

allowed_domains = ['jianshu.com']

start_urls = ['https://www.jianshu.com/']

rules = (

# 匹配地址https://www.jianshu.com/p/d8804d18d638

Rule(LinkExtractor(allow=r'.*/p/[0-9a-z]{12}.*'), callback='parse_detail', follow=True),

)

def parse_detail(self, response):

# 获取内容页数据并解析数据

title=response.xpath("//h1[@class='title']/text()").get()

#作者图像

avatar=response.xpath("//a[@class='avatar']/img/@src").get()

author=response.xpath("//span[@class='name']/a/text()").get()

#发布时间

pub_time=response.xpath("//span[@class='publish-time']/text()").get()

#详情页id

url=response.url

#https://www.jianshu.com/p/d8804d18d638

url1=url.split("?")[0]

article_id=url1.split("/")[-1]

#文章内容

content=response.xpath("//div[@class='show-content']").get()

item=ArticleItem(

title=title,

avatar=avatar,

author=author,

pub_time=pub_time,

origin_url=response.url,

article_id=article_id,

content=content

)

yield item

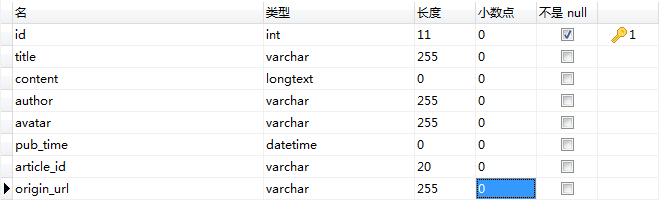

设计数据库和表

数据库jianshu

表article

id设置为自动增长

将爬取到的数据存储到mysql数据库中

# -*- coding: utf-8 -*-

# Define your item pipelines here

#

# Don't forget to add your pipeline to the ITEM_PIPELINES setting

# See: https://doc.scrapy.org/en/latest/topics/item-pipeline.html

import pymysql

from twisted.enterprise import adbapi

from pymysql import cursors

class JianshuSpiderPipeline(object):

def __init__(self):

dbparams = {

'host': '127.0.0.1',

'port': 3306,

'user': 'root',

'password': '8Wxx.ypa',

'database': 'jianshu',

'charset': 'utf8'

}

self.conn = pymysql.connect(**dbparams)

self.cursor = self.conn.cursor()

self._sql = None

def process_item(self, item, spider):

self.cursor.execute(self.sql, (item['title'], item['content'], item['author'], item['avatar'], item['pub_time'], item['origin_url'],item['article_id']))

self.conn.commit()

return item

@property

def sql(self):

if not self._sql:

self._sql = """

insert into article(id,title,content,author,avatar,pub_time,origin_url,article_id) values(null,%s,%s,%s,%s,%s,%s,%s)

"""

return self._sql

return self._sql

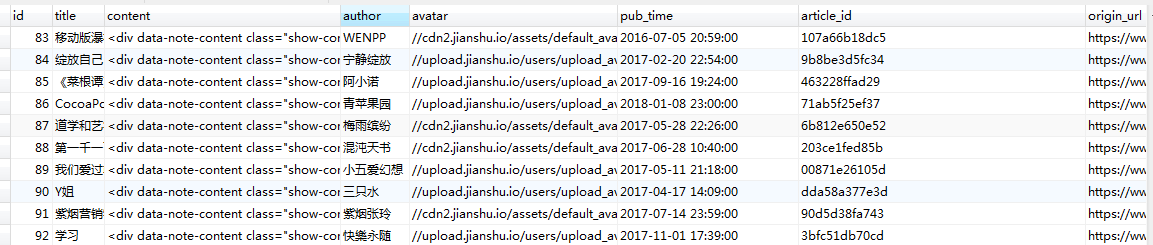

运行start.py效果如下

python scrapy 实战简书网站保存数据到mysql的更多相关文章

- SpringMVC保存数据到mysql乱码问题

SpringMVC保存数据到mysql乱码问题 乱码问题常见配置 一.web.xml配置过滤器 <filter> <filter-name>encoding-filter< ...

- hibernate保存数据到mysql时的中文乱码问题

因为hibernate底层使用的是jdbc的技术,所以我参考了别人使用jdbc保存数据到mysql里面时解决乱码问题的方法! 首先要告诉数据库要插入的字符串的字符集,mysql 默认使用的字符集是 l ...

- python scrapy实战糗事百科保存到json文件里

编写qsbk_spider.py爬虫文件 # -*- coding: utf-8 -*- import scrapy from qsbk.items import QsbkItem from scra ...

- Python爬取简书主页信息

主要学习如何通过抓包工具分析简书的Ajax加载,有时间再写一个Multithread proxy spider提升效率. 1. 关键点: 使用单线程爬取,未登录,爬取简书主页Ajax加载的内容.主要有 ...

- Python Scrapy 实战

Python Scrapy 什么是爬虫? 网络爬虫(英语:web crawler),也叫网络蜘蛛(spider),是一种用来自动浏览万维网的网络机器人.其目的一般为编纂网络索引. Python 爬虫 ...

- 教程+资源,python scrapy实战爬取知乎最性感妹子的爆照合集(12G)!

一.出发点: 之前在知乎看到一位大牛(二胖)写的一篇文章:python爬取知乎最受欢迎的妹子(大概题目是这个,具体记不清了),但是这位二胖哥没有给出源码,而我也没用过python,正好顺便学一学,所以 ...

- Scrapy Item用法示例(保存item到MySQL数据库,MongoDB数据库,使用官方组件下载图片)

需要学习的地方: 保存item到MySQL数据库,MongoDB数据库,下载图片 1.爬虫文件images.py # -*- coding: utf-8 -*- from scrapy import ...

- Spark使用Java读取mysql数据和保存数据到mysql

原文引自:http://blog.csdn.net/fengzhimohan/article/details/78471952 项目应用需要利用Spark读取mysql数据进行数据分析,然后将分析结果 ...

- 利用python scrapy 框架抓取豆瓣小组数据

因为最近在找房子在豆瓣小组-上海租房上找,发现搜索困难,于是想利用爬虫将数据抓取. 顺便熟悉一下Python. 这边有scrapy 入门教程出处:http://www.cnblogs.com/txw1 ...

随机推荐

- IT相关术语、缩略词

CLI Command Line Interface 命令行界面 GUI Graphical User Interface 图形用户界面 IP Internet Protocol 因特网协议 JDK ...

- jquery的全选和多选操作

//全选产品 $('#checkAll').click(function() { $(this).prop('checked',!$(this).prop('checked')); if($(this ...

- 仿真DDR3 Controller IP

一.Creat a new project,generate a new DDR3 IP,Close Project. 二.打开工程文件下的 X_example_design-->simulat ...

- URL地址中中文乱码详解(javascript中encodeURI和decodeURI方法、java.net.URLDecoder.encode、java.net.URLDecoder.decode)

引言: 在Restful类的服务设计中,经常会碰到需要在URL地址中使用中文作为的参数的情况,这种情况下,一般都需要正确的设置和编码中文字符信息.乱码问题就此产生了,该如何解决呢?且听本文详细道来. ...

- 如何提升SharePoint 2010的性能

文章来自: http://www.chinaemail.com.cn/server/xtfl/Exchange/201109/66466.html SharePoint是微软历史上销售量增长最快的产品 ...

- word禁止自动编号

在回车.换行时使用 shift + enter

- 了解Web及网络基础(二)

HTTP报文分为两种,HTTP请求报文跟HTTP响应报文. HTTP请求报文的结构如下: 其中,请求行中包括的内容有方法.URI和HTTP版本,请求首部字段.通用首部字段和实体首部字段隶属于HTTP首 ...

- MySQL入门很简单: 8查询数据

1. 查询语句语法 SELECT 属性列表 FROM 表名和视图列表 [WHERE 条件表达式1] [GROUP BY 属性名1 [HAVING t条件表达式2]] [ORDER BY 属性名2 [A ...

- mysql主从分离

1.工具: 两台机器 master:192.168.0.1 slave:192.168.0.2 2.master的配置 找到mysql的配置文件,一般centos的是/etc/my.cnf,ubunt ...

- mysql轮廓总结

架构=数据类型.索引.分片.主从复制原理.数据备份 学习软件,都应该先从架构入手,每一层掌握就行.mysql难吗?从其架构层开始,就不难啦. 架构结构:http://www.cnblogs.com/h ...