第9.2讲、Tiny Decoder(带 Mask)详解与实战

自己搭建一个 Tiny Decoder(带 Mask),参考 Transformer Encoder 的结构,并添加 Masked Multi-Head Self-Attention,它是 Decoder 的核心特征之一。

1. 背景与动机

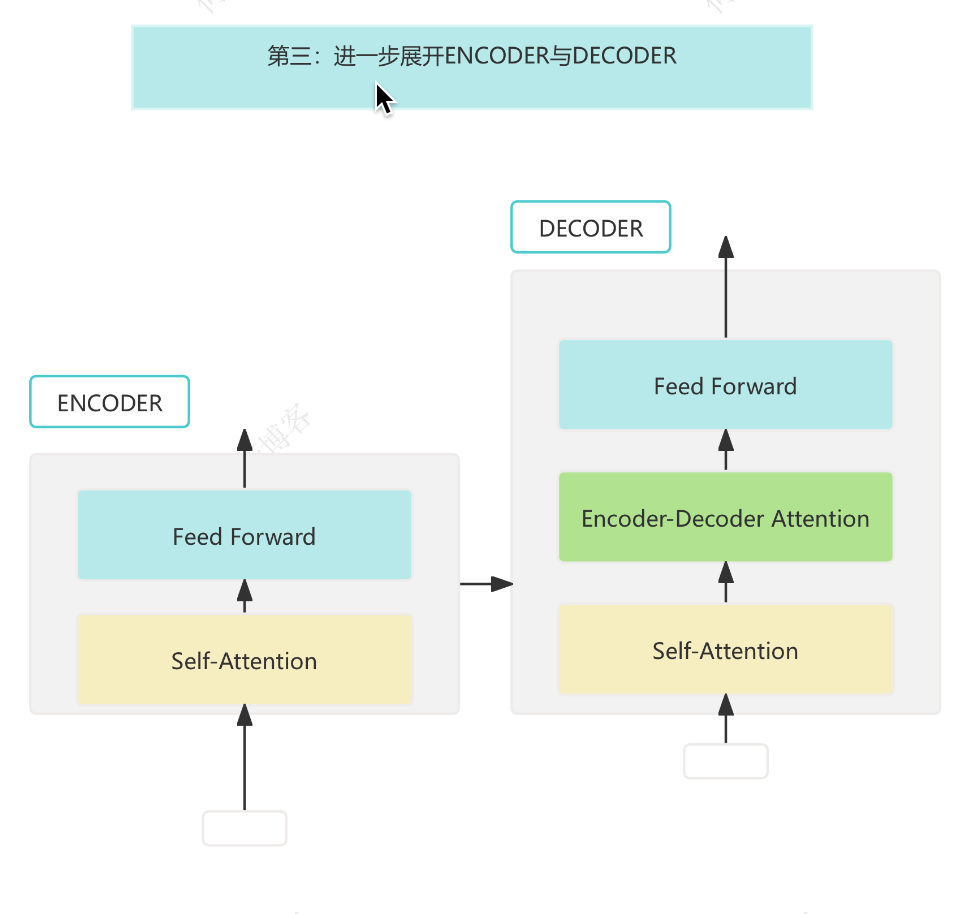

Transformer 架构已成为自然语言处理(NLP)领域的主流。其 Encoder-Decoder 结构广泛应用于机器翻译、文本生成等任务。Decoder 的核心特征是 Masked Multi-Head Self-Attention,它保证了自回归生成时不会"偷看"未来信息。本文将带你从零实现一个最小可运行的 Tiny Decoder,并深入理解其原理。

2. Tiny Decoder 架构简述

一个标准 Transformer Decoder Layer 包括:

- Masked Multi-Head Self-Attention

- Encoder-Decoder Attention(跨注意力)

- Feed Forward Network (FFN)

- LayerNorm + Residual Connection

为了简化,我们暂时不引入 Encoder-Decoder Attention,只聚焦于:

Masked Self-Attention + FFN

3. 什么是 Masked Attention?

Masked Attention 的作用是在 Decoder 生成序列时,禁止看到"未来"的 token,防止信息泄露。

用一个 Mask 矩阵来实现,例如:

Mask for length 4:

[[0, -inf, -inf, -inf],

[0, 0, -inf, -inf],

[0, 0, 0, -inf],

[0, 0, 0, 0]]

这个 Mask 会加在 Attention 的 logits 上(即 QKᵗ / sqrt(dk)),将不允许的位置置为 -inf,softmax 之后就是 0。

4. Tiny Decoder 核心代码(简化 PyTorch 实现)

import torch

import torch.nn as nn

import torch.nn.functional as F

import math

# 带掩码的多头自注意力机制

class MaskedSelfAttention(nn.Module):

def __init__(self, d_model, num_heads):

super().__init__()

assert d_model % num_heads == 0 # 保证可以均分到每个头

self.d_model = d_model

self.num_heads = num_heads

self.d_k = d_model // num_heads # 每个头的维度

# 用一个线性层同时生成 Q、K、V

self.qkv_proj = nn.Linear(d_model, 3 * d_model)

# 输出投影

self.out_proj = nn.Linear(d_model, d_model)

def forward(self, x):

# x: (batch, seq_len, d_model)

B, T, C = x.size()

# 生成 Q、K、V,并分头

qkv = self.qkv_proj(x).reshape(B, T, 3, self.num_heads, self.d_k).permute(2, 0, 3, 1, 4)

q, k, v = qkv[0], qkv[1], qkv[2] # (B, heads, T, d_k)

# 计算注意力分数 (QK^T / sqrt(d_k))

attn_logits = (q @ k.transpose(-2, -1)) / math.sqrt(self.d_k) # (B, heads, T, T)

# 构造下三角 Mask,防止看到未来信息

mask = torch.tril(torch.ones(T, T)).to(x.device)

attn_logits = attn_logits.masked_fill(mask == 0, float('-inf'))

# softmax 得到注意力权重

attn = F.softmax(attn_logits, dim=-1)

# 加权求和得到输出

out = attn @ v # (B, heads, T, d_k)

# 合并多头

out = out.transpose(1, 2).contiguous().reshape(B, T, C)

# 输出投影

return self.out_proj(out)

# 前馈神经网络

class FeedForward(nn.Module):

def __init__(self, d_model, d_ff):

super().__init__()

# 两层全连接+ReLU

self.ff = nn.Sequential(

nn.Linear(d_model, d_ff),

nn.ReLU(),

nn.Linear(d_ff, d_model)

)

def forward(self, x):

# 前馈变换

return self.ff(x)

# Tiny Decoder 层,包含 Masked Self-Attention 和前馈网络

class TinyDecoderLayer(nn.Module):

def __init__(self, d_model=128, num_heads=4, d_ff=512):

super().__init__()

self.self_attn = MaskedSelfAttention(d_model, num_heads) # 掩码自注意力

self.ff = FeedForward(d_model, d_ff) # 前馈网络

self.norm1 = nn.LayerNorm(d_model) # 层归一化1

self.norm2 = nn.LayerNorm(d_model) # 层归一化2

def forward(self, x):

# x: (batch, seq_len, d_model)

# 先归一化,再做自注意力,并加残差

x = x + self.self_attn(self.norm1(x))

# 再归一化,前馈网络,并加残差

x = x + self.ff(self.norm2(x))

return x

5. 使用示例

x = torch.randn(2, 10, 128) # Decoder输入

context = torch.randn(2, 15, 128) # Encoder输出

decoder = TinyDecoderLayer()

y = decoder(x, context) # output shape: (2, 10, 128)

6. 进阶扩展

6.1 添加 Encoder-Decoder Attention

Encoder-Decoder Attention 允许 Decoder 在生成时参考 Encoder 的输出(即源语言信息),是机器翻译等任务的关键。其实现方式与 Self-Attention 类似,只是 Q 来自 Decoder,K/V 来自 Encoder。

伪代码:

class CrossAttention(nn.Module):

def __init__(self, d_model, num_heads):

# ...同 MaskedSelfAttention ...

def forward(self, x, context):

# x: (B, T_dec, d_model), context: (B, T_enc, d_model)

# Q from x, K/V from context

# ...实现...

在 Decoder Layer 中插入:

self.cross_attn = CrossAttention(d_model, num_heads)

# forward:

x = x + self.cross_attn(self.norm_cross(x), context)

6.2 多层 Decoder 堆叠

实际应用中,Decoder 通常由多层堆叠而成:

class TinyDecoder(nn.Module):

def __init__(self, num_layers, d_model, num_heads, d_ff):

super().__init__()

self.layers = nn.ModuleList([

TinyDecoderLayer(d_model, num_heads, d_ff) for _ in range(num_layers)

])

def forward(self, x):

for layer in self.layers:

x = layer(x)

return x

6.3 加入 Positional Encoding

Transformer 不具备序列顺序感知能力,需加上 Positional Encoding:

class PositionalEncoding(nn.Module):

def __init__(self, d_model, max_len=5000):

super().__init__()

pe = torch.zeros(max_len, d_model)

position = torch.arange(0, max_len).unsqueeze(1)

div_term = torch.exp(torch.arange(0, d_model, 2) * (-math.log(10000.0) / d_model))

pe[:, 0::2] = torch.sin(position * div_term)

pe[:, 1::2] = torch.cos(position * div_term)

self.register_buffer('pe', pe)

def forward(self, x):

return x + self.pe[:x.size(1)]

7. 完整训练例子(伪代码)

# 假设有输入数据 input_seq, target_seq

x = embedding(input_seq)

x = pos_encoding(x)

decoder = TinyDecoder(num_layers=2, d_model=128, num_heads=4, d_ff=512)

output = decoder(x)

# 计算 loss, 反向传播

8. 小结

- Decoder 的关键是 Masked Self-Attention,通过

tril的下三角掩码防止泄漏未来信息。 - 可以用

torch.tril快速构造下三角 Mask。 - Decoder 层和 Encoder 类似,但注意力机制加了 Mask,而且通常会多出 Encoder-Decoder Attention。

- 可扩展为多层、加入位置编码、跨注意力等,逐步构建完整的 Transformer Decoder。

*如果不加 Mask,允许 Decoder 看到未来 token,会导致模型训练"作弊",推理时表现极差,生成文本质量低下,模型失去实际应用价值。因此,Masked Self-Attention 是保证自回归生成和模型泛化能力的关键机制。

9. 参考资料

第9.2讲、Tiny Decoder(带 Mask)详解与实战的更多相关文章

- 第三节:带你详解Java的操作符,控制流程以及数组

前言 大家好,给大家带来带你详解Java的操作符,控制流程以及数组的概述,希望你们喜欢 操作符 算数操作符 一般的 +,-,*,/,还有两个自增 自减 ,以及一个取模 % 操作符. 这里的操作算法,一 ...

- MySQL5.6的4个自带库详解

MySQL5.6的4个自带库详解 1.information_schema详细介绍: information_schema数据库是MySQL自带的,它提供了访问数据库元数据的方式.什么是元数据呢?元数 ...

- IntelliJ IDEA 快捷键说明大全(中英对照、带图示详解)

因为觉得网络上的 idea 快捷键不够详尽,所以特别编写了此篇文章,方便大家使用 idea O(∩_∩)O~ 其中的英文说明来自于 idea 的官网资料,中文说明主要来自于自己的领会和理解,英文说明只 ...

- Java线程池带图详解

线程池作为Java中一个重要的知识点,看了很多文章,在此以Java自带的线程池为例,记录分析一下.本文参考了Java并发编程:线程池的使用.Java线程池---addWorker方法解析.线程池.Th ...

- Java自带命令详解

1. 背景 给一个系统定位问题的时候,知识.经验是关键基础,数据(运行日志.异常堆栈.GC日志.线程快照[threaddump / javacore文件].堆转储快照[heapdump / hprof ...

- OPENGL_三角形带GL_TRIANGLE_STRIP详解

使用三角形带原因:减少顶点传递,渲染时api向显卡传输数据量是瓶颈,用较好的传递方法传递一个三角形最少可以少于一个点. 点的顺序根据奇数,偶数不一样的原因:保持所有三角形法线在同一方向. 原文:htt ...

- L2-014. 列车调度(带图详解)

L2-014. 列车调度 火车站的列车调度铁轨的结构如下图所示. Figure 两端分别是一条入口(Entrance)轨道和一条出口(Exit)轨道,它们之间有N条平行的轨道.每趟列车从入口可以选 ...

- Sprite Atlas与Sprite Mask详解

https://www.sohu.com/a/169409304_280780 Unity 2017.1正式发布后,带来了一批能帮助大家更加简化工作流的新功能.今天这篇文章,将由Unity技术经理成亮 ...

- java中带继承类的加载顺序详解及实战

一.背景: 在面试中,在java基础方面,类的加载顺序经常被问及,很多时候我们是搞不清楚到底类的加载顺序是怎么样的,那么今天我们就来看看带有继承的类的加载顺序到底是怎么一回事?在此记下也方便以后复习巩 ...

- Android 自带 camera 详解

在本文中 需要考虑的问题 概述 Manifest声明 使用内置的摄像头应用程序 捕获图像的intent 捕获视频的intent 接收摄像头intent的结果 创建摄像头应用程序 检测摄像头硬件 访问摄 ...

随机推荐

- Python基础-模块、Python操作excel

今日概要 模块 自定义模块 内置模块 第三方模块 [!Caution] 这个地方讲的会比较多,而且有的东西网上搜不到!!! 自动化办公相关模块 -- Excel和Word 面向对象 1. 面向对象中的 ...

- Swagger OpenAPI Schema 为空时 Example Value 显示 "string" 的原因及解决方案

解决Swagger UI示例值显示"string"的问题 最近在使用ObjectScript生成JSON接口文档时,遇到了一个奇怪的问题: 生成的JSON数据是正常的. 但Swag ...

- 文件上传fuzz工具-Upload_Auto_Fuzz

一.工具介绍 在日常遇到文件上传时,如果一个个去测,会消耗很多时间,如果利用工具去跑的话就会节省很多时间,本Burp Suite插件专为文件上传漏洞检测设计,提供自动化Fuzz测试,共300+条p ...

- 解决Dcat Admin laravel框架登录报错问题,(blocked:mixed-content)

前言 在使用 Dcat Admin 后台登录时,发生 error 报错:(blocked:mixed-content) xhr VM484:1,浏览器拦截 其实这是浏览器在 HTTPS 页面中尝试加载 ...

- 200条Git命令复习总结使用

新建 创建一个新的 git 版本库.这个版本库的配置.存储等信息会被保存到.git 文件夹中 # 初始化当前项目 $ git init # 新建一个目录,将其初始化为Git代码库 $ git init ...

- 通过百度地图 API V2.0 版本,进行地图坐标系转换

注意 先阅读参考链接 瞭月 的文章,再阅读本文. 其中,请求参数中 model 的含义: amap/tencent - 即:GCJ02 火星坐标系,由中国国家测绘局制订的地理信息系统的坐标系统. 由 ...

- Coupled Iterative Refinement for 6D Multi-Object Pose Estimation论文精读

目录 Coupled Iterative Refinement for 6D Multi-Object Pose Estimation论文精读 论文介绍 Abstract Introduction Re ...

- 【Linux】2.2 Linux安装

安装 vm 和 Centos 学习 Linux 需要一个环境,我们需要创建一个虚拟机,然后在虚拟机上安装一个 Centos 系统来学习. 先安装 virtual machine ,vm12 再安装 L ...

- MySQL 默认字符集

MySQL 默认的字符集是 latin1,通常跟我们的中文会打架,导致读写异常或乱码,而我们需要的字符集是 utf-8. MySQL 字符集的查看 mysql> show variables l ...

- C#之json字符串转xml字符串

留爪参考 using System.Xml; // using System.Text; // using System.Runtime.Serialization.Json; //JsonReade ...